Künstliche Intelligenz nimmt in der heutigen digitalen Landschaft eine immer bedeutendere Rolle ein. Insbesondere große Sprachmodelle wie LLaMA eröffnen vielfältige Möglichkeiten, von Chatbots über automatisierte Textverarbeitung bis hin zu komplexen Analysewerkzeugen. Dabei gewinnt die Frage nach Sicherheit und verantwortungsvollem Umgang mit KI zunehmend an Bedeutung. Wie lassen sich unerwünschte oder gefährliche Antworten von großen Sprachmodellen effektiv verhindern? Hier kommen sogenannte AI-Sicherheitsmechanismen oder Guardrails ins Spiel, deren Implementierung mit modernen Technologien wie Node.js und dem Llama Stack besonders effizient gelingt.

Der Llama Stack, der Anfang 2025 veröffentlicht wurde, bietet eine Plattform speziell für KI-Anwendungen auf Basis großer Sprachmodelle. Sein modularer Aufbau ermöglicht die einfache Integration von Sicherheitsmechanismen, die den Rahmen des jeweiligen Anwendungsfalls wahren. Dabei unterscheidet man zwischen eingebauten Guardrails, wie zum Beispiel LlamaGuard und PromptGuard, und der Option, eigene, spezifische Filter mechanisch zu integrieren. So lassen sich Antworten des Sprachmodells sowohl vor als auch nach der Generierung überprüfen und bei Bedarf unterbinden. Guardrails fungieren als Sicherheitsschilde, um sicherzustellen, dass das KI-Modell nur innerhalb des vorgesehenen Anwendungsgebiets agiert.

Sie verhindern, dass das Modell Fragen beantwortet, die rechtlich oder ethisch bedenklich sind, beispielsweise Anleitungen zur Gesetzesumgehung oder diskriminierende Inhalte. Dabei beschränken sie die Themenfelder so, dass zum Beispiel in einer Versicherungs-App keine verbotenen Ratschläge gegeben werden. Die Kombination von LlamaGuard und PromptGuard bietet hier eine umfassende Schutzschicht: LlamaGuard identifiziert unzulässige Inhalte in Eingaben und Ausgaben, während PromptGuard speziell gegen Manipulationsversuche, sogenannte „Jailbreaks“, vorgeht. Die Implementierung dieser Guardrails in Node.js gestaltet sich dank der Llama Stack APIs recht unkompliziert.

Zunächst müssen die Modelle, die für die Sicherheitsmechanismen zuständig sind, in der Infrastruktur registriert werden. Dies umfasst zum Beispiel die Meta-Modelle von LlamaGuard und PromptGuard, die jeweils unterschiedliche Kategorien von sicherheitsrelevanten Verstößen erkennen können. Die Registrierung erfolgt unter Nutzung eines Clients, der mit der Llama Stack Instanz kommuniziert. Damit weiß das System, welche Modelle zur Prüfung der Eingaben und Ausgaben zur Verfügung stehen. Im Anschluss werden sogenannte „Shields“ oder Filter konfiguriert und aktiviert.

Jeder Shield steht für eine bestimmte Sicherheitsfunktion, die im System angewendet wird. In der Praxis lassen sich verschiedene Shields parallel betreiben, um einen mehrstufigen Schutz zu gewährleisten. Über die API kann man beispielsweise einen Shield für die Eingaben des Nutzers sowie einen für die Antworten des Models definieren. Beide Guards können dann für unterschiedliche Zwecke verwendet werden, etwa um sowohl bösartige Anfragen frühzeitig abzulehnen als auch unangemessene Antworten zu verhindern. Die Anwendung der Sicherheitsmechanismen lässt sich entweder manuell oder automatisiert steuern.

Im manuellen Modus sendet der Entwickler bestimmte Eingaben zur Bewertung an die Shields und erhält als Antwort eine Einschätzung, ob die Eingabe unbedenklich ist oder eine Verletzung der Sicherheitsrichtlinien vorliegt. So lässt sich das Verhalten der Filtersysteme testen und nachvollziehen. Ein praktisches Beispiel zeigt, wie Anfragen nach dem Erstellen gefälschter Dokumente sowohl von LlamaGuard als auch von PromptGuard als Verstoß erkannt und entsprechend abgeblockt werden. Noch effizienter wird der Schutz durch die Nutzung des Agent APIs von Llama Stack. Dabei werden die Guardrails direkt in den interaktiven Dialog mit dem Modell eingebettet.

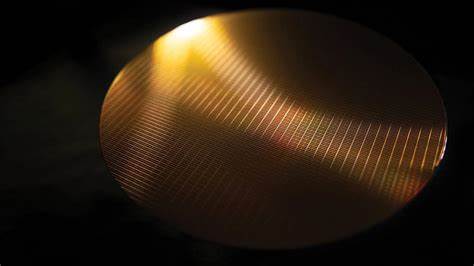

Eine Agent-Instanz kann so konfiguriert werden, dass sämtliche Eingaben und Ausgaben automatisch durch die registrierten Shields laufen, ohne dass der Entwickler jeden Schritt explizit koordinieren muss. Damit garantiert die Agent-API einen permanenten Schutz und entlastet Entwickler von der Feinsteuerung der Sicherheitsprüfungen im laufenden Betrieb. Die Praxis zeigt, dass der Einsatz solcher Guardrails nicht nur die Sicherheit erhöht, sondern auch Ressourcen schont. Ein interessanter Nebeneffekt ist, dass die Filter unerwünschte Anfragen schnell erkennen und beantworten können, oft deutlich schneller als das große Sprachmodell selbst. Dadurch wird kostspielige Rechenzeit auf Grafikprozessoren eingespart, was sowohl wirtschaftliche als auch ökologische Vorteile mit sich bringt.

Die Implementierung von Guardrails mit Node.js ist dabei besonders attraktiv für Entwickler, die bereits mit JavaScript oder TypeScript vertraut sind. Die gut dokumentierten APIs und die Unterstützung moderner asynchroner Programmierparadigmen ermöglichen eine elegante Integration in bestehende Anwendungen. Außerdem steht der komplette Beispielcode offen zur Verfügung, was den Einstieg erleichtert und Raum für individuelle Anpassungen schafft. Die Kombination von Node.

js und dem Llama Stack mit integrierten Sicherheitsmechanismen ist somit ein kraftvolles Rezept, um KI-Anwendungen nicht nur intelligent, sondern auch verantwortungsbewusst zu gestalten. Entwickler können so sicherstellen, dass ihre Anwendungen ethische Anforderungen erfüllen, keine rechtlich problematischen Inhalte verbreiten und vor Manipulationen geschützt sind. Abschließend lässt sich festhalten, dass die sorgfältige Planung und Umsetzung von KI-Sicherheitsmaßnahmen essentiell ist, um das Vertrauen der Nutzer zu sichern und unerwünschte Folgen zu vermeiden. Die verfügbaren Werkzeuge im Llama Stack bieten dabei ein hohes Maß an Flexibilität und Effektivität. Wer sich als Entwickler mit der Thematik auseinandersetzt und die Guardrails konsequent nutzt, schafft eine stabile Basis für den verantwortungsvollen Einsatz großer Sprachmodelle im kommerziellen und öffentlichen Umfeld.

Die Zukunft der KI-Anwendungen wird maßgeblich durch solche Sicherheitskonzepte geprägt sein – Node.js und Llama Stack sind Schlüsseltechnologien auf diesem Weg.