OpenSearch 3.0 ist das Ergebnis jahrelanger Entwicklung und gemeinschaftlicher Innovationen innerhalb der OpenSearch-Community. Die neue Hauptversion, veröffentlicht im Mai 2025, bringt zahlreiche Verbesserungen in den Bereichen Performance, Datenmanagement, Vektor-Datenbanken und Künstliche Intelligenz mit sich. Damit hält OpenSearch den Anforderungen moderner Anwendungen stand, die mit massiven Datenmengen und komplexen Suchanfragen umgehen müssen. Die Entscheidung, drei Jahre bis zur Veröffentlichung von Version 3.

0 zu warten, war bewusst gewählt, um in Einklang mit semantic versioning nur dann große Versionssprünge zu machen, wenn es wirklich signifikante Änderungen gibt. Ein großer Antrieb für diese Version waren die Fortschritte in Apache Lucene 10, auf dem OpenSearch basiert. Lucene 10 bringt erhebliche Verbesserungen in Sachen Leistung und Effizienz, insbesondere im Vektorindexing und im Suchverhalten. Die Optimierung bei der Indizierung von Vektorfeldern ermöglicht beispielsweise schnellere Indexierungszeiten und geringere Speicheranforderungen. Sparse Indexierung, bei der ähnlich gruppierte Dokumente nahe beieinander abgelegt werden, sorgt für weniger CPU-Auslastung und verbesserte Speicheroptimierung.

Eine Neuerung ist die Vektorquantisierung, die Vektorrepräsentationen komprimiert und dadurch den Speicherbedarf sowie die Abfragegeschwindigkeit verbessert. Die Kombination dieser Methoden unterstützt den Aufbau und Betrieb großer Vektor-Datenbanken, die für KI-Anwendungen ihrer Zeit voraus sind. Die Performance von OpenSearch 3.0 steigt signifikant gegenüber der Vorgängerversion 2.19.

Im Durchschnitt werden Performancegewinne von 20 Prozent bei wichtigen Such- und Analyseoperationen erreicht, während beim Vergleich mit OpenSearch 1.3 sogar eine Steigerung von mehr als dem Neunfachen sichtbar ist. Diese Optimierungen sind essenziell, um das rasante Wachstum von Anwendungen wie Observability-Tools, Log-Analyse-Plattformen und generativen KI-Modellen zu bewältigen, die sehr hohe Anforderungen an Rechenleistung und Geschwindigkeit stellen. Die neue Version unterstützt experimentell den Datentransport über Protocol Buffers (protobuf) und gRPC. Diese Kombination ermöglicht eine effizientere und schnellere Kommunikation zwischen Client und Server durch Nutzung der HTTP/2-Infrastruktur und Funktionen wie Multiplexing und bidirektionale Datenströme.

Die Vorteile zeigen sich vor allem bei komplexen und großen Abfragen, bei denen das Serialisieren und Deserialisieren von JSON bislang eine erhebliche Overheadquelle war. Die Integration von gRPC bietet zudem eine reibungslose Einbindung von OpenSearch in bestehende gRPC-Ökosysteme, was die Anpassungsfähigkeit und Agilität in entwickelten Umgebungen weiter erhöht. Ein weiterer Meilenstein ist die Einführung der Pull-basierten Datenaufnahme als experimentelles Feature. Dabei kann OpenSearch nun Daten aus Streamingquellen wie Apache Kafka oder Amazon Kinesis aktiv abrufen, anstatt nur passiv via REST-API Daten zu empfangen. Die Fähigkeit zur Eigendrosselung („Backpressure“) führt zu stabileren und widerstandsfähigeren Datenpipelines, da die Lastverteilung der Datenaufnahme automatisch geregelt wird.

Für Anwendungsfälle aus Log-Collecting und Echtzeit-Streaming ein bedeutender Schritt hin zu stabileren und weniger wartungsintensiven Systemen. OpenSearch 3.0 verbessert die Abfrageleistung bei Bereichsanfragen um 25 Prozent durch smartere Algorithmen. Insbesondere bei Zeitreihen- oder numerischen Feldern, die in großen Datenbeständen vorkommen, werden mit mehrstufigen Intervallbaum-Filtern weniger Ein-/Ausgabeoperationen benötigt. Dies führt zu schnelleren Antwortzeiten und geringerem Ressourcenverbrauch auf den Clustern.

Für Logging- und Monitoring-Anwendungen ist das ein enormer Vorteil, da sie auf präzise und schnelle Zeitbereichsabfragen angewiesen sind. Bei Aggregationen auf Feldern mit sehr hoher Kardinalität – also einer großen Anzahl von einzigartigen Werten – kann OpenSearch 3.0 die Latenzzeit um bis zu 75 Prozent reduzieren. Neue Ausführungshinweise ermöglichen es, zwischen verschiedenen Algorithmusvarianten für die Schätzung einzigartiger Werte aufzuteilen und dadurch das Verhältnis von Genauigkeit zu Performance zu optimieren. Diese Feinsteuerung sorgt insbesondere bei komplexen Analysen auf großen Datensätzen für bessere und schnellere Ergebnisse bei reduziertem Speicherverbrauch.

Auch die Filter-Umschreibungsoptimierung bei Aggregationen wurde erweitert, sodass nicht nur einfache Aggregationen, sondern auch jene mit verschachtelten Sub-Aggregationen profitieren. Für Nutzer bedeutet das eine Reduktion der Abfragezeiten um bis zu 40 Prozent bei komplexeren Analysestrukturen. Die neue Version revolutioniert zudem den Bereich Vektor-Datenbanken. Insbesondere der native Support des Model Context Protocol (MCP) ist ein großer Schritt zur nahtlosen Integration von OpenSearch mit KI-Agenten und generativen Modellen. Dadurch können Werkzeuge wie Anthropic, LangChain und OpenAI effizienter mit OpenSearch interagieren und dessen Funktionen in Workflows für maschinelles Lernen und KI nutzen.

Experimentell bringt OpenSearch 3.0 den „Plan-Execute-Reflect“-Agenten, der komplexe Problemlösungen autonom in Schritte zerlegt und diese schrittweise ausführt und verbessert. Dies eröffnet neue Möglichkeiten etwa in der automatisierten Analyse von Servicefehlern oder der intelligenten Datenaufbereitung. Das Feature „Derived Source“ für k-NN-Vektoren, das erstmals in Version 2.19 vorgestellt wurde, ist nun vollständig produktionsreif.

Dabei müssen Vektoren nicht mehr vollständig im JSON-Source gespeichert werden, sondern werden bei Bedarf dynamisch hinzugefügt. Dies führt zu erheblichen Einsparungen im Speicherbedarf, bis zu dreimal weniger Kosten für Vektor-Indizes und deutlich verkürzten Such- und Merge-Zeiten. Große Indizes können so effizienter verwaltet und abgefragt werden. Die experimentelle GPU-Beschleunigung von Vektor-Operationen ist ein weiterer beeindruckender Fortschritt für Anwender mit hohen Anforderungen an Geschwindigkeit und Kosteneffizienz. GPUs erlauben durch ihre Parallelverarbeitung deutlich schnellere Indexerstellung mit bis zu 9,3-facher Geschwindigkeit und einer Kostenreduktion von knapp dem Vierfachen im Vergleich zu CPU-basierten Lösungen.

Diese Innovation wurde in Zusammenarbeit mit NVIDIA entwickelt und verspricht eine erhebliche Optimierung bei groß angelegten KI- und Suchanwendungen. Ein neues Highlight im Bereich der Ergebnis-Präsentation ist die semantische Satz-Hervorhebung. Anders als klassische Suchhighlighting-Methoden, die sich nur auf exakte Textübereinstimmungen stützen, ermöglicht diese Funktion die Kennzeichnung von relevanten Sätzen auf Basis ihrer Bedeutung. Besonders bei neuronalen und hybriden Suchanfragen erhält der Nutzer so kontextuelle und inhaltlich vollständige Resultate, was die Nutzererfahrung erheblich verbessert und semantische Relevanz besser transportiert. Die „Concurrent Segment Search“ wurde standardmäßig für k-NN-Abfragen aktiviert und erlaubt durch parallele Suche auf mehrere Threads eine Leistungssteigerung von bis zu 2,5-fach bei gleichzeitig stabiler Ergebnissicherheit.

Zudem wurden durch eine verbesserte Segmentgrößenverteilung Tail-Latenzen um bis zu 20 Prozent verbessert, was vor allem in Echtzeitanwendungen spürbar ist. Um noch mehr Transparenz bei Vektor-Suchen zu schaffen, steht nun eine Explain-API zur Verfügung. Diese liefert detaillierte Einblicke, wie Scores berechnet, normalisiert und kombiniert werden – eine wichtige Information für Entwickler, die Ihre Abfragen optimieren und die Funktionsweise ihrer KI-getriebenen Suchanwendungen verstehen möchten. Die Suchfunktion selbst wurde ebenfalls durch neue Methoden wie Z-Score-Normalisierung bei hybriden Abfragen verbessert. Diese statistische Normalisierung sorgt für robustere und vergleichbarere Scores, indem sie Ausreißer besser behandelt und damit stabile und verlässliche Ergebnisse liefert.

Die bislang verwendete Min-Max-Normalisierung stagnierte hier oft bei extremen Werten, was zu einer Verzerrung der Rangfolge geführt hat. Ein weiteres Feature schafft für Min-Max-Normalisierung eine untere Schranke, die übermäßige Wertsteigerungen bei sehr niedrigen Scores verhindert. Somit bleibt die Bewertungskala konsistent und entspricht der tatsächlichen Relevanz. Inner Hits werden nun für hybride Suchanfragen unterstützt. Dabei werden die jeweiligen Unterergebnisse für verschachtelte Dokumentfelder mit angezeigt, was tiefere Einsichten in die Herkunft von Suchergebnissen ermöglicht und besonders bei komplexen Datenstrukturen neue Analysemöglichkeiten bietet.

Für Aggregate mit hohem Volumen ist die Bandbreite der neuen Star-Tree-Indizierung erweiterbar. Diese Technik erlaubt es, voraggregierte Segmente statt der kompletten Datenbasis zu lesen, was die Verarbeitung stark beschleunigt und den Ressourcenverbrauch reduziert. Berichte über 100-fache Reduktion des Abfrageaufwands und eine erheblich geringere Cache-Nutzung zeugen von den beeindruckenden Optimierungen. Besonders bei Gruppierungen mit hoher Kardinalität oder mehrstufigen Aggregationen ist der Leistungsgewinn immens. Im Bereich Observability, Log- und Security-Analytics bringt OpenSearch 3.

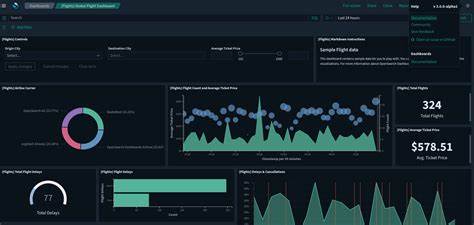

0 verbesserte Tools und erweiterte Abfragesprachenfunktionen. Die Erweiterung der Piped Processing Language (PPL) mit Lookup-, Join- und Subsearch-Kommandos ermöglicht eine noch effizientere Korrelation und Anreicherung von Logs, was vor allem Sicherheitsanalysten und Überwachungsspezialisten zugutekommt. Die Integration von Apache Calcite verbessert die Planungs- und Ausführungsperformance der Abfragen und legt die Basis für zukünftige, noch leistungsfähigere Features. Die Query Insights verbessern die Überwachung und Analyse von Suchanfragen erheblich. Durch die Live Queries API erhält man Echtzeitübersichten über aktuell laufende Abfragen.

So können lange oder ressourcenintensive Suchvorgänge schnell erkannt und bei Bedarf abgebrochen werden. Die Verwendung eines Verbose-Parameters reduziert Payload-Größen und sorgt für reibungslose Dashboards auch bei der Auswertung tausender Suchvorgänge. Dynamische Spalten passen sich kontextsensitiv an, wodurch die Nutzeroberfläche übersichtlich und sinnvoll bleibt. Die Funktion „Contextual Launch“ aus dem Discover-Interface ermöglicht es, direkt aus der Datenerfassung heraus Anomalie-Detektoren zu starten und relevante Logs automatisch bereitzustellen. Das erleichtert die Fehlersuche und macht Analyseprozesse effizienter.

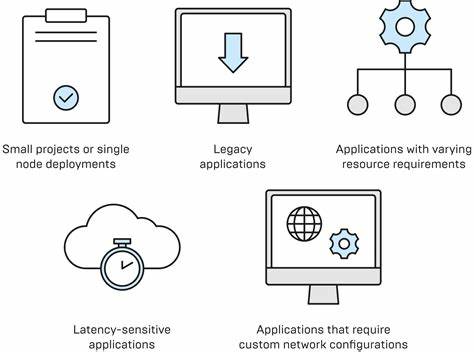

Die modulare Architektur von OpenSearch wird durch die Trennung von Lese- und Schreiboperationen in Remote-Store-Clustern verfeinert. Dieses Feature erlaubt unabhängige Skalierung und isoliert Fehlerquellen besser, was besonders bei Szenarien mit hohen Indexierungsvolumina und gleichzeitig intensiven Suchanforderungen vorteilhaft ist. Die Einführung einer _scale API bietet zudem die Möglichkeit, Schreibeoperationen abzuschalten und Indizes schreibgeschützt zu machen – ideal für archivierte Daten oder Log-Analysen, bei denen Daten selten geändert werden. Im Sicherheitsbereich ersetzt OpenSearch 3.0 den veralteten Java Security Manager durch einen neuen Java Agent.

Da der Security Manager mit JDK 24 endgültig entfernt wurde, ist dieser Schritt zwingend erforderlich, um gleichwertige Sandboxing- und Berechtigungskontrollen zu gewährleisten. Der neue Agent arbeitet mit Policy-Dateien, die Berechtigungen granular steuern und so die Sicherheit der Plattform auch weiterhin auf hohem Niveau halten. Performance-Verbesserungen für Sicherheitsfeatures wie Feldbezogene Sicherheit, Feldmaskierung und Dokumentebene steigern die Effizienz und reduzieren die interne Datenverarbeitung bei der Kommunikation im Cluster. Dies führt zu stabileren und schnelleren Systemen bei komplexen Sicherheitsregeln. Für die Versionsreihe 3.

![Do It – Your AI Study Coach [video]](/images/7D7D90ED-800D-41A9-8E67-936FABBB6DC7)