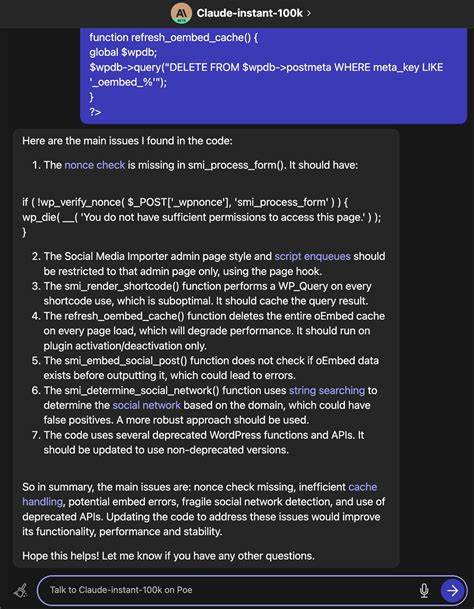

In der heutigen datengetriebenen Welt sind große Sprachmodelle (Large Language Models, LLMs) zu einem zentralen Instrument für die Verarbeitung von Informationen geworden. Sie brillieren dabei vor allem bei der Analyse von Text- und Bilddaten. Doch eine der bislang wenig befriedigend gelösten Aufgaben besteht darin, tabellarische Daten effektiv zu nutzen und daraus sinnvolle Schlüsse zu ziehen. Tabellen stellen eine typische Datenstruktur in vielen Bereichen dar – von wissenschaftlichen Umfragen über administrative Datensätze bis hin zu Geschäftsdaten. Die Herausforderung dabei ist, wie LLMs diese strukturierten Informationen richtig erfassen und interpretieren können, um echtes Wissen abzuleiten, das über einfache statistische Zusammenfassungen hinausgeht.

Das Kernproblem bei der Nutzung tabellarischer Daten in großen Sprachmodellen liegt in der Art der Datenrepräsentation. Eine naheliegende Methode wäre, jede Tabellenzeile als einen Textsatz zu betrachten und so die Informationen zu überführen. Doch diese Vorgehensweise ist aus mehreren Gründen problematisch. Sie führt oft dazu, dass Korrelationen oder Datenzusammenhänge nicht erkannt werden. Außerdem kann das wiederholte Auftauchen ähnlicher Datenpunkte, beispielsweise in sogenannten Long-Form-Tabellen, zu redundanten oder irreführenden Informationen für das Modell führen.

In der Praxis bedeutet dies, dass einzelne Fakten zwar verarbeitet werden, das Gesamtverständnis und die Verknüpfung der Datenpunkte jedoch verloren gehen. Damit bleibt ein erhebliches Potenzial ungenutzt.Eine vielversprechende Alternative besteht darin, mechanische Distillationstechniken anzuwenden. Dieser Ansatz ist inspiriert von der statistischen Datenanalyse und zielt darauf ab, univariate, bivariate und multivariate Zusammenfassungen der Daten zu erstellen. Zum Beispiel kann man Mittelwerte (univariat), Korrelationen zwischen Variablen (bivariat) oder komplexe Beziehungen zwischen mehreren Spalten (multivariat) berechnen.

Hierbei ist es wichtig, den Tabellenaufbau korrekt zu identifizieren. Viele Datensätze enthalten weitere Metadaten oder Datenbeschreibungen, sogenannte Data Dictionaries, die Auskunft über die Struktur und Bedeutung der Daten geben. Mit diesen Informationen lassen sich bessere Annahmen über das Datenformat treffen, wodurch die automatisch generierten Zusammenfassungen deutlich genauer und informativer werden.Zusätzlich zur statistischen Zusammenfassung ist die Frage von großer Bedeutung, welche Rückfragen man an die Daten stellen kann, um nützliche Einsichten zu gewinnen. Hier kommt der Einsatz von großen Sprachmodellen selbst ins Spiel: Durch das gezielte Prompting können diese Modelle dazu gebracht werden, potenzielle Fragestellungen zu generieren, die auf die konkreten Daten passen.

Diese Fragen dienen wiederum als Grundlage, um die mechanisch erstellten Statistiken und Diagramme mit erklärenden Antworten zu versehen. So ergänzt die KI die rein zahlenbasierte Auswertung um kontextbezogene Interpretation und erweitert damit den Wert der Datenanalyse.Ein zentraler Bestandteil eines solchen Analyse-Workflows besteht darin, das Verständnis für die Datenerhebung und -struktur systematisch zu erfassen. Nur wer die Herkunft, die Erhebungsmethode und die Aufbereitung der Daten kennt, kann am Ende verlässliche Ergebnisse liefern. Dies dient gleichzeitig auch dazu, Fehlerquellen und mögliche Verzerrungen zu erkennen, die bei Tabellendaten häufig auftreten.

Beispielsweise müssen Messfehler, fehlende Werte oder korrelierende Variablen richtig eingeordnet und behandelt werden.Obwohl diese mechanischen Zusammenführungen und durchdachte Fragestellungen vielversprechend erscheinen, ist es dennoch wichtig, die Grenzen der Methoden zu akzeptieren. Die Komplexität und Vielfalt tabellarischer Daten lassen sich nicht vollständig in wenigen Fragen und statistischen Werten abbilden. Die Anzahl möglicher Fragen an einen Datensatz ist theoretisch unbegrenzt, weshalb der beschriebene Ansatz immer nur eine Annäherung an den Idealfall darstellt. Dennoch bietet die Kombination aus Datenverständnis, KI-generierten Fragestellungen und statistischer Analyse eine leistungsfähige Methode, um die Informationsaufnahme aus Tabellen deutlich zu verbessern.

Die Anwendung solcher extrahierter Informationen geht weit über die reine Datenanalyse hinaus. Ein wichtiges Einsatzfeld ist die Verbesserung von Retrieval-Augmented Generations (RAGs), bei denen externe Datenquellen eingebunden werden, um umfangreichere und aktuellere Antworten aus LLMs zu generieren. Insbesondere wissenschaftliche Datensammlungen aus Plattformen wie dem Harvard Dataverse bieten wertvolle Ressourcen, die durch den beschriebenen Pipeline-Ansatz effizient genutzt werden können. Ebenso ist die Methode geeignet, um administrative Daten, die häufig in Tabellendatenformaten vorliegen, gewinnbringend zu analysieren.Bemerkenswert ist, dass das vorgestellte Konzept nicht auf klassische Tabellen beschränkt bleiben muss.

Daten in JSON-Formaten oder anderen strukturierten Datenformaten sind ebenfalls von einer verbesserten Extraktion und Verdichtung durch LLMs betroffen und können mit vergleichbaren Methoden bearbeitet werden. Die Herausforderung bleibt stets dieselbe: die Struktur der Daten richtig zu verstehen, geeignete Fragen zu ermitteln und daraus wertvolle Zusammenfassungen zu bilden.Insgesamt eröffnet die Kombination aus mechanischer Datenverarbeitung und KI-gestützter Fragestellung eine neue Perspektive für die Nutzung großer Sprachmodelle im Umgang mit strukturierten Daten. Während LLMs heute vor allem für unstrukturierte Textdaten optimiert sind, bietet der gezielte Ansatz für Tabellendaten einen vielversprechenden Schritt hin zu umfassenderem Wissenserwerb. So lassen sich wichtige Erkenntnisse aus Datensätzen ziehen, die bisher weitgehend ungenutzt blieben, und neue Anwendungsszenarien in Wissenschaft, Wirtschaft und Verwaltung erschließen.

Voraussichtlich wird die Weiterentwicklung dieser Methoden zu einer stärkeren Integration von Tabellenwissen in große Sprachmodelle führen, wodurch deren Wissensbasis und ihre Einsatzmöglichkeiten signifikant erweitert werden. Dies dürfte sich langfristig auch auf Suchmaschinen, Data Science Tools und KI-gestützte Entscheidungsunterstützungssysteme positiv auswirken. Die Zukunft zeigt, dass die Verbindung von intelligenter Datenrepräsentation, KI-generierten Fragestellungen und systematischen Zusammenfassungen das Potential hat, die Informationsverarbeitung auf ein neues Niveau zu heben und die bisher unzureichend genutzten Schätze tabellarischer Daten zu heben.

![NRC: Long-Term Cooling and Unattended Water Makeup of Spent Fuel Pools [pdf]](/images/3A9200E1-34D2-4138-8FAE-4C177FB9B21D)