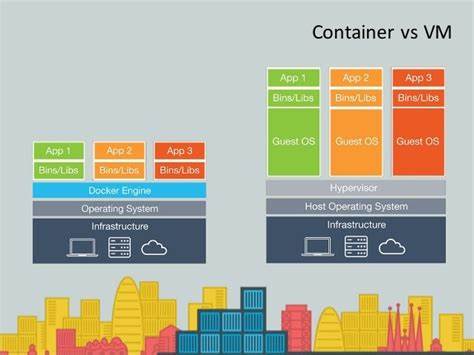

In der dynamisch wachsenden Welt der IT-Infrastruktur erleben wir eine wegweisende Entwicklung: Die nächste Welle der Virtualisierung ist containerisiert. Während traditionelle Virtualisierungslösungen wie VMware lange Zeit den Markt dominierten, wird das Paradigma zunehmend durch containerbasierte Virtualisierung in Kubernetes-Umgebungen abgelöst. Die Verschmelzung von Containern und virtuellen Maschinen eröffnet Unternehmen neue Möglichkeiten zur Effizienzsteigerung, Kostenoptimierung und Vereinfachung des IT-Betriebs. Die Motivation hinter diesem Wandel ist vielschichtig. Ein zentraler Faktor sind die stetig steigenden Lizenzkosten für Hypervisoren, die viele Organisationen dazu veranlassen, Alternativen zu evaluieren und ihre Virtualisierungsstrategie zu überdenken.

Gleichzeitig zeigt der Markt, dass Containertechnologie zunehmend zur Basis moderner Anwendungen und Workloads wird. Gartner prognostiziert in seinem Magic Quadrant, dass bis 2027 über die Hälfte aller Container-Management-Deployments serverlose Containerdienste enthalten werden und der Anteil der auf Containertechnologie basierenden KI-Einsätze bis dahin über 75 Prozent betragen soll. Auch am Edge, wo individuelle Anpassbarkeit und schnelle Bereitstellung essenziell sind, wächst der Container-Einsatz rasant. Eine der wichtigsten Entwicklungen in diesem Kontext ist KubeVirt, ein Open-Source-Projekt, das es ermöglicht, virtuelle Maschinen nahtlos innerhalb von Kubernetes-Pods zu betreiben. Diese Verschmelzung schafft eine einheitliche Management-Ebene, über die Container und VMs gleichermaßen orchestriert werden können.

Damit entfällt die Notwendigkeit, separate Management-Tools oder Kontrollsysteme für unterschiedliche Workloads zu pflegen. Unternehmen erhalten eine konsolidierte Plattform für den Betrieb und die Überwachung ihrer Anwendungen und Systeme. Ein wesentlicher Vorteil von containerisierter Virtualisierung liegt in der erhöhten Sicherheit und Effizienz. Micro-VMs, die auf KubeVirt und optimierten Laufzeiten wie Firecracker basieren, bieten ultraschnelle Bootzeiten im Bereich von wenigen Millisekunden und isolieren Workloads in einer Weise, die ideal für serverlose oder kurzlebige Anwendungen ist. Diese Technologien sind bereits bei großen Cloud-Anbietern etabliert und zeigen ihr Engagement für Performance und Sicherheit.

Gerade im Kontext von Edge-Computing profitieren Unternehmen davon, da hier oft ressourcenbegrenzte Systeme verwaltet werden und ein konsistentes Management über heterogene Hardware hinweg entscheidend ist. Darüber hinaus sind containerisierte VMs besonders gut geeignet, GPU-Ressourcen sicher und effektiv zu verwalten. Für KI- und Machine-Learning-Workloads, die eine intensive Grafikverarbeitung erfordern, ist dies von großer Bedeutung. Die Möglichkeit, GPU-Ressourcen über den GPU Operator in KubeVirt sicher zu abstrahieren, ermöglicht es Plattformingenieuren, autonome und isolierte Umgebungen für unterschiedliche Teams bereitzustellen. Dadurch können Unternehmen künstliche Intelligenz und datengetriebene Anwendungen skalierbar und kontrolliert ausführen.

Traditionelle Virtualisierungslösungen sind auf vielen Unternehmensebenen nach wie vor von Bedeutung, insbesondere wenn es um private und hybride Cloud-Umgebungen geht, in denen sensible oder geschäftskritische Workloads laufen. Die Modernisierung von Anwendungen erfordert jedoch oft flexible Lösungen, die sich in moderne DevOps- und Plattform-Engineering-Praktiken einfügen. Die Kombination von Containern und VMs mittels KubeVirt bildet hierbei eine Brücke zwischen bewährten Technologien und zukunftsfähigen Cloud-Strategien. Unternehmen haben damit die Möglichkeit, auf einer zentralen Kontrollebene sowohl virtualisierte als auch containerisierte Anwendungen zu managen. Monitoring, Tracing und Observability lassen sich konsolidieren, wodurch die Transparenz über die gesamte IT-Landschaft wächst.

Dies vereinfacht Fehleranalysen, Performance-Optimierungen und erleichtert die Einhaltung von Compliance-Vorgaben. Zudem können Software-Artefakte für VMs und Container in einem OCI-kompatiblen Registry-Format bereitgestellt werden, was die Build- und Deployment-Prozesse harmonisiert. Die Einführung von containerisierter Virtualisierung erfolgt jedoch nicht ohne Herausforderungen. Die Lernkurve für IT-Teams, die bisher mit traditionellen Hypervisor-basierten Umgebungen arbeiteten, kann steil sein. Einige etablierte Anbieter versuchen, den Umstieg durch maßgeschneiderte Angebote, Migrationswerkzeuge und Trainingsprogramme zu erleichtern.

Der Fokus sollte dabei aber nicht nur auf Kosteneinsparungen liegen, sondern auf der Etablierung moderner Betriebsmodelle, die mit Plattform Engineering, GitOps und automatisierter Systemverwaltung ausgestattet sind. Die technologische Basis aus Kubernetes und KVM ist mittlerweile ausgereift und weit verbreitet. KVM, als Standard-Hypervisor im Linux-Kernel seit 2007, bietet Stabilität, Performance und eine breite Unterstützung durch Partnerlösungen. In Kombination mit Kubernetes ist die Druckreifung erreicht, um skalierbare, hybride Cloud-Architekturen aufzubauen, die sowohl Containern als auch virtuellen Maschinen gerecht werden. Das Ecosystem von Hewlett Packard Enterprise (HPE) steht Beispiele, wie man containerisierte Virtualisierung erfolgreich in die Praxis umsetzt.

HPE stellt eine umfassende Infrastruktur zur Verfügung, die Server, Netzwerke sowie Speicherlösungen wie HPE Alletra MP B10000 verbindet, um private und hybride Clouds zu betreiben. Dabei unterstützt HPE CSI-Treiber (Container Storage Interface) für Kubernetes sowohl Block- als auch Dateispeicher mit Funktionen wie Snapshots oder Live-Migration von VMs via KubeVirt. Auch Partnerschaften mit Red Hat, SUSE und Canonical veranschaulichen den Trend zur gemeinsamen Plattformstrategie. Red Hat OpenShift Virtualization ermöglicht das parallele Management von Containern und VMs und lässt sich nahtlos mit HPE GreenLake als Cloud-Service integrieren. SUSE Virtualization bietet eine hyperkonvergente Lösung, die auf KubeVirt aufbaut und mit HPE Speicherlösungen zusammenarbeitet.

Canonical bietet Unternehmen zudem Kubernetes mit Langzeit-Support und unterschiedlichen Kubernetes-Distributionen an, um den Weg hin zu containerisierter Virtualisierung zu ebnen. Die Zukunft der IT-Infrastruktur wird demnach nicht mehr in der Trennung von Container- und VM-Technologien liegen, sondern in deren Integration und einheitlichem Management. Containerisierte Virtualisierung bietet die Flexibilität, moderne Cloud-native Anwendungen zu betreiben, ohne auf die bewährte Stabilität und Isolation virtueller Maschinen zu verzichten. Dies trifft insbesondere in heterogenen Umgebungen wie Edge, Multi-Cloud- und Hybrid-Cloud-Infrastrukturen zu. Für Unternehmen bedeutet dies eine Gelegenheit, ihre Anwendungen und Systeme zukunftssicher auszurichten, Innovationen schneller zu integrieren und ihre IT-Kosten nachhaltig zu optimieren.

Das gemeinsame Zusammenspiel von Kubernetes, KVM und KubeVirt sowie die Unterstützung durch etablierte Hardware- und Softwarepartner schafft eine solide Basis, um die nächste Phase der Virtualisierung zu meistern. Wer heute in containerisierte Virtualisierung investiert, profitiert morgen von einer agilen, sicheren und effizienten IT-Landschaft, die den Anforderungen einer zunehmend digitalisierten und vernetzten Welt gerecht wird.