Im Vorfeld der World Science Fiction Convention 2025 in Seattle hat die Organisatorin Kathy Bond eine öffentliche Stellungnahme zur Nutzung von Künstlicher Intelligenz (KI), genauer gesagt eines Large Language Models (LLM), im Vetting-Prozess für Programmteilnehmer veröffentlicht. Diese Entscheidung, KI-Technologie für die Bewertung von über 1.300 Bewerbungen einzusetzen, hat innerhalb der Science-Fiction-Community eine breite öffentliche Debatte ausgelöst. Die Reaktionen reichen von Verständnis und Neugier bis hin zu scharfer Kritik und Besorgnis hinsichtlich ethischer, ökologischer und datenschutzrechtlicher Aspekte. Die folgende Analyse beleuchtet die Hintergründe der Entscheidung, den tatsächlichen Prozess, die Kontroversen und die möglichen Folgen für zukünftige Veranstaltungen.

Die Notwendigkeit der Automatisierung Die Organisation einer Großveranstaltung wie der Worldcon ist eine komplexe und zeitintensive Aufgabe, besonders wenn es um die Programmauswahl geht. Bei der Seattle Worldcon 2025 lagen mehr als 1.300 Bewerbungen für Panels vor. Traditionell wurden die Bewerbungen manuell oder mit einfachen Internetrecherchen geprüft, was je nach Bewerber zwischen zehn und dreißig Minuten dauern kann. Um den enormen Aufwand zu reduzieren, wurden zunehmend digitale Hilfsmittel eingesetzt.

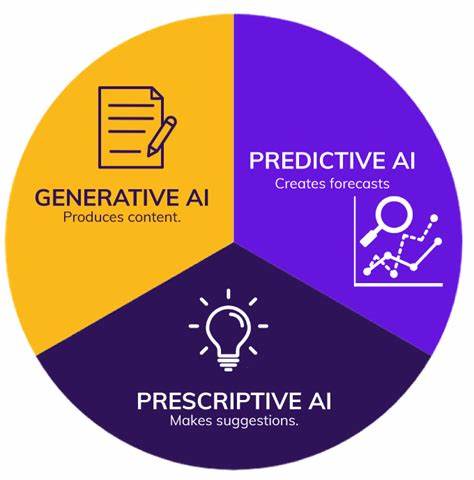

Vor diesem Hintergrund entschied sich das Organisationskomitee, experimentell ein LLM einzusetzen, das den Rechercheprozess automatisieren soll. Das Ziel war es, die Online-Suche zu beschleunigen, indem der Name des Bewerbers als einzige Eingabe verwendet wird, woraufhin das LLM aggregierte Ergebnisse und Quellen aus dem Internet zusammenstellt. Transparenz und Ablauf In ihrer Erklärung hob Kathy Bond hervor, dass bei der Nutzung des LLM ausschließlich der Name der Bewerber in das System eingegeben wurde, ohne weitere persönliche Daten oder Hintergrundinformationen. Es bestand von Anfang an eine bewusste Skepsis gegenüber generativen KI-Systemen, vor allem bezüglich ihrer Zuverlässigkeit. Daher wurde der Output des LLMs nicht ungeprüft übernommen.

Stattdessen erfolgte eine Überprüfung aller Ergebnisse durch mehrere menschliche Teammitglieder. Interessierte Programmleiter führten zusätzliche Nachforschungen durch, insbesondere bei kritischen Bewertungen. Die Verwendung des LLMs war auf das Aggregieren von Online-Quellen beschränkt und sollte keinesfalls allein über eine Annahme oder Ablehnung entscheiden. Die Erklärung betont ausdrücklich, dass niemand ausschließlich aufgrund der KI-Auswertung abgelehnt wurde. Reaktionen der Community Die Bekanntgabe dieser Praxis löste eine Flut von Kommentaren aus, viele davon kritisch bis empört.

Ein zentraler Kritikpunkt ist die ethische Dimension des Einsatzes von LLMs, die mit den Arbeiten zahlreicher SFF-Autoren ohne deren Zustimmung trainiert wurden. Viele Stimmen betrachten die Nutzung solcher Tools als indirekte Billigung von Urheberrechtsverletzungen und unethischem Umgang mit geistigem Eigentum. Zudem wurde die Umweltbelastung durch den hohen Energieverbrauch von KI-Anwendungen thematisiert. Darüber hinaus bestehen erhebliche Sorge wegen der Genauigkeit und Fairness der KI-gestützten Bewertung. LLMs sind bekanntlich fehleranfällig, produzieren sogenannte Halluzinationen mit erfundenen Fakten und weisen oft verborgene Verzerrungen auf, die insbesondere marginalisierte Gruppen benachteiligen können.

Weitere Empörung entzündete sich daran, dass die Verwendung einer KI im Auswahlprozess weder bei der Einreichung der Bewerbungen erwähnt noch vorher öffentlich diskutiert wurde. Viele Bewerber fühlten sich hintergangen und forderten Einsicht in die von der KI erzeugten Bewertungen inklusive der Möglichkeit zur Berichtigung falscher Informationen. Das Fehlen klarer, nachvollziehbarer Bewertungskriterien führte zu Unsicherheit und Misstrauen. Einige Personen beklagten, dass zwar angeblich alle abgelehnten Kandidaten intensiv überprüft wurden, aber positive Bewertungen durch die KI möglicherweise ohne weitere menschliche Kontrolle Zugriff auf Programmposten ermöglicht haben könnten – eine potenzielle Quelle von Ungerechtigkeit. Technische und methodische Kritik Die Entscheidung, ein LLM anstelle herkömmlicher Suchmaschinenskripte zu verwenden, ist für viele Fachleute fragwürdig.

Suchmaschinenskripte liefern faktische Links und Informationsquellen, die von Menschen selbst bewertet werden können. Demgegenüber fassen LLMs Informationen zusammen und generieren Inhalte, die trotz Quellenangaben fehlerhaft sein können. Die technische Herausforderung, KI-gestützte Ergebnisse verlässlich und umfassend zu prüfen, ist erheblich. Damit bleibt der Prozess anfällig für Missverständnisse und Fehler. Einige Kommentatoren stellten zudem infrage, ob durch die eingesetzten KI-Sprachmodelle wirklich Zeit gespart wurde, da viel Aufwand in die nachträgliche Validierung durch Menschen floss.

Datenschutz und rechtliche Implikationen wurden ebenfalls als Problem benannt. Das Einfügen von Bewerbernamen in ein KI-System wirft Fragen hinsichtlich persönlicher Identifizierbarkeit (PII) auf. Gerade in Europa gelten strenge Datenschutzregeln (z.B. DSGVO), deren Einhaltung scheinbar unklar blieb.

Auch wird die Eindeutigkeit von Namen kritisiert, da mehrere Personen denselben Namen tragen können, was die Zuverlässigkeit eines rein namensbasierten Suchvorgangs stark einschränkt. Vertrauens- und Glaubwürdigkeitsverlust Die Folgen des LLM-Einsatzes sind nicht nur technischer oder organisatorischer Natur, sondern betreffen vor allem das Vertrauen der Community. Die Worldcon ist traditionell eine Veranstaltung, die auf gemeinschaftlichem Engagement, gegenseitigem Respekt und kreativer Wertschätzung basiert. Die Entscheidung, eine Technologie einzusetzen, die viele Teilnehmer ablehnen oder gar als schädlich empfinden, hat das Ansehen der Veranstaltung beschädigt. Zahlreiche engagierte Autorinnen, Künstler und Fans kündigten an, nicht teilzunehmen oder ihre Mitarbeit zu überdenken, was die Vielfalt und Qualität des Programms gefährden könnte.

Die Forderung nach größtmöglicher Transparenz wird wiederholt vorgebracht. Viele wünschen sich die Offenlegung der genauen Suchanfragen an das LLM, der ermittelten Bewertungen und der Kriterien, nach denen menschliche Überprüfungen vorgenommen wurden. Nur so kann sichergestellt werden, dass keine Diskriminierung oder Verfälschung im System stattgefunden hat. Zudem raten Stimmen aus der Community zu einer vollständigen Rücknahme der KI-gestützten Auswahlverfahren und einer Neuorganisation des Vetting-Prozesses unter menschlicher Leitung. Alternativen und Lehren für die Zukunft Experten und erfahrene Mitglieder der Science-Fiction-Community schlagen vor, die Auswahl künftig zu dezentralisieren und stärker auf menschliche Fachkenntnis und Engagement zu setzen.

Die Nutzung einfacher Skripte, die Suchmaschinenergebnisse sammeln und aufbereiten, wurde als praktikable Alternative benannt. Dies erfordert zwar mehr Zeit- und Personalaufwand, gilt aber als ethisch vertretbarer und verlässlicher Prozess. Darüber hinaus fordern Kritiker vor allem, dass KI-Anwendungen nur nach vorheriger öffentlicher Diskussion, Zustimmung der Betroffenen und unter Berücksichtigung von Datenschutz sowie Umweltaspekten eingeführt werden sollten. Der Umgang mit Künstlicher Intelligenz in kulturellen und kreativen Kontexten verlangt einen verantwortungsvollen und transparenten Einsatz, der das Vertrauen der Beteiligten wahrt. Fazit Die Verwendung von KI-Tools im Vetting-Prozess der Worldcon 2025 bringt eine Reihe kritischer Fragen und Herausforderungen mit sich.