In der heutigen schnelllebigen digitalen Welt sind Informationen vielfach verteilt und liegen in unterschiedlichen Formaten vor. Unternehmen, Forschende und Analysten stoßen zunehmend auf die Herausforderung, nicht nur Texte zu durchsuchen, sondern auch Bilder, Videos und Audiodateien in ihre Recherchen einzubeziehen. Hier kommen multimodale Deep Research Agents ins Spiel: KI-gestützte Systeme, die verschiedene Medienarten verarbeiten, tiefgreifend analysieren und miteinander verknüpfen, um ein ganzheitliches Verständnis komplexer Informationslandschaften zu liefern. Die Bedeutung multimodaler Deep Research Agents resultiert aus den Grenzen klassischer, textbasierter Suchmethoden. Text allein kann wichtige Aspekte übersehen, die nur visuell oder auditiv erkennbar sind.

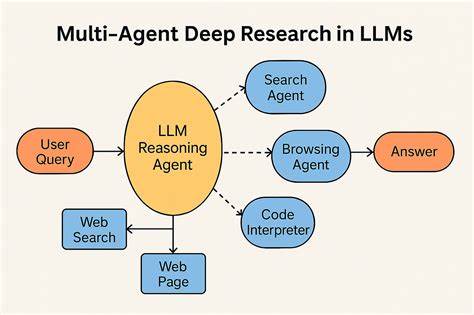

Beispielsweise können Produktbilder auf Webseiten wichtige Designänderungen offenbaren, die in technische Dokumentationen nicht erwähnt werden. Oder Stimmungen und Emotionen, etwa aus Tonaufnahmen von Konferenzen oder Podcasts, lassen sich kaum rein textbasiert erfassen. Multimodale Forschung überschreitet diese Barrieren, indem sie visuelle, auditive und textuelle Informationen kombiniert und somit neue Einblicke schafft. Der Kern multimodaler Deep Research Agents ist eine erweiterte Such- und Analyse-Schleife, die nicht nur Texte abfragt, sondern auch Bilder, Videos und Audiodateien verarbeitet. Mit jeder Iteration wird der Forschungsprozess verfeinert: Lücken und neue Fragestellungen werden erkannt, gezielt weiterverfolgt und beantwortet.

Dieses kontinuierliche „Suchen, Sehen, Hören und Vernetzen“ verleiht der KI die Fähigkeit, wie ein digitaler Sherlock Holmes zu agieren und Zusammenhänge über Medien hinweg herzustellen. In der Praxis bedeutet das, dass eine multimodale Agentin etwa ein Marketingvideo eines Wettbewerbers analysiert, Screenshots von Produktoberflächen interpretiert, Audiotranskripte von Telefonkonferenzen auswertet und begleitende technische Dokumente nach Details durchsucht. So entstehen umfassende Wettbewerbsanalysen, die weit über die Möglichkeiten herkömmlicher Recherchesysteme hinausgehen. Technisch erfordert ein solcher Agent spezialisierte Pipelines für die einzelnen Modalitäten. Beim Umgang mit Bildern kommen Verfahren der Objekterkennung, Szenenverständnis sowie optional Gesichtserkennung zum Einsatz.

Für Videos ist eine Kombination aus der Extraktion von Schlüsselbildern (Keyframes), audiobasierter Analyse und der Erfassung zeitlicher Abläufe notwendig. Audiodateien werden mittels Spracherkennung, Sprecheridentifikation sowie Tonalitäts- und Sentimentanalyse ausgewertet. Textinhalte durchlaufen klassische NLP-Verfahren wie Text Mining, Named Entity Recognition oder Sentiment-Analysen. Das eigentliche Geheimnis multimodaler Agents liegt in der semantischen Vernetzung der unterschiedlichen Medieninhalte. Jedes Analyseergebnis wird in einen gemeinsamen semantischen Raum projiziert, der die verschiedenen Modalitäten verbindet.

So können zum Beispiel visuelle Hinweise auf Produktmerkmale mit technischen Textbeschreibungen abgeglichen oder Stimmen in Videos mit auditiven Stimmungseinschätzungen korreliert werden. Diese sogenannte Cross-Modal Reasoning Engine kombiniert die fragmentierten Erkenntnisse zu einer kohärenten Wissensgraph-Struktur und ermöglicht so tiefergehende Schlussfolgerungen, die auf einer einzelnen Informationsquelle nicht möglich wären. Dennoch ist der Aufbau solcher System komplex und mit mehreren Herausforderungen verbunden. Eine der größten Schwierigkeiten ist das explosive Wachstum des Kontextumfangs. Multimodale Daten generieren enorm viele Informationen, beispielsweise tausende Tokens alleine durch die Transkription eines einstündigen Videos kombiniert mit visueller Analyse und Meta-Informationen.

Um diese Komplexität handhabbar zu machen, setzen Entwickler auf kontextspezifische Kompressionstechniken, die Informationen modulare und hierarchisch verdichten, ohne relevante Details zu verlieren. Ein weiteres bekanntes Problem ist die Neigung von KI-Modellen, sogenannte Halluzinationen zu produzieren – also Inhalte zu generieren, die faktisch nicht vorhanden sind. Besonders bei multimodaler Verarbeitung können visuelle Modelle falsche Objekte erkennen oder Audiomodelle erfundene Gespräche interpretieren. Um dem entgegenzuwirken, werden Cross-Modal Validierungsmethoden eingesetzt: Erkenntnisse aus einer Modalität werden mit Befunden aus anderen geprüft, externe Quellen als Referenz herangezogen und eine Vertrauensbewertung vorgenommen. So entsteht eine robuste und glaubwürdigere Analyse.

Zusätzlich besteht die Herausforderung, eine angemessene Gewichtung der Modalitäten vorzunehmen. Nicht alle Medien sind für jede Fragestellung gleich relevant oder vertrauenswürdig. Während Textquellen tendenziell Faktenpräzision liefern, eignen sich visuelle Daten besser zur Erfassung räumlicher Relationen und Audioinhalte vermitteln Information über Emotionen und Stimmungen. Multimodale Agents müssen Domain-spezifische Autoritäts-Hierarchien etablieren und das Ergebnis entsprechend adaptiv skalieren. Die technische Umsetzung basiert auf einem modularen Software-Stack, der spezialisierte Modelle für Sprache, Bild und Audio integriert.

Ergänzend nutzen diese Systeme semantische Suchplattformen wie Mixpeek, die multimodale Indexierung und Suche über verschiedene Formate hinweg ermöglichen. Effiziente Technologien zur parallelen Verarbeitung gewährleisten eine leistungsfähige Analyse von großen Datenmengen und der intelligente Einsatz von Caching hilft, Kosten und Rechenzeiten zu optimieren. In der Praxis zeigt sich die Stärke multimodaler Deep Research Agents in vielfältigen Anwendungsgebieten. Wettbewerbsanalysen profitieren von der Analyse kompletter Marketingkampagnen inklusive visueller Werbematerialien und Audiointerviews. Im Bereich der Content Compliance können Unternehmen große Mengen an Video- und Audioinhalten auf Regelverstöße oder problematische Inhalte überprüfen.

Auch im technischen Umfeld erlaubt die Kombination aus Architekturzeichnungen, Quellcode und begleitender Dokumentation ein besseres Verständnis komplexer Systeme. Die Weiterentwicklung dieses Felds setzt auf fortgeschrittene Funktionen wie temporale Analyse in Videos, die nicht nur Einzelbilder betrachten, sondern gerichtete Abläufe und Zeitverläufe verstehen. Die Fähigkeit zur Faktenprüfung über Modalitäten hinweg trägt zur erhöhten Zuverlässigkeit bei. Darüber hinaus erlaubt die Integration von Echtzeitanalysen künftige Anwendungen wie Live-Überwachung, sowie multimodale Benutzerinterfaces, die auf Sprache, Gestik und visuelle Signale reagieren. Aus technischer Sicht ist bei multimodalen Agents stets ein Balanceakt zwischen Genauigkeit, Verarbeitungszeit und Kosten gefragt.

Höhere Präzision führt oft zu längeren Analysezeiten und höheren Rechenanforderungen. Unternehmen müssen daher bewusst wählen, bei welchen Fragestellungen schnelle Resultate ausreichen und wo tiefergehende Analysen den Mehrwert rechtfertigen. Zusammenfassend lässt sich festhalten, dass multimodale Deep Research Agents den Schritt vom isolierten Textsearch zum ganzheitlichen Verständnis verschiedener Medien ermöglichen. Die Fähigkeit, visuelle, auditive und textuelle Informationen gleichzeitig zu verarbeiten und zu synthetisieren, führt zu signifikant verbesserten Erkenntnissen, schnellerer Entscheidungsfindung und einer neuen Qualität in der KI-gestützten Forschung. Die Zukunft der Recherche wird multimodal sein – Forscher, Unternehmen und Entwickler, die heute in die Integration solcher Plattformen investieren, werden langfristig entscheidende Wettbewerbsvorteile erzielen.

Erste Schritte können mit bewährten Text- und Bildanalyseverfahren erfolgen, bevor komplexere Audio- und Videoanalysen die Agenten ergänzen. Im Zentrum stehen dabei immer ein robustes Kontextmanagement, smarte Validierung und eine performante Systemarchitektur. Langfristig darf man darüber hinaus gespannt sein, wie Technologien wie 3D-Raumverständnis, Emotionserkennung über Sinne hinweg und interaktive multimodale Schnittstellen den Kommunikations- und Analyseprozess revolutionieren. Multimodale Deep Research Agents sind damit der Schlüssel zu einer neuen Ära umfassender, intuitiver und intelligenter Informationsverarbeitung.