In der modernen Softwareentwicklung wächst die Datenmenge rasant, insbesondere in Anwendungen, die eine lückenlose Historie von Änderungen speichern müssen. In Ruby on Rails-Projekten mit PostgreSQL-Datenbanken kann eine einzelne Tabelle schnell astronomische Größen erreichen – besonders wenn sie alle Änderungen protokolliert, wie es bei Audit-Tabellen der Fall ist. Ohne entsprechende Maßnahmen führt das zu erheblichen Performanceeinbußen, hohen Kosten und administrativen Herausforderungen. Die Partitionierung großer Tabellen ist eine bewährte Methode, um diesen Problemen entgegenzuwirken und die Skalierbarkeit der Datenbank deutlich zu erhöhen. Diese Technik teilt eine physisch große Tabelle in kleinere, überschaubare Stücke auf, ohne dass die Anwendung dabei ihre Sicht auf die Daten verlieren muss.

Die Gründe, warum eine Partitionierung notwendig wird, liegen auf der Hand. Wenn eine Tabelle Milliarden von Zeilen enthält und sich über Jahre oder Jahrzehnte historische Daten ansammeln, belastet das nicht nur den Speicherplatz, sondern verlangsamt Abfragen maßgeblich. Indexe wachsen überhand, passen nicht mehr in den Speicher, und die Datenbank muss ständig auf langsame Festplatten auslagern, was die Antwortzeiten verlängert. Außerdem steigen die Kosten für Speicher und Backups exponentiell, wie beispielsweise bei Cloud-Diensten wie Amazon RDS. Eine große Tabelle erhöht zudem das Risiko bei Wiederherstellungsmaßnahmen, da der Datenbank-Backup- und Restore-Vorgang immer länger dauert und die operative Komplexität wächst.

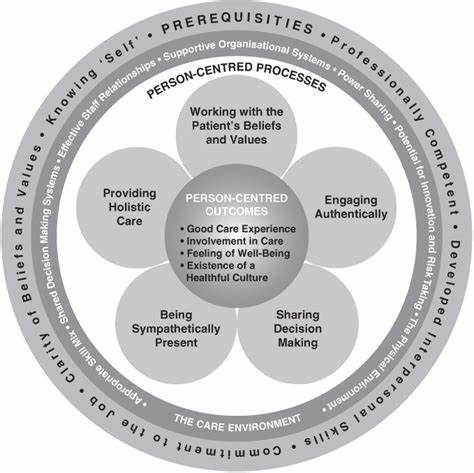

In vielen Anwendungen weisen Audit-Tabellen ein typisches Zugriffsmuster auf: Das sogenannte Hot-to-Cold-Access-Prinzip. Neue Daten werden intensiv genutzt – etwa für Benachrichtigungen oder Echtzeit-Analysen – während ältere Daten nach und nach in den Hintergrund treten. Bei den meisten Abfragen greifen Nutzer oder Systeme auf die Daten des letzten Monats oder Jahres zu, und Zugriffe auf ältere Aufzeichnungen sind selten. Ein solcher Zugriffsmuster legt nahe, dass ältere Daten ausgelagert werden können, um die hohe Performance „heißen“ Datenbereichs zu ermöglichen und gleichzeitig die langfristige Datenaufbewahrung sicherzustellen. Ein praktikabler Lösungsansatz kombiniert das Partitionieren mit effizienten Archivierungsprozessen: Audits, die älter als beispielsweise zwölf Monate sind, wandern als Paket auf kostengünstigen, langlebigen Speicher wie Amazon S3.

Dort bleiben sie für Langzeitanalysen oder Compliance-Zwecke zugänglich, während die aktive Datenbank schlank und performant bleibt. Nach der erfolgreichen Archivierung der Daten müssen diese aus der Datenbank entfernt werden, doch Massenlöschungen verursachen oft MVCC-bedingte Overhead-Probleme, Locking und Fragmentierung, die wiederum die Leistungsfähigkeit beeinträchtigen. Hier kommt die deklarative Partitionierung von PostgreSQL ins Spiel. Sie ist eine native Funktion, die seit Version 10 zur Verfügung steht und die Datenbank in die Lage versetzt, Tabellen elegant in Partitionen zu unterteilen. Dabei bleiben sämtliche Abfragen und Schreiboperationen unverändert, während PostgreSQL die Last intelligent auf die einzelnen Partitionen verteilt.

Besonders der Ansatz der Range-Partitionierung eignet sich hervorragend für zeitbasierte Daten wie Audit-Logs, da dabei Daten in nicht überlappenden Wertebereichen gespeichert werden – zum Beispiel pro Monat. Das wichtigste Merkmal der deklarativen Partitionierung ist die Partition Pruning-Funktion. Sie sorgt dafür, dass bei Abfragen mit Filterkriterien auf dem Partitionierungsschlüssel nur relevante Partitionssegmente durchsucht werden. Dies beschleunigt besonders die Zugriffe auf jüngere Daten enorm, da ältere Partitionen von Anfang an ausgeschlossen werden. Zudem ermöglicht das schnelle Abtrennen von ganzen Partitionen – statt mühsamer Zeilenlöschungen – eine unkomplizierte und ressourcenschonende Datenbereinigung.

Denn das Entfernen kompletter Partitionen ist ein nahezu instantaner Metadatenvorgang, der massiv Zeit und Systemressourcen spart. Die Wahl des Partitionierungsschlüssels ist ein kritisches Design-Element. Er muss eine Eigenschaft der Daten widerspiegeln, die geeignet ist, diese sinnvoll zu segmentieren und gleichzeitig die Integrität zu wahren. Im Audit-Datenbestand empfiehlt sich häufig das Zeitstempel-Attribut. Doch in manchen Fällen, wie bei individuellen ID-Generierungen, können auch andere Spalten verwendet werden, solange sie mit zeitlicher Ordnung korrelieren.

Insbesondere wenn ein Primärschlüssel aus einem 64-Bit-Zeitstempel-ähnlichen Wert besteht, lässt sich die Tabelle wirkungsvoll danach partitionsbasiert aufteilen. Die große Herausforderung bei der Migration einer bereits mehrere Milliarden Zeilen umfassenden Tabelle liegt darin, keine Ausfallzeiten zu verursachen. Eine Umschichtung der Daten durch Verschieben oder Kopieren verursacht Schreib-Locks und kann die Bank erheblich belasten. Stattdessen erlaubt PostgreSQL, sogenannte existierende Tabellen als Partitionen anzuhängen. Dabei werden keine Daten verschoben, sondern die Struktur so erweitert, dass die ursprüngliche Tabelle als eine Partition innerhalb einer neuen partitionierten Haupttabelle fungiert.

Allerdings erfordert das Anfügen einer Tabelle als Partition, dass diese nur Werte im gewünschten Bereich enthält. Die Prüfung darüber führt zu einem vollständigen Tabellenscan, der bei sehr großen Tabellen zu langen Sperrzeiten führt. Hier umgehen erfahrene Entwickler diese Einschränkung, indem sie zuerst einen CHECK-Constraint mit der Option NOT VALID anlegen, der zukünftig eingefügte Zeilen sofort validiert, die historischen Daten aber noch ausgespart werden. Die spätere Validierung des Constraints läuft mit weniger restriktiven Sperren, so dass kein nennenswerter Betriebsstillstand entsteht. Ein weiteres großes Thema ist der Umgang mit Ausreißerwerten, also Datensätzen, deren Werte nicht in die definierten Partitionierungsbereiche passen.

Für diese hält PostgreSQL eine Default-Partition bereit, die als Auffangbecken für Daten außerhalb aller regulären Partitionen dient. Für die Übergangsphase setzt man gerne auf die ältere Methode der Partitionierung per Tabellenvererbung mit Triggern, um so den Datenfluss ohne größere Unterbrechungen zu steuern. Zwar ist dieser Ansatz mit Wartungsaufwand und Performanceeinbußen verbunden, doch er erleichtert das Sanieren großer Datenmengen, bevor der endgültige Schritt zur deklarativen Partitionierung erfolgt. Die Umstellung auf deklarative Partitionierung erfolgt schrittweise mit der Trennung von Architektur und Anwendung. Rails unterstützt Partitionierungsfunktionen inzwischen mit speziellen Gems wie pg_party sowie über eigene Integrationen, die Migrationen vereinfachen und die Automatisierung im Betrieb ermöglichen.

Dazu gehört das Anlegen neuer Partitionen vor deren Bedarf, das automatisierte Abwerfen älterer Partitionen nach erfolgreichem Archivieren sowie das Entfernen von nicht mehr benötigten Partitionen, um Ressourcen freizugeben. Im Verlauf der Migration empfiehlt es sich, sämtliche Schematalemente wie Indizes, Constraints und Row-Level-Security-Policies vorab akribisch auf jede Partition anzuwenden. Postgres benötigt diese Objekte auf allen Partitionen, um Integrität und Zugriffssteuerung nachhaltig zu garantieren. Insbesondere Indizes sollten vor dem Anfügen einer Partition bereits existieren, um teure Sperrzeiten durch automatische Indexerstellung zu vermeiden. Der Aufwand der Partitionierung zahlt sich in vielfacher Hinsicht aus.

Die Performance bei Abfragen wird durch Partition Pruning und kleinere, effizientere Indizes signifikant besser. Die Betriebsführung wird leichter, da das Archivieren, Verwalten und Löschen von Daten granulärer und kostengünstiger erfolgt. Durch automatisierte Jobs in Rails lassen sich diese Aufgaben sauber in die bestehenden Monitoring- und Alarmierungssysteme integrieren, sodass bei Unregelmäßigkeiten schnell reagiert werden kann. Die Implementierung einer solchen Lösung ist komplex und erfordert eine sorgfältige Planung, aber das Ergebnis ist eine zukunftssichere Datenbasis, die den Anforderungen wachsender Anwendungen gerecht wird. Sie garantiert nicht nur schnelle Antwortzeiten selbst bei enormen Datenmengen, sondern auch eine nachhaltige Kostenkontrolle und verbesserte Betriebssicherheit.

Wer also vor der Herausforderung steht, große Tabellen in PostgreSQL mit Rails effizient zu verwalten, sollte die Partitionierung als erstklassige Option in Erwägung ziehen. Mit einem durchdachten Stufenplan, einer ausgewogenen Kombination aus PostgreSQL-Funktionalitäten und Rails-Werkzeugen sowie einer automatisierten Wartungsstrategie ist es möglich, auch volumengroße Audit- oder Log-Tabellen performant und wartbar zu gestalten. Besonders die deklarative Partitionierung eröffnet neue Spielräume für Transparenz, Skalierbarkeit und Performanceoptimierung, die moderne Anwendungen heute dringend benötigen.