Künstliche Intelligenz (KI) hat die Art und Weise, wie wir leben, arbeiten und kommunizieren, revolutioniert. Doch mit ihren unzähligen Vorteilen bringt sie eben auch Herausforderungen im Bereich der Sicherheit mit sich. Immer wieder hört man von Experten, Behörden oder Medien, dass wir mehr tun müssen, um KI sicherer zu machen. Doch wie realistisch ist diese Forderung? Und vor allem: Haben wir als Einzelne oder Gemeinschaft tatsächlich die Möglichkeit, die Sicherheitsstandards von KI nachhaltig zu verändern? Die Antwort darauf liegt in einem Verständnis dessen, was Daniel Miessler als das „effiziente Sicherheitsprinzip“ beschreibt und welches das Verhältnis von Risiko, Marktkräften und gesellschaftlichem Verhalten in den Vordergrund stellt. Die KI-Sicherheit wird nicht isoliert von einzelnen Anstrengungen verbessert oder verschlechtert.

Stattdessen ist sie das Ergebnis eines komplexen Gleichgewichts, das durch das kollektive Verhalten von Menschen und Organisationen bestimmt wird. Dieses Gleichgewicht reguliert sich oftmals selbst, abhängig davon, wie mich die Menschen auf KI-Technologien einlassen oder welche Risiken sie bereit sind in Kauf zu nehmen. Wenn die Nutzer große Sicherheitsvorfälle erleben, die spürbare Schäden verursachen, steigt das Bewusstsein und der Druck steigt, bessere Sicherheitsmaßnahmen umzusetzen. Sobald jedoch ein gewisser Grad an Vorfällen akzeptiert oder als unvermeidbar angesehen wird, stagniert die Bereitschaft und die Nachfrage nach weiteren Sicherheitsvorkehrungen. Das bedeutet, dass kein einzelner Akteur, auch keine global agierende Organisation oder Regierung, dauerhaft den Sicherheitsstandard von KI maßgeblich nach oben oder unten verschieben kann.

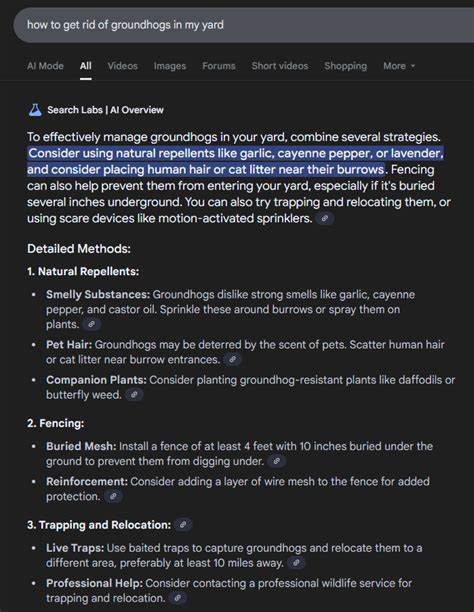

Die Marktkräfte und das Verhalten der Masse sind hierbei die wegweisenden Faktoren. Die sogenannten „Heroic Efforts“ von Sicherheitsforschern, Regulierern oder Unternehmen können kurzzeitig Aufmerksamkeit erzeugen und Verbesserungen anstoßen, doch sie sind letztlich nicht in der Lage, das Baseline-Sicherheitsniveau grundlegend zu verändern. Diese Dynamik kann am besten durch das Modell der „punktierten Gleichgewichte“ beschrieben werden. Das heißt, die KI-Sicherheit bleibt meist auf einem konstant niedrigen oder moderaten Niveau, bis ein großer Vorfall eintritt, der die Öffentlichkeit wachrüttelt und massive Reaktionen provoziert. Beispielhaft hierfür sind bedeutende Sicherheitslücken oder Angriffe, die Millionen von Menschen direkt betreffen.

Solche Ereignisse führen zu einem abrupten Anstieg der Sicherheitsmaßnahmen. Nach einer solchen „Punktuation“ glättet sich die Entwicklung jedoch meist wieder, bis ein neuer signifikanter Vorfall passiert. Auf der Grundlage dieser Erkenntnisse sollte sich die Diskussion um KI-Sicherheit verändern. Anstatt sich auf individuelle Heldentaten oder isolierte technische Innovationen zu fokussieren, wäre es sinnvoller, das System aus Nutzererwartungen, Marktanreizen und gesellschaftlichem Risikoempfinden zu betrachten. Nur so lassen sich tragfähige Lösungen entwickeln, die dem tatsächlichen Umgang mit KI entsprechen.

Ein weiterer wichtiger Faktor ist die Rolle von Regulierung und Regierung. Während diese strukturell eingreifen können, reagieren auch sie vor allem auf gesellschaftlichen Druck und öffentliche Meinung. Regulierungen entstehen meist erst dann, wenn ein gewisses Maß an öffentlicher Empörung oder Angst im Umgang mit KI erreicht wird. Deshalb bewegt sich auch die staatliche Strenge im Bereich der KI-Sicherheit häufig nur reaktiv und ist eng an reale Ereignisse oder mediale Berichterstattung gekoppelt. Auch die Frage nach der „perfekten Sicherheit“ ist hier hochgradig relativiert.

Perfekte Sicherheit wird selten erreicht und kann kostspielig oder gar kontraproduktiv sein, wenn sie den technologischen Fortschritt oder die Nutzbarkeit einschränkt. Stattdessen entsteht auf dem Markt für KI-Sicherheit ein „funktionales Gleichgewicht“, bei dem das Niveau der Sicherheitsmaßnahmen gerade so hoch ist, dass es den Aufwand gegenüber dem wahrgenommenen Risiko rechtfertigt. Dieses Gleichgewicht ist flexibel und passt sich im Laufe der Zeit an, abhängig davon, wie sich Technologie, Bedrohungen und gesellschaftliche Akzeptanz entwickeln. Für IT-Sicherheitsprofis und technologische Entwickler bedeutet das, dass permanente Warnungen und „Rooftop-Screaming“, also lautes Alarmieren, nicht unbedingt zu nachhaltigen Veränderungen führen. Es ist vielmehr wichtig, realistische Erwartungen zu setzen, fundierte Aufklärung zu betreiben und die Menschen kompetent durch die sich rasant weiterentwickelnde KI-Landschaft zu begleiten.

Hilfreich ist es, wenn Sicherheitskonzepte und -richtlinien pragmatisch, transparent und vernetzt entwickelt werden, sodass sie in der Praxis eine spürbare Wirkung entfalten. Zudem dürfen wir nicht vergessen, dass die Nutzung von KI trotz aller Risiken auch viele Probleme löst und die Lebensqualität verbessert. Das Vertrauen in die Technik entsteht durch eine ausgewogene Balance von Sicherheit und Nutzen. Übermäßige Angst oder hysterische Kritik können das Vertrauen untergraben und damit auch die Bereitschaft, KI-Technologien verantwortungsvoll einzusetzen und weiterzuentwickeln. Die aktuelle Situation ist also eine Zwickmühle, bei der wir uns nicht auf eine völlige Kontrolle der KI-Sicherheit durch Einzelmaßnahmen verlassen können.

Stattdessen müssen wir das System als Ganzes verstehen und akzeptieren, dass die Sicherheitsstandards weitgehend durch das Zusammenspiel vieler sozialer, wirtschaftlicher und technischer Kräfte bestimmt werden, die sich dynamisch anpassen. Das bedeutet jedoch nicht, dass wir tatenlos zusehen sollten. Vorsorge, Bildung und transparente Kommunikation gehören zu den wichtigsten Werkzeugen, mit denen wir das Vertrauen der Nutzer stärken und Gefahren minimieren können. Sichere KI-Designs, klare Richtlinien für verantwortungsbewussten Umgang und die Förderung eines kritischen Bewusstseins in der Gesellschaft bilden das Fundament. Zusammenfassend lässt sich sagen, dass die KI-Sicherheit eine emergente Eigenschaft ist, die aus dem Verhalten ganzer Gesellschaften entsteht.