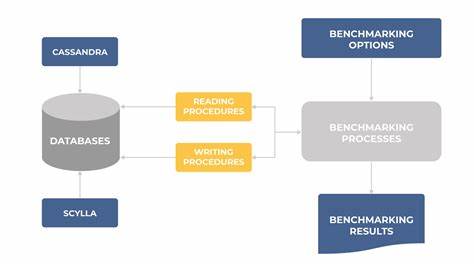

In der Welt der verteilten Datenbanken spielen Datenkonsistenz und Zuverlässigkeit eine zentrale Rolle. Beim Umgang mit Löschvorgängen in Systemen wie Apache Cassandra und ScyllaDB steht oft das Thema der sogenannten Datenwiederbelebung im Mittelpunkt – ein Phänomen, bei dem eigentlich gelöschte Daten unerwartet wieder sichtbar werden. Dieses Problem entsteht durch komplexe Wechselwirkungen zwischen Reparaturprozessen und der Garbage Collection, die für das permanente Entfernen gelöschter Daten verantwortlich ist. Aktuelle Studien und Berichte, darunter eine umfassende Analyse von Mike Sun aus dem Jahr 2025, zeigen, wie essenziell die richtige Planung und Durchführung von Reparaturen ist, um solche Risiken auszuschließen. Diese Erkenntnisse bilden die Grundlage für ein tiefergehendes Verständnis der Reparaturzeit-Anforderungen in Cassandra und Scylla und deren Einfluss auf die Datenintegrität.

Grundprinzipien von Löschvorgängen und Tombstones Löschungen in verteilten Datenbanken verlaufen nicht wie bei traditionellen Systemen durch direkte Entfernung. Stattdessen nutzen Cassandra und ScyllaDB ein Konzept namens Tombstones – spezielle Markierungen, die einen Datensatz als gelöscht kennzeichnen, ohne ihn sofort physisch zu entfernen. Diese Tombstones sichern, dass auch bei einer asynchronen Replikation der Löschstatus auf alle Knoten übertragen werden kann. Die physische Entfernung der Daten und ihrer Tombstones erfolgt erst im Rahmen von Kompaktierungsprozessen, jedoch erst nach dem Ablauf einer festgelegten Frist, die durch den Parameter gc_grace_seconds bestimmt wird. Der Hauptzweck von gc_grace_seconds ist es, sicherzustellen, dass alle Datenknoten die Löschinformationen erhalten, bevor die Daten endgültig gelöscht werden.

In der Standardkonfiguration beträgt diese Zeitspanne in der Regel zehn Tage, kann aber je nach Anforderungen variiert werden. Während dieses Zeitraums schützen die Tombstones vor einer Wiederbelebung der Daten, da jeder Knoten diese Informationen für Replikations- und Reparaturvorgänge bereithält. Die Gefahren der Datenwiederbelebung und die Rolle von Reparaturen Das zentrale Problem bei der Datenwiederbelebung entsteht, wenn aufgrund von Verzögerungen oder Fehlern während der Replikation nicht alle Knoten den Tombstone einer Löschung erhalten. Sobald jedoch die Garbage Collection bei einem Teil der Knoten den Tombstone nach Ablauf von gc_grace_seconds entfernt, besteht das Risiko, dass Knoten, die den Löschmarker nie erhalten haben, die Daten wieder als gültig ausgeben. Dies kann zu erheblichen Inkonsistenzen im Cluster führen und das Vertrauen in die Datenintegrität untergraben.

Reparaturprozesse, oft mit dem Kommando nodetool repair oder durch Tools wie Cassandra Reaper oder Scylla Manager orchestriert, übernehmen die kritische Aufgabe, Daten zwischen Knoten zu synchronisieren und fehlende Tombstones zu propagieren. Nur durch regelmäßige und vollständige Reparaturen lässt sich gewährleisten, dass alle Knoten den gleichen Löschstatus kennen und somit keine Daten versehentlich wieder erscheinen. Häufig sind Reparaturoperationen ressourcenintensiv und können, besonders bei großen Datenmengen, mehrere Tage in Anspruch nehmen. Die Logik der Reparaturen ist dabei eng mit der zeitlichen Definition von gc_grace_seconds gekoppelt, denn nur wenn alle nötigen Reparaturen innerhalb dieses Zeitfensters durchgeführt werden, können Wiederbelebungen sicher ausgeschlossen werden. Unzureichende Dokumentationsrichtlinien und praktische Herausforderungen Obwohl die offiziellen Dokumentationen von Cassandra und Scylla grundlegende Empfehlungen zu Reparaturintervallen geben, sind diese in der Praxis oft unzureichend und schwer umzusetzen.

Die allgemeine Vorgabe lautet, Reparaturen mindestens einmal innerhalb des gc_grace_seconds-Intervalls durchzuführen. In der Praxis bedeutet das bei einer Standard- Einstellung von zehn Tagen ein Reparaturintervall von sieben Tagen, um Puffer für unerwartete Verzögerungen zu schaffen. Ein Problem dabei ist, dass sich Reparaturen nicht nur über mehrere Tage ziehen können, sondern auch tokenbasiert in Teilschritten ablaufen, deren Reihenfolge und Dauer nicht garantiert sind. So kann es vorkommen, dass ein Teil des Datenbestands nach dem Start einer Reparatur behandelt wird, während neuere Tombstones für andere Bereiche erst nach Abschluss der Reparatur auftauchen. Wenn die nachfolgende Reparatur sich verzögert oder längere Zeit benötigt, können einzelne Tombstones vor der Synchronisation ablaufen – was die Wiederbelebung der Daten ermöglicht.

Diese Problematik wird durch clusterweite Reparaturwerkzeuge wie Cassandra Reaper oder Scylla Manager verstärkt. Diese Tools koordinieren zwar Reparaturen über große Cluster, strecken einzelne Reparaturvorgänge jedoch oft über viele Tage, um Ressourcenbelastungen zu minimieren. Dadurch steigt die Gefahr, dass gc_grace_seconds-Richtlinien in der Praxis verletzt werden, obwohl die Intervalle den offiziellen Empfehlungen zu entsprechen scheinen. Strengere Anforderungen zur Vermeidung von Datenwiederbelebung Aus der Analyse der genannten Herausforderungen ergibt sich eine strengere, theoretisch abgesicherte Anforderung: Nicht nur der Abstand zwischen Reparaturen, sondern der gesamte Zeitraum vom Beginn einer Reparatur bis zum Abschluss der nächsten muss den gc_grace_seconds-Parameter einhalten. Mit anderen Worten, wenn der Beginn einer Reparatur bei Si und das Ende der darauf folgenden bei Ei+1 liegt, darf der Zeitraum Ei+1 - Si niemals den Wert von gc_grace_seconds überschreiten.

Diese Zeitspanne berücksichtigt vollständig die Dauer der Reparaturprozesse und stellt sicher, dass kein Tombstone jemals zwischen zwei Reparaturen abläuft und somit keine Todesdaten wieder auftauchen. Praktisch bedeutet dies, dass Reparaturen bei einem gc_grace_seconds von zehn Tagen mindestens alle fünf Tage starten und innerhalb von fünf Tagen beendet sein müssen, um genügend Puffer zu bieten. Angesichts der Komplexität und der Ressourcennutzung führt dies zu erheblichen Herausforderungen bei der Planung und Durchführung von Reparaturen – vor allem in sehr großen und stark genutzten Clustern. Performance-Auswirkungen und technische Lösungsansätze Reparaturen erzeugen eine nicht zu vernachlässigende Last auf die Systemressourcen, insbesondere auf Netzwerk und Storage-I/O. Um Reparaturen beschleunigt durchzuführen, könnten Operatoren die Parallelität erhöhen, riskieren jedoch damit eine Verschlechterung der Query-Performance.

Dies erfordert ein sorgfältiges Abwägen zwischen Datenintegrität, Systemverfügbarkeit und Performance. Neuere Entwicklungen in Cassandra und Scylla gehen auf diese Probleme ein. Cassandra plant, mit Version 5.1 eine Unified Repair Solution einzuführen, die den ältesten unreparierten Knoten im Cluster priorisiert und so die Effizienz der Reparaturen steigert. Außerdem ermöglicht ein LongestUnrepairedSec-Metriksystem die präzise Überwachung potenziell gefährdeter Tombstones.

Scylla wiederum bietet mit dem Feature Repair Based Tombstone Garbage Collection die Möglichkeit, Tombstones bereits vor Ablauf von gc_grace_seconds zu komprimieren, wenn diese als repariert gelten. Dies erlaubt es, gc_grace_seconds verlängert einzustellen ohne die typischen Nachteile wie erhöhte Latenzen und Diskverbrauch. Das Feature befindet sich noch in der Entwicklung, zeigt jedoch großes Potential zur Lösung des Reparatur-Dilemmas. Alternativ können Löschungen mit einem Konsistenzlevel von ALL ausgeführt werden, wodurch vermieden wird, dass Löschmarker nicht an alle Knoten übermittelt werden. Dieser Ansatz sichert Löschungen so ab, dass sie nur erfolgreich sind, wenn alle Replikate den Tombstone erhalten haben.

Allerdings sinkt dadurch die Verfügbarkeit von Löschoperationen, da die Ausführung scheitert, wenn zumindest ein Knoten offline ist. Als Kompromiss sind Löschungen mit Konsistenzlevel QUORUM verbreitet, die bei einer Unverfügbarkeit auf spätere Reparaturen zurückgreifen. Fazit Die Gewährleistung der Datenintegrität in verteilten Datenbanken wie Cassandra und Scylla erfordert ein tiefgehendes Verständnis der komplexen Prozesse rund um Löschungen, Tombstones und Reparaturen. Während einfache Empfehlungen aus der offiziellen Dokumentation einen Ausgangspunkt bieten, zeigen detaillierte Analysen, dass strengere Anforderungen an Timing und Dauer von Reparaturzyklen notwendig sind, um ein Wiederaufleben gelöschter Daten sicher auszuschließen. Betreiber müssen die Reparaturstrategien so gestalten, dass aufeinanderfolgende Reparaturen nicht nur in ausreichenden Intervallen starten, sondern auch schnell genug beendet werden, um innerhalb des Garbage Collection Grace Periods zu bleiben.

Dies erfordert eine Balance zwischen operativer Leistung, Clusterlast und Verfügbarkeit. Mit den jüngsten Entwicklungen in beiden Datenbanksystemen und der Möglichkeit, Löschungen mit unterschiedlichen Konsistenzstufen auszuführen, stehen praktische Lösungen bereit, um diese Herausforderungen anzugehen. Trotzdem bleibt die kontinuierliche Überwachung und Optimierung der Reparaturprozesse eine Schlüsselaufgabe im Betrieb von Cassandra- und Scylla-Clustern, um langfristige Konsistenz und Zuverlässigkeit der Daten sicherzustellen.