Die Entwicklung und Einführung von Künstlicher Intelligenz (KI) hat in den letzten Jahren einen bemerkenswerten Fortschritt erlebt. Besonders im Bereich der Cloud-Dienste haben Unternehmen zunehmend die Möglichkeiten erkannt, komplexe KI-Modelle zu nutzen, um Wettbewerbsvorteile zu erzielen, Prozesse zu automatisieren und innovative Services zu entwickeln. Dennoch gibt es einen bedeutenden Hemmschuh, der die breite und nachhaltige Akzeptanz von KI in Unternehmen derzeit einschränkt: die unvorhersehbaren und oft hohen Kosten für das sogenannte Inferenzieren, also die Nutzung von trainierten KI-Modellen zur Verarbeitung neuer Daten in Echtzeit. Diese Kostenproblematik führt zu einer spürbaren Zurückhaltung bei der Skalierung von KI-Projekten und hat weitreichende Auswirkungen auf die Strategie der Cloud-Nutzung. Im Kern geht es bei den Inferencing-Kosten darum, dass sie sich kontinuierlich und wiederkehrend ergeben, während das Training eines KI-Modells in der Regel eine einmalige Investition darstellt.

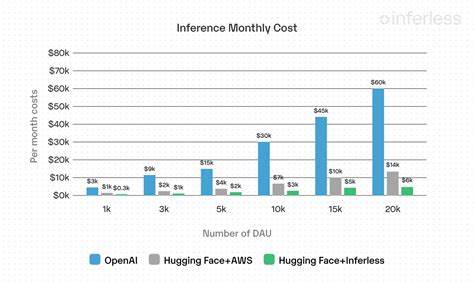

Das Training kann immense Rechenressourcen und Speicherkapazitäten erfordern, doch nach Abschluss steht das Modell bereit, um eingesetzt zu werden. Das tatsächliche Ausführen der KI-Modelle, also das Inferenzieren, geschieht jedoch fortlaufend und muss vielfach erfolgen – je nach Anwendung kann das in der Größenordnung von Millionen API-Aufrufen oder Token-Generierungen innerhalb kurzer Zeit passieren. Dabei verlangen die führenden Cloud-Anbieter meist nutzungsabhängige Preise, die pro Aufruf oder Datenmenge abgerechnet werden. Diese Dynamik macht eine exakte Kostenprognose schwierig und birgt das Risiko, dass Unternehmen Überraschungen bei ihrer Cloudrechnung erleben. Aktuelle Marktforschungen von Canalys unterstreichen diese Entwicklung eindrücklich.

Trotz eines globalen Wachstums im Cloud-Segment von 21 Prozent im ersten Quartal 2025 auf mehr als 90 Milliarden US-Dollar, sind Unternehmen bei der Nutzung von KI-Inferenzdiensten vorsichtiger geworden. Besonders in der Phase des Rollouts von KI-Anwendungen steigt das Bewusstsein für die laufenden Kosten und die Effizienz der zugrundeliegenden Infrastruktur. Unternehmen vergleichen dabei nicht nur Cloud-Plattformen, sondern auch Hardwarearchitekturen wie klassische GPUs und spezialisierte KI-Beschleuniger, um das Optimum zwischen Leistung und Kosten zu finden. Die Folge der kostenseitigen Unsicherheiten ist, dass viele Firmen ihre KI-Nutzung einschränken, die Komplexität der eingesetzten Modelle reduzieren oder sich auf besonders wertschöpfende Anwendungsfälle konzentrieren. Dieses Phänomen führt dazu, dass das volle Potenzial von KI-Technologien nicht ausgeschöpft wird und Innovationen gebremst werden.

Insbesondere für Unternehmen, die auf Public-Cloud-Anbieter wie AWS, Microsoft Azure oder Google Cloud setzen, entpuppt sich die Kostenfrage als wesentlicher Engpass. Ein prominentes Beispiel ist das US-Unternehmen 37signals, bekannt für die Projektmanagement-Plattform Basecamp. Nachdem die Firma mit überraschend hohen Cloud-Rechnungen konfrontiert wurde, die sich auf über drei Millionen US-Dollar jährlich summierten, entschied sie sich für den Wechsel zurück zu On-Premises-Lösungen. Dieser Schritt spiegelt eine wachsende Skepsis gegenüber reinen Public-Cloud-Modellen wider, vor allem wenn es um den großflächigen Einsatz von KI geht. Auch Analysten wie Alastair Edwards von Canalys warnen davor, dass die Public Cloud nicht unbedingt die kosteneffizienteste Umgebung für das Skalieren von KI-Inferenzanwendungen sei.

Die hohe Flexibilität und die breite Verfügbarkeit großer Cloud-Anbieter gehen einher mit Kostenstrukturen, die bei ambitionierten Projekten schnell untragbar werden können. In der Konsequenz erwägen immer mehr Unternehmen Alternativen, etwa spezialisierte Hosting-Anbieter und Colocation-Lösungen, die auf KI-optimierte Hardware und Infrastruktur setzen. Ein weiteres Problemfeld ist die Preistransparenz der Anbieter. Viele KI-Dienste arbeiten mit komplexen, oft undurchsichtigen Tarifen, die auf Nutzungsmenge, Anzahl der API-Aufrufe oder textgenerierender Token basieren. Rascher Anstieg in der Nutzungsintensität führt dabei häufig zu Kostenüberschreitungen, die schwer vorherzusagen sind.

Gartner hat im letzten Jahr davor gewarnt, dass Kostenprognosen für KI-Nutzung um das Fünffache oder gar das Zehnfache abweichen können –eine erhebliche Unsicherheit für Unternehmen, die in den Ausbau ihrer KI-Kompetenzen investieren wollen. Dabei ist die Nachfrage nach KI-gestützten Lösungen ungebrochen. Sowohl Innovationen im Bereich generative KI als auch datengetriebene Entscheidungsunterstützung treiben die Nachfrage nach KI-Berechnungen voran. Unternehmen müssen jedoch sicherstellen, dass sie ihre Ausgaben effizient steuern, um wirtschaftlich tragfähige KI-Projekte umzusetzen. Die Herausforderungen sind technischer, organisatorischer und strategischer Natur.

Auf der technischen Ebene arbeiten Cloudanbieter daran, ihre Infrastruktur an die speziellen Anforderungen von KI anzupassen. Das beinhaltet neue Data-Center-Designs, die höhere Rechenleistung und eine bessere Energieeffizienz bieten, sowie leistungsfähige, speziell designte KI-Prozessoren. Diese Maßnahmen zielen darauf ab, die Kosten pro Inferenz deutlich zu senken und damit die wirtschaftliche Skalierung von KI-Anwendungen zu erleichtern. Organisatorisch müssen Unternehmen neue Ansätze beim Kostenmanagement einführen. Dies betrifft die Auswahl der Modelle, die Optimierung von Arbeitslasten, das Monitoring der Nutzung und die Kostenkontrolle.

Viele Firmen setzen zunehmend auf hybriden Betrieb, der Cloud- und On-Premises-Ressourcen kombiniert, um eine bessere Balance zwischen Flexibilität, Leistung und Kosten zu erzielen. Strategisch gewinnen außerdem Partnerschaften mit spezialisierten Anbietern und die Nutzung von Colocation-Diensten an Bedeutung. Die Auswahl der richtigen Infrastruktur und Anbieter wird zum kritischen Erfolgsfaktor bei der Umsetzung von KI-Vorhaben. Die Entwicklung hin zu mehr Transparenz und Berechenbarkeit der Kosten gehört zu den zentralen Anforderungen, damit Unternehmen ihr KI-Potenzial nachhaltig realisieren können. Abschließend wird deutlich, dass die gegenwärtigen Herausforderungen bei den Inferenzkosten zwar eine ernstzunehmende Barriere darstellen, aber auch Chancen bieten.

Fortschritte in der Infrastrukturtechnologie, neue Geschäftsmodelle im Cloud-Spektrum und eine wachsende Kompetenz der Unternehmen im Umgang mit KI-Kosten werden mittelfristig dafür sorgen, dass die breite Einführung von KI-Modellen in der Cloud wieder an Fahrt gewinnt. In der Zwischenzeit ist ein bewusster und wohlüberlegter Umgang mit den Kosten und ein gezieltes Kostenmanagement der Schlüssel zum Erfolg bei der Nutzung von KI-Diensten im Unternehmensumfeld.