Im digitalen Zeitalter hat sich die Art und Weise, wie wir Informationen verarbeiten und mit der Welt interagieren, grundlegend verändert. Künstliche Intelligenz und vernetzte Systeme bestimmen immer stärker unseren Alltag, von Smartphones, Smart Homes bis hin zu komplexen Datenzentren, die riesige Mengen an Informationen in Echtzeit analysieren. Doch was passiert eigentlich, wenn diese künstliche Intelligenz unerwartet ausfällt? Welche Konsequenzen ergeben sich daraus für Individuen und Gesellschaften, und wie gut sind wir tatsächlich auf solche Szenarien vorbereitet? Ein anschauliches Beispiel dafür lieferte ein ungewöhnlich heftiger Eissturm in Nord-Michigan. Solche Naturereignisse treffen Regionen häufig mit langen Stromausfällen und unterbrechen dadurch nicht nur die Grundversorgung, sondern auch die digitale Infrastruktur. Wenn die Stromversorgung zusammenbricht und damit auch der Zugang zu Datenzentren oder Cloud-Diensten, bedeutet das einen Stillstand der künstlichen Intelligenz, auf die viele digitale Dienste inzwischen angewiesen sind.

Dieser Stromausfall hat deutlich gemacht, wie fragil das Ökosystem der vernetzten Intelligenz tatsächlich ist. Obwohl die meisten Menschen in betroffenen Regionen gut vorbereitet sind – mit Generatoren für den Notfall, alternativen Kommunikationsmitteln und traditionellen Informationsquellen wie Büchern – zeigt sich, dass die zentrale Speicherung und Verarbeitung von Daten eine erhebliche Abhängigkeit schafft. Sollte also die „Intelligenz“ einmal ausfallen, stehen viele vor Herausforderungen, die über den einfachen Verlust von Internetzugang hinausgehen. Die digitale Revolution hat das Modell der zentralisierten Intelligenz vorangetrieben: Daten werden in großen Rechenzentren verarbeitet, künstliche Intelligenz errechnet in der Cloud die beste Lösung, und Nutzer greifen per Internet auf diese Dienste zu. Dieses Modell bringt enorme Vorteile in Sachen Skalierbarkeit und Leistung, doch es hat auch Schattenseiten.

Wenn die Verbindung zwischen Endgerät und Datenzentrum unterbrochen wird – sei es durch einen Sturm, technische Fehler oder Cyberangriffe – sind viele Technologien unbrauchbar oder verlieren stark an Funktionalität. Ein zentraler Gedanke ist die Metapher von Intelligenz, die wie Elektrizität fließt – allgegenwärtig, immer verfügbar und zentral erzeugt. Doch anders als Elektrizität, die man zumindest kurzfristig selbst erzeugen kann, ist „künstliche Intelligenz“ bislang überwiegend auf die zentrale Infrastruktur angewiesen. Diese Abhängigkeit wirft existenzielle Fragen auf, wenn es darum geht, Ausfallsicherheit und Resilienz in kritischen Situationen zu gewährleisten. Die Vorstellung, dass in einem zukünftigen Szenario lokale Backup-KIs einspringen können, ist zwar eine spannende Science-Fiction-Idee, doch in der Praxis scheint sie derzeit schwer umsetzbar.

Die meisten KI-Modelle erfordern enorme Rechenleistung, die bisher nur in spezialisierten Rechenzentren möglich ist. Auf Endgeräten laufen zwar immer leistungsfähigere Chips, doch eine echte Reduktion der Abhängigkeit von der Cloud ist bisher selten. Diese Entwicklung ist eng verbunden mit dem Trend zur Zentralisierung von Rechenleistung. Technologische Fortschritte haben vor allem dazu geführt, dass Daten immer tiefer in die Cloud abwandern, während Geräte am Rande des Netzwerks selbst oft nur noch als Schnittstelle fungieren. Smartphones, Laptops oder sogar vernetzte Haushaltsgeräte benötigen durchgängige Internetverbindungen, um AI-Funktionen nutzen zu können.

Fällt diese Verbindung aus, sind viele zuvor als intelligent beworbene Geräte plötzlich nur noch sehr eingeschränkt funktional. Die Frage nach der lokalen KI bringt weitere Herausforderungen mit sich. Nicht nur die Hardware, sondern auch Datenschutz und Sicherheit spielen eine Rolle. Lokale KI-Modelle könnten zwar eine gewisse Unabhängigkeit schaffen und Daten näher am Nutzer verarbeiten, doch das führt auch zu neuen Komplexitäten. Die Verteilung von KI-Fähigkeiten auf zahlreiche Geräte verteilt Risiken und Angriffsflächen.

Darüber hinaus müsste sichergestellt werden, dass Upgrades und Sicherheits-Patches regelmäßig und effizient durchgeführt werden, um neue Bedrohungen abzuwehren. Parallel zum technologischen Aspekt gibt es auch menschliche und soziale Dimensionen, die berücksichtigt werden müssen. Wie reagieren Menschen, wenn sie plötzlich von der gewohnten „Intelligenz“ abgeschnitten sind? Die Fähigkeit, auch ohne digitale Hilfsmittel klarzukommen, wird wieder relevant. Erfahrungen wie der beschriebene Eissturm zeigen, dass Vorbereitung, Resilienz und traditionelle Kompetenzen eine unverzichtbare Rolle spielen, um Krisenzeiten durchzustehen. Diese Überlegungen können zu einer wichtigen Erkenntnis führen: Digitale Intelligenz ist ein mächtiges Werkzeug, aber keine Selbstverständlichkeit.

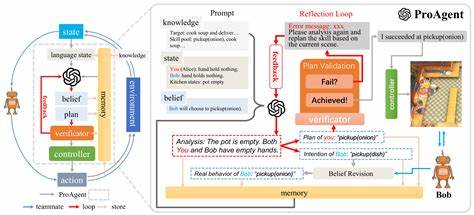

Eine Infrastruktur, die allein auf Durchgängigkeit und Zentralisierung setzt, ist anfällig. Die Integration lokaler Intelligenz, hybrider Modelle und robust gestalteter physischer Netzwerke könnte zukünftige Systeme widerstandsfähiger machen. Innovative Ansätze in der Forschung befassen sich daher zunehmend mit sogenannten Edge-Computing-Lösungen. Dabei werden Daten und KI-Berechnungen lokal auf Geräten oder in deren Nähe durchgeführt, um Latenzen zu reduzieren und eine gewisse Unabhängigkeit von zentralen Datenzentren sicherzustellen. Das zeigt, dass eine Balance zwischen zentraler und verteilter Intelligenz möglich ist und womöglich letztlich auch notwendig wird.

Aus ökologischer Sicht stellt sich zudem die Frage nach der Nachhaltigkeit zentraler KI-Infrastrukturen. Riesige Rechenzentren verbrauchen enorme Mengen an Energie. Lokale KI-Modelle könnten dagegen energieeffizienter sein, wenn sie gezielt auf kleinere, spezialisierte Aufgaben ausgelegt werden. Kombiniert mit erneuerbaren Energien und intelligentem Energiemanagement entsteht so ein vielversprechender Rahmen für eine zukunftsfähige digitale Infrastruktur. In Bezug auf die gesellschaftliche Dimension sind auch politische und rechtliche Rahmenbedingungen ein Thema.

Die zunehmende Abhängigkeit von globalen Technologiekonzernen, die zentrale Infrastrukturen betreiben, wirft Fragen nach demokratischer Kontrolle, Datenhoheit und Dezentralisierung auf. Ein Ausfall der „Intelligenz“ könnte durchaus auch geopolitische Konsequenzen nach sich ziehen, wenn kritische Ressourcen und Dienstleistungen plötzlich nicht mehr verfügbar sind. Praktisch gesehen sollte sich die Gesellschaft daher fragen, wie sie mit dem Risiko eines Ausfalls umgehen kann. Notfallpläne, redundante Systeme und die Verknüpfung von modernen und traditionellen Informationsquellen sind wichtige Bausteine. Gleichermaßen müssen Entwickler, Unternehmen und Politik gemeinsam daran arbeiten, resilientere, transparente und verantwortungsvoll gestaltete Infrastrukturen zu schaffen.

Die Zukunft der künstlichen Intelligenz wird nicht nur von technologischen Innovationen geprägt sein, sondern auch von unserem Umgang mit deren Grenzen und Risiken. Der Moment, wenn die Intelligenz plötzlich ausfällt, könnte als Weckruf dienen, um vernetzte Systeme menschlicher, widerstandsfähiger und nachhaltiger zu gestalten. Dabei ist nicht nur das Wie entscheidend, sondern auch das Bewusstsein über die Verantwortung, die mit dieser neuen Form der Intelligenz einhergeht. Zusammenfassend lässt sich sagen, dass der Ausfall digitaler Intelligenz in vernetzten Systemen ein reales und bedeutendes Problem darstellt. Er macht deutlich, wie sehr unsere Gesellschaft aktuell auf zentrale Systeme, durchgängige Konnektivität und leistungsstarke Rechenzentren angewiesen ist.

Gleichzeitig bietet er die Gelegenheit, alternative Lösungsansätze zu entwickeln, die mehr Dezentralität, lokale Intelligenz und Resilienz fördern. Die Herausforderung besteht darin, technologische Fortschritte mit nachhaltigen und gesellschaftlich verträglichen Strategien zu verbinden, um den nächsten Sturm – ob meteorologisch oder digital – besser zu überstehen.