In einer Welt, die sich zunehmend durch digitale Medien und soziale Netzwerke definiert, haben sich unsere moralischen Urteile und Reaktionen auf Fehltritte prominenter Persönlichkeiten stark verändert. Die Vorstellung von „gleichem Recht für alle“ wird zwar oft verbal bejaht, doch die Realität sieht anders aus. Künstliche Intelligenz (KI) eröffnet nun neue Perspektiven, die zeigen, wie tief Doppelmoral eigentlich verwurzelt ist – sowohl bei uns Menschen als auch in den Algorithmen, die wir erschaffen haben. Rhys Fisher, COO und Mitgründer von Rally, führt in seinen jüngsten Experimenten genau diese Thematik vor Augen. Mit Hilfe von KI-generierten virtuellen Personas hat er Milliarden von Social-Media-Reaktionen simuliert und aufgedeckt, wie sich Favoriten oder sogenannte „Stans“ auf die moralische Bewertung auswirken.

Dabei wurde deutlich: Wenn man einer KI „Team Will Smith“ als Erinnerung einprägt, vergibt sie großzügiger. Wechseln die Erinnerungen zu „Team Kanye West“, verschärfen sich die Urteile deutlich. Die Ergebnisse sind ein faszinierender Spiegel unserer gesellschaftlichen Mechanismen, die schon vor über hundert Jahren vom Psychologen Edward Thorndike als Halo-Effekt beschrieben wurden. Dieser besagt, dass eine positive Eigenschaft einer Person dazu führt, alle weitere Eigenschaften ebenfalls positiv zu bewerten – und umgekehrt. Neu ist jedoch, dass diese Verzerrung nun auch in der künstlichen Crowd-Simulation sichtbar wird und somit keine rein menschliche Schwäche mehr ist, sondern auch algorithmisch reproduziert wird.

Fisher nutzte für seine Studie zehn verschiedene virtuelle Millennials-Personas, die jeweils mit einem bestimmten „Medien-Diät“-Erinnerungsspeicher versehen wurden. Diese Verwendung von Memory-Feeds ahmt reale Social-Media-Konsummuster nach und erlaubt der KI, auf Basis unterschiedlichster Informationsblasen zu agieren. So wurde gezeigt, dass die moralische Reaktion bereits mit der Manipulation der „Vorlieben“ dramatisch schwanken kann. Die Erkenntnisse sind dabei besonders für PR-Teams und Markenstrategie relevant. Üblicherweise wird eine Krise aus der Sicht von Marketer und Krisenmanager statisch betrachtet: „Hat Influencer XY Regel X gebrochen? Dann folgt Konsequenz Y.

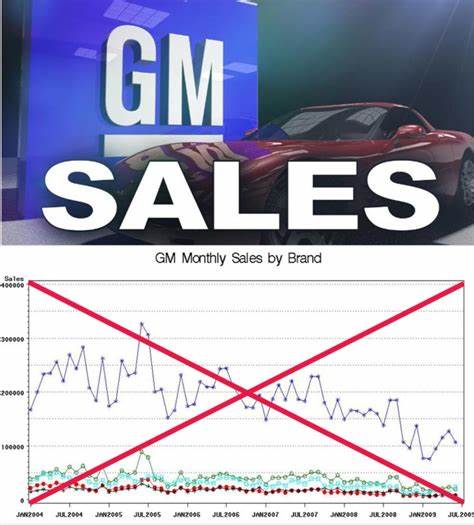

“ Doch in Wirklichkeit sind die öffentlichen Reaktionen viel fluider, stark abhängig von Zeitpunkten, Gruppenzugehörigkeiten und algorithmischer Breitenwirkung. Wer wie Logan Paul trotz eines Skandals noch fast 80 Prozent Zustimmung behält, verdeutlicht diese komplizierte Gemengelage. Die traditionellen Tools der Marktforschung stoßen hier schnell an ihre Grenzen. Umfragen tendieren zu sozial erwünschten Antworten, Social Listening-Tools verfangen sich häufig in Empörungsduellen und Krisenberater kommen oft erst ins Spiel, wenn der Shitstorm bereits rollt. KIs hingegen können Szenarien vorab testen – und zwar nicht nur mit einer neutralen Crowd, sondern mit Gruppen, die entweder gegenüber der Marke oder Persönlichkeit voreingenommen sind.

Dies eröffnet ganz neue Perspektiven, bevor ein Statement in die Öffentlichkeit geht. Die „synthetische Moral“ zeigt, wie flexibel und doch voreingenommen moralische Urteile ausfallen können. Je nachdem, welche Erinnerungsschichten die KI im Gedächtnis hat, verändert sich ihre Haltung von Vergebung bis hin zur Forderung nach „Canceling“. Etwas, das bisher vor allem frisch gebackenen Krisenmanagern und Marktforschern verborgen blieb, wird so sichtbar und planbar. Diese Entwicklung wirkt sich nicht nur auf die Krisenkommunikation aus, sondern auch auf den gesamten Austausch von Werten in der Öffentlichkeit.

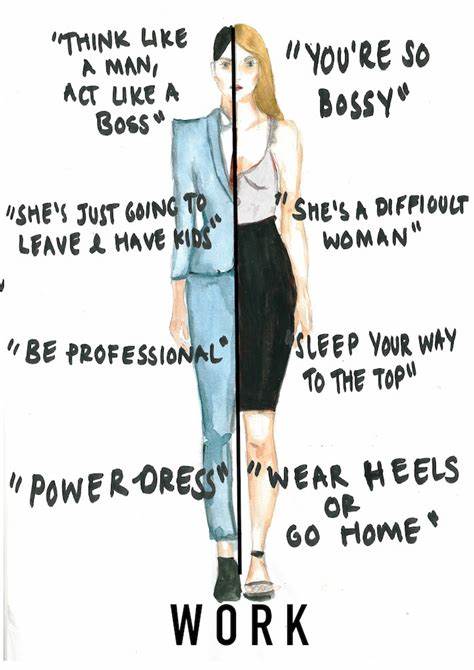

Vorbilder und Idole werden nicht länger durch objektive Fakten bewertet, sondern durch Gruppenzugehörigkeiten, stimmungsbasierte Narrative und algorithmische Verstärkungen. Übertragen auf die reale Interaktion in sozialen Netzwerken bedeutet das auch, dass unser kollektives Verständnis von Gerechtigkeit und Moral zunehmend fragmentiert und relativisiert wird. KI-basierte Tests können somit als Frühwarnsystem fungieren, um Stimmungswechsel frühzeitig zu erkennen und maßgeschneiderte Strategien zu entwickeln. Wer seine Krisenbotschaften sowohl an den „Fans“ als auch an den „Gegnern“ verprobt, gewinnt wertvolle Erkenntnisse zur realen Reputationsgefährdung. Das kann Millionen an Kosten sparen und das Aufkommen von Shitstorms verhindern oder zumindest abmildern.

Rhys Fisher zeigt damit, dass wir uns bei der Konstruktion moralischer Urteile und öffentlicher Meinungsbildung nicht von vermeintlich neutralen Fakten leiten lassen sollten. Unsere Vorlieben, Zugehörigkeiten und kollektiven Erinnerungen verzerren die Bewertung gerade dann am stärksten, wenn es um wichtige gesellschaftliche Fragen geht. Das gilt für uns Menschen ebenso wie für die Systeme, die wir zur Analyse einsetzen. Für Unternehmen bedeutet das konkret: Vor einer Veröffentlichung von Statements, Krisenreaktionen oder öffentlicher Positionierung sollten diese zwingend sowohl durch loyal gesinnte als auch kritische virtuelle Testgruppen geprüfte werden. Die Differenz dieser Ergebnisse ist der echte Messwert für das Risikopotenzial.

Generell ist dieses Vorgehen ein eindrucksvolles Beispiel dafür, wie KI heute nicht nur als Datenanalyse-Instrument, sondern als Spiegel unserer eigenen menschlichen Fehlbarkeit dient. Indem sie die sogenannten „silizium-basierten“ Möglichkeiten für Simulationen bietet, erlaubt sie Einblicke in Mechanismen, die lange im Dunkeln blieben. Abschließend zeigt sich, dass unser menschliches Bedürfnis nach gerechtem Urteil von tief verankerten Bias und der sozialen Zugehörigkeit bestimmt wird – und dass dieser Mechanismus so alt ist wie die Psychologie selbst. Mit KI lässt sich diese Dynamik nun nachbilden und verstehen, was neue Wege für ethische Debatten, Kommunikation und Krisenmanagement eröffnet. Die zugrundeliegende Botschaft lautet: Künstliche Intelligenz entlarvt nicht nur technische Schwächen oder Marktchancen, sondern auch unsere eigenen Doppelstandards.

Wer diese erkennt, kann nachhaltiger, bewusster und verantwortungsvoller in der Öffentlichkeit agieren – und sich so dem komplexen moralischen „Vibe-Check“ unserer Zeit stellen.