In der modernen Softwareentwicklung hat sich die Nutzung von Künstlicher Intelligenz, insbesondere von großen Sprachmodellen (LLMs), immer mehr etabliert. Sie ermöglichen es Entwicklern, Codevorschläge schnell zu erhalten, repetitive Aufgaben zu automatisieren und komplexe Probleme zu unterstützen. Allerdings birgt die starke Verlockung, erste KI-generierte Lösungen ungeprüft zu übernehmen, eine erhebliche Gefahr: die vorzeitige Schlussfolgerung, auch als „premature closure“ bekannt. Dieses Phänomen beschreibt den kognitiven Fehler, bei dem Entwickler zu schnell auf eine vermeintlich passende Lösung verfallen, ohne alternative Ansätze ausreichend zu prüfen. Die Folge sind nicht selten versteckte Fehler, technische Schulden und eine Verarmung der eigenen Problemlösungskompetenzen.

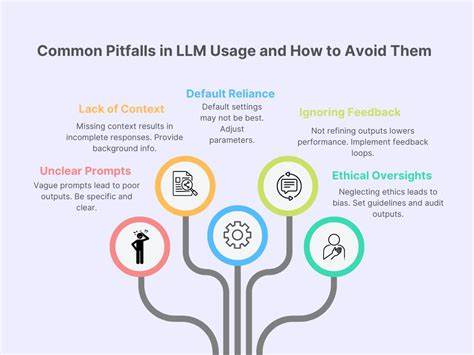

Die Problematik ähnelt einem bekannten Fall aus der Medizin, in dem erfahrene Ärzte bei einem Notfallpatienten eine lebensbedrohliche Diagnose aufgrund des scheinbar eindeutigen Symptombildes fast übersehen hätten. Diese Analogie verdeutlicht eindrucksvoll, wie gefährlich es sein kann, sich auf die naheliegendste Erklärung zu beschränken und andere Möglichkeiten auszublenden. Im Kontext der Softwareentwicklung zeigt sich eine ähnliche Dynamik: KI-gestützte Codetools bieten oft sofort Lösungen an, die optisch makellos und syntaktisch korrekt erscheinen. Sauber formatierte Vorschläge mit passenden Benennungen erzeugen beim Entwickler den Eindruck der Korrektheit und können kritisches Hinterfragen unterdrücken. Doch gerade bei komplexeren Herausforderungen, etwa Performanceoptimierungen oder Architekturentscheidungen, sind diese schnellen Antworten häufig nur Oberflächenlösungen.

Werden sie einfach übernommen, besteht die Gefahr, dass die eigentlichen Ursachen überdeckt bleiben und nachhaltige Verbesserungen ausbleiben. Ein typisches Beispiel ist die immer wieder empfohlene Indizierung von Datenbankspalten zur Performanceverbesserung. Auf den ersten Blick erscheint dies eine sinnvolle Maßnahme, die den Zugriff beschleunigt. Doch wenn die zugrundeliegende Ursache ineffiziente Abfragemuster oder mangelhafte Datenmodellierung sind, behebt der Index nur Symptome, nicht das Problem selbst. Anders gesagt: Der Code mag zwar schneller laufen, aber nicht besser.

Bei einer unkritischen Nutzung von KI-generiertem Code laufen Entwickler Gefahr, potenzielle Problemursachen nicht gründlich genug zu analysieren. Dieses Verhalten wird durch den zunehmenden Druck auf Produktivität und schnelle Ergebnisse verschärft. Unternehmen und Teams messen Fortschritt oft in schnell realisierten Features oder Bugfixes, wodurch die Versuchung groß ist, auf die erste plausible Lösung zurückzugreifen, die der Assistent liefert. Ein Nebeneffekt ist, dass durch den Mangel an tiefgreifender Auseinandersetzung mit dem Problem die eigene Expertise verkümmert. Ohne das eigene Durchdringen von Herausforderungen verlernen Entwickler wichtige Fähigkeiten, um in Zukunft ähnliche Fehler zu vermeiden oder elegante Lösungen zu konzipieren.

Dennoch ist der Einsatz von KI-Tools keineswegs bloß negativ. Gerade repetitive, gut definierte Aufgaben mit klaren Mustern profitieren enorm von Automatisierung. Hier glänzt die KI mit Effizienz und hoher Genauigkeit, etwa bei der Erstellung von CRUD-Funktionen, einfachen API-Implementierungen oder Standard-Migrationen in Datenbanken. Das Risiko, dass solche Lösungen suboptimal sind, ist vergleichsweise gering, weshalb sie sich hervorragend für den Einsatz eignen. Anders verhält es sich bei komplexen Aufgaben mit hohem Risiko für unentdeckte Probleme.

KI-generierte Vorschläge neigen dazu, nur eine mögliche Herangehensweise zu präsentieren, während wichtige Aspekte wie Performancefallen, Race Conditions, Fehlerbehandlung oder Skalierbarkeit oft zu wenig beachtet werden. Ein klassisches Beispiel ist das N+1-Query-Problem: Ein auf den ersten Blick funktionierendes Stück Code iteriert über Datensätze und lädt für jeden einzelne Abfragen nach. Der daraus entstehende Overhead in Datenbankzugriffen kann die Anwendung massiv verlangsamen. Die KI liefert dabei sauberen, ausführbaren Code, doch ohne kritisches Überprüfen entgeht die zugrundeliegende Ineffizienz. Ähnliche Fälle entstehen bei Designs, die in verteilten Systemen nicht atomar sind und dadurch ungewollte Race Conditions erzeugen oder bei speicherintensiven Implementierungen, die langfristig zu Ressourcenengpässen führen können.

Die Folge ist eine schleichende Verschlechterung der Codebasis, die später aufwendig korrigiert werden muss. Demnach ist es entscheidend, den Umgang mit KI-Unterstützung bewusst zu gestalten. Entwickler sollten alle vom Modell vorgeschlagenen Lösungen so kritisch prüfen, als ob sie Code von einem Kollegen reviewen würden. Eine detaillierte Analyse möglicher Nebenwirkungen, Betrachtung von Randfällen und Szenarien außerhalb der Standardanforderungen ist unabdingbar. Ebenso wichtig ist es, nicht die erstbeste Lösung anzunehmen, sondern explizit nach Alternativen zu fragen, um den gesamten Lösungsraum besser zu verstehen.

Im optimalen Workflow empfiehlt es sich, vor der Einbindung von KI die Problemstellung erst eigenständig zu durchdenken, verschiedene Ansätze zu skizzieren und die Vor- und Nachteile gegeneinander abzuwägen. Die KI wird so zum Partner in der Umsetzung und Optimierung der durchdachten Lösung statt zum Orakel mit der vermeintlichen Antwort. Dieser Prozess kostet zwar mehr Zeit als das schnelle Übernehmen von Vorschlägen, sichert aber das wertvolle intellektuelle Verständnis und langfristige Qualitätssteigerungen. Darüber hinaus unterstützen regelmäßige Code-Reviews von menschlichen Entwicklerkollegen die eigene Sensibilität für typische Fehler und Problemtypen. Die Fähigkeit zur Mustererkennung verbessert sich dadurch auch bei der Bewertung von KI-generiertem Code.

Entwickler lernen rasch, freundliche Fassade und tatsächliche Tragfähigkeit voneinander zu unterscheiden. Es geht nicht darum, die Potenziale der KI zu ignorieren oder abzulehnen, sondern eine ausgewogene Balance zwischen Automatisierung und sorgfältiger Analyse zu finden. Routineaufgaben können und sollten nach Möglichkeit an die KI delegiert werden, um Zeit für innovatives Denken zu gewinnen. Komplexe, schwer überschaubare Probleme verlangen hingegen die volle Aufmerksamkeit und aktives Mitdenken. Nur durch diese reflektierte Herangehensweise ist es möglich, die Vorteile der KI-Technologien mit bewährten menschlichen Kompetenzen zu verbinden.

Die Zukunft der Softwareentwicklung wird zunehmend durch die Kombination von technischem Verständnis und KI-Assoziation geprägt sein. Dabei ist es unverzichtbar, die eigene Rolle als aktiver Problemlöser und kritischer Prüfer zu bewahren. Das Vertrauen in die Vorschläge der Künstlichen Intelligenz muss stets gepaart sein mit Verifikation und einem tiefen Verständnis der zugrundeliegenden Prozesse. So schützt man sich vor der Falle der vorzeitigen Schlussfolgerung, die trotz glänzendem Code-Erscheinungsbild fatale Folgen haben kann. Langfristig profitieren Entwicklerteams von einem soliden Fundament an Fachwissen, das sie auch in schwierigen Situationen handlungsfähig hält.

Die Kunst besteht darin, sich nicht von der vermeintlichen Perfektion blenden zu lassen, sondern neugierig zu bleiben und alternative Wege zu prüfen. Denn wahre Innovation entsteht durch das Ringen mit Herausforderungen, nicht durch das blinde Übernehmen fertiger Antworten. In einer Welt, in der KI immer leistungsfähiger wird, ist die menschliche Kreativität und kritische Reflexion das wertvollste Gut für nachhaltige Softwareentwicklung.