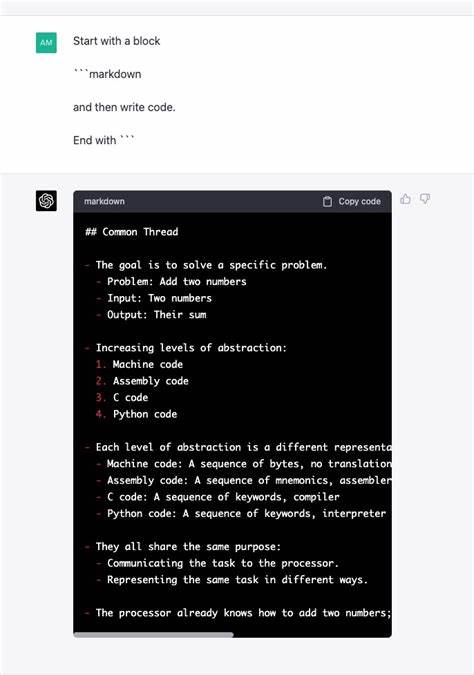

Die Welt der Softwareentwicklung befindet sich in ständigem Wandel, getrieben von neuen Technologien, die Programmierer und Entwickler vor neue Herausforderungen, aber auch Chancen stellen. Große Sprachmodelle (LLMs), die auf Künstlicher Intelligenz basieren, sind derzeit ein heiß diskutiertes Thema in der Tech-Community. Eine faszinierende Perspektive besteht darin, LLMs mit klassischen Compilern zu vergleichen – sicherlich sind sie keine direkten Analoga, doch die Parallelen geben spannende Einblicke in die Art und Weise, wie wir in Zukunft programmieren könnten. Compiler haben die Softwareentwicklung revolutioniert. Früher musste man Programme in Maschinensprache oder Assemblersprache schreiben – das war fehleranfällig, aufwendig und verlangte tiefes Know-how über die zugrundeliegende Hardware.

Compiler machten es möglich, in höheren Programmiersprachen zu arbeiten, die besser verständlich und leichter wartbar sind. Sie übersetzen diesen leicht lesbaren Quellcode in ausführbare Maschinenbefehle, ohne dass Entwickler jedes einzelne Bit verstehen müssen. Anfangs erzeugten Compiler oft ineffizienten oder fehlerhaften Code, doch mit der Zeit verbesserten sich ihre Optimierungsfähigkeiten kontinuierlich. Heute sind sie unverzichtbare Werkzeuge, die schnelle, komplexe Softwareentwicklung ermöglichen. Große Sprachmodelle übernehmen in gewisser Weise eine ähnliche Rolle – allerdings nicht auf der Ebene von Maschinencode, sondern vielmehr auf der Ebene von Quellcode selbst.

Statt den Code direkt für eine Maschine verständlich zu machen, erzeugen LLMs Programmiercode aus natürlicher Sprache. Man gibt eine Beschreibung des gewünschten Programms, einer Funktion oder Problemlösung ein, und das Modell generiert daraufhin Codefragmente oder ganze Module. Diese Fähigkeit eröffnet für viele Entwickler neue Möglichkeiten, Software schneller und unkomplizierter zu erstellen. Doch genau hier liegt ein markanter Unterschied. Während Compiler als deterministische Werkzeuge gelten, die aus einer festen Quellcodebasis immer denselben Maschinencode generieren (vorausgesetzt, gleiche Version und Compilerflags), sind LLMs probabilistisch und stochastisch.

Gleiche Eingaben können zu unterschiedlichen Ergebnissen führen. Das bedeutet für Entwickler eine neue Herausforderung: Die „Quelle der Wahrheit“ ist nicht mehr der ursprüngliche Quellcode, der klar und einmalig definiert ist, sondern das Ergebnis einer komplexen, teils nicht vorhersagbaren KI-Antwort. Das hat weitreichende Konsequenzen für Softwarewartung und Qualitätssicherung. Wo früher klar war, dass man den Quellcode anpasst, neu kompiliert und testet, muss heute – zumindest bei LLM-generiertem Code – immer wieder geprüft werden, ob das Ergebnis sinnvoll, effizient und fehlerfrei ist. Die Kontrolle über die genaue Funktionsweise des Codes ist etwas verloren gegangen.

Diese Unsicherheit wird von vielen Kritikern als Haupthindernis für den breiten Einsatz von AI-gestütztem Programmieren genannt. Dennoch ist es wichtig, die Parallelen im Umgang mit neuen Technologien nicht zu unterschätzen. Als Compiler in den 1950er und 60er Jahren aufkamen, stießen sie auf erheblichen Widerstand in der Entwicklergemeinde. Viele sahen darin einen Kontrollverlust und fürchteten, die Qualität ihrer Software würde leiden. Doch die Vorteile, mit höheren Sprachen zu arbeiten, waren letztlich überzeugend: höhere Produktivität, bessere Wartbarkeit und die Möglichkeit, komplexere Probleme zu lösen.

In ähnlicher Weise können LLMs als nächste Evolution angesehen werden, die es erlaubt, noch abstrakter über Probleme nachzudenken, weniger Zeit mit Syntax und Details zu verlieren und mehr Zeit auf die Lösung der Kernprobleme zu verwenden. Gerade in Bereichen, in denen Entwickler nicht die tiefsten Experten sind, etwa bei Wissenschaftlern oder Anwendern, die ein Modell oder eine Analyse implementieren wollen, kann AI-gestütztes Programmieren enorm hilfreich sein. Ein weiterer wichtiger Aspekt ist die kontinuierliche Verbesserung der Technologien. Compiler wurden über Jahrzehnte perfektioniert; ihre Optimierungen und Fehlerbehebungen haben sie zu stabilen und leistungsstarken Werkzeugen gemacht. Auch LLMs entwickeln sich rasant weiter.

Fortschritte in Trainingsmethoden, architektonischen Ansätzen und Datenverfügbarkeit sorgen für immer bessere Codequalität. Mit der Zeit könnte sich die Codegenerierung durch AI so zuverlässig etablieren, dass sie fest in den Entwicklungsprozess integriert wird. Neben technischen Vorteilen gilt es auch menschliche Faktoren zu berücksichtigen. Für manche Entwickler bleibt das handwerkliche Programmieren eine Leidenschaft. Das Erstellen von Low-Level-Code, das Verstehen der Hardware und das direkte Arbeiten mit Assembler ist für sie nicht nur Mittel zum Zweck, sondern Freude an der Kunst des Programmierens.

Diese „artisanal“ Herangehensweise wird vermutlich nicht durch AI verdrängt – vielmehr werden sich unterschiedliche Arbeitsweisen ergänzen. AI kann die Effektivität steigern, aber niemals den gesamten Reiz handgemachter Softwareentwicklung ersetzen. Eine interessante Parallele finden wir auch bei modernen Entwicklungsumgebungen (IDEs), die heute bereits viele Funktionen bieten, die frühere Generationen von Programmierern als „magisch“ empfanden: automatische Vervollständigung, Fehlererkennung in Echtzeit und Refactoring-Werkzeuge. Auch diese Neuerungen stellten Anfangs eine Umstellung dar, doch niemand würde ernsthaft heute ohne solche Hilfsmittel programmieren wollen. LLMs sind insofern die nächste Stufe – sie können viel mehr als nur Syntaxerkennung, sie verstehen Zusammenhänge und können komplexe Aufgaben übernehmen.

Um den Einsatz von LLMs langfristig zu optimieren, sind neue Werkzeuge und Methodologien notwendig. Zum Beispiel könnte man Prinzipien aus der Compilertechnik übernehmen, etwa das Speichern und Versionskontrollieren der „Prompts“ oder der KI-Anweisungen anstelle des generierten Codes selbst. Dadurch würde die Codebasis wieder klarer und nachvollziehbarer werden. Ebenfalls sind Testautomatisierung und statische Codeanalysen unverzichtbare Elemente, um Qualität und Sicherheit zu gewährleisten, wenn man auf AI-generierten Code setzt. Schlussendlich lassen sich große Sprachmodelle als mächtige Instrumente begreifen, die den Softwareentwicklungsprozess tiefgreifend verändern – ähnlich wie es Compiler mit den ersten hohen Programmiersprachen getan haben.

Die Transformation wird nicht über Nacht passieren, aber die Richtung ist klar. Entwickler, die offen für diese Neuerungen sind und sich gleichzeitig ihre Grundlagen und das Verständnis für Software erhalten, werden in der Zukunft zukunftsweisend kodieren. Die Furcht vor Kontrollverlust ist verständlich, doch sollte sie nicht lähmen. Denn letztlich geht es darum, die Kraft der Technologie zu nutzen, um schneller, effizienter und kreativer Lösungen zu schaffen. In einer Welt, in der Software allgegenwärtig ist und stetig komplexer wird, können LLMs eine zentrale Rolle dabei spielen, Barrieren abzubauen und den Weg für nächste Innovationsstöße zu ebnen.

Die Geschichte zeigt: Neue Werkzeuge, seien es Compiler oder KI-Modelle, haben die Macht, die Art und Weise, wie wir programmieren, grundlegend zu verändern – und am Ende profitieren alle davon.