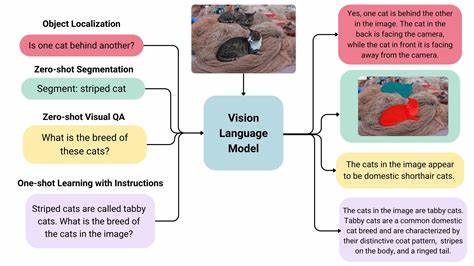

Die rasante Entwicklung großer Vision-Sprach-Modelle (LVLMs) hat die künstliche Intelligenz in den letzten Jahren auf ein neues Niveau gehoben. Diese Modelle, die sowohl visuelle als auch sprachliche Daten verarbeiten, ermöglichen komplexe Zusammenhänge und tiefgehende Analysen, die für Anwendungen von autonomen Fahrzeugen bis hin zu innovativen Suchmaschinen genutzt werden. Doch trotz ihrer beeindruckenden Fähigkeiten kämpften die LVLMs mit einem Phänomen namens "Overthinking" – das heißt, sie neigen dazu, zu jeder Aufgabe ausschweifende und lange Erklärungen zu generieren, selbst wenn dies nicht notwendig ist. Diese unnötige Denklast führt nicht nur zu Ineffizienzen, sondern beeinträchtigt auch die Leistungsfähigkeit und Anwendbarkeit der Modelle im Praxisalltag. Vor diesem Hintergrund setzt das Konzept des Fast-Slow Thinking – eine adaptive Methode, die zwischen schneller und langsamer Denkweise wechselt – einen neuen Maßstab im Bereich der Bild-Sprach-Modellierung.

Das Fast-Slow Thinking-Prinzip basiert auf der Annahme, dass nicht alle Fragen oder Aufgaben gleich komplex sind und deshalb auch nicht dieselbe Menge an kognitiver Ressourcen benötigen. In der menschlichen Kognition ist dieses Prinzip längst bekannt: Routinetätigkeiten oder einfache Probleme werden schnell und automatisiert gelöst, während komplexere Herausforderungen eine gründlichere und bedächtigere Analyse erfordern. Überträgt man dieses Prinzip auf LVLMs, so bedeutet dies, dass das Modell dynamisch entscheiden kann, wann eine schnelle, oberflächliche Antwort genügt und wann eine langsame, tiefgründige Denkweise sinnvoll ist. Aktuelle Forschungen wie die von Wenyi Xiao und Kollegen zeigen, dass mit einer solchen adaptiven Denkweise signifikante Verbesserungen erzielt werden können. Sie entwickelten das Framework FAST (FaST-Slow Thinking), das anhand von drei wesentlichen Komponenten funktioniert.

Erstens erlaubt eine modellbasierte Metrik, die Charakteristik der Frage genau einzuschätzen und so die Komplexität zu bestimmen. Zweitens steuert ein adaptives Belohnungssystem die Denkweise dynamisch und fördert eine optimale Balance zwischen Schnelligkeit und Genauigkeit. Drittens sorgt eine schwierigkeitssensitive Regularisierung mittels der Kullback-Leibler-Divergenz (KL) dafür, dass das Modell beim langsamen Denken nicht übermäßige Ressourcen verschwendet und bei einfachen Aufgaben nicht unnötig verlangsamt wird. Das Ergebnis ist beeindruckend: In mehreren Benchmark-Tests zeigt FAST eine Steigerung der Genauigkeit um über zehn Prozent gegenüber den Basismodellen und reduziert zugleich die benötigten Tokens um bis zu zwei Drittel im Vergleich zu bisherigen langsamen Denkansätzen. Diese Effizienzsteigerung verbunden mit verbesserten Ergebnissen weist auf das enorme Potenzial adaptiver Denkmechanismen in multimodalen KI-Systemen hin.

Die Vorteile dieser Methode sind vielfältig. Zum einen ermöglicht sie eine ressourcenschonendere Nutzung von Rechenleistung. In Zeiten, in denen große KI-Modelle mit immensem Energieverbrauch und Kosten verbunden sind, liefert FAST eine elegante Lösung zur Optimierung der Performanz. Zum anderen verbessert die Anpassungsfähigkeit der Denkweise die Benutzererfahrung: Nutzer erhalten präzise und auf den Punkt gebrachte Antworten, ohne mit langen und überwältigenden Erklärungen konfrontiert zu werden. Gerade in Anwendungsgebieten wie der medizinischen Bildanalyse, dem autonomen Fahren oder der Rechtsprechung kann dies entscheidende Vorteile bringen, da hier schnelle und dennoch verlässliche Entscheidungen gefragt sind.

Grundlegend für den Erfolg des Fast-Slow Thinking-Ansatzes ist die Fähigkeit des Systems, den Schwierigkeitsgrad einer Anfrage präzise einzuschätzen. Fragen mit klaren, eindeutigen Antworten können schnell abgehandelt werden, ohne unnötig viele Verarbeitungsschritte zu durchlaufen. Komplexere Fragestellungen, die mehr Kontext, logisches Denken oder kreative Lösungen erfordern, werden tiefergehend analysiert. Diese Flexibilität verhindert das sogenannte "Overthinking", bei dem Modelle unnötigerweise alle Aufgaben mit tiefen und langwierigen Analysen bearbeiten, was zu ineffizienter Token-Nutzung und langsameren Antwortzeiten führt. Zudem bietet die Kombination von modellspezifischen Metriken und Trainingsmechanismen eine ausgefeilte Balance zwischen Exploitation und Exploration: Während der schnelle Denkprozess auf bekannten Mustern und Routinen basiert, erlaubt der langsame Denkprozess die gründliche Untersuchung unbekannter oder schwieriger Fälle.

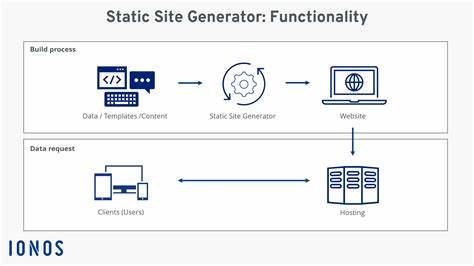

Auf diese Weise wird das Modell adaptiv trainiert und verbessert sich kontinuierlich in seiner Fähigkeit, situationsabhängig zu entscheiden. Im Vergleich zu anderen Ansätzen, die entweder ausschließlich schnelle Reaktionszeiten oder tiefgründige Verarbeitung priorisieren, stellt FAST eine ausgewogene Lösung dar, die Skalierbarkeit und Genauigkeit vereint. Dies ist insbesondere für den praktischen Einsatz in dynamischen und ressourcenbeschränkten Umgebungen von entscheidender Bedeutung. Anwendungen im Bereich der mobilen Geräte, Echtzeitkommunikation oder Edge-Computing profitieren stark von der Reduktion unnötiger Rechenoperationen ohne Qualitätseinbußen. Ein weiterer interessanter Aspekt der FAST-Methode liegt in der Möglichkeit, bessere Erklärungen und interpretierbare Ergebnisse zu liefern.

Da die Denkweise auf die jeweilige Komplexität abgestimmt ist, entstehen angemessene Antwortlängen und -formate. So werden Überfrachtungen vermieden und das Vertrauen in KI-Systeme gestärkt. Dies ist ein Schritt hin zu transparenteren und nachvollziehbareren künstlichen Intelligenzen. Zukünftige Forschung in diesem Bereich könnte darauf abzielen, das Fast-Slow Thinking-Konzept noch weiter zu verfeinern und auf weitere multimodale Aufgaben auszudehnen. Die Integration weiterer Modalitäten wie Audio oder Sensor-Daten wäre denkbar, um Echtzeit-Systeme noch effektiver und intelligenter zu machen.

Zudem bieten sich Möglichkeiten, die adaptive Denkweise durch verstärkendes Lernen und selbstüberwachtes Training noch flexibler und autonomer zu gestalten. Insgesamt markiert das Fast-Slow Thinking für große Vision-Sprach-Modelle einen Paradigmenwechsel im Bereich der multimodalen KI. Die Kombination von intelligent angepasster Verarbeitungstiefe mit gezielter Regulierung ermöglicht eine effiziente und präzise Analyse komplexer Informationsquellen. So wird nicht nur die Leistungsfähigkeit der Modelle gesteigert, sondern auch deren praktische Anwendbarkeit und Nutzerfreundlichkeit verbessert. Die neue Generation von KI-Systemen, die auf adaptiven Denkprozessen basiert, kann dadurch vielseitiger, schneller und zuverlässiger agieren.

Dies öffnet Türen für innovative Einsatzmöglichkeiten, die bislang aufgrund von Rechenaufwand oder mangelnder Effizienz nicht realisierbar waren. Von der automatisierten Bildbeschreibung über komplexe Entscheidungsunterstützung bis hin zur intelligenten Kommunikation – die Potentiale sind enorm. Für Unternehmen und Entwickler im Bereich der KI bedeutet dies, dass Investitionen in adaptive Frameworks wie FAST zukünftig nicht nur die Modellqualität erhöhen, sondern ebenso die Betriebskosten reduzieren können. Die Kombination aus technischer Innovation und den wirtschaftlichen Vorteilen macht Fast-Slow Thinking zu einem vielversprechenden Ansatz, der die Zukunft der multimodalen künstlichen Intelligenz maßgeblich prägen wird.

![CPL elementary programming manual [pdf]](/images/B9879993-EAB5-4F41-A8A1-F57D66AC20AD)