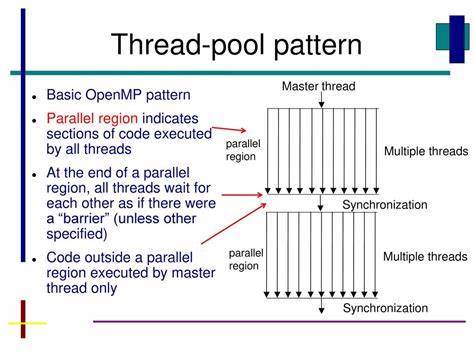

Die Parallelprogrammierung ist ein essenzieller Bestandteil moderner Softwareentwicklung, um die Leistung von Mehrkernprozessoren voll auszuschöpfen. OpenMP hat sich über Jahre als eine der beliebtesten Methoden etabliert, um parallelisierbaren Code einfach umzusetzen. Doch mit der zunehmenden Komplexität der Systeme und der Entwicklung neuer C++-Standards zeichnen sich alternative Ansätze ab. Besonders bemerkenswert ist die Einführung eines ThreadPools durch Copilot, der auf std::threads basiert und OpenMP in vielen Bereichen ersetzen kann. Diese Neuerung eröffnet spannende Möglichkeiten für die parallele Verarbeitung, insbesondere bei Algorithmen wie Quicksort, die von einer effizienten Thread-Verwaltung profitieren.

OpenMP ist ein bewährtes API, das den Entwicklern die Komplexität der Thread-Erzeugung und Synchronisation weitgehend abnimmt. Mit pragmatischen Direktiven kann man parallelisierbare Bereiche kennzeichnen, und der Compiler generiert den entsprechenden Code für die parallele Ausführung. Dadurch ist der Einstieg in die Parallelprogrammierung relativ einfach. Dennoch bringt OpenMP Einschränkungen mit sich, etwa in Bereichen der Flexibilität, Portabilität und der Kontrolle über Thread-Verwaltung und Scheduling. Gerade wenn es darum geht, spezialisierte Thread-Pools oder fein abgestimmte Parallelisierungsstrategien zu implementieren, stößt OpenMP an Grenzen.

Copilot, die KI-gestützte Programmierassistenz, hat kürzlich durch die Implementierung eines eigenen ThreadPools mit std::threads als Grundlage gezeigt, dass ein flexibler und leistungsfähiger Ersatz für OpenMP möglich ist. Die verwendete ThreadPool-Klasse organisiert eine feste Anzahl von Worker-Threads, die auf eingehende Aufgaben warten. Dadurch wird der Overhead durch häufiges Erzeugen und Zerstören von Threads stark reduziert. Für Algorithmen mit rekursiv-paralleler Struktur wie Quicksort bietet das deutliche Vorteile, denn die Aufgaben können effizient verteilt werden, ohne jedes Mal neue Threads anlegen zu müssen. Der zugrundeliegende Mechanismus des ThreadPools ist vergleichsweise einfach, aber äußerst wirkungsvoll.

Im Kern wartet eine Anzahl von Workern in einer Endlosschleife auf Aufgaben, die in einer Thread-sicheren Warteschlange abgelegt werden. Sobald neue Aufgaben eintreffen, benachrichtigt ein Condition Variable einen oder mehrere Worker, die dann die Aufgaben abarbeiten. Besonderes Augenmerk liegt auf der Synchronisation und der Vermeidung von Race Conditions, beispielsweise durch den Einsatz von Mutexen und Atomics. Das sichert eine konsistente Verwaltung der Threads und reduziert Probleme wie Deadlocks oder verlorene Benachrichtigungen. Im Vergleich zu OpenMP bietet die Implementierung mit std::threads und einem ThreadPool mehr Kontrolle und Flexibilität.

Entwickler können detailliert steuern, wie Aufgaben verteilt, wann Threads gestartet oder gestoppt werden, und die Ressourcenverwaltung ist expliziter steuerbar. Außerdem erlaubt dieses Modell eine bessere Integration in bestehende C++-Codebasen, die oft schon auf std::thread aufbauen, ohne auf die Abstraktionen von OpenMP angewiesen zu sein. Ein häufig genanntes Beispiel für den Einsatz einer solchen ThreadPool-Struktur ist der parallele Quicksort. Quicksort ist ein effizienter, vergleichsbasierter Sortieralgorithmus, der oft rekursiv implementiert wird. Die natürliche Aufteilung in Teilprobleme bietet sich hervorragend für parallele Umsetzung an.

Mit OpenMP geschieht dies oftmals über pragmatische Direktiven, die die Rekursion automatisch parallelisieren. Mit dem ThreadPool-Ansatz erfolgt die Steuerung des parallelen Aufrufs hingegen manuell über das Einspeisen von Aufgaben in die Thread-Warteschlange. Dabei wird die Aktivität der Threads effizient genutzt und eine Überlastung durch zu viele parallel laufende Aufgaben vermieden. Die Performance des Copilot-ThreadPools konnte mit OpenMP auf Augenhöhe gebracht werden. Tests zeigten, dass die Latenzzeiten und Durchsatzraten des Quicksort-Algorithmus in der Parallelfassung vergleichbar sind, was auf eine gelungene Umsetzung der Threadverwaltung zurückzuführen ist.

Besonderer Wert wurde zudem auf die Stabilität und Thread-Sicherheit gelegt, denn besonders bei paralleler Sortierung können Fehler wie Datenkorruption oder inhärente Race Conditions zu inkonsistenten Ergebnissen führen. Es gab jedoch Herausforderungen in der Entwicklung und Reviews des Codes, wie sie in der Projekt-Diskussion dokumentiert sind. So wurde unter anderem auf mögliche Race Conditions beim Notifizieren von Threads in Warteschleifen hingewiesen. Die Vermeidung solcher Fehler erfordert ein tiefes Verständnis der Synchronisationsmechanismen in C++ sowie bewährte Entwurfsmuster für Threadpools. Beispielsweise muss vor dem Warten auf eine Bedingung stets geprüft werden, ob tatsächlich noch Arbeit vorliegt, um verlorene Benachrichtigungen zu vermeiden oder potenzielle Deadlocks auszuschließen.

Ebenso wurde empfohlen, moderne C++-Funktionen wie CTAD (Class Template Argument Deduction) zu verwenden, um den Code lesbarer und kompakter zu gestalten. Eine weitere Empfehlung war der Einsatz von std::atomic für Variable, die zwischen Threads geteilt werden, um Zustandsänderungen sicher zu verfolgen. Die Stabilität und Zuverlässigkeit eines ThreadPools basiert maßgeblich auf korrekter Synchronisation. Insofern wurden solche Hinweise von Copilot und menschlichen Reviewern dankbar aufgenommen und in den Code integriert. Die Integration des ThreadPools in den Entwicklungsprozess erfolgte auch durch Erweiterung der Build- und Test-Infrastruktur.

Neue Build-Optionen wurden ergänzt, um die Nutzung des std::thread-basierten Parallelismus aktivieren zu können. Die Continuous Integration (CI) Workflows wurden angepasst, um die Codequalität und die Funktionsfähigkeit bei paralleler Ausführung systematisch zu prüfen. Neben Performance-Messungen wurde auch auf die Regressionstestabdeckung Wert gelegt. Der Ansatz, von OpenMP hin zu einem selbst verwalteten ThreadPool zu wechseln, ist nicht ausschließlich eine technische Entscheidung. Er steht auch für den Trend in der Softwareentwicklung, enger mit der Spracheigentlichen Thread-Unterstützung zu arbeiten und KI-basierte Tools wie Copilot als Unterstützer bei komplexen Implementierungen einzusetzen.

So können Entwickler Aufgaben mit klarer Parallelstrategie explizit steuern und optimieren, statt sich auf automatische oder Compiler-basierte Parallelisierung zu verlassen, die im Hintergrund arbeitet. Neben den Vorteilen bleiben weiterhin Punkte offen, die die weitere Entwicklung prägen. Beispielsweise stellt sich die Frage nach der optimalen Anzahl von Threads für unterschiedliche Hardwarearchitekturen. Im Projekt wurde eine Limitierung auf acht Threads vorgenommen, auch wenn das System mehr Kerne bietet. Die Gründe liegen in der Cache-Lokalisierung und Datenpartitionierung, welche bei zu vielen Threads die Effizienz beeinträchtigen kann.

Hier sorgt ein ausgewogenes Verhältnis zwischen Parallelisierung und Arbeitsteilung für die beste Performance. Abschließend lässt sich sagen, dass Copilots ThreadPool-Implementierung eine moderne, robuste und flexible Alternative zu OpenMP ist, die durch die Nutzung von std::threads tief in die C++-Standardbibliothek integriert ist. Das manuelle Handling von Threads und Synchronisation erfordert zwar mehr Know-how vom Entwickler, bietet aber dafür Chancen durch feinkörnigere Steuerung und potenziell bessere Integration in komplexe Systeme. Für die Zukunft zeichnen sich vielversprechende Entwicklungen ab. Die Verwendung von noch moderneren C++-Funktionen wie std::jthread (ab C++20) könnte den ThreadPool weiter vereinfachen, indem automatische Join- und Abbruchmechanismen eingebaut werden.

Ebenso könnten KI-gestützte Codegeneratoren wie Copilot noch intensiver in die Entwicklung von Parallelisierungsmustern eingebunden werden, um die Effizienz zu erhöhen und Fehlerquellen zu minimieren. Parallelisierung ist und bleibt eine Kernherausforderung in der Softwareentwicklung. Die Umsetzung des parallelen Quicksorts mit einem ThreadPool zeigt exemplarisch, wie durch gezieltes Design und Nutzung moderner Sprachmittel die Grenzen bisheriger Ansätze wie OpenMP überwunden werden können. Damit ebnet Copilot den Weg für neue Standards der parallelen Programmierung, die Performance, Stabilität und Flexibilität in Einklang bringen.