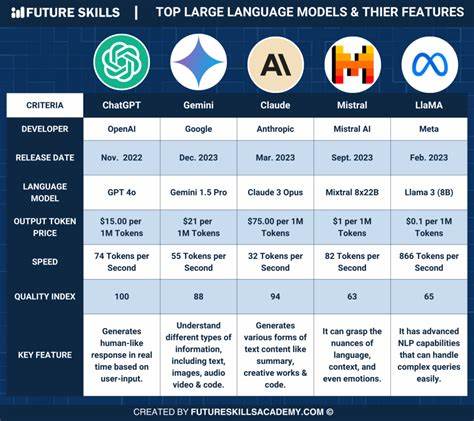

In der schnelllebigen Welt der Künstlichen Intelligenz dominieren große Sprachmodelle (LLMs) wie Claude Sonnet 3.7, Gemini Pro 2.5 oder o4-mini die Schlagzeilen. Diese Modelle sind wahre Alleskönner und können mit den richtigen Eingaben und Werkzeugen sehr leistungsfähige Agenten bilden. Doch trotz ihrer beeindruckenden Fähigkeiten haben sie stets den Nachteil, dass sie allgemeingültig und auf eine Vielzahl von Themen ausgerichtet sind, was nicht immer die effizienteste Lösung darstellt.

Genau hier zeigt sich die Stärke von spezialisierten Modellen, die mittels Reinforcement Learning (RL) trainiert wurden. Sie sind spezialisiert, kostengünstiger und oft leistungsfähiger für konkrete Anwendungsfälle als die größten LLMs. Die Herausforderung bei allgemeinen Sprachmodellen besteht darin, dass sie auf unzähligen Themen ausgebildet sind und deshalb für jede neue Aufgabe quasi „neu angelernt“ oder ausführlich mit Prompts gefüttert werden müssen, um erwünschte Antworten zu liefern. Das heißt, bei jedem Einsatz ist es so, als würde das Modell an seinem ersten Tag neue Werkzeuge und Aufgaben erklärt bekommen – ein umständlicher und oft unzuverlässiger Prozess. Die Modelle können so zwar vielfältig eingesetzt werden, aber die Tiefe des Fachwissens fehlt Ihnen oft in speziellen Anwendungsfeldern.

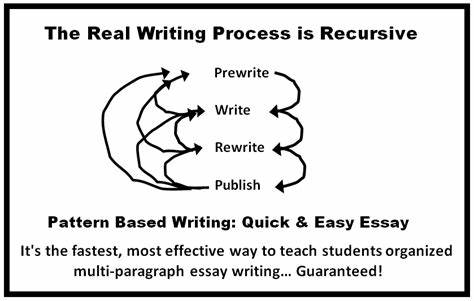

Spezialisierung durch Reinforcement Learning bietet hier eine echte Alternative. RL erlaubt es, Modelle gezielt auf einzelne Aufgaben hin zu optimieren, indem sie aus Interaktionen und der Bewertung ihrer Handlungen lernen. Anstatt einfach nur auf einen gegebenen Datensatz zu reagieren, wird das Modell für eine konkrete Aufgabe mit einem Belohnungssystem ausgestattet, das genau misst, wie gut die getroffenen Entscheidungen oder Outputs sind. Die Modelle lernen so, ihre Entscheidungen zu verbessern und auf einer tieferen Ebene zu verstehen, wie sie ihre Ziele erreichen können. Die zugrunde liegende Idee ist simpel, aber mächtig: Das Modell wird nicht mehr in einem starren Setup trainiert, sondern lernt dynamisch und selbstständig, durch Belohnungen, sein Verhalten zu verbessern.

Dies führt zu einer intuitiven Beherrschung von Werkzeugen und Fähigkeiten, die für den spezifizierten Anwendungsfall entscheidend sind. Die Priorisierung der Belohnung sorgt zudem dafür, dass Fehlversuche minimiert werden und das Modell ausschließlich auf die Ergebnisse hinarbeitet, die tatsächlich erfolgsversprechend sind. Ein signifikanter Vorteil von RL ist, dass es weit über herkömmliche Feinabstimmung hinausgeht. Beim normalen Fine-Tuning besteht oft das Risiko des Überanpassens an Trainingsdaten, was dann die Fähigkeit des Modells mindert, bei neuen Daten richtig zu reagieren. Reinforcement Learning ermöglicht hingegen eine bessere Generalisierung, da es fortwährend auf der Grundlage dynamischer Rückmeldungen optimiert wird.

Zudem werden keine umfangreichen Beispiele für „gute“ Antworten benötigt – das Modell kann auch ohne explizit vorgegebene Vorlagen lernen, indem es auf die Rückmeldungen aus dem Belohnungssystem reagiert. Praktische Anwendungen verdeutlichen die Wirksamkeit von RL-eingesetzten spezialisierten Modellen eindrucksvoll. In der Chemie etwa wurden LLMs dazu aufgefordert, Moleküle zu generieren, die ein bestimmtes Protein des Coronavirus hemmen können. Die Qualität des Outputs wurde mittels eines simulierten Bindungsstärke-Scores bewertet, der im Belohnungssystem als Maßstab diente. Innerhalb von nur zwei Stunden Trainingszeit konnte ein relativ kleines 3-Milliarden-Parameter-Modell, das sogar auf einem iPhone betrieben werden kann, so viel Fachwissen erlangen, dass es die Leistung von großen Modellen wie Claude 3.

7 übertraf. Im Bereich der Browserbedienung wurde wiederum gezeigt, dass spezialisiertes RL-Training einem Modell ermöglicht, komplexe und „nervige“ Formulare deutlich schneller und fehlerfrei auszufüllen als generelle LLMs. So wurde etwa ein besonders schwieriges Formular, das selbst fortschrittliche Modelle nicht effizient bewältigen konnten, in weniger als eineinhalb Minuten erfolgreich ausgefüllt – ein beeindruckendes Beispiel für praktische Effizienz und Spezialwissen. Für Unternehmen und Entwickler, die bereits über Evaluierungsmethoden für ihre KI-Agenten verfügen, stellt RL eine hervorragende Gelegenheit dar, die erzielten Messwerte als Belohnungsfunktion zu verwenden und die Leistung gezielt zu maximieren. Wer diese Bewertungsmethoden noch nicht hat, bekommt inzwischen von spezialisierten Anbietern wie The LLM Data Company Unterstützung dabei, geeignete Metriken zu definieren und zu messen.

RunRL bietet als Plattform genau die notwendigen Tools und Infrastruktur, um Reinforcement Learning auf verschiedenste LLMs und KI-Agenten anzuwenden. Mit dem Ziel, die Magie von RL für Entwickler und Unternehmen zugänglich zu machen, unterstützt RunRL dabei, Modelle effizient zu trainieren und spezialisierte Fähigkeiten auszubauen. Die Vorteile von RL sind nicht nur in der Theorie überzeugend, sondern zeigen sich in messbaren Fortschritten und Kosteneinsparungen im Vergleich zu den gigantischen allgemeinen LLMs. Zusammenfassend lässt sich sagen, dass spezialisierte Modelle, die durch Reinforcement Learning trainiert werden, eine vielversprechende Alternative zu den momentan marktführenden großen Sprachmodellen darstellen. Sie sind nicht nur günstiger in der Anwendung, sondern auch in der Fähigkeit, komplexe spezifische Aufgaben zuverlässig und schnell zu lösen, deutlich überlegen.

Während große Modell-Anbieter das Ziel verfolgen, möglichst breite Abdeckung und Vielseitigkeit zu schaffen, zeigt RL, dass konzentrierte Fachkompetenz im jeweiligen Anwendungsfall entscheidend sein kann, um bestmögliche Resultate zu erzielen. Die Zukunft der KI wird daher aller Voraussicht nach eine Symbiose aus gigantischen Multitalenten und spezialisierten Expertensystemen sein. Reinforcement Learning dient als Schlüsseltechnologie, die eine effizientere, gezieltere und intelligente Leistungssteigerung ermöglicht – zugunsten von Anwendern, die maßgeschneiderte und hochspezialisierte AI-Lösungen benötigen. Es lohnt sich, diesem spannenden Ansatz besondere Aufmerksamkeit zu schenken und die Potenziale frühzeitig zu nutzen.