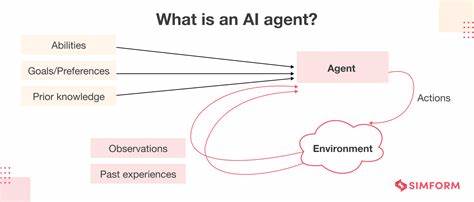

Die digitale Transformation schreitet unaufhaltsam voran und revolutioniert zahlreiche Lebensbereiche. Besonders im Bereich der Automatisierung und künstlichen Intelligenz machen intelligente Internet-Agenten einen bedeutenden Fortschritt möglich. Doch was genau versteht man unter einem intelligenten Internet-Agenten? Wie funktionieren solche Systeme und welche Vorteile bieten sie? Diese Fragen sind zentral, um das Potenzial und die Anwendungsmöglichkeiten dieser Technologie umfassend zu verstehen. Ein intelligenter Internet-Agent ist im Kern ein automatisiertes System, das eigenständig im Internet agiert, Informationen sammelt, analysiert und darauf basierend selbstständig Entscheidungen trifft oder Aktionen ausführt. Anders als einfache Chatbots oder regelbasierte Skripte besitzen diese Agenten die Fähigkeit, komplexe Zusammenhänge zu erfassen, sich an verschiedene Kontexte anzupassen sowie mit Nutzern interaktiv und adaptiv zu kommunizieren.

Moderne Agenten basieren auf fortschrittlicher Sprachverarbeitung, maschinellem Lernen und Integration großer Sprachmodelle (LLM), wodurch sie ein tiefes Verständnis natürlicher Sprache und Szenarien erreichen. Die Architektur intelligenter Internet-Agenten besteht typischerweise aus verschiedenen Komponenten, die zusammenarbeiten, um eine nahtlose Nutzererfahrung und effiziente Prozesse zu gewährleisten. Zu den Kernbestandteilen zählen das Agent-Management-System, das die Konfiguration, Steuerung und Überwachung der Agenten übernimmt, sowie ein Nachrichten- und Ereignissystem, das eine reaktive Kommunikation ermöglicht und Kontextinformationen speichert. Insbesondere die Gedächtnis- und Kontextverwaltung spielt eine Schlüsselrolle, damit der Agent Gesprächsverläufe nachvollziehen und relevante Informationen langfristig behalten kann. Ein weiterer zentraler Aspekt ist die Integration von Tools und Schnittstellen, die dem Agenten Zugriff auf unterschiedliche Webdienste und Funktionalitäten ermöglichen.

Dazu gehören Browserautomatisierung, Dateiverwaltung, Präsentationsfunktionen und spezialisierte Recherche-Tools. Durch diese Vielseitigkeit kann der Agent nicht nur einfache Anfragen beantworten, sondern komplexe Aufgaben selbstständig bearbeiten – von der Informationsrecherche über Datenanalyse bis hin zur Ausführung von Aktionen. Die Verbindung eines intelligenten Internet-Agenten zu leistungsfähigen LLMs wie den Modellen von OpenAI, Anthropic oder Google Gemini ist essenziell für seine Leistungsfähigkeit. Diese Modelle dienen als „Gehirn“ des Agenten, indem sie natürliche Sprache verstehen und generieren können. Dabei wird ua.

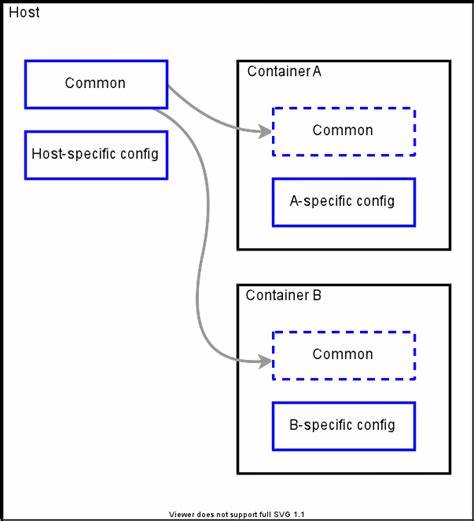

über eine Client-Architektur eine einfache Integration unterschiedlicher Anbieter gewährleistet, sodass je nach Anforderung und Verfügbarkeit flexibel ein Modell gewählt werden kann. Die Auswahl des passenden LLM beeinflusst maßgeblich die Schnelligkeit, Genauigkeit und Qualität der Antworten. Bei der Einrichtung und dem Betrieb solcher Agenten kommt modernen DevOps-Methoden große Bedeutung zu. Empfohlen wird vornehmlich eine Docker-basierte Bereitstellung, die alle benötigten Komponenten als containerisierte Services orchestriert. Docker Compose erleichtert die Verwaltung der Systeme, sorgt für Reproduzierbarkeit und eine einfache Skalierung.

Alternativ lässt sich die Installation auch manuell umsetzen, was insbesondere für Entwicklerzwecke und individuelle Anpassungen von Vorteil ist. Die Konfiguration der Umgebung erfordert die sorgfältige Einrichtung von Backend- und Frontend-Komponenten. Im Frontend bietet das System eine Webanwendung, die über eine moderne Benutzeroberfläche eine interaktive Kommunikation mit dem Agenten ermöglicht. Die Backend-Umgebung nutzt Python als Programmiersprache und stellt über WebSocket-Server eine Echtzeitverbindung sicher, die es erlaubt, Anfragen schnell zu verarbeiten und Ergebnisse unmittelbar an Nutzer zu übermitteln. Das Datenmanagement erfolgt über eine integrierte SQLite-Datenbank, die mittels automatischer Migrationsmechanismen stets auf dem neuesten Stand gehalten wird.

Sie speichert unter anderem Sitzungsinformationen und Ereignisdaten, was es erlaubt, Nutzersitzungen dauerhaft zu speichern und den Agenten kontextbewusst arbeiten zu lassen. Diese Persistenz ist gerade bei komplexen oder längeren Unterhaltungen essenziell, um ein konsistentes Nutzererlebnis zu gewährleisten. Die Sicherheitsaspekte bei intelligenten Internet-Agenten dürfen ebenfalls nicht unterschätzt werden. Da diese Systeme in der Regel auf externe APIs zugreifen, z. B.

von LLM-Anbietern, muss die Verwaltung von API-Schlüsseln und Zugangsdaten sicher erfolgen. Optional können auch zusätzliche Integrationen, etwa mit Google Cloud oder Google Drive, eingebunden werden, wobei in diesen Fällen die entsprechenden Zugriffsdaten und Berechtigungen sauber konfiguriert werden müssen. Intelligente Internet-Agenten zeichnen sich durch ihre vielfältigen Anwendungsmöglichkeiten aus. Unternehmen können sie zur Automatisierung von Kundenservice, Rechercheaufgaben oder Vertrieb nutzen. Die Fähigkeit, mit Benutzern personalisiert und interaktiv zu kommunizieren, eröffnet neue Chancen in der Verbesserung von Nutzererfahrungen und der Steigerung von Effizienz.