AMD präsentiert mit seiner Instinct MI350 Serie einen bedeutenden Fortschritt in der Entwicklung von KI-Beschleunigern und hat dabei eine langfristige Vision vor Augen, die bis ins Jahr 2027 reicht. Die MI350-GPU, die auf der neuesten CDNA4-Architektur basiert, stellt nicht nur einen enormen Sprung in Sachen Rechenleistung dar, sondern auch in puncto Energieeffizienz und Skalierbarkeit. Mit klaren Zielen, die über den aktuellen Stand hinausgehen, untermauert AMD seine Ambition, im schnell wachsenden Markt der künstlichen Intelligenz eine führende Rolle einzunehmen. Die MI350-Serie markiert den Beginn einer neuen Generation, die mit innovativen Technologien und einer intelligenten Chiplet-Architektur arbeitet, um die Herausforderungen moderner KI-Workloads zu meistern. Die Grundlage bildet die fortschrittliche Verpackungstechnologie, die eine 3D-Chiplet-Integration ermöglicht.

Acht leistungsstarke Beschleuniger-Compute-Chiplets arbeiten Hand in Hand, während die IO-Dies für effizientes Speicher- und Datenmanagement sorgen. Die Verwendung des hochmodernen 3-nm-Prozesses sorgt für eine verbesserte Energieeffizienz und ermöglicht gleichzeitig eine kompakte Chiparchitektur. Mit insgesamt 256 Compute Units bietet die MI350 eine ausgewogene Mischung aus Rohleistung und effizienter Speicheranbindung. Besonders hervorzuheben ist die Zusammenarbeit zwischen den Compute-Chiplets und den IO-Dies über hybride 3D-Verbindungstechniken, die eine sehr hohe Bandbreite und geringe Latenz sicherstellen. Das Ergebnis ist ein hochintegrierter und gleichzeitig modularer Aufbau, der Skalierbarkeit und eine flexible Ressourcenzuteilung in unterschiedlichen KI-Anwendungen erlaubt.

Die Speicherarchitektur wurde ebenfalls signifikant verbessert. Die MI350-Geräte verfügen über umfangreiche 288 GB HBM3E mit einer extrem hohen Bandbreite von bis zu 1,3-mal mehr pro Watt im Vergleich zum Vorgänger. AMDs Infinity Cache sorgt zusätzlich für eine intelligente Zwischenspeicherung, die den Datenfluss optimiert und die Effizienz weiter steigert. Neue Translation Cache-Verbesserungen ermöglichen eine fein abgestimmte Verwaltung großer virtueller Speicherbereiche, was im Kontext riesiger KI-Modelle von entscheidender Bedeutung ist. Die Infinity Fabric-Technologie bleibt das Rückgrat für die Kommunikation zwischen den GPU-Komponenten und ermöglicht durch fatale Bandbreitensteigerung einen reibungslosen Datenaustausch.

Die externen Verbindungsmöglichkeiten wurden mit sieben Infinity Fabric Links weiter ausgebaut, was besonders in Multi-GPU-Systemen Effizienz und Skalierbarkeit garantiert. Auch die Datenkompression und effizientere Verpackungsmethoden tragen zur Maximierung der Übertragungsgeschwindigkeit bei. Die Compute-Architektur selbst hat eine beeindruckende Weiterentwicklung erfahren. Die CDNA4-Compute-Units liefern gegenüber dem Vorgänger MI300 eine Verdopplung der Durchsatzraten bei 16-Bit- und 8-Bit-Operationen. Neue Unterstützung für Mikro-Datenformate wie FP6 und FP4 verbessert die Flexibilität gerade im Bereich KI-Training, während ein neuer Vektor-ALU für 2-Bit-Operationen die Performance bei extrem niedrigpräzisen Anwendungen steigert.

Zusätzlich wurde die lokale Datenfreigabe (LDS) erweitert, was sich positiv auf spezialisierte KI-Operationen wie Softmax und Attention-Mechanismen auswirkt. Auch neue Hardware-Funktionen wie stochastisches Runden und erweiterte logische Operatoren geben Entwicklern mehr Spielraum zur Optimierung komplexer Algorithmen ohne Einbußen bei Stabilität oder Genauigkeit. Obwohl der Fokus klar auf AI-Leistung liegt, unterstützt die MI350-Serie weiterhin hochpräzise FP64-Rechenoperationen, allerdings in einer etwas angepassten Leistungskonfiguration gegenüber dem Vorgänger. Die Adaptive Partitionierung zwischen Speicher und Compute ermöglicht eine flexibilisierte Nutzung als Single Part oder Multi-Part GPU mit bis zu acht unabhängigen Partitionen. Dies eröffnet besonders im Cloud- und Virtualisierungsbereich neue Möglichkeiten, Ressourcen effizient zu verteilen und den Betrieb mehrmandantenfähig zu gestalten.

Bezüglich thermischer Gestaltung bietet AMD zwei Varianten an: die niedrigere TDP-Variante MI350X für luftgekühlte Systeme und die leistungsstärkere MI355X für flüssigkeitsgekühlte Umgebungen, womit sich sowohl Flexibilität als auch höchste Performance-Anforderungen abdecken lassen. Neben den GPUs hat AMD mit der Pollara Networking Lösung eine intelligente Netzwerklösung vorgestellt, die speziell auf die Anforderungen moderner AI-Datenzentren ausgelegt ist. Die programmierbare Architektur des Pollara 400 AI NIC sorgt für maximale Anpassbarkeit an sich wandelnde Workload-Anforderungen und unterstützt innovative Features wie Multicast und selektive Paketbestätigung, um Engpässe zu vermeiden und die Netzwerkbandbreite optimal auszunutzen. Die enge Verzahnung von CPU, GPU und Netzwerktechnologie schafft Synergien, die den gesamten AI-Stack beschleunigen. Die Softwareseite wird durch ROCm 7 abgerundet, das eine massive Steigerung der Trainings- und Inferenzgeschwindigkeit verspricht.

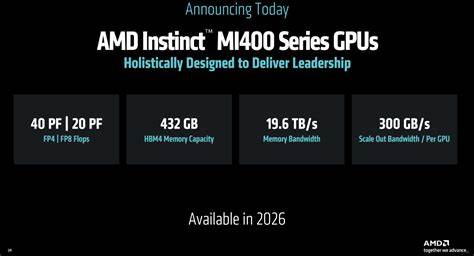

Das offene Ökosystem, das von AMD weiter ausgebaut wird, bietet sowohl großen Unternehmen als auch Entwicklern erweiterten Zugang und Unterstützung für die neuesten KI-Technologien auf unterschiedlichsten Plattformen – von Rechenzentren bis hin zu Endgeräten. Der Blick auf die Zukunft zeigt AMDs ehrgeizige Pläne: Mit dem MI400 erwartet die Industrie 2026 eine GPU, die für das Training extrem großer KI-Modelle optimiert ist. Das dazugehörige Helios-System kombiniert die neuesten EPYC-CPUs, Instinct-GPUs und Pensando-Netzwerkkomponenten zu einem hochintegrierten Rack-Scale-Cluster, der auf offene Standards setzt und mit den neuesten Netzwerkprotokollen wie Ultra Ethernet und Ultra Accelerator Link ausgestattet ist. Die Fortschritte beim MI400 werden durch eine beeindruckende Vergrößerung des HBM-Speichers, extrem hohe FP4- und FP8-Rechenleistung sowie gesteigerte Skalierbarkeit in der Datenkommunikation geprägt. Über das Jahr 2026 hinaus sind bereits weitere Entwicklungen für die MI500-Serie und darüber hinaus in Arbeit, die noch leistungsfähiger, effizienter und skalierbarer sein sollen.

![Show HN: My [sci-fi] book, free forever to listen/download](/images/C96D12E7-0BE5-4F10-B1F4-74B7C0B015C3)