Die rasante Entwicklung im Bereich der Künstlichen Intelligenz (KI) verändert unsere Welt grundlegend. Immer häufiger kommen große Sprachmodelle (Large Language Models, LLMs) wie GPT zum Einsatz, die komplexe Aufgaben in natürlicher Sprache meistern. Dabei stand bislang vor allem die Cloud-Nutzung im Fokus, was oft mit Herausforderungen bezüglich Datenschutz, Sicherheit und Netzwerkabhängigkeit verbunden ist. Vor diesem Hintergrund gewinnt die lokale KI-Verarbeitung auf Endgeräten zunehmend an Bedeutung. Apple-on-device-OpenAI ist ein spannendes Projekt, das genau diesen Trend adressiert: Ein OpenAI-kompatibler API-Server, der die leistungsstarken Apple Foundation Models auf macOS-Geräten lokal verfügbar macht und damit den Zugriff auf KI-Funktionalitäten neu definiert.

Die Vorteile einer lokalen KI-Verarbeitung sind mannigfaltig. Zum einen bleiben sensible Daten dort, wo sie verarbeitet werden – nämlich auf dem eigenen Gerät – und verlassen nicht mehr die eigenen vier Wände. Zum anderen werden Verzögerungen durch langsame oder abgebrochene Internetverbindungen vermieden, was vor allem bei interaktiven Anwendungen von großer Bedeutung ist. Apple-on-device-OpenAI fügt sich nahtlos in dieses Konzept ein, indem es Nutzerinnen und Nutzer in die Lage versetzt, mit den Apple Foundation Models über eine API zu kommunizieren, die vollständig mit der weit verbreiteten OpenAI-Schnittstelle kompatibel ist. Dieses Zusammenspiel sorgt dafür, dass Entwicklerinnen und Entwickler vorhandene OpenAI-kompatible Anwendungen problemlos auf lokale Modelle umstellen können, ohne ihre bestehende Infrastruktur grundlegend verändern zu müssen.

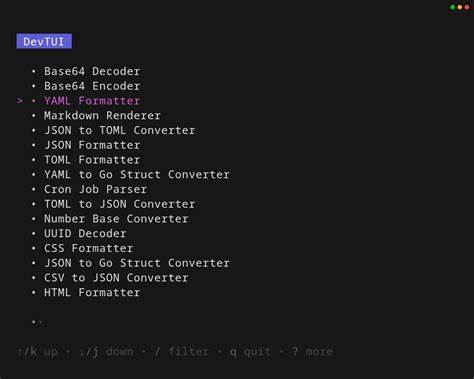

An der Oberfläche zeigt sich dieses Projekt als eine SwiftUI-basierte Applikation für macOS, die einen API-Server hostet. Über diesen Server können Anwenderinnen und Anwender die bekannten Endpunkte der OpenAI API ansprechen, um Chat-Kompletionen in Echtzeit zu nutzen. Die Unterstützung für Streaming-Antworten ermöglicht es, textuelle Ergebnisse live zu empfangen, wie man es beispielsweise von den offiziellen OpenAI-Diensten kennt. Wesentlicher Bestandteil des Projekts ist die Nutzung von Apples Foundation Models, die seit macOS 13 verfügbar sind. Diese sind tief in das Betriebssystem integriert und bieten vielfältige KI-Funktionalitäten, die komplett lokal ausgeführt werden – eine einzigartige Möglichkeit, die den Datenschutz maximiert und gleichzeitig die Latenzen minimiert.

Voraussetzung für den Einsatz von Apple-on-device-OpenAI ist macOS 14 (auch bekannt als Sonoma) beziehungsweise die Beta 2-Version davon, da dort die relevanten KI-Frameworks enthalten sind. Ebenso muss Apple Intelligence in den Systemeinstellungen aktiviert sein, um Zugriff auf die Foundation Models zu erhalten. Für Entwicklerinnen und Entwickler steht der Quellcode auf GitHub bereit, wo sie das Projekt entweder fertig kompiliert herunterladen oder selbst mit Xcode bauen können. Ein besonderer Kniff der Implementierung liegt darin, dass der API-Server als GUI-Bündel ausgeführt wird, nicht als herkömmlicher CLI-Dienst. Grund hierfür sind Apples interne Beschränkungen: Nur Apps mit einer sichtbaren Benutzeroberfläche dürfen uneingeschränkt auf die Foundation Models zugreifen, da sie von Apple als vorrangige Anwendungen eingestuft werden.

Dadurch wird vermieden, dass Hintergrundprozesse mit hoher Rate limitierung belegt sind, was die Performance drastisch reduzieren würde. Dadurch stellt Apple-on-device-OpenAI sicher, dass Nutzerinnen und Nutzer stabil und ohne häufige Unterbrechungen lokal auf KI-Funktionalitäten zugreifen können. Trotz dieser cleveren Lösung können jedoch temporäre Rate Limits auftreten, die unter anderem durch aktuelle Beschränkungen in Apples FoundationModels hervorgerufen werden. In solchen Fällen empfiehlt es sich, den Server einfach neu zu starten, um den Zugriff wieder zu ermöglichen. Die API selbst unterstützt die wichtigsten Parameter der OpenAI Chat Completions Schnittstelle: Modelle können ausgewählt werden, Nachrichten und Kontexte eingegeben werden, die Temperatur zur Steuerung der Kreativität der Antwort kann gesetzt werden, und auch die maximale Token-Anzahl sowie Streaming-Optionen sind verfügbar.

Der Endpunkt /v1/chat/completions bildet hier das Kernstück der Funktionalität. Zusätzlich gibt es health- und status-Endpunkte, mit welchen sich der Zustand des Servers und die Verfügbarkeit der Modelle abfragen lassen. Dieses rundum OpenAI-kompatible Interface erleichtert die Integration enorm und eröffnet neue Wege für die Entwicklergemeinde. Besonders interessant ist Apple-on-device-OpenAI vor allem für Nutzerinnen und Nutzer, die Anwendungen mit erhöhtem Datenschutzbedarf entwickeln oder betreiben möchten. Klassische Szenarien sind etwa medizinische Anwendungen, Finanztools oder persönliche Assistenten, bei denen keine Daten das Gerät verlassen sollen.

Ebenso profitieren Entwickler im Prototyping und in der Forschung von der einfachen und günstigen Möglichkeit, leistungsfähige KI-Modelle ohne Cloud-Abhängigkeiten einzusetzen. Für den Entwickleralltag sind außerdem test_server.py und andere Hilfsmittel enthalten, die umfassende Testabdeckung ermöglichen. So lassen sich Mehrfachanwenderkonversationen, Mehrsprachigkeit und Streaming-Verhalten einwandfrei prüfen. Auch die Kompatibilität mit dem offiziellen OpenAI Python SDK wird demonstriert, was den Einstieg deutlich vereinfacht.

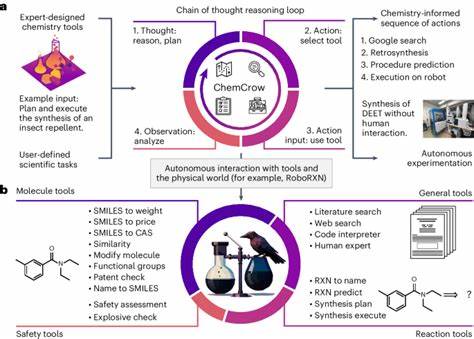

Die Open-Source-Natur des Projekts motiviert außerdem zu Anpassungen und Erweiterungen. Besonders spannend ist die Planung, sogenannte Tool-Using-Funktionalität zu implementieren. Damit könnten die Foundation Models über kontextabhängige Aufrufe mit externen Werkzeugen interagieren, was die KI-Fähigkeiten massiv ausbaut. Die Zukunft sieht also vielversprechend aus: Lokale KI auf Apple-Geräten mit vertrauter API, die Entwicklerinnen und Entwickler auf der ganzen Welt begeistert. Im Vergleich zu Cloud-Diensten reduzieren sich die Betriebskosten und Sicherheitsrisiken signifikant.

Gleichzeitig gewinnt man mehr Unabhängigkeit von externen Anbietern und deren Preisgestaltung. Zusammenfassend ist Apple-on-device-OpenAI ein Meilenstein auf dem Weg zu dezentralisierten, benutzerzentrierten KI-Lösungen. Das Projekt vereint die Leistungsfähigkeit von Apples Foundation Models mit der Kompatibilität zu OpenAI, was nicht nur technische Innovation bedeutet, sondern auch ein Signal für mehr Datenschutz, Kontrolle und Flexibilität im Umgang mit KI. Für macOS-Anwender ist das Projekt eine einladende Einladung, die Vorteile der KI lokal und ohne Abhängigkeit von Cloud-Infrastrukturen zu nutzen – und dabei dennoch mit den bekannten Tools und Standards zu arbeiten. Wer sich für Künstliche Intelligenz interessiert und gleichzeitig den Schutz persönlicher Daten nicht vernachlässigen möchte, sollte Apple-on-device-OpenAI definitiv im Blick behalten.

Es zeigt eindrucksvoll, dass die Zukunft der KI nicht nur in der Cloud stattfindet, sondern auch direkt auf den Geräten vor unserer Nase aktiv gestaltet werden kann.