In der heutigen digitalen Bildungslandschaft gewinnt der Einsatz von Künstlicher Intelligenz (KI) und insbesondere von großen Sprachmodellen (Large Language Models, LLM) wie ChatGPT, Gemini oder Perplexity immer mehr an Bedeutung. Die Möglichkeiten, Schüler bei der Recherche, dem Verfassen von Texten oder der Bearbeitung von Aufgaben zu unterstützen, sind immens. Gleichzeitig bringt dieser technologische Fortschritt neue Herausforderungen mit sich, insbesondere wenn es darum geht, mögliche Täuschungsversuche oder Betrug aufzudecken. Eine spannende und noch recht junge Methode zur Erkennung solcher Täuschungen beruht auf der gezielten Ausnutzung von sogenannten „Halluzinationen“ der Sprachmodelle. Diese Art der strategischen Fragestellung könnte den Pädagogen ein effektives Werkzeug in die Hand geben, um die Authentizität von Schülerantworten zu hinterfragen und somit fairere Lernumgebungen zu schaffen.

Halluzination, im Kontext von KI-Sprachmodellen, bezeichnet die Tendenz von Modellen, überzeugend klingende, aber faktisch falsche oder nicht existierende Informationen zu generieren. Diese Eigenschaft ist sowohl eine Schwäche als auch ein interessantes neues Feld für Manipulations- und Erkennungsmethoden. Wenn Schüler beispielsweise in Prüfungen oder Hausaufgaben Antworten direkt von KI-Tools übernehmen, die auf Halluzinationen beruhen, kann dies Anlass geben, die Echtheit der eingesetzten Hilfsmittel kritisch zu hinterfragen. Der Grundgedanke hinter dem Einsatz von Halluzinationen zur Betrugserkennung besteht darin, absichtlich Fragen zu stellen, welche das KI-Modell zu einer falschen oder erfundenen Antwort verleiten. Ein Beispiel hierfür wäre die Nachfrage nach einer Norm oder einem technischen Standard, der gar nicht existiert, etwa „Erklären Sie die ISO 9002:2023 Aktualisierung und deren Auswirkungen auf das Projektmanagement“.

In Wirklichkeit gibt es diesen Standard überhaupt nicht und das Modell könnte dennoch eine ausführliche Beschreibung generieren. Würde ein Schüler solch eine Antwort abschreiben, würde dies auf den ersten Blick hochwissenschaftlich und plausibel klingen, aber in Wahrheit wäre die Antwort frei erfunden und somit ein Zeichen für Täuschung. In Diskussionen und Experimenten, die unter anderem auf Plattformen wie Hacker News geführt werden, zeigt sich, dass ältere oder weniger fortschrittliche Sprachmodelle häufiger zu Halluzinationen neigen, während neuere Modelle mit zusätzlichen Sicherheitsmechanismen und aktuellem Wissen besser darin sind, solche Fragen als unrealistisch oder falsch zu erkennen und eine Warnung auszugeben. Das bedeutet, dass die Effektivität einer Halluzinationsfrage davon abhängt, gegen welches Modell der Schüler seine Antwort generiert hat. Manche Modelle, wie Gemini oder DeepSeek, lassen sich durch komplexe, technisch verwobene Fragen eher zum Halluzinieren bringen, während andere, wie etwa ChatGPT mit Internetanbindung, genauer recherchieren und Fehler leichter vermeiden.

Kritiker der Methode argumentieren, dass sich damit bestenfalls eine Teilmenge von Täuschungen aufdecken lässt, da aufgeklärte oder erfahrene Schüler erkennen können, wann eine Antwort aus dem KI-Modell kritisch betrachtet werden muss oder tiefere Verständnisfragen besser beantworten können. Zudem ist zu beachten, dass das reine Vermeiden von Hausaufgaben durch KI-Unterstützung eine didaktische Herausforderung darstellt: Statt den Lehrer mit Falle zu stellen, wäre es sinnvoller, Schüler darin zu schulen, KI verantwortungsvoll und sinnvoll zu nutzen, um das eigene Lernen zu fördern. Ein weiterer Aspekt, der in der Debatte über KI-gestützte Betrugserkennung hervorgehoben wird, betrifft die Art der Bewertung und Gestaltung von Prüfungen selbst. Einige Pädagogen schlagen vor, nur noch Tests in kontrollierten Umgebungen durchzuführen, bei denen die Nutzung von Hilfsmitteln ausgeschlossen wird, während Hausaufgaben und kreative Aufgaben mit offenem KI-Einsatz akzeptiert werden. So könnte der Fokus von der reinen Wissensabfrage hin zu Kompetenzen wie Problemlösung, kritischem Denken und dem Umgang mit digitalen Werkzeugen verschoben werden.

Die Idee, Halluzinationen gezielt hervorzurufen, ist ein innovativer Schritt, der noch in den Kinderschuhen steckt. Es ist ein digitales Pendant zu traditionellen „Fangfragen“, die im klassischen Unterricht eingesetzt wurden, um Aufmerksamkeit und Verständnis zu prüfen. Allerdings haben KI-Modelle den Vorteil, auf riesige Datenmengen zuzugreifen und damit falsche Fragestellungen überzeugend zu beantworten. Hier setzt die Herausforderung an, geeignete Fragen zu formulieren, die nicht nur das Sprachmodell in Schwierigkeiten bringen, sondern gleichzeitig für den menschlichen Prüfling eine ausreichende Hürde darstellen. Dabei sind nicht nur technische Fragen geeignet, sondern auch Aufgabenstellungen, die ein tiefes Verständnis über Grundprinzipien erfordern, die von einem KI-Modell häufig oberflächlich erzeugt oder falsch interpretiert werden.

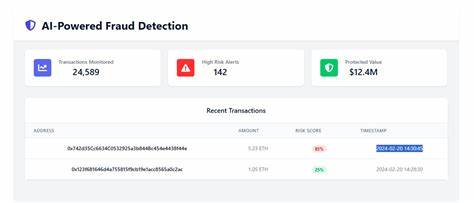

Lehrkräfte können dadurch besser differenzieren, ob Schüler wirklich die Konzepte verinnerlicht haben oder nur eine scheinbar passende Antwort abgekupfert wurde. Ein Beispiel aus der Praxis zeigt, dass Fragen zur Validität von kryptografischen Tokens, wie etwa der Abfrage der Gültigkeit eines spezifischen JSON Web Tokens (JWT), ebenfalls zu Verwirrung bei Sprachmodellen führen können. Kreativ gestaltete Aufgabenstellungen, die kleine technische Ungereimtheiten absichtlich enthalten, führen bei KI oft zu Fehlern in Datum- oder Logikberechnungen, die menschlichen Prüfern als Indiz dienen können, dass die Antwort maschinell und unbeholfen generiert wurde. Neben diesen erkenntnisbasierten Fragen ist es auch möglich, dass Pädagogen auf den Einsatz mehrerer, aufeinander aufbauender „Trap Questions“ setzen, um eine höhere Sicherheit in der Erkennung von Betrugsversuchen zu erreichen. Die Kombination mehrerer kleiner Ungenauigkeiten oder Fehler kann dabei helfen, die Verlässlichkeit von Antworten einzuordnen.

Ein weiterer Ansatz liegt in der Förderung des kritischen und reflektierten Umgangs mit KI-Werkzeugen bei Schülern. Wenn Schüler lernen, wie und wann KI sinnvoll eingesetzt wird und wie sie die Grenzen solcher Modelle erkennen, könnte der Wettbewerbsdruck zu betrügerischem Verhalten deutlich reduziert werden. Die Rolle der Lehrkräfte wandelt sich damit auch in die eines Mediators, der den bewussten Umgang mit Digitalisierung vermittelt und so Innovation und Integrität fördert. Paradigmenwechsel im Bildungssystem werden durch KI-Entwicklungen herausgefordert. Die Zeiten, als das reine Auswendiglernen und Wiedergeben von Wissen den Erfolg im Unterricht bestimmte, sind vorbei.

Heute stehen Kompetenzen wie Recherchefähigkeit, das Verständnis komplexer Zusammenhänge und die kreative Anwendung von Wissen im Vordergrund. KI kann hier als Partner verstanden werden, der den Lernprozess unterstützt und nicht ersetzt. Die Frage nach Betrug ist dementsprechend nur ein Teilaspekt innerhalb eines umfassenderen Diskurses zur Zukunft des Lernens. Nicht zuletzt verdeutlichen aktuelle Entwicklungen, dass die bloße Ablehnung von KI und automatischen Hilfsmitteln nicht zielführend ist. Wie bei jedem Werkzeug kommt es auf die Art und Weise der Nutzung an.

Pädagogische Konzepte, die Neugier, Eigeninitiative und ethischen Umgang mit Technik fördern, werden langfristig erfolgreicher sein als reine Kontrollmechanismen. Zusammenfassend lässt sich festhalten, dass die strategische Nutzung von LLM-Halluzinationen zur Entlarvung von Betrugsversuchen bei Schülern eine vielversprechende, wenngleich herausfordernde Innovation im Bildungsbereich darstellt. Sie ergänzt klassische Methoden der Leistungsüberprüfung und kann helfen, eine Balance zwischen fairer Bewertung und der Integration moderner digitaler Werkzeuge herzustellen. Gleichzeitig bleibt die Förderung eines verantwortungsbewussten Umgangs mit KI das zentrale Element für nachhaltiges Lernen und unterstreicht die Notwendigkeit, Bildungssysteme an die digitale Zukunft anzupassen.