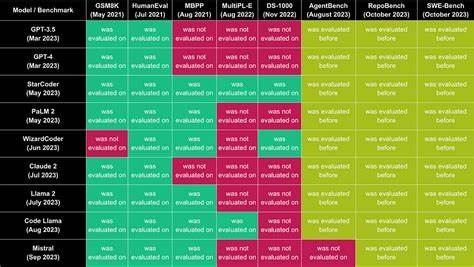

Die Fähigkeit von Large Language Models (LLMs), aus natürlichsprachlichen Anfragen präzise und effiziente SQL-Abfragen zu generieren, gewinnt in der heutigen datengetriebenen Welt zunehmend an Bedeutung. Unternehmen und Entwickler stehen vor der Herausforderung, große Datenmengen schnell und zuverlässig auszuwerten, ohne selbst komplexe SQL-Kenntnisse besitzen zu müssen. Aktuelle Fortschritte im Bereich der KI und maschinellen Sprachverarbeitung bringen innovative Werkzeuge hervor, die genau dies ermöglichen. Doch wie gut sind diese Modelle wirklich, wenn es darum geht, aus frei formulierten Texten korrekte und leistungsfähige Datenbankabfragen zu erzeugen? Um diese Frage zu beantworten, wurden im Rahmen des LLM SQL Generation Benchmarks verschiedene Modelle anhand eines umfangreichen realen Datensatzes evaluiert. Dabei stand nicht nur die Genauigkeit der generierten SQL-Abfragen im Fokus, sondern auch deren Effizienz hinsichtlich Ausführungszeit und Ressourcenverbrauch.

Die Grundlage des Benchmarks bildete ein Datensatz mit rund 200 Millionen Datensätzen, extrahiert aus dem GH Archive, welcher auf der Plattform Tinybird bereitgestellt wurde. Mit insgesamt 50 sorgfältig ausgewählten natürlichsprachlichen Eingabeaufforderungen wurde geprüft, wie gut verschiedene populäre LLMs SQL-Skripte erstellen konnten, die den jeweiligen Fragen entsprechen. Die Auswahl der Prompts orientierte sich an realen Anwendungsfällen, um die Leistungsfähigkeit unter praxisnahen Bedingungen zu testen. Die Auswertung umfasste mehrere Perspektiven: Zum einen die Genauigkeit, also wie exakt die vom Modell erzeugte SQL-Abfrage die jeweilige Anfrage abbildete. Zum anderen wurde die Effizienz der Abfragen bewertet, insbesondere hinsichtlich der benötigten Rechenzeit, Datenmenge, die beim Ausführen der Abfrage gelesen wurde, und die durchschnittliche Latenz der Ausführung.

Im Vergleich zum menschlichen Benchmark, der als Referenz für die optimale Genauigkeit und Effizienz diente, konnten die besten Modelle bemerkenswerte Resultate erzielen. Das Modell „claude-opus-4“ von Anthropics führte die Rangliste mit einem Score von 79,04 an und erreichte eine Genauigkeit von 64,07 %. Das bemerkenswerte daran ist, dass es mit einer Latenzzeit von etwa 352 Millisekunden arbeitete und dabei deutlich weniger Daten las als die menschliche Referenzabfrage – nur rund 112 Megabyte verglichen mit über 750 Megabyte des Menschen. Auch weitere Modelle von OpenAI und Google erzielten im Benchmark solide Werte, wobei die Scores in der Regel zwischen 70 und 80 Prozent lagen. Diese Ergebnisse zeigen eindeutig, dass moderne LLMs schon nah an menschliche Leistungen herankommen können – zumindest bei der Balance zwischen Genauigkeit und Effizienz.

Ein interessantes Detail im Benchmark ist die Betrachtung der durchschnittlichen Anzahl von Versuchen, die ein Modell benötigt, um die korrekte SQL-Abfrage zu generieren. Hier schnitten die Spitzenreiter mit geringeren Wiederholungen deutlich besser ab, was auf eine stabile und verlässliche Fähigkeit hinweist. Einige Modelle benötigten im Durchschnitt nur knapp über einem Versuch, was praktisch bedeutet, dass die erste generierte Abfrage häufig bereits korrekt war. Andere hingegen zeigten mehr Schwankungen und mussten mehrmals nachbessern. Diese Kennzahl ist wichtig für den praktischen Einsatz, da eine höhere Anzahl an Versuchen die Systemlatenz und damit die Nutzerzufriedenheit negativ beeinflussen kann.

Auch die Effizienz der generierten Abfragen ist von großer Bedeutung. Weniger gelesene Datenmengen und geringere Latenzzeiten sparen Ressourcen und reduzieren Kosten, gerade in Cloud-Umgebungen, in denen Datenzugriffe abgerechnet werden. Modelle wie „claude-opus-4“ konnten hier besonders punkten, da sie effizientere SQL-Abfragen generierten, die weniger Daten durchsuchten. Dies erhöht nicht nur die Geschwindigkeit, sondern führt auch zu umweltfreundlicheren IT-Operationen durch reduzierten Energieverbrauch. Die Analyse zeigt zudem, dass höhere Genauigkeiten nicht immer mit der besten Effizienz einhergehen.

Einige Modelle erzielten zwar hohe Genauigkeitswerte, lasen aber beträchtlich größere Datenmengen oder benötigten längere Verarbeitungszeiten. Das unterstreicht die Komplexität des Problems, bei dem ein Gleichgewicht zwischen korrekter Abfrage, Performance und Ressourcenverbrauch gefunden werden muss. Es gelingt nicht allen LLMs gleichermaßen, in allen Kategorien auszuragen. Ein weiterer Aspekt, der im Benchmark sichtbar wird, sind die unterschiedlichen Ansätze der Anbieter beim Umgang mit der SQL-Generierung. Während einige Modelle ausgesprochen präzise und stark auf Effizienz optimiert sind, fokussieren andere mehr die Vollständigkeit und Korrektheit der Datenextraktion.

Diese Unterschiede spiegeln sich auch in den eingesetzten Trainingsdaten und Modellarchitekturen wider, was zeigt, dass langfristige Fortschritte auch von der Qualität und Breite der trainierten Datensätze abhängig sind. Für Entwickler, Datenanalysten und Unternehmen eröffnen solche Benchmark-Ergebnisse wertvolle Erkenntnisse für die Auswahl geeigneter KI-gestützter Tools. Wer auf der Suche nach einer integrierten Lösung zur Umwandlung von Sprache in Datenbankabfragen ist, kann auf Basis der Benchmark-Auswertung gezielter entscheiden, welches Modell den eigenen Anforderungen in puncto Genauigkeit, Reaktionszeit und Effizienz am besten gerecht wird. Dies ist insbesondere in Branchen mit hohen Datenaufkommen und komplexen Datenstrukturen wichtig, beispielsweise im E-Commerce, Finanzsektor oder bei IoT-Anwendungen. Neben den statischen Ergebnissen liefert der Benchmark auch wichtige Impulse für zukünftige Forschung und Entwicklung.

Die Lücken zwischen KI-generierten und durch Menschen erstellten Abfragen wollen Entwickler durch verfeinerte Algorithmen, besseres Training und innovative Feedbackschleifen weiter schließen. Die Integration fortgeschrittener Techniken wie Few-Shot-Learning oder Reinforcement Learning könnte die Modelle noch präziser machen und die Chance erhöhen, die generierten Abfragen in Echtzeit zu optimieren. Auch der Umgang mit komplexeren SQL-Strukturen und verschachtelten Abfragen stellt eine interessante Herausforderung dar. Der LLM SQL Generation Benchmark demonstriert eindrucksvoll den aktuellen Stand der Technik und zeigt zugleich, dass das Feld der automatisierten SQL-Generierung dynamisch in Bewegung ist. Die Möglichkeit, große Mengen an Daten schnell und genau auszuwerten, ohne manuelle SQL-Fachkenntnisse, schafft enorme Potenziale für Unternehmen und IT-Teams.

Zusätzlich sorgt die stetige Verbesserung der Effizienz für nachhaltige Kosten- und Ressourcenersparnisse. Zukünftig lässt sich erwarten, dass solche Benchmarks zur Standardisierung und Qualifizierung von KI-Modellen in Datenbankanwendungen beitragen werden. Mögliche Erweiterungen könnten neben größeren Datensätzen auch weitere Datenbanktypen und SQL-Varianten umfassen. Ebenso relevant werden ethische und sicherheitstechnische Aspekte sein, um beispielsweise den Missbrauch oder Fehlerquellen bei der automatischen SQL-Generierung zu minimieren. Insgesamt bietet der LLM SQL Generation Benchmark eine wertvolle Grundlage, um die Fähigkeiten von KI-Modellen praxisnah zu überprüfen und weiter zu verbessern.

Für alle, die mit Daten arbeiten, ist das Verständnis und der gezielte Einsatz solcher Tools eine Schlüsselkompetenz, um den Weg in die Zukunft der datenbasierten Entscheidungsfindung erfolgreich zu gestalten. Die optimale Balance zwischen Genauigkeit, Effizienz und Nutzerfreundlichkeit wird dabei den entscheidenden Wettbewerbsvorteil im Umgang mit Big Data und KI-basierten Lösungen ausmachen.