Seit dem Aufkommen der sogenannten „Age of AI“ ab Ende 2022 hat sich ein immer stärker werdendes Paradoxon rund um den Einsatz von KI-gestützten Programmierhilfen herauskristallisiert. Auf der einen Seite berichten einzelne Entwickler von einer Verbesserung ihrer Produktivität dank intelligenter Code-Unterstützung. Auf der anderen Seite zeigen empirische Daten, dass Teams, die diese Tools vermehrt einsetzen, oft negative Auswirkungen auf wichtige Kennzahlen wie Durchsatz bei der Lieferung und Release-Stabilität erleben. Dieser scheinbare Widerspruch lässt sich jedoch durch einen systematischen Blick auf den gesamten Entwicklungsprozess auflösen. Man könnte sagen: Es geht um das System, nicht um einzelne Aktionen oder Werkzeuge.

Ein Grund für dieses Paradoxon liegt darin, dass viele Entwickler bei der Bewertung ihrer Produktivität vor allem den reinen Akt des Codierens betrachten. Sie sehen, wie schnell sie mit KI-Hilfe funktionierenden Code generieren können, und empfinden das als Fortschritt. Was häufig dabei unbeachtet bleibt, sind die nachgelagerten Prozesse wie Testing, Code-Review, Merging, Deployment und Betrieb. Wenn diese Phasen jedoch sequentiell und in größeren Chargen abgearbeitet werden – das klassische Wasserfallmodell oder ähnlich batch-orientierte Ansätze – führen schnell größere Änderungspakete zu erheblichen Engpässen und Verzögerungen. Mehr Code in kürzerer Zeit zu schreiben bedeutet oft auch, dass dementsprechend mehr getestet, überprüft und integriert werden muss.

Dadurch erhöhen sich die Fehleranfälligkeit und der Aufwand für Refaktorierungen und Fehlerbehebungen. In einem solchen Workflow sind „A.I.“-gestützte Code-Generatoren also ein Beispiel für lokale Optimierung zulasten des gesamten Systems. Die Folge sind größere Aufwände in den nachgelagerten Phasen, was sich negativ auf die Produktqualität und Pünktlichkeit auswirkt.

Anders sieht die Situation aus, wenn Teams in kleinen Iterationen arbeiten. Veränderungen werden unmittelbar nach dem Schreiben getestet, überprüft, überarbeitet und dann ins Hauptprojekt integriert. Dieser kontinuierliche Entwicklungsansatz, der Elemente wie Continuous Integration, Continuous Testing und kontinuierliche Code-Reviews beinhaltet, reduziert Engpässe und ermöglicht eine stabilere und gleichmäßigere Auslieferung. Die Daten der sogenannten DORA-Studien bestätigen diesen Zusammenhang eindrucksvoll: Teams mit kurzen Lead-Zeiten und hoher Release-Stabilität setzen auf geringe Batchgrößen und kontinuierliche Arbeitsschritte. In diesem Kontext fallen die Auswirkungen von KI-Assistenzwerkzeugen deutlich geringer aus oder sind sogar marginal, was zeigt, wie wichtig ein ganzheitliches Systemverständnis ist.

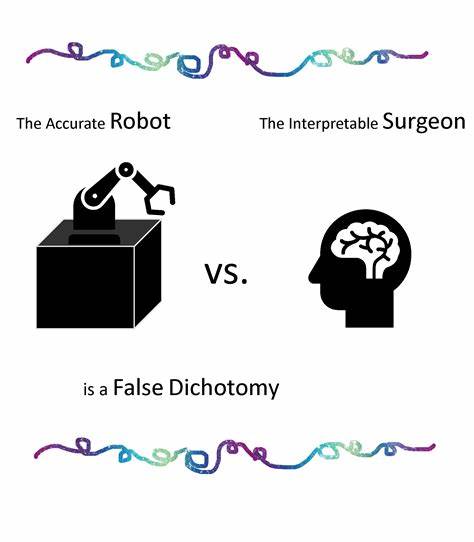

Vor dem Hintergrund dieser Erkenntnisse drängt sich die Frage auf, ob KI-Modelle derzeit überhaupt an der richtigen Stelle eingesetzt werden. Der Fokus liegt oft auf der Steigerung der individuellen Entwicklerproduktivität durch automatische Code-Generierung, doch eigentliche Systemengpässe und die Komplexität des Gesamtprozesses bleiben unberücksichtigt. Ein weitaus erfolgversprechenderer Ansatz wäre es, KI darauf zu trainieren, systemweite Flaschenhälse zu erkennen und zu reduzieren. Beispielsweise könnten smarte Linters oder KI-gestützte Code-Review-Tools die Qualitätssicherung verbessern, indem sie Fehler frühzeitig und automatisch aufdecken und so den manuellen Review-Aufwand verringern. Das Konzept von Paarprogrammierung oder Ensemble-Programmierung zeigt, dass menschliche Zusammenarbeit aktuell oft effektiver ist als reine automatisierte Analysen.

Linguistische Modelle oder statistische Werkzeuge haben bisher kaum gezeigt, dass sie erfahrene menschliche Prüfer in der Tiefe ersetzen könnten. Noch weiter gedacht könnte KI im Idealfall auf Daten aus dem gesamten Entwicklungszyklus zugreifen – von der Produktstrategie über Design, Kodierung und Testing bis hin zur Produktion und Kundenbetreuung. Ein System, das etwa anhand eines UI-Wireframes vorhersagen kann, wie viele Support-Anfragen dieses Design wahrscheinlich generiert, oder dass es Fehleranfälligkeiten und Ausfallzeiten eines bestimmten Softwaremoduls abschätzen kann, würde nicht nur den Entwicklungsprozess optimieren. Es könnte auch von vornherein Risiken mindern und Kosten reduzieren. Derartige prädiktive Modelle sind in anderen Branchen wie der Elektronikentwicklung schon Realität.

Dort können statistische Modelle die Lebensdauer und Zuverlässigkeit von Bauteilen genau prognostizieren. Im Softwarebereich scheitert eine vergleichbare Umsetzung oftmals an der Vielfalt und Unübersichtlichkeit von Datenquellen sowie fehlenden einheitlichen Standardformaten. Ohne eine gemeinsame Grundlage für Datenaustausch wird die Aggregation und Analyse großer Mengen heterogener Daten erschwert. Trotz dieser Herausforderungen bietet die Zukunft großes Potenzial. Wären wir fähig, eine Schnittstellenarchitektur zu entwickeln, die unterschiedliche Tools und Plattformen miteinander verbindet, könnten verborgene Muster in den komplexen Prozessdaten erkannt werden.

So könnte KI als übergreifende Systemintelligenz wirken und dazu beitragen, Engpässe gezielt zu beseitigen und den gesamten Workflow zu verbessern. Der wesentliche Punkt ist: KI darf nicht nur als Werkzeug zur lokalen Effizienzsteigerung einzelner Entwickler betrachtet werden. Ohne systemisches Denken kann das vermeintlich schnelle Voranschreiten in der Codierung nachgelagerte Prozessschritte ausbremsen und den Fortschritt insgesamt behindern. Ein nachhaltiger, produktiver Einsatz erfordert eine ganzheitliche Perspektive, bei der Technik, Prozess und Organisation ineinandergreifen. Bis eine solche umfassende System-KI Realität wird, erweist sich bewährte Praxis als das stabilste Fundament.

Kontinuierliche Integration, Testautomatisierung, laufende Code-Reviews im Kleinformat und schnelle Iterationen schaffen ein System, das flexibler und weniger anfällig für Rückschläge ist. In solchen Umgebungen bringt auch der Einsatz von KI-Assistenzmitteln mehr Nutzen, weil sie bestehende Prozesse unterstützen statt sie durch größere Zwischenschritte zu belasten. Für Teams, die ihre Abläufe optimieren und mit modernen Praktiken den Ausstoß qualitativ hochwertiger Software steigern möchten, ist daher ein systemischer Ansatz der Schlüssel. Schulungen und Mentoring in diesen technischen Basiskompetenzen zahlen sich aus, egal ob mit oder ohne KI-Werkzeuge. Abschließend lässt sich zusammenfassen, dass das KI-Paradox in der Softwareentwicklung weniger auf die Technik oder die Qualität einzelner Tools zurückzuführen ist.

Vielmehr zeigt es die Bedeutung der Gesamtarchitektur und Arbeitsweise eines Teams und seiner Prozesse. Die Integration neuer Technologien sollte immer mit Blick auf das große Ganze erfolgen – nur so lassen sich Produktivitätsgewinne nachhaltig realisieren und echte Innovationen vorantreiben.