FPV-Drohnenrennen erleben eine außergewöhnliche technologische Revolution, die nicht nur den Sport, sondern auch die Robotik und künstliche Intelligenz nachhaltig verändert. Die Entwicklung von autonomen Drohnensystemen, die nun menschlichen Weltmeistern ebenbürtig sind, markiert einen Meilenstein auf dem Gebiet hochagiler mobiler Roboter. Im Jahr 2023 präsentierte ein Forscherteam unter Leitung von Elia Kaufmann und Davide Scaramuzza eine autonome Drohne namens Swift, die bei realen Kopf-an-Kopf-Rennen gegen renommierte Profisiege errang und dabei mehrfach als Sieger hervorging. Mit einer Rekordfahrzeit demonstrierte Swift, dass Deep Reinforcement Learning (Deep RL) den Schlüssel zur Erreichung von Spitzenleistungen im physischen Wettbewerbsumfeld darstellt. Doch wie genau funktioniert solch ein System, und welche Technologien machen dies möglich? Im Folgenden führen wir durch die Hintergründe, Herausforderungen sowie durch die Funktionsweise und Bedeutung dieser wegweisenden Arbeit.

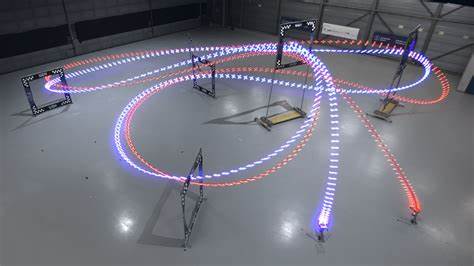

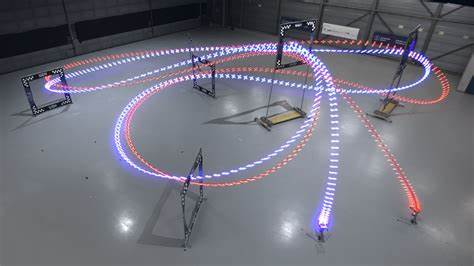

FPV-Drohnenrennen: Ein Überblick Das sogenannte First-Person-View-Drohnenrennen ist eine faszinierende Kombination aus Geschwindigkeit, Geschick und technischer Raffinesse. Dabei nehmen Piloten mittels spezieller Brillen die Perspektive ihrer Drohnen ein und navigieren diese durch komplexe dreidimensionale Rennstrecken, oft mit engen Kurven und herausfordernden Manövern. Die verwendeten Drohnen, meist kleine Quadcopter, sind extrem agil und können Beschleunigungen erleben, die das Vielfache ihres Eigengewichts ausmachen – Geschwindigkeiten von über 100 Kilometern pro Stunde sind keine Seltenheit. Diese rasante, präzise Steuerung erfordert eine Kombination aus schneller visueller Verarbeitung, präziser Flugsteuerung und taktischem Rennverständnis. Professionelle Piloten trainieren oft monatelang, um den Anforderungen der Rennen gerecht zu werden.

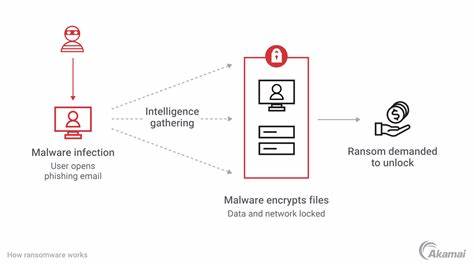

Die Herausforderung, eine autonome Maschine zu entwickeln, die menschliche Weltklasseleistungen erreicht, ist immens – denn eine solche Drohne muss auf Basis der Informationen von an Bord befindlichen Kameras und Sensoren Geschwindigkeit und Position auswerten, Flugbahnen antizipieren und mit minimaler Latenz steuern. Die Grenzen traditioneller Methoden Frühere Ansätze zur autonomen Drohnensteuerung setzten häufig auf die Kombination aus präzisen externen Motion-Capture-Systemen und klassischen Kontrollmechanismen wie Trajektorienplanung oder modellprädiktiver Regelung (MPC). Obwohl solche Systeme in idealisierten oder stark reglementierten Umgebungen Leistung zeigten, waren sie in realen, dynamischen Rennsituationen mit unvollständiger Datenlage und starker Wahrnehmungsrauschigkeit oftmals unterlegen. Ein weiterer Nachteil traditioneller Verfahren ist ihre starke Abhängigkeit von genauer Zustandsschätzung und Umgebungsmodellwissen. Kleine Fehler in der Schätzung von Position oder Geschwindigkeit können zu Kollisionen oder suboptimalem Flugverhalten führen.

Darüber hinaus sind vorgeplante Flugpfade aufgrund unvorhersehbarer Gegnerbewegungen und Umgebungsvariationen schwer anzupassen, was Einschränkungen in der Flexibilität bedeutet. Deep Reinforcement Learning als Game Changer Deep Reinforcement Learning ist eine Form des maschinellen Lernens, bei der ein Agent durch Interaktionen mit seiner Umgebung lernt, eine Aufgabe optimal zu lösen, basierend auf einem Belohnungssignal. Im Kontext von Drohnenrennen bedeutet dies, dass die Steuerungsstrategie direkt aus simulierten Rennen erlernt wird, wobei Drohnen lernen, durch Belohnung Progress bei der Streckenabdeckung und Wahrnehmungsqualität zu maximieren. Swift, das autonome System von Kaufmann et al., kombiniert eine Zwei-Modularchitektur: ein Perzeptionssystem, das hochdimensionale visuelle und inertiale Sensordaten zu einer kompakten Zustandsschätzung verarbeitet, und eine Kontrollstrategie, die aus diesem Zustand direkte Steuerrichtbefehle generiert.

Kernstück ist ein Feedforward-Neuronales Netz, das in einer realistisch augmentierten Simulation mit tiefem Reinforcement Learning trainiert wurde. Besondere Bedeutung kommt dabei der Überbrückung der sogenannten Sim-to-Real-Lücke zu. Die Unterschiede zwischen simulierten und realen Flugdynamiken sowie der daraus resultierende Wahrnehmungsrauschen können zu gravierendem Leistungsverlust führen. Um dies zu vermeiden, integrierte das Team empirisch ermittelte Modelle der sensoriellen und dynamischen Residuen in die Simulation und verfeinerte die Steuerungspolitik anhand von kleinem realweltlichem Datensatz. So wurde die Robustheit gegen reale Umgebungsbedingungen erheblich erhöht.

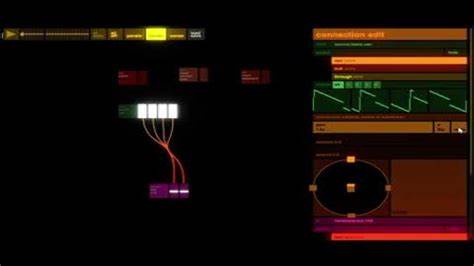

Technische Umsetzung: Perzeption und Kontrolle Die Wahrnehmung der Drohne basiert auf einer Kombination aus visueller Trägheitsnavigation (Visual-Inertial Odometry, VIO) und einer spezialisierten Gate-Erkennung mittels neuronaler Netze. Die VIO ermöglicht eine metrische Schätzung von Position, Geschwindigkeit und Orientierung auf Grundlage von Kamera- und Inertialsensor-Daten. Die Gate-Erkennung gliedert die Rennstrecke in definierte Landmarken, deren Sichtbarkeit der Drohne eine kontinuierliche Korrektur der Drift in der Navigation erlaubt. Eine Kalman-Filterung kombiniert beide Informationsquellen zu einer präzisen Zustandsschätzung, die der Steuerungsstrategie als Eingabe dient. Der Steuerungsalgorithmus, trainiert mittels Proximal Policy Optimization – einem bewährten Deep RL-Algorithmus –, nimmt diese Zustandsinformation auf und generiert in Echtzeit Steuerbefehle für die kollektive Schubkraft und Drehgeschwindigkeiten der Drohne.

Der gesamte Regelkreislauf funktioniert onboard, ohne externe Infrastruktur, was die Autonomie des Systems gewährleistet. Bei der Simulation der Drohnendynamik kommen physikalisch fundierte Modelle zum Einsatz, die sowohl motorische als auch aerodynamische Effekte berücksichtigen. Zusätzlich bilden ein Batterie- und ESC-Modell die Leistungselektronik akkurat nach, was für realistische Trainingsbedingungen essenziell ist. Leistung im Wettbewerb: Kopf-an-Kopf-Rennen mit Weltmeistern Die Evaluierung des Swift-Systems erfolgte anhand eines eigens präparierten 75 Meter langen Parcours mit sieben charakteristischen Toren, entworfen von einem professionellen FPV-Piloten. Swift trat in direkten Rennen gegen drei menschliche Weltmeister an, allesamt erfahrene und hochdekorierte Piloten dieser Sportart.

Die Ergebnisse sprechen für sich: Swift gewann die Mehrzahl der Rennen und erreichte zeitweise die schnellste je für diesen Kurs verzeichnete Rundenzeit mit einem Vorsprung von bis zu einer halben Sekunde gegenüber dem schnellsten menschlichen Piloten. Besonders in anspruchsvollen Manövern wie dem sogenannten "Split-S" zeigte die autonome Drohne überlegen enge Wendemanöver bei hoher Geschwindigkeit. Interessanterweise zeigte Swift auch signifikante Vorteile beim Start, indem es eine um etwa 120 Millisekunden schnellere Reaktionszeit als die menschlichen Konkurrenten aufwies. Das erklärt sich zum Teil durch die geringe Latenz in der Verarbeitung der Steuersignale, die wesentlich unter der Reaktionszeit von erfahrenen Piloten liegt. Nichtsdestotrotz weist das System, anders als Menschen, kein taktisches Verhalten auf, das Risiko und Geschwindigkeit in Abhängigkeit vom Rennverlauf abwägt.

Vorteile und Herausforderungen gegenüber menschlichen Piloten Das autonome System bietet einige strukturelle Vorteile gegenüber menschlichen Piloten. Ein signifikanter Punkt ist die Nutzung von Inertialsensorik, die Beschleunigungen und Rotationsraten mit hoher Genauigkeit erfasst – vergleichbar mit dem menschlichen Gleichgewichtsorgan, jedoch beim Menschen während FPV-Rennen nicht verfügbar, da der Pilot nicht physisch im Fahrzeug sitzt. Ein weiterer Vorteil ist die deutlich reduzierte Latenz in der visuellen Datenverarbeitung und Steuerungsausgabe. Während menschliche Piloten auf Kamera-Input mit Frequenzen von etwa 120 Hz zugreifen können, arbeitet der Jetson TX2 Computer von Swift mit einer geringeren Kamera-Update-Rate von 30 Hz, jedoch kompensiert die präzise Sensordatenfusion diesen Nachteil. Die Wahrnehmungsrobustheit menschlicher Piloten gegenüber wechselnden Lichtverhältnissen und unerwarteten Umgebungsveränderungen ist hingegen deutlich höher.

Swift ist stark abhängig von der Konsistenz der Umgebung, da sein Gate-Detektor und die Wahrnehmungsresiduen auf relativ homogene Trainingsdaten angewiesen sind. Hier besteht Potenzial für künftige Arbeiten durch Datenaugmentierung und robuste Lernverfahren. Auswirkungen auf Robotics und KI Die Demonstration von Swift, dass autonome Systeme mit Deep RL in der physischen Welt konkurrieren und mitunter ihre menschlichen Gegenüber übertreffen können, ist ein eindrucksvolles Beispiel für den Übergang von Simulationserfolgen zu realweltlicher Spitzenleistung. Dieser Fortschritt geht über den Bereich des Drohnenrennens hinaus und signalisiert eine neue Ära in der autonomen Robotik. Anwendungen, die von schnelleren, robusteren und wahrnehmungsintelligenten autonomen Agenten profitieren, umfassen unter anderem autonome Lieferdrohnen, Flugsysteme zur Katastrophenhilfe, aber auch vielfältige terrestrische Robotersysteme.

Das Hybridkonzept von Swift – Verbindung von physikalisch fundierten Modellen mit lernbasierten Anpassungen an reale Sensor- und Umweltdaten – könnte als Blaupause für diverse autonome Systeme dienen. Zukunftsperspektiven Während Swift bereits auf höchstem Niveau agiert, gibt es zahlreiche Herausforderungen und offene Forschungsfragen. Insbesondere die Robustheit gegenüber unvorhergesehenen Umwelteinflüssen wie schwankenden Lichtverhältnissen, beweglichen Hindernissen oder Wetterbedingungen bleibt ein zentrales Thema. Eine mögliche Lösung besteht in der Integration robuster Wahrnehmungsmethoden und erweitertem Training auf diverseren und realitätsnahen Szenarien. Die Optimierung der Reaktivität und taktischen Anpassung an die Rennsituation, etwa durch Learnings aus Mehragentenumgebungen, könnte den autonomen Systemen weitere Wettbewerbsvorteile verschaffen.