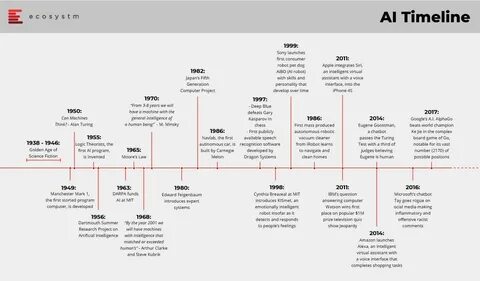

Die Geschichte der Künstlichen Intelligenz (KI) ist eine faszinierende Reise, die von den ersten theoretischen Überlegungen im 19. Jahrhundert bis hin zu hochentwickelten multimodalen Systemen im Jahr 2025 reicht. Die Entwicklung der KI wird von technologischem Fortschritt, wissenschaftlichen Durchbrüchen und dem unermüdlichen Streben nach intelligenter Automatisierung geprägt. Um die heutige Bedeutung und künftige Potenziale von KI zu verstehen, lohnt es sich, die wichtigsten Stationen dieser Evolution nachzuvollziehen. Die Ursprünge der Idee, dass Maschinen denken können, lassen sich bis in die Mitte des 19.

Jahrhunderts zurückverfolgen. Ada Lovelace erkannte als eine der ersten die Möglichkeit, dass Maschinen nicht nur Zahlen, sondern auch Symbole bearbeiten könnten – ein Grundstein für heutige Algorithmen. Etwas später, im Jahr 1936, legte Alan Turing mit seiner Vorstellung der Universalmaschine das theoretische Fundament für generalisierte Berechnungen und somit auch für die Entwicklung intelligenter Maschinen. Bis in die 1950er Jahre hinein wurden entscheidende technologische Entwicklungen wie der Transistor, integrierte Schaltkreise und die ersten Mikroprozessoren realisiert. Diese waren zwingende Voraussetzungen für die spätere Umsetzung komplexer KI-Systeme.

Der Begriff „Künstliche Intelligenz“ selbst wurde 1956 auf der Dartmouth-Konferenz geprägt, wo Wissenschaftler erstmals das Ziel formulierten, Maschinen mit menschenähnlicher Intelligenz zu schaffen. In den folgenden Jahrzehnten entstanden grundlegende Konzepte wie neuronale Netze, die zunächst durch begrenzte Rechenleistung und Datenverfügbarkeit eingeschränkt waren. Dennoch folgten Fortschritte wie das Perzeptronmodell von Rosenblatt und die Entwicklung von LSTM-Netzwerken, die das Lernen über längere Datenfolgen ermöglichen. Der Durchbruch zur modernen KI erfolgte wesentlich durch den Einsatz und die Weiterentwicklung neuronaler Netzwerke verbunden mit der exponentiellen Steigerung der Rechenkapazität durch GPUs und spezialisierte Hardware. CUDA, eingeführt im Jahr 2007, revolutionierte das Training von KI-Modellen und führte zu dramatisch beschleunigten Lernprozessen.

Parallel dazu erweiterten Forscher das Wissen über effektive Trainingsmethoden, etwa durch die Einführung von Batch-Normalisierung und Optimierungsverfahren wie Adam. Ab 2012 wurde durch den Erfolg von AlexNet bei der Bildklassifikation erstmals der konkrete Einfluss tiefgehender neuronaler Netze auf praktische Anwendungen sichtbar. Diese und weitere Durchbrüche unterstützten die Erweiterung von KI-Anwendungen jenseits von Spiel- und Bildverarbeitung hin zu Sprachmodellen und komplexen Entscheidungsverfahren. Die Veröffentlichung von BERT im Jahr 2018 markierte eine bedeutende Verbesserung im Verständnis der natürlichen Sprache. BERT verband das Konzept der Maskierung mit Transformer-Architekturen, die seit 2017 die Grundlage für beinahe alle modernen Sprachmodelle darstellen.

Ein Jahr zuvor hatte Google mit AlphaZero bewiesen, dass KI durch selbstständiges Lernen ohne menschliches Vorwissen komplexe Spiele meistern kann, was ein großes Stück näher an generelle Problemlösefähigkeiten führte. In der Folgezeit wuchs die Bedeutung großer Sprachmodelle rapide. OpenAI veröffentlichte mit GPT-2 und später GPT-3 Modelle, die durch ihr enormes Trainingsvolumen und ihre Architektur hochgradig kontextbezogenes Textverständnis demonstrierten. Diese Modelle zeigten erstmals emergente Fähigkeiten und ermöglichten Anwendungen von fortgeschrittener Textgenerierung bis hin zu Programmierhilfen und kreativer Textgestaltung. Im Jahr 2023 und besonders 2024 dominierten multimodale Modelle die Diskussion.

OpenAI und Google stellten Systeme vor, die nicht nur Texte, sondern auch Bilder, Videos und Audio in Echtzeit verarbeiten und generieren können. Diese wurden durch erweiterte Kontextfenster, wie den Millionen-Token-Kontext von Gemini 2.5 Pro, ermöglicht, wodurch die Maschinen in der Lage sind, komplexe Langzeitzusammenhänge in großen Datenmengen zu erfassen. Diese Technologien sind ein entscheidender Schritt in Richtung allgemeiner künstlicher Intelligenz (Artificial General Intelligence, AGI). Parallel rückt die Sicherheit und Steuerbarkeit von KI-Systemen immer stärker in den Fokus.

Firmen wie Anthropic mit ihrem Modell Claude Opus 4 setzen neue Maßstäbe, indem sie nicht nur auf Leistung, sondern auf umfassende Sicherheitsmechanismen Wert legen. Auch die Verfügbarkeit von Open-Source-Modellen wie Llama 3 zeigt, dass die Demokratisierung von KI-Technologien entscheidend für ein ausgewogenes Innovationsumfeld ist. Die Erschwinglichkeit von KI-Diensten wird ebenfalls revolutioniert. Produkte wie DeepSeek R1 haben es geschafft, fortschrittliche reasoningfähigkeiten zu einem Bruchteil der bisherigen Kosten anzubieten, wodurch auch kleinere Unternehmen und Einzelpersonen Zugang zu leistungsfähiger KI erhalten. Zusätzlich eröffnen Modelle mit multimodalen Fähigkeiten ganz neue Anwendungsfelder – von der Echtzeitgenerierung von Videos mit synchronem Audio und natürlichen Umgebungsgeräuschen bis hin zu KI-gestützten Assistenzsystemen, die nahtlos mit Nutzern interagieren.

Betrachtet man die historischen Entwicklungen im Kontext der heutigen Fortschritte, so wird deutlich, wie eng technologische Innovation mit gesellschaftlichen Bedürfnissen und wissenschaftlichem Fortschritt verflochten ist. Von frühen Konzepten und Papierarbeiten hin zu Tausenden von Innovationen in Hard- und Software hat sich Künstliche Intelligenz zu einem der wichtigsten Motoren für Zukunftstechnologien entwickelt. Die nächsten Jahre werden entscheidend sein, um zu sehen, ob und wie das Ziel einer allgemeinen künstlichen Intelligenz erreicht werden kann. Fortschritte wie adaptive Rechenallokation in Modellen, die Fähigkeit zu längerfristigem Denken und fortgeschrittene Sicherheitsprotokolle dürften dabei eine zentrale Rolle spielen. Gleichzeitig bleibt die Frage der ethischen Implementierung und der gesellschaftlichen Auswirkungen eine Herausforderung, die durch transparente und verantwortungsbewusste Entwicklung adressiert werden muss.

Zusammenfassend lässt sich sagen, dass die Entwicklung der KI ein kontinuierlicher Prozess ist, der von vielen verschiedenen wissenschaftlichen Feldern und Technologien getragen wird. Die heutige KI-Landschaft, mit hochskalierbaren multimodalen und multimissionalen Systemen, war vor nicht allzu langer Zeit noch reiner Futurismus. Mit der kommenden Zeit steht die nächste große Transformation bevor – eine, die Mensch und Maschine auf bislang ungeahnte Weise zusammenbringen wird.