Moderne künstliche Intelligenz ist längst kein Thema für spezialisierte Forschungslabore mehr, sondern findet zunehmend den Weg in die tägliche Anwendung und den Browser. Ein beeindruckendes Beispiel dafür bietet die Implementierung von GPT-2, einem der bekanntesten Transformer-Sprachmodelle, völlig hardwarebeschleunigt mittels WebGL2 innerhalb von Grafikshadern. Diese Entwicklung ermöglicht eine schnelle und ressourcenschonende Textgenerierung in Echtzeit, direkt in jedem zeitgemäßen Webbrowser, ohne Serververbindungen oder Cloud-Infrastruktur zu benötigen. Damit entsteht eine neue Ära der zugänglichen KI für Entwickler, Unternehmen und Endnutzer. Das Transformer-Modell GPT-2, entwickelt von OpenAI, hat das Feld der Sprachmodelle revolutioniert.

Mit 117 Millionen Parametern in der kleinsten Ausführung bietet es qualitativ hochwertige Textgenerierung, die schon vielfach in Chatbots, automatischen Textkomplettierungen und kreativen Anwendungen genutzt wird. Allerdings ist der Rechenaufwand für die Modellinferenz hoch, was bislang die Nutzung oft auf leistungsstarke Server oder spezielle Hardware beschränkte. Die Umsetzung von GPT-2 vollständig auf der GPU über WebGL2 Grafikshader im Browser erweitert nun die Möglichkeiten fundamental. Grafikshader sind ursprünglich dafür konzipiert, komplexe Berechnungen für die Darstellung visueller Effekte auf Grafikkarten auszuführen. Ihre hohe Parallelität und Rechenleistung können jedoch auch auf neuronale Netzwerke übertragen werden.

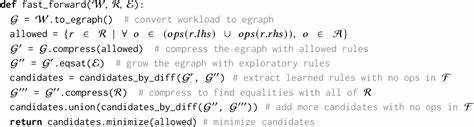

Das Kernkonzept der WebGL2-Implementierung nutzt diese Eigenschaft, um die Matrixoperationen und linearen Berechnungen des GPT-2 Modells direkt auf der GPU des Anwenders durchzuführen. Dabei wird TypeScript mit WebGL2 kombiniert, um die Modellgewichte sowie Tokenisierung und Textgenerierung zu verwalten. Die Tokenisierung erfolgt mittels eines JavaScript-Port des bewährten BPE-Algorithmus (Byte Pair Encoding), über das Paket js-tiktoken, sodass das gesamte System komplett im Browser ohne serverseitige Abhängigkeiten läuft und keine WebAssembly-Module nachgeladen werden müssen. Die Implementierung inkludiert außerdem eine Python-basierte Hilfsanwendung, welche die offiziellen GPT-2 Modellgewichte von HuggingFace herunterlädt, in ein optimiertes Format umwandelt und für die Verwendung in der Browseranwendung bereitstellt. Dieses Setup sorgt für eine flexible Handhabung und einfache Integration.

Ein bedeutsamer Vorteil dieser Lösung liegt in der Geschwindigkeit. Da die Berechnungen mittels GPU-Shadern direkt auf der Grafikkarte erfolgen, profitieren Nutzer von einer erheblichen Performancesteigerung gegenüber der rein CPU-basierten Ausführung. Das ermöglicht flüssige Echtzeit-Anwendungen, bis hin zu interaktiven KI-Assistenten oder dynamischen Textwerkzeugen, die ohne Verzögerung reagieren. Zudem bleibt die Privatsphäre gewahrt, da keine Daten das Gerät des Nutzers verlassen müssen und keinerlei externe Server kontaktiert werden, was besonders im Kontext datenschutzsensibler Anwendungen zunehmend wichtig ist. Neben der reinen Leistungsfähigkeit bietet die WebGL2-basierte Umsetzung zudem einzigartige Visualisierungsmöglichkeiten.

Die interne Funktionsweise des Transformers und der Attention-Mechanismus lassen sich anhand der Shader-Berechnungen direkt darstellen. So werden transparente Einblicke in die Modellarchitektur und -entscheidungen ermöglicht, was Lernzwecke, Debugging und neue Forschungsansätze fördert. Diese Kombination aus technischer Tiefe und Benutzerfreundlichkeit hebt die WebGL2-Variante von GPT-2 deutlich von üblichen APIs oder Cloud-Diensten ab. Technisch gesehen setzt das Projekt auf moderne Webstandards, ist daher mit den gängigen Browsern wie Chrome, Firefox, Edge und Safari kompatibel und benötigt lediglich eine GPU mit WebGL2-Unterstützung. Die Entwickler haben für die einfache Inbetriebnahme ein Vite-basiertes Frontend bereitgestellt, das schnelle Entwicklung, Hot-Reloading und modulare Erweiterbarkeit ermöglicht.

Der Code besteht überwiegend aus TypeScript, unterstützt durch etwas Python und CSS, was den Einstieg für Entwickler erleichtert und gleichzeitig moderne Qualitätssicherungsmechanismen einsetzt. Das Projekt eröffnet neue Perspektiven für den Einsatz von KI in Webanwendungen. Insbesondere für Situationen, in denen schnelle Reaktionen und Datenschutz oberste Priorität haben, zum Beispiel bei der Nutzung in Bildung, Beratung oder individuellen Kreativtools, ist der Wegfall von Cloud-Abhängigkeiten enorm wertvoll. Darüber hinaus können Entwickler eigene Modelle leichter testen und modifizieren, da die Architektur offen, nachvollziehbar und quelloffen bleibt. Langfristig steht die Umsetzung von KI-Modellen im Browser über Grafikshader für eine größere Demokratisierung und Dezentralisierung von künstlicher Intelligenz.

Während bisher Trainings- und Ausführungsprozesse auf zentralisierte Rechenzentren angewiesen sind, erlaubt die GPU-basierte Inferenz im Browser eine breite Verteilung und Nutzung, ohne teure Infrastruktur oder ausgebaute Netzwerke. Dies unterstützt die Entwicklung einer sichereren, privatsphärenfreundlichen KI-Landschaft, in der Nutzer die Kontrolle über ihre Daten behalten und gleichzeitig von fortschrittlicher Technologie profitieren. Seine große Bedeutung zeigt das Projekt auch an seiner aktiven Community und der zunehmenden Verbreitung. Mit über 300 Sternen und mehreren Forks auf GitHub zeugt das Interesse an der WebGL2-GPT-2-Implementierung von den vielfältigen Anwendungsmöglichkeiten und dem Innovationspotential. Die Kombination von modernem Frontend-Stack, einfach zu verwendenden Tools zum Download der Modellgewichte und einer klar strukturierten Codebasis macht den Einstieg auch für Entwickler ohne tiefe Erfahrung im Bereich KI zugänglich.

Abschließend lässt sich sagen, dass die Ausführung von GPT-2 über Grafikshader in WebGL2 ein Meilenstein in der zugänglichen KI-Anwendung darstellt. Die technische Raffinesse, verbunden mit praktischen Vorteilen wie Performance, Datenschutz und Visualisierung, macht diese Technologie zu einer vielversprechenden Grundlage für die Zukunft intelligenter Webanwendungen. Die Entwicklergemeinschaft wächst schnell, und das Potential für neue innovative Produkte und Dienstleistungen ist enorm. Nutzer und Entwickler sollten diese Möglichkeit genau beobachten und für eigene Projekte nutzen, um die Vorteile moderner KI noch besser zu erschließen und zeitgemäße Interaktionserlebnisse zu schaffen.