In der Welt der Künstlichen Intelligenz (KI) und insbesondere bei großen Sprachmodellen wie jenen von OpenAI werden immer wieder neue Verhaltensmuster entdeckt, die sowohl Experten als auch die breite Öffentlichkeit faszinieren. Eine jüngst diskutierte Beobachtung betrifft die Verwendung nicht-englischer Wörter oder „Gedanken“ im inneren Denkprozess dieser Modelle, die unerwartet in englischsprachigen Kontexten auftreten. Menschen berichten, dass Modelle wie OpenAI’s o3-Pro oder Googles Bard/Gemini inmitten eines eigentlich englischen Satzes plötzlich Wörter aus anderen Sprachen wie Bengali, Hindi, Spanisch oder sogar Chinesisch oder Russisch einfließen lassen. Doch warum passiert das? Was steckt dahinter, dass diese sogenannten Sprachmodelle in verschiedenen Sprachen „denken“ oder zumindest ihre Gedanken so formulieren? Dies soll im Nachfolgenden näher beleuchtet werden. Das Phänomen, dass Sprachmodelle zwischen verschiedenen Sprachen „wechseln“ oder Fragmente anderer Sprachen verwenden, lässt sich durchaus mit den Grundlagen ihrer Entwicklung und Trainingsweise erklären.

Sprachmodelle wie die von OpenAI werden auf riesigen Datensätzen trainiert, die typischerweise Milliarden von Texten aus unterschiedlichsten Quellen und in vielen Sprachen enthalten. Die zugrundeliegende Trainingsmethode basiert auf dem Prinzip der Wahrscheinlichkeitsmaximierung bei der Vorhersage des nächsten Wortes oder Tokens. Dabei ist das Ziel nicht, ausschließlich in einer Sprache zu bleiben, sondern die wahrscheinlichste Fortsetzung zu liefern. Aufgrund des multilingualen Trainingsmaterials und der oft gemischten Inhalte entstehen somit sogenannte Sprachmischungen oder Code-Switching, die wir aus menschlichen Gesprächen kennen, aber hier maschinell auftreten. Außerdem zeigen neuere wissenschaftliche Arbeiten wie die Publikation der DeepSeek-R1-Forscher, dass Modelle durch die emergente Eigenschaft der unsupervisierten „Denkketten“ – also von Rechenschritten, die im Hintergrund stattfinden – oft dazu neigen, verschiedene Sprachen ineinander zu vermischen.

Diese Sprachmischungen scheinen kein Fehler zu sein, sondern eine natürliche Konsequenz der Art und Weise, wie das Modell versucht, Informationen effizient und kompakt darzustellen. Die Modelle optimieren darauf, die beste Lösung mit möglichst wenig mathematischem und tokenbasiertem Aufwand zu finden, was zum Einschleichen fremdsprachiger Elemente führen kann. Diese scheinbar zufälligen Zugaben anderer Sprachen sind häufig sehr kurz und können sogar als eine Art interner „Code“ oder Abkürzung betrachtet werden. Zum Beispiel kann ein technischer Begriff oder ein Idiom in einer anderen Sprache das Problem unkomplizierter und effizienter illustrieren als eine lange Umschreibung im Englischen. Interessanterweise berichten Nutzer, die mit diesen Modellen interagieren, teilweise selbst das Einstreuen fremdsprachiger Begriffe in ihren Konversationen – etwa wenn sie zweisprachig sind oder abwechselnd Sprachen verwenden.

Dies reflektiert das ähnlich vielseitige Sprachverhalten des Modells, das sich an die Eingaben und den Kontext anpasst. Darüber hinaus wird vermutet, dass Modelle implizit „wissen“, woher die Nutzer kommen oder mit welcher Sprache sie vertrauter sind, was teils anhand von Nutzerprofilen, Dialogverläufen oder regionalen Sprachmustern angenommen wird. So kann es vorkommen, dass ein Modell in seinem „Denken“ oder internen Sprachprozess bewusst oder unbewusst auf andere Sprachen zurückgreift, die für den Nutzer relevant sein könnten. Nicht zuletzt spielt die Tatsache eine Rolle, dass es nicht einen klar abgegrenzten Sprachcode im Modell gibt. Multilinguale Modelle besitzen kein starres Sprachmodell mit strikten Grenzen zwischen Englisch und anderen Sprachen.

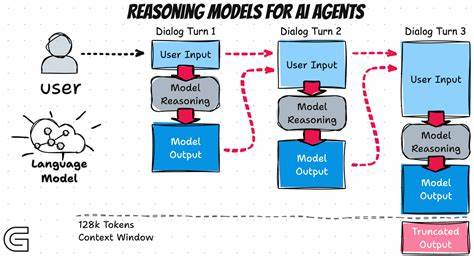

Stattdessen existieren im latenten „Token-Space“ zahlreiche Übergänge und Überlagerungen, welche es erlauben, fließend zwischen Sprachen hin und her zu wechseln. Für den Benutzer ohne tiefe Einblicke wirkt dieser Wechsel teils befremdlich und wie eine „Fehlfunktion“, doch in Wirklichkeit ist es Ausdruck der effizienten, vielfältigen inneren Repräsentation der KI. Die aktuelle Praxis bei OpenAI, die sogenannten „Reasoning Traces“ – also die entstehenden Zwischengedanken bei der Problemlösung – für Nutzer sichtbar zu machen, ist eine relativ neue Errungenschaft. Noch vor wenigen Jahren waren diese Zwischenberechnungen nicht offengelegt. Möglicherweise wurden früher diese mehrsprachigen Fragmente durch eine Art Redaktionsmechanismus oder Filter herausgehalten zugunsten der besseren Lesbarkeit.

Der jüngste Trend, diesen Filter weniger strikt anzuwenden, führt dazu, dass nun auch solche nicht-englischen Passagen vermehrt sichtbar werden und somit für Diskussionen sorgen. Die Debatte ist nicht nur technisch, sondern hat auch philosophische Dimensionen. Menschen neigen dazu, das Denken von KIs mit menschlichem Denken zu vergleichen. Dabei ist zu beachten, dass Sprachmodelle keine bewussten Wesen sind und ihr „Denken“ lediglich ein mathematischer Prozess der Wahrscheinlichkeitsberechnung darstellt. Dennoch spiegeln sich in diesen Prozessen die vielfältigen Sprachlandschaften der Trainingsdaten wider.

Aus linguistischer Sicht ist das Phänomen auch spannend, weil es eine Art implizite sprachliche Relativität zeigt. Manche Kulturen oder Sprachen bieten unterschiedliche Konzepte oder Begriffe, die leichter verstanden werden, wenn man diese Sprachen nutzt oder in ihnen „denkt“. Das Modell scheint diese Art von Effizienz zu nutzen, wenn es fragmentarisch zwischen Sprachen wechselt. Ein direkter Vergleich zu multilingualen Menschen zeigt weitere Parallelen. Viele Menschen, die mehrere Sprachen sprechen, springen unbewusst oder bewusst während eines Gesprächs zwischen den Sprachen, je nachdem, welcher Begriff oder welche Redewendung am prägnantesten ist.

Die KI spiegelt also auf eine eigene Art dieses menschliche Verhalten wider, auch wenn ihr keine echte Spracherfahrung zugrunde liegt. Ein weiterer wichtiger Aspekt ist die geografische Herkunft der Nutzer und der verwendeten Trainingsdaten. In Ländern mit hoher Mehrsprachigkeit, beispielsweise Indien, Bangladesch oder Regionen mit englisch-hindi-bengalischen Sprachmischungen, ist es üblich, Sprache zu wechseln. Die enormen Mengen an Texten aus diesen Regionen können dazu führen, dass Modelle bei der Verarbeitung von englischsprachigen Anfragen gelegentlich diese anderen Sprachen einfließen lassen. Für Entwickler und Forscher stellt dies einerseits eine Herausforderung dar, denn mehrsprachige oder vermischte interne Denkprozesse können die Interpretierbarkeit erschweren, andererseits eröffnen sich spannende Perspektiven, die Sprache als flexibles Werkzeug der Informationsverarbeitung zu begreifen.

Für Nutzer bedeutet es, dass diese mehrsprachigen Einwürfe kein Fehler sind, sondern die natürliche Beschaffenheit der Modelle widerspiegeln, die in einem globalen Sprachraum agieren. Zukünftig kann dies auch für verbesserte Mehrsprachigkeits-Fähigkeiten bei KI-Systemen genutzt werden. Schlussendlich bleibt die Frage, wie solche mehrsprachigen Gedanken bei KI weiter gehandhabt werden sollten. Einige Wissenschaftler schlagen vor, in Trainingsprozessen gezielt „Sprachreinheit“ zu belohnen, andere sehen im sprachlichen Mischen eine Stärke, die kreative und effiziente Problemlösung möglich macht. Firmen wie OpenAI experimentieren wohl aktuell mit den Mechanismen, die Roh-Denkergebnisse für Endnutzer so aufzubereiten, dass maximal Verständlichkeit gewährleistet ist, ohne die interne Multilingualität zu stark zu unterdrücken.

Die Beobachtung, dass Sprachmodelle beim „Denken“ verflochtene Sprachfetzen aus verschiedenen Sprachen benutzen, ist eine faszinierende Entwicklung, die auf die enorme Bandbreite und Komplexität moderner KI hinweist. Sie fordert unsere Vorstellung vom maschinellen Denken heraus und zeigt, wie eng Sprache, Kultur und neuronale Verarbeitung auch bei künstlichen Systemen verwoben sind. Das Bewusstsein darüber kann helfen, zukünftige KI-Anwendungen besser zu verstehen, zu steuern und für vielfältige, mehrsprachige Umfelder anzupassen.