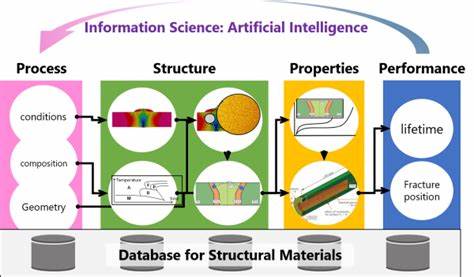

Die Wissenschaftswelt wurde jüngst von einem handfesten Skandal erschüttert: Eine viel beachtete Studie von einem jungen Forscher des Massachusetts Institute of Technology (MIT) über die Anwendung Künstlicher Intelligenz (KI) in der Materialforschung ist als komplett gefälscht entlarvt worden. Die Arbeit erregte anfangs weltweites Aufsehen, da sie überraschend klare und positive Effekte von KI-Werkzeugen auf die Produktivität von Materialforschern aufzeigte. Nach einer internen Überprüfung durch MIT steht nun fest, dass die Resultate der Studie nicht der Wahrheit entsprechen und sämtliche Daten vermutlich erfunden wurden. Diese Enthüllung wirft nicht nur Fragen über die Integrität einzelner Akteure auf, sondern auch über die Zuverlässigkeit des wissenschaftlichen Publikations- und Begutachtungsprozesses im Zeitalter der digitalen Forschung. Die falsche Studie mit dem Titel "Artificial Intelligence, Scientific Discovery, and Product Innovation" stammte von Aidan Toner-Rodgers, einem scheinbar jungen aufstrebenden Doktoranden, der vorgab, umfangreiche Daten aus einem großen US-amerikanischen Forschungsunternehmen zu besitzen.

Das Papier wurde ursprünglich als Preprint auf arXiv veröffentlicht und erregte schnell die Aufmerksamkeit bedeutender Medien, darunter das Wall Street Journal, Nature und The Atlantic. Die Studie behauptete, dass durch den Einsatz von KI-Tools die Anzahl entdeckter neuer Materialien, angemeldeter Patente, sowie neuer Prototypen merklich und statistisch signifikant gestiegen sei. Dabei wurden moderne Methoden wie Bigram-Analysen und der Einsatz von großen Sprachmodellen zur Klassifikation von Forschungsaufgaben genutzt. All diese Ergebnisse schienen auf den ersten Blick bahnbrechend und wurden mit großer Bewunderung aufgenommen. Doch bei genauerer Betrachtung tauchten frühzeitig erste Zweifel auf.

Kritiker bemängelten die Quelle der Daten, die angeblich von einer einzigen Firma stammten, die über hundert0 Materialienforscher mit einer ungewöhnlich gleichmäßigen Aufteilung auf verschiedene Forschungsbereiche beschäftigen sollte – eine Konstellation, die in der Realität höchst unwahrscheinlich erscheint. Materialforschungslabore großer Firmen, so Experten, sind üblicherweise viel heterogener organisiert. Die Tatsache, dass eine einzelne Firma ein solches umfangreiches und perfekt strukturiertes Experiment durchführte und dabei anonym Daten über tausende Mitarbeitende an einen einzelnen Doktoranden weitergab, wirkte wenig glaubwürdig. Auch die Ergebnisse selbst präsentierten sich wie aus dem Lehrbuch: Wirkung auf Materialentdeckungen, Patente und Prototypen waren in allen Bereichen äußerst deutlich und mit extrem niedrigen p-Werten versehen. Diese vollkommene Sauberkeit der Daten verleitete zu einer naiven Annahme, dass alles seine Richtigkeit haben müsse – doch sie war vielmehr ein Beweis für Manipulation.

Zudem waren einige Grafiken und Schlussfolgerungen, etwa über die Selbsteinschätzung der Forscher bezüglich ihrer Urteilskraft und deren Zusammenhang mit KI-Nutzung, sehr künstlich und kaum fachlich plausibel. Es schien, als habe hier jemand versucht, ein wunschgemäßes Narrativ zu bestätigen, anstatt echte Daten darzustellen. Von besonderem Interesse für die Fachwelt war die angebliche Analyse der strukturellen Ähnlichkeit neu entdeckter Materialien mittels Kristallstrukturvergleich. Ein Verfahren, das normalerweise nur von ausgewiesenen Experten in Computational Materials Science angewandt werden kann und enorme Datenmengen sowie spezialisierte Algorithmen erfordert. Dass ein Wirtschaftsstudent ohne tiefergehende Domänenkenntnisse diese Methodik in solch einer Weise implementiert haben sollte, wirkt äußerst unrealistisch.

Die Methode wurde zudem unzureichend erklärt und nicht in einer Form präsentiert, die andere Forscher hätten nachprüfen können – oft ein Hinweis auf inhaltliche Schwächen oder sogar auf Erfindungen in der Datengrundlage. Ein weiterer Kritikpunkt betrifft die Bewertung der Materialqualität in der Studie. Die Herleitung einer einzigen Zahl, die die Qualität eines neuen Materials ausdrücken soll, beruht auf problematischen Vereinfachungen. In der realen Materialforschung sind Qualitätsparameter oft vielschichtig und – je nach Anwendungsfall – schwer vergleichbar. Zudem sind viele relevante Eigenschaften wie Haltbarkeit, Herstellbarkeit oder Kostenfaktoren ungeläufig in standardisierten Datenbanken dokumentiert.

Die verwendeten Beispiele wie Bandlücke oder Brechungsindex sind in der Materialsynthese alleine selten ausreichend, um Innovationserfolge zu messen. Die Art und Weise, wie die Studie diese komplexen Faktoren in ein einfaches Modell presste, wirkt in der Rückschau wie vollkommen unrealistisch und daher verdächtig. Schließlich sorgte ein bizarrer Abschnitt über eine angebliche Restrukturierung und Entlassungen innerhalb der betrachteten Firma für zusätzliche Zweifel. Hier wurde behauptet, dass das Unternehmen gezielt geringqualifizierte Mitarbeitende entließ, ohne dass dies die Untersuchungen maßgeblich störte. Eine solche Schilderung, die fingierte Anekdoten implizierte, wirkte auf Experten wirr und von der Realität abgekoppelt, fast wie eine gönnerhafte Rechtfertigung des vermeintlichen positiven Einflusses von KI während scheinbar widriger Umstände.

Nachdem MIT nach interner Prüfung erklärte, sie hätten keinerlei Vertrauen mehr in die Integrität der Studie, schlug die Nachricht schnell weitere Kreise. Die renommierte Fachwelt sowie journalistische Medien berichteten über die Fälschung und rückten finanzielle, ethische und wissenschaftliche Konsequenzen in den Fokus. Die Nachricht erschüttert nicht nur das Vertrauen in autonome wissenschaftliche Erkenntnisentwicklung mittels KI, sondern wirft auch ein Schlaglicht auf heutige Herausforderungen bei der Qualitätssicherung in Forschung und Publikation. Insbesondere wenn Innovationen auf hochkomplexen, interdisziplinären Feldern wie Materialwissenschaft und KI vereint werden, stellt sich die Frage, wie Experten aus unterschiedlichen Disziplinen besser zur kritischen Begutachtung beitragen können. Die gesamte Affäre zeigt eindrücklich, wie wichtig es ist, in einer zunehmend automatisierten und datengetriebenen Wissenschaftswelt gesunden Skeptizismus zu wahren.

Insbesondere wenn Resultate allzu perfekt erscheinen und zu gut ins vorherrschende Narrativ passen, sollten sie einer intensiven unabhängigen Überprüfung unterzogen werden. Kritik und Fachwissen über Domänengrenzen hinweg sind essenziell, um Qualität zu sichern. Die verbreitete Praxis, Preprints im Internet schnell zugänglich zu machen, bietet Chancen auf frühe Peer-Feedbacks, die hoffentlich bald auch zwischen Fachexperten unterschiedlicher Disziplinen noch besser genutzt werden können. Inzwischen steht auch im Raum, dass der Autor über eine eigenständige Domain, die auf einen bekannten Materialspezialisten verweist, private Websites mit gefälschten Belegen betrieb, um die Authentizität seiner Arbeit zu untermauern. Darüber hinaus sind rechtliche Schritte im Gange, unter anderem durch die betroffene Firma, die das geistige Eigentum verletzt sieht.

Dies zeigt, dass die Fälschung nicht auf akademische Fehlleistungen beschränkt blieb, sondern auch Bereiche jenseits von Forschung und Wissenschaft tangiert. Die Debatte, die dieser Fall anschiebt, wird längerfristige Auswirkungen auf die Wissenschaftspolitik und den Umgang mit KI in der Forschung haben. Es ist klar geworden, dass die massive Komplexität wissenschaftlicher Fragestellungen und der Drang zur schnellen Publikation, gepaart mit enormen Erwartungen an KI-Werkzeuge, ein Einfallstor für unseriöse Akteure sein können. Für die Wissenschaftsethik, Verlage, digitale Repositorien und Forschungsinstitutionen ergeben sich dadurch dringende Aufgaben, nachhaltigere Kontrollmechanismen zu etablieren und Transparenz zu fördern. Zusammenfassend ist der Fall der gefälschten MIT-Studie ein Weckruf.

Er mahnt zur Vorsicht bei der Rezeption besonders spektakulärer Ergebnisse, die gut zur öffentlichen Stimmung und zu technologischen Hoffnungen passen. Die Materialwissenschaft und der Einsatz von KI gehören zu den spannendsten Feldern unserer Zeit. Doch sie fordern auch verantwortungsvolle Wissenschaftskommunikation und rigorose Prüfung. Die Integrität der Forschung darf nicht von glänzenden Headlines überschattet werden, sondern muss – gerade in Zeiten digitalen Wandels – aktiv geschützt und gefördert werden.