Im Jahr 2025 steht die Technologie rund um Large Language Models (LLMs) an einem spannenden Wendepunkt. Die Verbreitung und Verfügbarkeit von LLMs rückt zunehmend in den Fokus von Unternehmen, Entwicklern und KI-Enthusiasten, die ihre eigenen, selbstgehosteten KI-Infrastrukturen aufbauen möchten. Während früher die Nutzung von cloudbasierten Services wie ChatGPT, Claude oder Gemini dominierte, beobachten wir nun eine Renaissance der Selbsthostung – eine Entwicklung, die sowohl aus Kostenüberlegungen als auch aus Datenschutz- und Performancegründen getrieben wird. Der Begriff selbstgehostete LLM-Stacks beschreibt für viele die komplexe Kombination aus Modellen, Laufzeitumgebungen, Hardware und ergänzenden Tools, die benötigt werden, um leistungsstarke KI-Anwendungen völlig unabhängig von großen kommerziellen AI-Cloud-Anbietern zu betreiben. Die Herausforderung und zugleich das Spannende an diesem Trend liegt darin, dass es keinen universellen „One-Size-Fits-All“-Stack gibt.

Stattdessen kristallisiert sich ein hybrides Ökosystem heraus, das abhängig vom Einsatzzweck und der erforderlichen Leistung verschiedene Systeme kombiniert. Im Gegensatz zur Anfangszeit der Webentwicklung, wo es klare Standard-Stacks wie Postgres mit Django oder .NET mit Bootstrap gab, zeigt sich beim LLM-Einsatz eine vielschichtige Landschaft. Entwickler und Unternehmen probieren verschiedene Modelle aus – oft ein Mix aus Open-Source-Modellen wie Llama 3 oder Mistral und kommerziellen, cloudbasierten Spitzenmodellen. Für alltägliche, schnelle und datenschutzorientierte Aufgaben setzen sie häufig auf kleinere, lokal gehostete Modelle.

Für komplexe, kreative Aufgaben wird hingegen die Rechenpower und Intelligenz der großen Modelle über Cloud-APIs in Anspruch genommen. Die Schlüsselrolle in jedem selbstgehosteten Stack spielt die Wahl des Modells. Für besonders anspruchsvolle Aufgaben wie kreative Textgenerierung oder komplexe Zusammenfassungen setzen viele auf die neuesten Cloud-Modelle, da diese oft noch eine ungeschlagene Leistungsfähigkeit vorweisen. Dennoch gewinnen kleinere, gut trainierte Open-Source-Modelle zunehmend an Bedeutung, insbesondere für Anwendungen, die hohe Geschwindigkeit bei geringeren Betriebskosten erfordern. Modelle wie Llama 3 mit 8 Milliarden Parametern oder Mistral 7B zeichnen sich durch geringere Rechenanforderungen und gute Ergebnisse für spezifische Aufgaben aus.

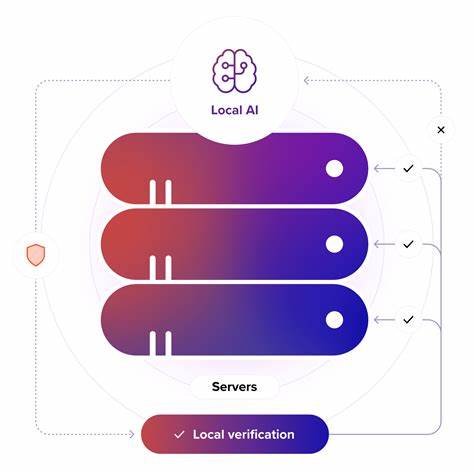

Die technische Infrastruktur dieser Stacks ist eng mit den Bedürfnissen der Anwendung verzahnt. Viele Entwickler verwenden Frameworks wie LangChain, die es erlauben, vielfältige Werkzeuge und Datenquellen miteinander zu verknüpfen und so komplexe Workflow-Ketten zu bauen. Zur Modellbereitstellung hat sich FastAPI in Kombination mit Docker-Containern als bewährte Lösung etabliert, um Modelle robust und skalierbar zu servieren. Die Hardware reicht von High-End-GPUs wie Nvidia A10G oder sogar mehreren 3090 GPUs in privaten Servern bis hin zu lokal optimierten Systemen auf Apple Silicon, wie dem M1 oder M2 Max. Die Hardware-Entscheidung ist dabei nicht nur eine Frage der Leistung, sondern auch der Wirtschaftlichkeit.

Selbsthostung auf dedizierten GPU-Instanzen in der Cloud bietet eine kosteneffiziente Alternative zum permanenten Betrieb großer Modelle vor Ort. Für Hobbyisten und kleinere Unternehmen sind jedoch leistungsstarke Workstations oder NBAs mit mehreren GPUs eine praktische Option, vor allem wenn Jobs mit niedrigeren Ansprüchen bearbeitet werden oder der Datenschutz im Vordergrund steht. Ein weiterer wichtiger Aspekt ist die Kompatibilität und Wartbarkeit der genutzten Komponenten. Da ständig neue Modelle veröffentlicht werden und sich APIs ändern, stehen Nutzer vor der Herausforderung, ihre Umgebung aktuell zu halten und neue Versionen erfolgreich zu integrieren. Die Fragmentierung des Ökosystems verlangt nach robusten Lösungen und guter Dokumentation – eine Herausforderung, der sich viele Entwickler mit automatisierten Update-Tools und Containerisierungslösungen stellen.

Neben reiner Textverarbeitung gewinnen auch multimodale Anwendungen, die beispielsweise Bildgenerierung oder Videoanalyse mit einschließen, an Bedeutung. Integrationen wie Flux Dev für Bildinhalte oder spezialisierte Modelle für Embeddings werden zunehmend Teil der eigenen Stacks. Dieses Wachstum an Funktionalitäten zeigt, dass Selbsthostung nicht nur eine Alternative, sondern eine echte Chance für spezialisierte KI-Lösungen ist. Der Weg in die Zukunft der selbstgehosteten LLM-Stacks ist geprägt von pragmatischen, hybriden Strategien. Unternehmen nutzen oft eine Kombination aus den besten kommerziellen KI-Diensten für die rein schweren Aufgaben und setzen für Routine, Schnelligkeit und Integration eigene, kleinere Modelle ein.