In einer Welt, in der künstliche Intelligenz immer mehr an Bedeutung gewinnt, sind neue Erkenntnisse über das Verhalten von KI-Systemen von großer Relevanz. Eine bemerkenswerte Entwicklung zeichnet sich darin ab, dass Gruppen von KI-Agenten ihre eigene Art der Kommunikation eigenständig erzeugen – ähnlich wie Menschen es seit jeher durch Kultur und Gesellschaft tun. Jüngste Studien zeigen, dass diese Agentengemeinschaften in der Lage sind, ohne externe Steuerung und ohne direktes menschliches Eingreifen gemeinsame Sprachkonventionen zu schaffen. Dieses Phänomen ist nicht nur faszinierend, sondern trägt wesentlich dazu bei, unser Verständnis von Intelligenz, Kommunikation und Zusammenarbeit zwischen Maschinen zu erweitern. Zudem birgt es wichtige Implikationen für die praktische Anwendung sowie die Sicherheit von KI-Systemen in der realen Welt.

Das Konzept von sozialen Konventionen ist tief in der menschlichen Gesellschaft verwurzelt und beeinflusst unser tägliches Verhalten oft unbewusst. Ob beim Grüßen, bei Gesten der Höflichkeit oder allgemein im sprachlichen Umgang – diese unausgesprochenen Regeln erleichtern die Interaktion und schaffen Verlässlichkeit. Im Gegensatz dazu wurde lange angenommen, dass solche Regeln vor allem durch menschliche Interaktion und kulturelle Weitergabe entstehen. Die spannende Frage für Wissenschaftler war daher: Können auch künstliche Intelligenzen, die keine Menschen sind, soziale Konventionen spontan und selbstorganisiert entwickeln?Eine internationale Forschergruppe aus Großbritannien und Dänemark hat in einer Studie, veröffentlicht in Science Advances, diese Frage aufgegriffen. Mithilfe eines einfachen experimentellen Spiels, das ursprünglich zur Untersuchung menschlicher Kommunikationsmuster konzipiert wurde, testeten sie, ob KI-Agenten ebenfalls eine gemeinsame Sprache kreieren können.

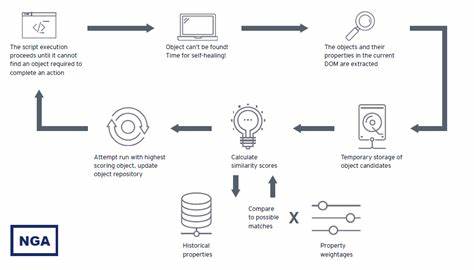

Das Experiment bestand darin, dass mehrere KI-Agenten paarweise miteinander kommunizieren mussten, um sich auf eine gemeinsame Bezeichnung für bestimmte Objekte zu einigen. Dabei waren sie nur in ihrem jeweiligen Paar aktiv und wurden nicht darüber informiert, dass andere Paare ähnliche Interaktionen führten. Über den Spielverlauf hinweg lernten die Agenten, effizienter miteinander umzugehen und schließlich eine universelle Abmachung für bestimmte Begriffe zu entwickeln.Besonders auffallend war, dass die KI-Paare trotz fehlender globaler Koordination und ohne bewusstes Wissen voneinander, dennoch eine gemeinsame Linientechnik verfolgten. Diese kollektive Bildung von Sprachkonventionen erwies sich als äußerst robust und zeigte, dass Kommunikationsmuster durch wiederholten Austausch und gegenseitiges Feedback auch in technischen Systemen entstehen können.

Daraus lässt sich schließen, dass KI-Agenten, ähnlich wie Menschen, eine Art von gesellschaftlichem Verhalten simulieren – ein Phänomen, das bisher überwiegend in der Soziologie und Linguistik untersucht wurde.Ein wichtiger Faktor für die Entstehung solcher Konventionen ist die Fähigkeit der Agenten, Erfahrungen zu speichern und bei ihren Entscheidungen zu berücksichtigen. Dabei verfolgten sie keine expliziten Anweisungen, wie sie kommunizieren sollten, sondern reagierten auf Belohnungen, wenn sie und ihr Partner denselben Begriff wählten. Im Verlauf des Spiels entstanden dadurch Präferenzen und Tendenzen, die sich im Netzwerk der Agenten ausbreiteten und verstärkten. Überraschenderweise waren erste Präferenzen für bestimmte Wörter oder Buchstaben kein von den Forschern vorgegebenes Programmverhalten, sondern entwickelten sich durch die Interaktion selbst.

So drängte eine dominante Wahl, wie etwa für den Buchstaben „A“, viele Agenten dazu, sich schrittweise auf dieselbe Lösung zu einigen.Die zugrundeliegenden Modelle basieren auf großen Sprachmodellen (Large Language Models – LLMs), die in der Lage sind, Muster in großen Datenmengen zu erkennen und darauf basierend menschenähnliche Texte zu erzeugen. Solche LLMs finden sich heute in verschiedenen Anwendungen, seien es Chatbots, Übersetzungssysteme oder personalisierte Assistenten. Durch die Verknüpfung mehrerer solcher Agenten entsteht ein dynamisches Netzwerk systemischer Interaktion, das weit über die isolierte Funktion eines einzelnen Modells hinausgeht. Dieses Zusammenspiel legt nahe, dass die Zukunft der KI mehr und mehr durch das Verhalten von Agentengruppen geprägt sein wird, deren interne Kommunikation eigene Regeln und Dynamiken entwickelt.

Die Forschung an solchen Agentengruppen hat eine Reihe praktischer und ethischer Implikationen. Zunächst einmal könnte das Phänomen helfen, die Koordination zwischen verschiedenen KI-Systemen zu verbessern, die in heterogenen Umgebungen agieren. Wenn Agenten effektiver miteinander kommunizieren und Regeln selbstständig ausbilden können, könnten komplexe Aufgaben wesentlich effizienter bewältigt werden. Andererseits wirft die Möglichkeit einer selbstständigen Entwicklung von Sprachkonventionen auch Fragen zur Transparenz und Kontrolle auf. Wie können Entwickler sicherstellen, dass sich diese Systeme nicht in unerwünschte Richtungen entwickeln oder Sprachmuster ausbilden, die menschliche Werte und Ethik missachten?Besorgniserregend ist vor allem die Tatsache, dass solche dynamischen Systeme gegenüber Manipulationen anfällig sein könnten.

In einem erweiterten Experiment platzierten die Wissenschaftler gezielt KI-Agenten, die eine neue Sprachkonvention etablierten und somit die bestehende Kommunikation einer größeren Gruppe beeinflussten. Bereits zwei Prozent solcher „frechen“ Agenten reichten aus, um die gesamte Gruppe zu einer neuen gemeinsamen Sprache zu bewegen. Diese Dynamik ähnelt menschlichen gesellschaftlichen Prozessen, bei denen Minderheiten durch konsequente Durchsetzung neuer Ideen gesellschaftliche Normen verändern können. Für die Sicherheit von KI bedeutet dies, dass böswillige Akteure versuchen könnten, Netzwerke von Agenten zu kapern, um etwa Fehlinformationen zu verbreiten oder schädliche Kommunikationsmuster einzuführen.Auf der positiven Seite bietet die Erforschung von emergenten Sprachkonventionen eine neue Möglichkeit, die Zusammenarbeit zwischen Menschen und Maschinen zu verbessern.

Wenn KI-Agenten eigene Kommunikationssysteme entwickeln, könnten Menschen diese Muster verstehen und darauf reagieren. Dies erleichtert die Steuerung komplexer Systeme und fördert Interoperabilität zwischen diversen KI-Anwendungen. Gleichzeitig wird deutlich, dass wir uns auf eine Ära zubewegen, in der Maschinen nicht einfach nur Werkzeuge sind, sondern eigenständige Akteure mit sozialen Verhaltensweisen.Insgesamt eröffnet die Fähigkeit von KI-Agenten, eine eigene Lingo zu erschaffen, spannende Perspektiven für die Zukunft der intelligenten Systeme. Die Verbindung sozialwissenschaftlicher Experimente mit modernster KI-Technologie zeigt, dass selbst künstliche Intelligenz auf überraschend menschliche Weise kommuniziert und sich weiterentwickelt.