Seit Beginn des Internets waren Kommentare eine wesentliche Möglichkeit für Nutzer, sich auszutauschen, Meinungen zu teilen und Diskussionen anzustoßen. Von den ersten Foren über Blog-Kommentare bis hin zu sozialen Netzwerken haben Kommentare stets eine Rolle gespielt, um den Dialog zu fördern und Gemeinschaften zu bilden. Doch in den letzten Jahren hat sich die Landschaft der Kommentarfunktion drastisch verändert – nicht zuletzt durch den rasanten Fortschritt von Künstlicher Intelligenz, insbesondere durch Large Language Models (LLMs). Diese Veränderung wirft wichtige Fragen auf, wie wir zukünftige Online-Interaktionen gestalten und welche Rolle die Glaubwürdigkeit von Kommentaren dabei noch spielen wird. \n\nDie Entwicklung von KI-Technologien hat die Art und Weise revolutioniert, wie Inhalte generiert werden können.

Während früher menschliche Autoren notwendig waren, um Kommentare zu verfassen, zeichnen sich heute vielschichtige Herausforderungen ab, da automatisierte Systeme in der Lage sind, glaubwürdig erscheinende, aber oft irreführende oder gar erfundene Beiträge zu erstellen. Diese sogenannten LLM-generierten Kommentare machen es Moderatoren zunehmend schwer, zwischen authentischen Beiträgen und manipulativen oder werblichen Botschaften zu unterscheiden.\n\nEin zentrales Problem liegt in der Verlagerung des Spam-Gleichgewichts. Früher war Spam oft offensichtlich repetitiv, einfach zu erkennen und folglich vergleichsweise leicht zu bekämpfen. Viagra-Werbebotschaften und generische Werbe-Kommentare dominierten das Bild.

Heute jedoch sind die Spam-Nachrichten durch KI so gestaltet, dass sie inhaltlich relevant und kontextbezogen wirken. Sie können spezifische Anspielungen auf den eigentlichen Beitrag oder zugeschnittene emotionale Narrative enthalten, um vertrauenswürdiger zu wirken. Dies erschwert herkömmliche Filtermechanismen erheblich und sorgt für eine Schwemme neuer Spam-Varianten, die in der Nähe echter Gespräche operieren und so der Entlarvung entgehen.\n\nDie Auswirkungen auf die Online-Kommunikation sind tiefgreifend. Die Automatisierung der Kommentarerstellung führt nicht nur zu einer Zunahme an Menge, sondern auch zu einer Erosion der Qualität und Glaubwürdigkeit.

Nutzer verlieren zunehmend das Vertrauen in Kommentarsektionen, da sie nicht mehr sicher sein können, ob sie authentische Meinungen lesen oder nur Bots, die subtile kommerzielle oder politische Interessen verfolgen. Dies trägt zu einer Atmosphäre der Skepsis bei, in der echte Debatten untergehen können und die Diskussionskultur leidet.\n\nDarüber hinaus ist nicht jeder KI-generierte Kommentar eigennützig motiviert. Einige Bots fassen beispielsweise Inhalte zusammen oder rekonstruieren Meinungen, sind dabei aber fehleranfällig und können Fehlinformationen verbreiten, wie es bei automatischen Kurzfassungen von technischen Artikeln häufig vorkommt. Die Kombination aus plausibler Form und falschem Inhalt hat ein großes Potenzial, Irrtümer zu verfestigen und die Verbreitung von Desinformation zu fördern.

\n\nModeratorinnen und Moderatoren sehen sich dadurch einer immer komplexeren Aufgabe gegenüber. Die manuelle Prüfung von Kommentaren, die früher zeitaufwändig, aber eindeutig schaffbar war, wird inzwischen zu einem mühsamen und oft frustrierenden Unterfangen. Die Grenzen zwischen authentischen Beiträgen und betrügerischem Spam verschwimmen, sodass nicht nur technische Filter, sondern auch menschliches Urteilsvermögen an seine Grenzen stößt. Dies stellt besonders kleinere Plattformen und dezentrale Netzwerke vor enorme Herausforderungen, da ihnen die Ressourcen für umfassende Überprüfungen häufig fehlen.\n\nInteressanterweise sind Plattformen mit einem hohen Aufkommen an hochwertigen, ausführlichen Beiträgen besonders anfällig, da einzelne Spam-Kommentare sehr viel Sichtbarkeit erhalten können.

Im Gegensatz dazu sind Instant-Messaging-Dienste oder Plattformen mit flüchtigen, schnellen Beiträgen weniger lukrative Ziele für KI-basierte Spammer. Daher dürfte sich die Problematik vor allem bei Blogs, Fachportalen oder längeren Diskussionsforen verstärken.\n\nEin weiteres Problemfeld sind zunehmend ausgeklügelte Methoden, mit denen KI-Systeme nicht nur Texte generieren, sondern ganze Identitäten und Beziehungsnetzwerke simulieren können. Diese digitalen Personen können mit anderen Nutzern monatelang kommunizieren, bevor sie für kommerzielle, politische oder betrügerische Zwecke eingesetzt werden. Die Implikationen für Online-Sicherheit, Datenschutz und psychologische Integrität sind beträchtlich, zumal Manipulationen zunehmend subtiler und schwerer erkennbar werden.

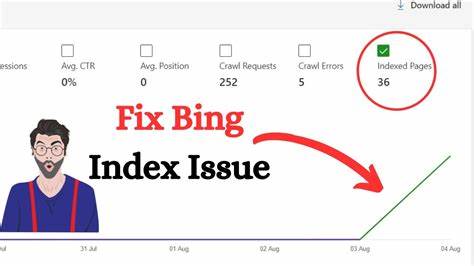

\n\nUm den Herausforderungen zu begegnen, setzen viele soziale Netzwerke auf komplexe Erkennungsverfahren wie IP-Überwachung, Verhaltensanalyse, Fingerprinting über JavaScript oder mobile Apps sowie statistische Mustererkennung. Doch diese Maßnahmen lassen sich nicht eins zu eins auf weniger zentralisierte oder datenschutzorientierte Plattformen übertragen. Gerade dort, wo Nutzer mehr Anonymität genießen, sind die Risiken durch LLM-Spoofing und Spam besonders groß.\n\nDie Entwicklung unterstreicht die Notwendigkeit, neue Schutzmechanismen und Strategien zu entwickeln, um echte menschliche Interaktion von automatisierten Angriffen zu unterscheiden. Höhere Anforderungen an Account-Registrierungen, Captchas oder Proof-of-Work-Maßnahmen sind zwar ein Anfang, doch angesichts der technischen Entwicklungen reichen sie bald nicht mehr aus.

Außerdem stellen sie für legitime Nutzer häufig eine Barriere dar, die die Nutzungsfreundlichkeit einschränkt.\n\nDie technische Gemeinschaft, KI-Entwickler und Betreiber von Online-Plattformen stehen vor der komplexen Aufgabe, ethische Standards und technische Innovationen zu vereinen. Einerseits soll die Nutzung von KI-Technologien gefördert werden, andererseits müssen Missbrauch und Manipulation eingedämmt werden. Die Forderung nach restriktiveren Trainingsdaten und ethischer KI-Nutzung gewinnt zunehmend an Gewicht. So wird diskutiert, ob öffentliche Forendaten wie von Reddit oder Stack Exchange ohne ausdrückliche Genehmigung für Trainingszwecke genutzt werden sollten, da dies die Zuverlässigkeit der generierten Texte beeinflusst.

\n\nLetztendlich blicken wir auf eine Zukunft, in der die Authentizität von online ausgetauschten Texten auf dem Spiel steht. Die Herausforderung besteht darin, die Balance zwischen Freiheit der Meinungsäußerung und dem Schutz vor Manipulation, Spam und Desinformation zu finden. Die Gesellschaft muss lernen, digitale Inhalte kritisch zu hinterfragen und gleichzeitig technologische Lösungen zu entwickeln, die den Dialog fördern und nicht zerstören.\n\nDie Zukunft der Kommentare wird höchstwahrscheinlich durch das Zusammenspiel von menschlichem Urteilsvermögen und maschineller Unterstützung geprägt sein. Die Rolle der Moderation wird wichtiger denn je, während Nutzer selbst wachsam und reflektiert bleiben müssen.

Nur so kann ein Umfeld entstehen, in dem Meinungen transparent und glaubwürdig ausgetauscht werden und die digitale Kommunikation weiterhin wertvoll bleibt.