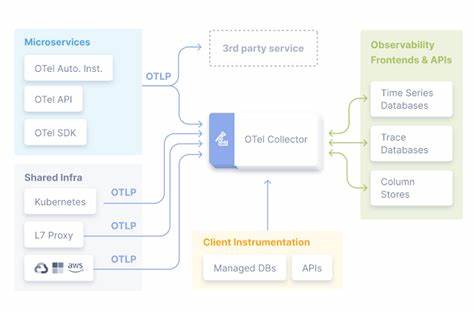

OpenTelemetry, kurz Otel, hat in den letzten Jahren zunehmend an Bedeutung gewonnen, wenn es darum geht, in modernen verteilten Systemen und konkurrierenden Anwendungen Transparenz zu schaffen. Die Fähigkeit, verteilte Traces zu erfassen und aufzubereiten, macht Otel zu einem unverzichtbaren Werkzeug bei der Fehlersuche und Leistungsoptimierung. Trotz all seiner Vorteile ist die Nutzung von OpenTelemetry jedoch nicht frei von Frustrationen. Viele Anwender berichten von einer regelrechten Love-Hate-Beziehung mit Otel, das einerseits extrem nützlich, andererseits aber auch mit diversen Herausforderungen verbunden ist. Vor allem in der Entwicklungsarbeit an kleinen Tools oder lokalen Anwendungen kann das Einrichten von Otel schnell übermäßig komplex werden, sodass die Hemmschwelle für eine Implementierung hoch ist.

Wie gelingt also der pragmatische Einsatz von OpenTelemetry, der die Stärken nutzt, ohne sich in Details und Abhängigkeiten zu verlieren? Das Ziel ist es, Otel so einzusetzen, dass es die eigenen Bedürfnisse erfüllt, ohne unnötigen Aufwand zu verursachen – und genau dafür gibt es praktikable Wege. Viele Einsteiger stoßen bei der Nutzung von Otel auf typische Hürden. Zum Beispiel ist die Einrichtung von Backend-Systemen wie Jaeger, die zur Visualisierung der Traces dienen, nicht gerade trivial. Die offizielle Empfehlung für Jaeger verlangt etwa das Starten mehrerer Container, umfangreiche Konfigurationen und das Offenlegen von Ports, was gerade für Entwickler ohne tieferes Betriebswissen eine Barriere darstellt. Für kleinere Projekte oder bei temporärer Anwendung ist dieser Overhead oft zu groß und wirkt dem eigentlichen Ziel – schneller Einsicht in das Laufzeitverhalten – entgegen.

Alternativ existieren Tools wie der otel-desktop-viewer, der einen Schritt in die richtige Richtung macht. Diese standalone Go-Binaries sind leichter zu betreiben und bieten eine einfache Oberfläche, mit der sich Trace-Daten lokal betrachten lassen. Dennoch besteht hier weiterhin der Nachteil, dass der’application Code eine Netzwerkverbindung zu einem separaten Prozess etablieren muss, was den Workflow unterbricht und in manchen Umgebungen unpraktisch ist. Um solche Komplexität zu umgehen, bietet sich ein einfacherer Ansatz an: Traces lokal in eine Datei schreiben und später entsprechend visualisieren. Dafür eignet sich die Nutzung eines sogenannten stdout-Exporters hervorragend.

Trotz des Namens schreibt dieser Exporter die Trace-Daten nicht zwingend auf die Standardausgabe, sondern lässt sich flexibel auf beliebige Writer umleiten – häufig auf eine Datei. Dieses Vorgehen verzichtet auf die Notwendigkeit, einen externen Trace-Dienst zu betreiben oder sich mit komplexen Exportmechanismen auseinanderzusetzen. Stattdessen wird die gesamte Erfassung und Speicherung lokal und autark gehandhabt, was insbesondere bei Tools ohne eigene Serverkomponente sinnvoll ist. Die Implementierung ist verhältnismäßig simpel. Über eine optionale CLI-Flag, etwa --trace, wird gesteuert, ob Tracing aktiviert wird oder nicht.

Ist die Option gesetzt, öffnet das Programm eine Datei, in die der Exporter alle gesammelten Span-Daten schreibt. Danach wird eine globale Tracer-Instanz konfiguriert und mit einem sogenannten Root-Span startet die Erfassung, die durch context.Context propagiert und in weiteren, instrumentierten Funktionen erweitert wird. Wichtig ist dabei die bewusste Entscheidung, welche Funktionen mit Spans versehen werden. Das Ziel ist es, eine aussagekräftige und gleichzeitig überschaubare Trace-Hierarchie zu erzeugen.

Funktionen, die sehr häufig oder in heißer Schleife aufgerufen werden, sollten eher nicht instrumentiert werden, da sie die Traces mit zu vielen Einträgen überfluten und die Performance beeinträchtigen können. Stattdessen konzentriert man sich auf die übergeordneten Routine- oder Ablaufstrukturen, die das Verhalten sinnvoll zusammenfassen. In der Praxis sind das etwa Funktionen, die komplexe Arbeitsabläufe organisieren oder Datenströme steuern. Diese selektive Instrumentierung stellt sicher, dass die Trace-Daten aussagekräftig und nutzbar bleiben. Ist die Trace-Datei einmal erstellt, stellt sich die Frage der Visualisierung.

Reine JSON-Dateien mit Rohdaten sind für Menschen kaum direkt interpretierbar und bieten wenig Mehrwert ohne geeignete Tools. Während viele Anwender auf große OSS-Werkzeuge oder kommerzielle Dashboards zurückgreifen, lassen sich einfache Visualisierungen auch mit leichtgewichtigen Programmen erzeugen. Ein Beispiel hierfür ist „trot“, ein selbst entwickeltes Tool, das rohe Trace-Daten in eine HTML-Datei umwandelt und so einen schnellen Überblick ermöglicht. Der Vorteil liegt darin, dass keine komplexen Installationen oder Netzwerkdienste erforderlich sind. Einfach die erzeugte HTML-Datei im Browser öffnen und die Trace-Struktur wird visuell aufbereitet.

Wer dennoch die Vorteile eines voll ausgestatteten Trace Viewers nutzen möchte, ohne direkt und live eine Export-Verbindung aufzubauen, kann Tools wie „retrace“ einsetzen. Diese fungieren als Brücke, indem sie die zwischengespeicherten Speicherdateien neu über den HTTP-Exporter ausspielen und so Kompatibilität mit etablierten Dashboards wie otel-desktop-viewer herstellen. Das ermöglicht eine flexible Mischung aus einfachen lokalen Workflows und professioneller Analyse-Infrastruktur. Zusammengefasst bietet der beschriebene pragmatische Ansatz erhebliche Vorteile. Entwickler müssen weder Container oder Ports managen, noch ihre Projekte in komplexe Abhängigkeitsstrukturen zwingen.

Stattdessen können sie bei Bedarf einfach lokal Trace-Daten erzeugen, bei Ruhezeit analysieren und so gezielt optimieren. Dieses Vorgehen fördert einen entspannten Workflow und erleichtert die Diagnostik insbesondere in kleineren Teams oder bei Tool-Entwicklung. Trotz der vielen organisatorischen und technischen Schwierigkeiten lohnt sich die Beschäftigung mit OpenTelemetry zweifellos. Es verändert die Art und Weise, wie man Fehler sucht, Antworten auf Leistungsfragen findet oder die Architektur versteht. Dabei geht es nicht darum, immer das komplexeste Setup zu betreiben, sondern Werkzeuge genau auf die eigenen Bedürfnisse zuzuschneiden und pragmatisch zu nutzen.

Wer bereit ist, sich auf diesen Kompromiss einzulassen, gewinnt ein mächtiges Hilfsmittel, das dank seiner Offenheit und Flexibilität langfristig Verbesserungen in der Software-Qualität und -Wartbarkeit ermöglicht. In der Softwareentwicklung stellt sich oft die Frage, wie viel Aufwand man für Observability investieren soll. OpenTelemetry kann dabei mehr sein als eine Pflichtübung – als Werkzeug ohne unnötigen Ballast wird es zum Verbündeten, der echten Mehrwert liefert. Die Liebe zu Otel entsteht aus den realen Möglichkeiten, Grenzen zu überwinden. Die Abneigung resultiert dagegen aus allem, was den einfachen Zugang erschwert.

Die beste Lösung liegt darin, Wege zu finden, auf die Stärken zu setzen und den Rest über Bord zu werfen. Im täglichen Einsatz hilft dieser Fokus nicht nur, Zeit zu sparen, sondern auch, die Debugging-Erfahrung ohne Frust zu verbessern. Wer sich den Herausforderungen stellt und OpenTelemetry mit pragmatischem Blick nutzt, wird schnell entdecken, wie wertvoll das Tool in der modernen Softwareentwicklung sein kann.