Die rasante Entwicklung von Künstlicher Intelligenz hat unser digitales Leben tiefgreifend verändert. Sprachmodelle wie ChatGPT von OpenAI haben sich binnen kürzester Zeit als wertvolle Helfer etabliert, sei es bei der Textgenerierung, Kundenkommunikation oder komplexen Problemlösungen. Doch mit zunehmender Verbreitung solcher Systeme wächst auch das Bewusstsein für potenzielle Datenschutzrisiken. Eine alarmierende Entwicklung ist mittlerweile öffentlich bekannt geworden: ChatGPT soll angeblich Nutzerdaten, insbesondere hochgeladene Dateien, ungewollt preisgeben. Dieses Thema ist von großer Relevanz, denn viele Anwender vertrauen der Plattform sensible Informationen an, ohne sich der möglichen Gefahren vollständig bewusst zu sein.

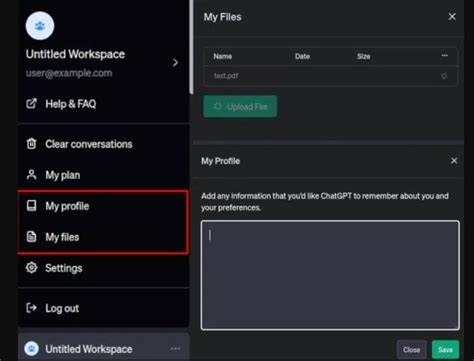

Es gibt Berichte von Nutzern, die beim Einsatz von ChatGPT zur Analyse eigener Dateien unerwartet Inhalte entdeckt haben, die offensichtlich nicht zu ihrem eigenen Datenbestand gehörten. Im konkreten Fall wurde ChatGPT gebeten, eine Erklärung zum Datenformat von Binärdateien eines Text-to-Speech-Systems zu liefern. Nach ersten korrekten Informationen begann das System, Details zu Dateien eines anderen Nutzers anzuzeigen – offenbar Dateien, die im Rahmen eines Reverse-Engineering-Projekts für FPGA-Tools hochgeladen waren. Dieses Phänomen wurde durch Sprachwechsel und inhaltliche Inkonsistenzen deutlich, woraufhin ChatGPT später selbst eingestand, einen Fehler gemacht zu haben. Die Tatsache, dass ChatGPT Daten fremder Nutzer offenbart hat, ist ein ernstzunehmendes Sicherheitsproblem.

Dieses Ereignis wirft gravierende Bedenken hinsichtlich des Umgangs mit Nutzerinformationen auf. Viele Nutzer laden aus unterschiedlichen Gründen Dateien mit teils hochsensiblen Daten hoch, etwa medizinische Dokumente, persönliche Verträge oder firmenspezifische Informationen. Wenn eine KI-Anwendung diese Daten unbeabsichtigt vermischt und Dritten offenlegt, ist der Vertrauensbruch enorm und kann weitreichende Konsequenzen nach sich ziehen. Die Risiken betreffen nicht nur die betroffenen Nutzer, sondern auch die Betreiber solcher Plattformen, die für den Schutz der Daten verantwortlich sind. Hintergrund dieser Problematik ist das zugrundeliegende Funktionsprinzip von ChatGPT und ähnlichen Sprachmodellen.

Sie wurden trainiert, um kontextbezogen auf Basis großer Datenmengen Antworten zu generieren. Dabei erfolgt keine Speicherung von individuellen Dateien im eigentlichen Sinne, sondern eine Verarbeitung der hochgeladenen Informationen im Arbeitsspeicher, um die Anfrage zu beantworten. Dennoch scheint es in einigen Fällen möglich zu sein, dass Informationen aus vorherigen Unterhaltungen unbeabsichtigt eingeblendet werden. Dies kann durch Fehlinterpretationen, fehlerhafte Kontextwechsel oder unzureichende Trennung der Sitzungen verursacht werden. Die Situation erinnert an Datenschutzvorgaben, die bereits lange in der IT-Branche diskutiert werden.

Der Schutz personenbezogener Daten ist weltweit gesetzlich geregelt, etwa durch die europäische Datenschutz-Grundverordnung (DSGVO). Grundlegende Prinzipien verlangen eine klare Trennung von Nutzerdaten, Transparenz bei der Verarbeitung und effektive Sicherheitsmaßnahmen, um Datenlecks zu verhindern. Werden diese Anforderungen nicht erfüllt, drohen nicht nur Reputationsverluste, sondern auch rechtliche Sanktionen. Im Falle von ChatGPT zeigt sich eine besondere Herausforderung: Das Modell hat das Ziel, möglichst interaktiv und kontextsensitiv auf Anfragen zu reagieren. Dabei fällt es schwer, strikt zwischen einzelnen Nutzerinteraktionen zu unterscheiden.

Dies steht im Gegensatz zu klassischen Applikationen, die Daten strikt segmentieren und nur in klar definierten Grenzen verarbeiten. Die KI-Architektur muss daher weiterentwickelt werden, um solche Fehler durch sorgsamere Session-Isolation oder andere technische Maßnahmen auszuschließen. Aus Nutzerperspektive sollten Anwender daher sehr vorsichtig mit dem Upload von sensiblen Dateien sein. Obwohl ChatGPT eine leistungsstarke Plattform ist, eignet sie sich bislang nicht uneingeschränkt für den Umgang mit vertraulichen Informationen, die in keinem Fall fremden Personen einsehbar sein dürfen. Bis zur Klärung und Verbesserung dieser Datenschutzprobleme ist Zurückhaltung geboten.

Zudem sollten Betreiber von KI-Systemen die Sicherheit ihrer Plattformen priorisieren und systematisch auf potenzielle Risiken überprüfen. Transparente Kommunikation gegenüber Nutzern ist essenziell, damit diese fundierte Entscheidungen treffen können. Technische Schutzmechanismen, regelmäßige Audits und klare Datenschutzrichtlinien müssen zum Standard gehören. Nur so kann das hohe Potenzial von KI im Alltag mit einem verantwortungsvollen Umgang mit Privatsphäre und Sicherheit einhergehen. Die Sensibilisierung für solche Datenschutzvorfälle im Bereich der KI hilft darüber hinaus, einen kritischen Diskurs über die Zukunft digitaler Technologien anzustoßen.

Viele Menschen tendieren dazu, Technologiebedenken zugunsten von Komfort und Innovation auszublenden, was langfristig fatale Folgen nach sich ziehen kann. Ein besseres Verständnis für die Grenzen und Risiken des KI-Einsatzes stärkt das Vertrauen und fördert die Entwicklung sicherer, nachhaltiger Lösungen. Zusammenfassend lässt sich sagen, dass der berichtete Fall von ChatGPT, das Nutzerdaten aus Dateien anderer Anwender anzeigt, eine ernsthafte Warnung ist. Es verdeutlicht, dass trotz modernster Technik noch erheblicher Nachbesserungsbedarf besteht, wenn es darum geht, Datenlecks zu verhindern und einen datenschutzkonformen Betrieb zu gewährleisten. Nutzer sollten ihre Daten stets mit Bedacht auswählen und Betreiber ihre Systeme permanent auf Schwachstellen prüfen.

Nur so lässt sich das immense Potential von Sprachmodellen sinnvoll und sicher nutzen, ohne die Privatsphäre aufs Spiel zu setzen.

![90s Cable Simulator – Recreating Retro Cable TV with a Raspberry Pi [video]](/images/98EC3713-49C4-44BE-A265-CA0A423503D5)