Im heutigen digitalen Zeitalter bewegt sich ein großer Teil des Internetverkehrs nicht mehr nur in Form menschlicher Interaktionen, sondern wird von sogenannten Bots generiert. Diese Softwareprogramme sind für viele nützliche Dienste unverzichtbar - von der Indexierung durch Suchmaschinen bis hin zu automatisierten Kundeninteraktionen. Gleichzeitig birgt die Präsenz von Bots auch erhebliche Gefahren. Denn fast die Hälfte des gesamten Internetverkehrs stammt inzwischen von Bots, von denen ein beträchtlicher Teil bösartige Zwecke verfolgt. Diese Bots sind verantwortlich für Distributed-Denial-of-Service-Angriffe, das massenhafte Sammeln sensibler Daten, den Versuch von Kontoübernahmen durch Credential Stuffing, Spam-Verbreitung und betrügerische Klickmanipulationen.

Angesichts dieser eskalierenden Bedrohungslage sind robuste Verteidigungsmechanismen unabdingbar geworden. Als Antwort auf diese Herausforderungen haben sich Unternehmen wie Cloudflare als zentrale Lösungen etabliert. Cloudflare ist ein marktführender Anbieter von Content Delivery Netzwerken (CDN) und Sicherheitsdiensten, der als Schutzschild für einen erheblichen Teil der Webinhalte fungiert. Durch eine Zwischenschaltung zwischen Besuchern und Websites werden Zugriffsversuche gefiltert und analysiert. Dabei kommen komplexe Techniken zum Einsatz: Von der Bewertung des IP-Rufs über die Analyse von Verkehrsmustern bis hin zur Überprüfung von Browser-Fingerprints wie TLS- und HTTP-Signaturen werden verschiedene Parameter ausgewertet.

Zudem erhöhen JavaScript-Challenges und Captcha- oder Turnstile-Abfragen die Schutzwirkung. Ergänzend erlaubt der Einsatz moderner maschineller Lernverfahren, die auf einem riesigen Netzverkehr basieren, das Erkennen und Abwehren von Schadaktivitäten in Echtzeit. Dieses vielschichtige Sicherheitsnetz ist für Unternehmen und Nutzer gleichermaßen unerlässlich im Kampf gegen die Flut an Bot-Angriffen. Doch trotz dieser fortschrittlichen Schutzmaßnahmen gibt es eine unterschätzte Schattenseite. Diese Sicherheitsbarrieren wirken oft wie ein zweischneidiges Schwert.

Denn die Verfahren, die speziell darauf ausgelegt sind, auch hochentwickelte bösartige Bots zu identifizieren und zu blockieren, greifen häufig zu unscharf. So geraten auch legitime automatisierte Dienste in den Fokus und werden blockiert. Dieses sogenannte Kollateralschaden-Phänomen betrifft eine Reihe von wichtigen Akteuren im Internetökosystem und hat weitreichende Folgen. Unter diesen betroffenen Gruppen befinden sich vor allem Sicherheits-Scanner. Diese Tools sind entwickelt worden, um Websites automatisiert auf schädliche Inhalte, Phishing-Seiten oder technische Schwachstellen hin zu untersuchen.

Sie sind essenziell für die frühzeitige Erkennung von Gefahren und spielen eine Schlüsselrolle bei der Gewährleistung der Web-Sicherheit. Ihre charakteristische Arbeitsweise führt jedoch dazu, dass sie oft von Anti-Bot-Systemen als verdächtig eingestuft werden. Die automatisierte Natur, schnell hoher Zugriff unter Nutzung von Rechenzentrum-IP-Adressen und das wiederholte Auslesen von Webseiteninhalten lösen häufig Schutzmechanismen aus. Anstelle direkt auf die Website zugreifen zu können, werden diese Scanner ins Leere geschickt oder mit Captchas, Javascript-Challenges oder Rate-Limiting konfrontiert. Dies führt nicht nur zu Verzögerungen, sondern kann ganze Scansystems lähmen und damit die allgemeine Sicherheit des Internets schwächen.

Auch digitale Webarchive wie die Internet Archive’s Wayback Machine oder Projekte wie Common Crawl spüren diese Auswirkungen deutlich. Diese Dienste sind entscheidend für die langfristige Archivierung von Webinhalten und Forschungszwecke, um etwa historische Veränderungen oder digitale Entwicklungen zu dokumentieren. Blockaden, die sich in HTTP 403-Fehlermeldungen oder expliziten Sperrseiten äußern, führen zu Informationsverlusten und zeitlichen Lücken in der digitalen Historie. Diese Problematik ist nicht nur für Forscher problematisch, sondern auch für die Bewahrung des kollektiven Kultur- und Wissenserbes. Darüber hinaus sind akademische Forscher, die eigene automatisierte Crawler für Untersuchungen zu Web-Trends, Desinformation oder Barrierefreiheit einsetzen, ebenso von diesen Schutzsystemen betroffen.

Ihre Arbeitssicherheit wird erheblich eingeschränkt, was auch die Entwicklung neuer Erkenntnisse und innovativer Lösungen behindert. Selbst Monitoring-Dienste, mit denen Website-Betreiber die Erreichbarkeit und Performance ihrer Seiten überprüfen, können durch Anti-Bot-Maßnahmen fehlerhafte Daten liefern oder komplett geblockt werden, wenn sie nicht explizit in Filterregeln einbezogen sind. Ein besonders kritischer Aspekt besteht jedoch darin, dass die Verzögerung oder Verhinderung von Sicherheits-Scans eine verlängerte Angriffszeit für bösartige Akteure bedeutet. Dabei zeigen Studien, dass beispielsweise Phishing-Seiten oft nur wenig Stunden online sind, bevor sie von traditionellen Blocklisten erkannt und gesperrt werden. Hier bestehen deutliche Zeitunterschiede: Während in manchen Untersuchungen die mittlere Lebensdauer eines Phishing-Portals bei etwa 5,5 Stunden liegt, dauert es bei einigen großen Blockierungsdiensten wie Google Safe Browse im Durchschnitt mehrere Tage, bis diese Seiten erfasst werden.

Blockaden gegenüber automatisierten Scannern vergrößern diese Zeitfenster erheblich und verschaffen Angreifern somit mehr Chancen, Opfer zu täuschen und zu schädigen. Hinzu kommt, dass viele bösartige Websites durch Anti-Bot-Dienste gerade erst geschützt werden. Cyberkriminelle wissen um die Schwächen der Abwehr und nutzen gezielt Cloudflare & Co., um hinter der Verteidigung Schutz zu suchen. Sie verstecken Phishing-Seiten, Malware-Verteilungsplattformen oder Command-and-Control-Server hinter diesen Netzwerken.

Funktionen wie Cloudflare Tunnels werden missbraucht, um lokale Schadsoftware wie AsyncRAT, XWorm oder GuLoader zu hosten und die Spuren zu verwischen. Gleichzeitig verwenden Angreifer Cloudflare Turnstile in Phishing-Kits, um automatische Scanner auszubremsen und für Besucher eine trügerische Seriosität zu schaffen. Selbst Cloudflare WARP IP-Bereiche werden als Angriffspunkt genutzt, da viele Unternehmensfirewalls diesen Netzwerkverkehr unkritisch behandeln. Ein weiteres Problemfeld stellen sogenannte Grauzonen-Scams dar. Dabei handelt es sich um betrügerische Angebote wie falsche Investmentplattformen, gefälschte Online-Shops oder Täuschungen mit Abonnementfallen, die oft auf den ersten Blick legitim aussehen und keinen klassischen Schadcode ausführen.

Diese Seiten entziehen sich vielen herkömmlichen Sicherheitswarnungen, da sie keine expliziten Malware-Signaturen enthalten. Die gleichen Schutzmechanismen, die Bots abwehren, blockieren unfreiwillig auch automatisierte Untersuchungen, die solche Täuschungen aufdecken könnten. Das Ergebnis ist eine verlängerte Lebensdauer für betrügerische Websites und damit ein erhöhtes Risiko für Konsumenten. Die Bekämpfung dieser Herausforderungen erfordert speziell von Sicherheitsfirmen große technische und finanzielle Anstrengungen. Herkömmliche simple Zugriffe genügen nicht mehr, um Anti-Bot-Mechanismen zu umgehen.

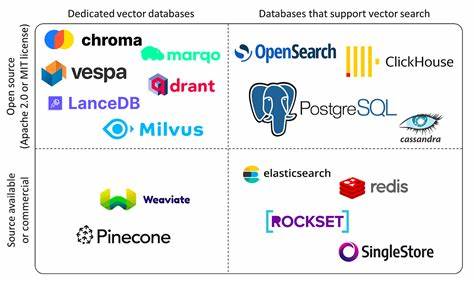

Stattdessen bedarf es ausgefeilter Browser-Emulationstechniken, die Puppeteer oder Playwright nutzen und so konfiguriert sind, dass sie nicht als automatisiert erkannt werden. Hinzu kommen kostspielige, residential Proxies, die echte Nutzer-IP-Adressen simulieren, und manchmal der Einsatz von CAPTCHA-Lösediensten, die durch menschliche oder KI-basierte Systeme den Schutz durchbrechen. Diese Methoden sind teuer, komplex und stehen teilweise in einem rechtlichen sowie ethischen Graubereich. Sie erhöhen die Hürden für innovative Sicherheitsansätze erheblich. Cloudflare hat das Problem erkannt und versucht mit Programmen wie dem Verified Bot Program, einigen legitimen Akteuren den Zugang zu erleichtern.

Dieses erlaubt eine Whitelist für zertifizierte Bots, die strengen Kriterien entsprechen, einschließlich ihrer IP-Verifizierbarkeit und Transparentz. Websitebetreiber mit den nötigen Kenntnissen und Ressourcen können zudem detaillierte Regeln konfigurieren, um legitimen Scanner-Traffic gezielt zuzulassen. Dennoch sind diese Optionen nicht für alle Sicherheitsdienste praktikabel, besonders für kleinere oder spezialisierte Scanner, die keinen direkten Kontakt zu allen Website-Inhabern pflegen. Es zeichnet sich ab, dass es ohne eine verbesserte Zusammenarbeit und Kommunikation zwischen Infrastrukturprovidern, Website-Betreibern, Sicherheitsfirmen und Forschern nur schwer möglich ist, den Zielkonflikt zwischen effektiver Bot-Abwehr und dem Erhalt legitimer automatisierter Dienste aufzulösen. Ein höherer Differenzierungsgrad in der Klassifikation von Bots sowie transparente und standardisierte Authentifizierungsverfahren könnten die Situation verbessern.

![New computers don't speed up old code [video]](/images/9CFB9055-4ED3-42CA-B8DC-D10F7B7A6E8B)