Die Entwicklung der Künstlichen Intelligenz (KI) hat in den letzten Jahrzehnten enorme Fortschritte gemacht, doch die Diskrepanz zwischen biologischer Intelligenz und maschinellem Lernen bleibt weiterhin bestehen. Während neuronale Netze imitiert sind von biologischen Gehirnen, fehlen modernen Modellen oft wesentliche Eigenschaften, die die menschliche Gehirnfunktion auszeichnen, insbesondere das zeitliche Zusammenspiel neuronaler Aktivitäten. An diesem Punkt setzen die Continuous Thought Machines (CTM) an – ein neues Modell, das die Dynamik biologischer Neuronen durch neuronale Synchronisation und zeitliche Prozesse in die KI integriert, um Flexibilität, Anpassungsfähigkeit und tiefere kognitive Fähigkeiten zu ermöglichen. Continuous Thought Machines repräsentieren einen innovativen Ansatz, bei dem neuronale Aktivität nicht als statischer Wert, sondern als zeitlich dynamische Synchronisation verstanden wird. Klassische neuronale Netze vereinfachen neuronale Aktivität meist auf die reine Aktivierungsstärke, ohne das Timing oder die Synchronisation zwischen Neuronen zu berücksichtigen.

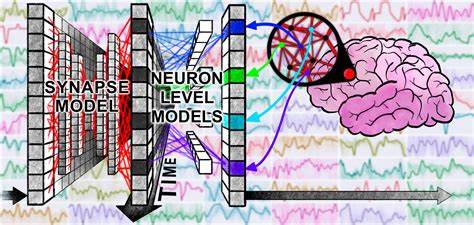

Im Gegensatz dazu modellieren CTMs eine interne Dimension, die als eine Abfolge von „Gedankenschritten“ oder „internal ticks“ beschrieben wird, über die neuronale Signale synchronisiert und weiterverarbeitet werden, was eine Art kontinuierliches Nachdenken simuliert. Eine der grundlegenden Innovationen der CTM ist die sogenannte Dekopplung der internen Dimension vom Datenstrom. Anstatt einfach nur sequenzielle Eingabedaten Schritt für Schritt zu bearbeiten, arbeitet das System mit einer inneren Zeitachse, über die Gedanken oder Berechnungen entfaltet und verfeinert werden können. Diese innere zeitliche Achse erlaubt die iterative Verarbeitung selbst bei statischen Daten wie Bildern oder komplexen Aufgaben wie dem Lösen von Labyrinthen. Ein weiteres zentrales Element sind neuronale Modelle auf Einzelebene, sogenannte Neuron-Level-Modelle.

Jedes Neuron besitzt sein eigenes kleines Modell mit individuellen Parametern, das eine Aktivitätsgeschichte seiner Eingänge über die Zeit verarbeitet. Dies erzeugt eine hochdetaillierte innere Dynamik, die von klassischen statischen Aktivierungsfunktionen wie ReLU(s) weit entfernt ist. Dadurch entstehen komplexe neuronale Aktivitätsmuster, welche die Grundlage für zeitbasierte Informationsverarbeitung bilden. Das Herzstück der CTM ist jedoch die Nutzung neuronaler Synchronisation als Repräsentation. Das bedeutet, dass das System nicht nur darauf achtet, wie stark einzelne Neuronen feuern, sondern wie ihre Aktivitätsmuster über die Zeit miteinander synchronisiert sind.

Diese Synchronisationsmatrix – ein Produkt der zeitlichen Überlagerung von neuronalen Aktivitäten – wird direkt verwendet, um Eingaben zu beobachten und Ausgaben vorherzusagen. Dadurch weist das Modell eine wesentlich größere und feinere Repräsentationsfähigkeit auf, die nicht nur auf individuellen, sondern auch auf relationalen neuronalen Dynamiken basiert. Die Anwendungsmöglichkeiten der Continuous Thought Machines sind breit gefächert und selbst unter den ersten Experimenten beeindruckend. So zeigt ein interaktives Demo beispielhaft die Fähigkeit des CTMs, komplexe Labyrinthe zu lösen. Im Gegensatz zu herkömmlichen Ansätzen, die oft auf vorgefertigte Positionsinformationen oder externe Tools angewiesen sind, baut der CTM eine interne, dynamische Weltkarte auf, die ihm erlaubt, auch über lange und komplexe Pfade hinweg zu navigieren.

Diese flexible Navigation beruht auf dem synchronisierten zeitabhängigen Gedankenprozess und erweist sich selbst bei stark verlängerten Routen als robust. Auch in klassifizierenden Aufgaben wie der Bilderkennung auf ImageNet demonstriert der CTM beeindruckende Fähigkeiten. Mit wachsender Anzahl an inneren Denk-Schritten verbessert sich nicht nur die Genauigkeit, sondern auch die Zuverlässigkeit der Vorhersagen, was sich in einer bemerkenswerten Kalibrierung widerspiegelt. Das bedeutet, dass das Modell seine Unsicherheit in den Vorhersagen besser einschätzen kann als herkömmliche Modelle und sogar in einigen Fällen besser als menschliche Probanden – ein bedeutender Fortschritt in Richtung vertrauenswürdiger KI-Systeme. Darüber hinaus zeigen CTMs exzellente Leistungen bei Aufgaben, die mit längeren Abhängigkeiten oder speicherintensiven Prozessen verbunden sind.

Bei einem Paritätsproblem, das von klassischen RNNs nur schwer gelöst werden kann, wenn die gesamte Datensequenz auf einmal vorliegt, kann ein CTM durch seine interne Zeitentfaltung und Synchronisation die Lösung zuverlässig erlernen. Der CTM operiert dabei nicht nur sequentiell, sondern zeigt die Fähigkeit, rückwärts oder vorwärts durch die Daten zu navigieren und so eine Art Planung und strategisches Denken umzusetzen. Ebenso wird das Gedächtnisvermögen des CTM anhand der Q&A MNIST-Aufgabe getestet. Diese etabliert eine Herausforderung, bei der der Computer sich an vorangegangene Zahlen erinnern und komplexe, modulare Operationen durchführen muss. CTMs besitzen hier den Vorteil, dass durch die zeitliche Organisation und Synchronisation neuronaler Aktivitäten eine Art Langzeitgedächtnis entsteht, welches die spätere Erinnerung und Berechnung ermöglicht—ein Befund, der das Potenzial der CTM in kognitiven Architekturen bestätigt.

Im Vergleich zu klassischen Modellen wie LSTMs zeigen CTMs nicht nur bessere oder vergleichbare Leistungen, sondern auch eine deutlich höhere Robustheit in zahlreichen Szenarien und eine verbesserte Fähigkeit zur Generalisierung. Dies beruht maßgeblich auf der erweiterten Darstellung durch neuronale Synchronisation, die das Modell befähigt, komplexe interne Prozesse zu verfolgen, die bei anderen Ansätzen übermäßig schwierig oder ineffizient sind. Die CTM-Architektur ist bemerkenswert vielseitig und benötigt im Allgemeinen nur minimale Anpassungen für unterschiedliche Aufgaben, ob es sich um Bildklassifikation, logische Algorithmen, Pfadfindung oder Speicheraufgaben handelt. Diese Konsistenz in Design und Leistung spricht dafür, dass das grundlegende Prinzip einer zeitbasierten neuronalen Synchronisation ein natürlicher und leistungsstarker Baustein für KI der Zukunft sein könnte. Darüber hinaus adressiert die CTM einen kritischen Aspekt der biologischen Intelligenz, der in der KI-Forschung oft vernachlässigt wurde: die Rolle der Zeit.

Während aktuelle neuronale Netze vor allem statische Eingabemuster verarbeiten, legen biologische Gehirne großen Wert auf die genaue zeitliche Abstimmung und Synchronisation von neuronaler Aktivität, was sich in komplexen Verhaltensweisen, flexibler Anpassung und Lernen niederschlägt. Die CTM versucht genau diese zeitlichen Dimensionen einzufangen und in effektive Rechenmechanismen zu transformieren. Durch die Parallele zur Biologie bietet die CTM auch eine spannend interpretierbare Perspektive auf neuronale Prozesse. Die sichtbaren Muster der neuronalen Dynamik in ihren verschiedenen Aufgaben lassen sich analysieren, visualisieren und in gewisser Weise nachvollziehen. So zeigt sich beispielsweise in einer UMAP-Projektion, wie die neuronalen Aktivitäten komplexe, mehrskalige „Reisewellen“ oder oszillatorische Muster bilden, die in konventionellen Netzwerken kaum beobachtet werden können.

Während die Forschungsarbeit zu den Continuous Thought Machines noch relativ neu ist, eröffnet sie eine Vielzahl von Forschungsperspektiven. Eine spannende Frage lautet, wie CTMs sich in noch komplexeren Umgebungen bewähren, etwa in Videospielen oder in dynamischeren realweltlichen Umgebungen, ohne explizite Positionsinformationen. Auch die Skalierung auf größere Modelle und tiefere Kombinationen mit anderen KI-Prinzipien bietet ein vielversprechendes Entwicklungspotenzial. Zusätzlich stellt der Einsatz von CTMs in Bereichen wie dem Reinforcement Learning eine wichtige Brücke dar. Erste Experimente zeigen, dass CTMs mit Methoden wie proximaler Policy-Optimierung umgehen können, um Navigationsaufgaben oder klassisch schwer zu handhabende Steuerungsprobleme zu meistern.

Dabei nutzen sie die kontinuierliche Historie neuronaler Aktivität als eine Art intern persistenten Zustand, der das Verhalten verbessert und die Lernfähigkeit steigert. Das Gesamtbild lässt darauf schließen, dass Continuous Thought Machines den Weg zu einer neuen Generation von KI-Systemen ebnen, bei der Zeit, Synchronisation und neuronale Dynamik zentrale Rollen spielen. Diese Ansätze stellen eine Annäherung an die tiefen Prinzipien der biologischen Intelligenz dar, ohne dabei den praktischen Einsatz aus den Augen zu verlieren. Die Balance zwischen biologisch inspirierter Komplexität und maschineller Skalierbarkeit macht CTMs zu einem besonders spannenden Forschungsfeld. Abschließend lässt sich sagen, dass Continuous Thought Machines ein kraftvolles Konzept darstellen, das einige der fundamentalen Limitationen heutiger KI überschreiten kann.

Durch die Verknüpfung von Selbstorganisation über die interne Zeitachse, individuelle neuronale Modelle und Synchronisationsrepräsentationen schaffen sie eine flexible Denkplattform, die viele kognitive Prozesse natürlicher und effizienter abbildet. Dies hat das Potenzial, nicht nur Fortschritte im Bereich der Mustererkennung oder Planung zu erzielen, sondern auch die Tür für KI-Systeme zu öffnen, die wirklich lernen, denken und sich anpassen können wie biologische Organismen.