Große Sprachmodelle (Large Language Models, LLMs) sind längst zu einem entscheidenden Instrument in der modernen Künstlichen Intelligenz geworden. Sie revolutionieren zahlreiche Branchen – von der Softwareentwicklung über die Textgenerierung bis hin zur Kundenbetreuung. Doch mit der Vielzahl an verfügbaren Modellen wächst die Herausforderung: Welches Modell ist für welchen Anwendungsfall am besten geeignet? Worauf sollte beim Vergleich geachtet werden? Genau hier kommt das Benchmarking ins Spiel – die systematische Bewertung und Messung von KI-Modellen anhand definierter Kriterien. Benchmarking ist mehr als nur ein Trend, es ist eine grundlegende Methode, um Transparenz, Vertrauenswürdigkeit und Qualität bei generativen KI-Systemen sicherzustellen. Neben klassischen Parametern wie Rechenleistung oder Speicherverbrauch geht es bei der Bewertung von LLMs vor allem um deren Problemlösungskompetenz und Verlässlichkeit.

Doch der Weg von einfachen Leistungstests zu umfassenden Evaluierungen gestaltet sich komplex und verlangt tiefgehendes Verständnis. Traditionelle Softwaremetriken messen Aspekte wie Geschwindigkeit oder Energieeffizienz, doch bei LLMs steht die Fähigkeit im Fokus, komplexe Sachverhalte zu verstehen, logisch zu schlussfolgern, Code zu generieren oder sinnvolle Zusammenfassungen zu erstellen. Daher sind Benchmark-Tests speziell dafür ausgelegt, diese vielfältigen Fähigkeiten objektiv zu messen und damit Vergleichbarkeit zu gewährleisten. Doch worum handelt es sich bei LLM-Benchmarks genau und wie funktionieren sie? Grundsätzlich sind es standardisierte Testverfahren mit spezifischen Aufgabenstellungen, die ein Modell lösen muss. Diese Aufgaben können sich auf viele Bereiche erstrecken – zum Beispiel mathematisches Denken, naturwissenschaftliches Wissen, Sprachverständnis oder Codegenerierung.

Das Modell wird anhand vorgegebener Metriken wie Genauigkeit und Vollständigkeit bewertet und mit einer Punktzahl versehen. So lassen sich verschiedene Modelle gezielt auf Schwächen und Stärken hin analysieren und mit Blick auf den Anwendungszweck auswählen. Im Ablauf eines Benchmarks unterscheidet man mehrere Phasen. Zukünftig notwendige Vorbereitungen beinhalten die Datenaufbereitung: Die Auswahl und Gestaltung der Testszenarien ist von zentraler Bedeutung, denn der Test muss sowohl aussagekräftig als auch fair sein. Danach wird das Modell getestet – entweder ohne vorherige Beispiele zu sehen (zero-shot), mit einigen Beispielen als Orientierung (few-shot) oder durch eine Anpassung des Modells an den Test (fine-tuning).

Schließlich erfolgt die Bewertung der Ergebnisse, die oft in Punktwerten zwischen 0 und 100 zusammengefasst werden. Dabei stehen funktionale Aspekte wie Genauigkeit sowie nicht-funktionale Merkmale im Fokus. LLM-Benchmarks ähneln menschlichen Prüfungen, bei denen entweder ein spezielles Fachwissen oder eine breit gefächerte Kompetenz gemessen wird. Die Tests können einfache Wissensfragen, komplexe Problemlösungen oder sogar logisches Denken umfassen. Auch Teilbereiche von Sprachverständnis, wie zum Beispiel die Fähigkeit, auf Basis eines Textes logische Schlussfolgerungen zu ziehen oder den Bezug eines Pronomens korrekt zu bestimmen, werden berücksichtigt.

Eine der Hauptherausforderungen bei LLM-Benchmarks ist die Bewertung, da oft eine eindeutige Antwort verlangt wird. Tests mit mehreren richtigen Antworten sind schwer objektiv zu bewerten und somit teuer und aufwendig. Zudem sind manche Benchmarks urheberrechtlich geschützt und dürfen nicht veröffentlicht werden. Diese Geheimhaltung soll verhindern, dass Modelle diese Tests bereits in ihrem Trainingsmaterial kennen und damit nur Mustererkennung demonstrieren statt echtes Verständnis. Das Phänomen des Overfittings beschreibt genau dieses Problem: Die Modelle lernen die Prüfungsdaten zu spezifisch und verlieren ihre allgemeine Problemlösefähigkeit.

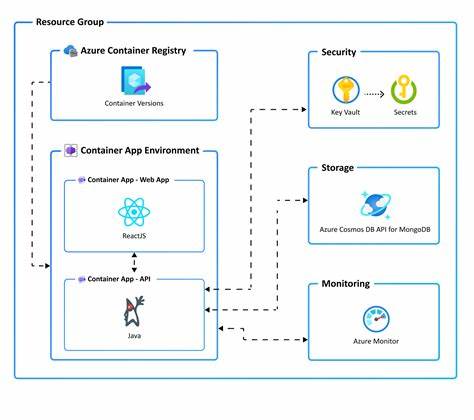

Um eine verlässliche Bewertung zu erzielen, wird oft auf methodische Kontrollmechanismen wie Randomisierung oder mehrfache Testdurchläufe gesetzt. Die technische Umsetzung von Benchmark-Tests erfolgt meist automatisiert über Schnittstellen (APIs), Skripte und Programmierungen. So können viele Modelle systematisch getestet, Ergebnisse gesammelt und mit herkömmlichen Leistungsdaten wie Antwortzeit verknüpft werden. Stark in die Bewertung einfließen auch Einstellungen, die die Ausgabe deterministischer oder variabler machen – bei ChatGPT etwa die Temperatursteuerung, mit der man Zufälligkeit einschränken kann. Die Vielfalt der bekannten LLM-Benchmarks ist groß und ihre Schwerpunkte unterschiedlich.

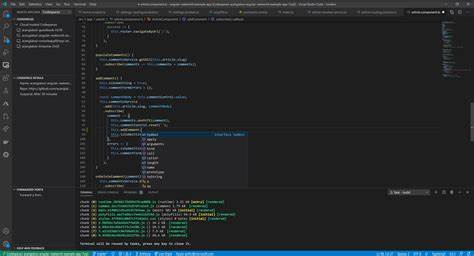

Der Massive Multitask Language Understanding Test (MMLU) misst Leistungen über 57 Kategorien aus verschiedenen Wissenschafts- und Geistesgebieten. Ein weiteres anspruchsvolles Benchmark ist GPQA, das Fachwissen auf PhD-Niveau in Biologie, Physik und Chemie abfragt und sogar unterschiedliche Schwierigkeitsstufen besitzt. HumanEval hingegen fokussiert sich auf die Programmierung, speziell das Generieren von Python-Code anhand von Textbefehlen und die Überprüfung durch Unittests. Mathematische Kompetenzen adressiert das AIME-Examen, ein anspruchsvoller Wettbewerb, der komplexe Highschool-Mathematik aufbereitet und somit Modelle auf Lösungsfähigkeiten in mathematischen Problemstellungen prüft. Verständnis und logisches Denken testet HellaSwag, indem es vom Modell verlangt, aus mehreren plausiblen, aber nur einer korrekten Fortsetzung eine richtige Auswahl zu treffen.

Für dialogorientierte Modelle und Chatbots ist MT-Bench eine wichtige Bewertungsgrundlage, da es die Fähigkeit in mehrstufigen Gesprächen analysiert und die Anpassungsfähigkeit an neue Informationen prüft. Die Genauigkeit und Wahrheitsgemäßheit der Antworten ist das Ziel von TruthfulQA. Hier wird untersucht, ob Modelle falsche Prämissen erkennen und korrekte, sachlich richtige Informationen liefern können. Aufgrund der enormen Vielfalt an Modellen und Benchmarks gestaltet sich eine vergleichende Bewertung kompliziert. Community-Plattformen wie Hugging Face bieten Leaderboards und Vergleichstabellen, wo Nutzer Ergebnisse teilen und aktualisieren.

Doch nicht jeder Benchmark ist dort vertreten, insbesondere proprietäre Tests sind oft nur eingeschränkt zugänglich. Neben offenen Plattformen existieren spezialisierte Anbieter, wie zum Beispiel Vellum AI oder SWE-bench, die eigene Leaderboards und Messungen veröffentlichen und dabei unterschiedliche Leistungsaspekte betonen – von Programmierfähigkeit bis zum Umgang mit Drittwerkzeugen. Trotz der Vielfalt und technischen Möglichkeiten bestehen Einschränkungen bei der Bewertung von LLMs. Die meisten Benchmarks sind nur begrenzt auf spezielle Teilbereiche ausgelegt. So bewertet HumanEval nur Python-Codegenerierung, berücksichtigt aber nicht die Qualität der Programmierung, Integration in komplexere Softwaresysteme oder andere Sprachen.

Auch Aspekte wie Geschwindigkeit, Latenzzeiten, Skalierbarkeit oder Sicherheitsfragen spielen in den Tests meist keine Rollen. Für neuere Generationen von Agenten, die autonom Aufgaben steuern und selbstständig Entscheidungen treffen sollen – sogenanntes agentisches KI – existieren nur erste, nicht umfassend validierte Benchmarks. Ein weiteres Manko ist die beschränkte Fähigkeit vieler Modelle, verschiedene Denkmodi gleichzeitig zu beherrschen. Reines Faktenwissen, mathematisches Denken, logische Schlussfolgerungen oder kreative Textgenerierung sind oft isoliert betrachtet; eine ganzheitliche Bewertung ist schwierig. Die menschlichen Eigenschaften wie emotionale Intelligenz, ethische Überlegungen oder Integrität bleiben außerhalb des Messbaren.

Dennoch ist das Benchmarking unverzichtbar, um zumindest eine objektive Basis für die Auswahl und Weiterentwicklung von KI-Modellen zu bieten. Für Unternehmen bedeutet eine strategische Bewertung anhand verschiedener Metriken, dass sie Modelle gezielt für ihre Anforderungen auswählen und spezialisieren können. Ein ausgewogener Scorecard-Ansatz, der mehrere Testbereiche und Leistungsdimensionen umfasst, gibt eine fundierte Entscheidungsgrundlage. Dabei bleibt die abschließende Wahl eines KI-Systems eine unternehmensspezifische Bewertungsfrage, die Erfahrung, Fachwissen und Kontext einbeziehen muss. So können Verantwortliche gezielt auf die Stärken eines Modells setzen und gleichzeitig dessen Schwächen durch ergänzende Werkzeuge oder Anpassungen ausgleichen.

Wer sich heute mit großen Sprachmodellen beschäftigt, kommt an Benchmarking nicht vorbei. Es bietet wertvolle Einblicke in das Verhalten, die Leistungsfähigkeit und die Eignung von Modellen. Durch die transparente Messbarkeit wird zugleich Vertrauen in die KI-Technologien gestärkt und der verantwortungsvolle Umgang gefördert. In einer Welt, in der Innovation und Qualität entscheidend sind, ist die präzise Bewertung von KI-Modellen unerlässlich, um Chancen optimal zu nutzen und Risiken zu minimieren.