Die rasante Entwicklung der künstlichen Intelligenz (KI) im Bereich der Sprachsynthese hat die Art und Weise, wie Menschen mit digitalen Technologien interagieren, grundlegend verändert. Sprachassistenzsysteme, Vorlese-Apps und automatische Übersetzungsprogramme profitieren von einer zunehmend naturalistischen Stimmenproduktion, die Stimmen auf überzeugende Weise simulieren können. Trotz dieser Fortschritte entstehen jedoch neue Herausforderungen, die weit über technische Genauigkeit hinausgehen. Besonders deutlich wird dies bei der Repräsentation verschiedener Akzente und regionaler Sprachvarianten in synthetischen KI-Stimmen. Diese Herausforderungen führen zu einer Form von sprachbezogenem Bias, der als Akzentbias bezeichnet wird, und hat das Potenzial, soziale Ungleichheiten auf digitaler Ebene zu verstärken sowie bestimmte Nutzergruppen auszuschließen.

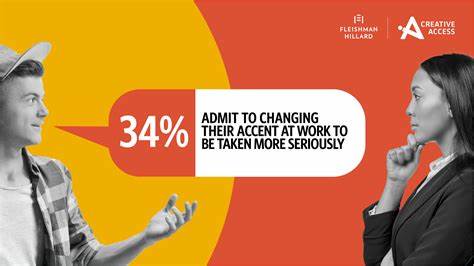

Das Phänomen des Akzentbias im Kontext von KI-Stimmen ist vielfältig und tiefgreifend. Es geht nicht nur darum, wie gut eine KI eine Stimme imitiert, sondern vor allem darum, wessen Stimme tatsächlich repräsentiert wird und wer sich in der Auswahl der angebotenen Stimmen wiederfindet. In vielen aktuellen Systemen spiegeln KI-Stimmen vorrangig einen neutralen oder standardisierten Akzent wider, der sich häufig an einer prominenten, meist urbanen und „prestigeträchtigen“ Sprachvariante orientiert. Nutzer mit regionalen oder weniger verbreiteten Akzenten berichten davon, dass ihre eigene Sprachrealität von den KI-Stimmen nicht adäquat erfasst wird. Diese fehlende Repräsentation kann als Entwertung der eigenen sprachlichen Identität empfunden werden und zu einem Gefühl der digitalen Exklusion führen – einem Ausschluss aus digitalen Räumen, die immer selbstverständlicher Teil des Alltags werden.

Studien, die verschiedene KI-Sprachgenerierungssysteme analysieren, zeigen, dass technische Leistung erheblich von der Art des Akzents abhängt. Systeme wie Speechify und ElevenLabs, die zu den marktführenden Anbietern gehören, erzielen bei Standardakzenten meist eine sehr hohe Qualität. Sobald es jedoch um regionale Varianten oder weniger verbreitete Akzente geht, nehmen Fehler in der Aussprache, die Natürlichkeit der Stimme und die Verständlichkeit spürbar zu. Diese Diskrepanzen können zu einem weniger zufriedenstellenden Nutzererlebnis führen und die Akzeptanz der Technologie bei bestimmten sozialen Gruppen mindern. Darüber hinaus lassen sich linguistische Privilegien beobachten, bei denen Standardakzente unverdiente Vorteile erhalten und Menschen mit nicht standardisierten Akzenten technisch diskriminiert werden.

Die gesellschaftlichen Konsequenzen dieser technischen Limitierungen sind gravierend. Sprache ist ein zentraler Bestandteil der Identität und des sozialen Miteinanders. Wenn digitale Systeme bestimmte Akzente privilegieren, werden sprachliche Minderheiten marginalisiert. Gerade in einer Welt, in der KI-gesteuerte Sprachdienste als alltäglich gelten, bedeutet das eine neue Dimension der Ungleichheit. Digitale Exklusion betrifft nicht nur den Zugang zu Informationen, sondern auch das Selbstverständnis und die Teilhabe an der digitalen Gesellschaft.

Nutzende, die sich in synthetischen Stimmen nicht repräsentiert fühlen, könnten sich von der Technologie entfremden oder sogar ganz davon abwenden. Dies kann den digitalen Graben zwischen verschiedenen Regionen, sozialen Schichten oder ethnischen Gruppen verstärken. Neben technischen Problemen und gesellschaftlichen Auswirkungen werfen Akzentbias und digitale Exklusion auch ethische Fragen auf. Die Nutzung von KI für Sprachsynthese berührt Grundrechte wie die freie Meinungsäußerung und die Wahrung der kulturellen Vielfalt. Sprache darf nicht als ein homogenes, künstlich standardisiertes Produkt betrachtet werden, sondern muss in ihrer Vielfalt geschätzt und erhalten werden.

Entsprechende KI-Systeme sollten deshalb verantwortungsvoll entwickelt werden, um die Vielfalt menschlicher Sprache und Identität widerzuspiegeln und keinesfalls systematisch zu benachteiligen. Die Herausforderung besteht darin, KI-Stimmen nicht nur technisch zu optimieren, sondern die gesellschaftliche Dimension der Sprachvarianz aktiv in den Entwicklungsprozess einzubeziehen. Das bedeutet, dass Entwickler und Unternehmen, die Sprachsynthese anbieten, ihre Datensätze diversifizieren müssen. Trainingsdaten sollten eine breite Palette von Akzenten und Sprachstilen umfassen, um unterschiedliche Nutzerprofile möglichst getreu abzubilden. Ebenso wichtig ist die Zusammenarbeit mit Linguisten, Soziologen und den Communities selbst, um kulturelle Eigenheiten und den sozialen Kontext von Sprache besser zu verstehen und in die Technologie zu integrieren.

Darüber hinaus ist die Regulierung von KI-Sprachdiensten ein zentraler Impuls, um Akzentbias entgegenzuwirken. Regulierungsinstitutionen müssen Rahmenbedingungen schaffen, die faire und inklusive Sprachtechnologien fördern. Dies kann durch Leitlinien zur Repräsentation von Minderheitensprachen, Transparenzanforderungen bei der Entwicklung von KI-Stimmen und durch die Möglichkeit von Betroffenen zur Mitgestaltung geschehen. Damit wird nicht nur die technische Qualität verbessert, sondern auch das Vertrauen in KI-Systeme gestärkt. Auch die Sensibilisierung der Öffentlichkeit spielt eine wichtige Rolle.

Die Nutzer sollten über die möglichen Beschränkungen von KI-Stimmen informiert werden, um realistische Erwartungen zu entwickeln. Zugleich müssen Diskriminierungserfahrungen ernst genommen und sichtbar gemacht werden, um gesellschaftlichen Druck für Verbesserungen zu erzeugen. Verschiedene Interessengruppen können dabei als Fürsprecher fungieren, die auf die Bedürfnisse von Menschen mit unterschiedlichen Akzenten und Sprachvarianten hinweisen. Die Zukunft der sprachlichen KI-Technologie hängt daher entscheidend davon ab, wie inklusiv und divers die Systeme gestaltet werden. Es liegt in der Verantwortung von Entwickler:innen, Unternehmen und politischen Akteuren, Sprachvielfalt zu würdigen und digitale Ausschlüsse zu minimieren.

Nur so können synthetische KI-Stimmen ein echtes Abbild der Gesellschaft werden und die interkulturelle Kommunikation stärken. Abschließend lässt sich festhalten, dass Akzentbias und digitale Exklusion in KI-Stimmen kein rein technisches Problem sind, sondern ein gesellschaftliches Phänomen, das Sprache, Identität und Teilhabe betrifft. Sprache als Ausdruck von Kultur darf nicht dem Diktat einer vermeintlichen Norm unterliegen, sondern muss in all ihrer Vielfalt digital sichtbar und hörbar bleiben. Die Entwicklung und Nutzung von KI-Sprachdiensten muss diesen Anspruch verfolgen, um eine gerechtere digitale Zukunft zu gestalten – eine Zukunft, in der niemand das Gefühl hat, dass die künstliche Stimme nicht auch die eigene Stimme ist.