Die digitale Transformation stellt Unternehmen immer wieder vor die Herausforderung, ihre IT- und Datenbankinfrastrukturen an wachsende Anforderungen anzupassen. Eine solche bedeutende Veränderung ist die Migration von einer Datenbanklösung zur nächsten. Obwohl moderne verteilte Datenbanken wie CockroachDB besonders durch Skalierbarkeit und Multi-Region-Fähigkeiten überzeugen, zeigen sich im Praxisbetrieb auch immer wieder Grenzen, die den Umstieg auf traditionelle relationale Systeme wie PostgreSQL attraktiv machen. Diese Migration ist mehr als nur ein technischer Schritt – sie ist ein strategisches Investment in Stabilität, Performance und langfristige Kosteneffizienz. Seit Anfang 2022 setzte das Unternehmen Motion erfolgreich CockroachDB als Kern ihres Datenmanagements ein.

Die Wahl fiel wegen der einfachen horizontalen Skalierung, die vor allem bei Multi-Region-Betreibungen unschätzbare Vorteile bietet. Zudem garantiert CockroachDB mit seiner SQL-ähnlichen Schnittstelle unter hoher Verfügbarkeit eine bequeme Entwicklererfahrung. Doch je stärker das Datenvolumen zunahm und die Anwendungskomplexität wuchs, desto mehr traten Performance-Engpässe und steigende Kosten zu Tage. Insbesondere bei einfachen, transaktionalen Abfragen in nur einer Region hinterfragte das Team die Notwendigkeit eines so komplexen und kostenintensiven verteilten Systems. Ein maßgebliches Problem war das Management von Migrationen.

Mit wachsender Datenbankgröße führten Updates häufig zu Timeouts. Entwickler waren gezwungen, diese manuell und Schritt für Schritt durchzuführen, da automatisierte Migrationstools wie Prisma regelhaft an Grenzen stießen. Die mitunter bis zu zwei Stunden langen Blockaden im Deployment-Prozess führten nicht nur zu Ausfallzeiten, sondern sorgten auch für Frust im Entwicklerteam. Die anhaltenden Probleme verhinderten zudem ein einfaches Upgrade der CockroachDB-Version, wodurch die Software schlussendlich auf eine veraltete und nicht mehr optimal unterstützte Version beschränkt blieb. Die Schwierigkeiten beschränkten sich nicht nur auf Migrationsvorgänge.

Auch ETL-Prozesse zeigten erhebliche Schwachstellen. Die eingesetzte Synchronisierungslösung Airbyte brachte wenig Mehrwert, da der Connector in einem instabilen Alpha-Status war und zusätzlich durch Speicherlecks die Stabilität beeinträchtigte. Die Performance bei Datenextraktion und -übertragung war ineffizient, was wertvolle Ressourcen band und die Interpretierbarkeit von Daten erschwerte. Im Vergleich zu CockroachDB konnten verschiedene Abfragen in PostgreSQL schneller ausgeführt werden, insbesondere im Szenario komplexer SQL-Statements, die hinter ORMs wie Prisma stehen. Obwohl CockroachDB mit seinem fortschrittlichen Query-Optimierer bei bestimmten Spezialfällen Vorteile zeigte, offenbarten die meisten realen Abfragen, dass PostgreSQL eine bessere und stabilere Performance mit deutlich geringerer Latenzzeit erreichte.

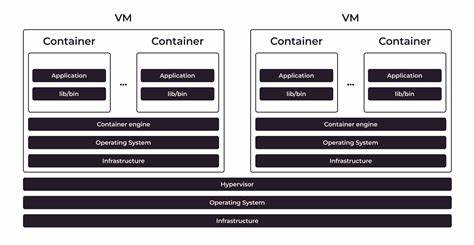

Gerade bei stark verschachtelten Joins und umfangreichen Aggregationen war die Geschwindigkeit von PostgreSQL um ein Vielfaches besser. Des Weiteren traten während des CockroachDB-Betriebs immer wieder technische und operative Probleme auf, etwa Verbindungsabbrüche in Virtual Private Cloud (VPC) Netzwerken, die das Entwicklerteam nicht beheben konnte. Diese Instabilitäten führten zu weiteren Verzögerungen in der Entwicklung und brachten nochmalige Unsicherheiten in den Betriebsablauf. Solche Hürden waren beim Betrieb von PostgreSQL nicht zu beobachten, was die Zuverlässigkeit maßgeblich erhöhte. Der Kern der erfolgreichen Migration lag in der Konzeption einer maßgeschneiderten ETL-Lösung mit moderner Unterstützung durch das Tool Bun.

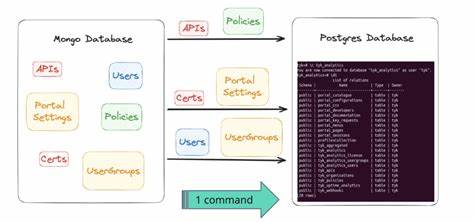

Die Strategie bestand darin, alle Daten tabellenweise zu exportieren, in Dateien zu speichern und mit parallelen Prozessen durch Streaming nach PostgreSQL zu importieren. Der Ansatz bewährte sich auch bei anspruchsvollen Datenformaten. Allerdings erforderte die Besonderheit, dass CockroachDB bei JSON- und Array-Datentypen eine leicht andere Byte-Codierung verwendet, zusätzliche Transformationen in der Pipeline. Durch gezielte Anpassungen konnte eine konsistente und verlustfreie Datenübertragung gewährleistet werden. Die eigentliche Migration wurde in einer nächtlichen Wartungsperiode durchgeführt.

Mit einer großzügigen Ressourcenbereitstellung (128 Kern-VM in Google Cloud) konnte die Übertragung der 100 Millionen Datensätze innerhalb von etwa 15 Minuten abgeschlossen werden. Während dieser Zeit war der Betrieb zwar für knapp eine Stunde unterbrochen, allerdings ließ sich durch eine schrittweise Traffic-Erhöhung die Stabilität sicherstellen. Die Folge dieses Prozesses war eine unmittelbare Verbesserung der Anwendungsperformance mit einer Reduktion der aggregierten Latenzen um ein Drittel. Ein weiterer wesentlicher Vorteil zeigte sich in der Analyse und Optimierung von SQL-Abfragen mit Hilfe von leistungsfähigen Werkzeugen wie PGAnalyze. Innerhalb weniger Stunden konnten mehrere schlecht performante Abfragen identifiziert und überarbeitet werden.

Dies führte nicht nur zu verbesserter Geschwindigkeit, sondern auch zu einer nachhaltig geringeren Serverbelastung. Insgesamt resultierte die Migration nicht nur in einer technisch besseren Lösung, sondern auch in einer signifikanten Kosteneinsparung von über 110.000 US-Dollar jährlich unter Berücksichtigung des weiter steigenden Traffics. Die Migration unterstreicht eindrucksvoll den Wert einer sorgsamen Planung, praktischen Tests und der Bereitschaft, bestehende Werkzeuge und Abläufe kritisch zu hinterfragen. Sie zeigt, dass auch vermeintlich komplexe Verteiltdatenbanksysteme nicht zwangsläufig die beste Lösung für alle Anwendungen sind.

Stattdessen bietet die bewährte Relevanz und Flexibilität von PostgreSQL für viele Anwendungsfälle eine verlässliche und kosteneffiziente Plattform. Für Entwickler und Unternehmen, die vor der Entscheidung stehen, eine neue Datenbanklösung einzuführen oder eine bestehende zu ersetzen, liefert dieser Erfahrungsbericht wertvolle Impulse. Ein migrationsfreundlicher ORM-Prozess, ein gut durchdachtes eigenes ETL-Verfahren sowie eine klare Aufwand-Nutzen-Rechnung helfen dabei, Risiken zu minimieren und langfristige Vorteile zu sichern. Neben den technischen Aspekten darf nicht unerwähnt bleiben, dass der Umstieg auch kulturbedingt Einfluss auf das Entwicklerteam hat. Die erworbene Expertise in PostgreSQL sowie der damit verbundene Umgang mit stabilen und transparenten Tools steigern die Zufriedenheit und Effizienz.

Gleichzeitig wird durch die bessere Support-Erreichbarkeit und das gut etablierte Ökosystem die Wartbarkeit des Systems erheblich erleichtert. Insgesamt macht die Migration zu PostgreSQL deutlich, dass eine Datenbank nicht allein durch ihre technischen Spezifikationen beurteilt werden sollte. Faktoren wie Kosten, Stabilität, Performance in Alltagsanwendungen sowie Support und Infrastruktur müssen zusammenspielen, um eine zukunftsfähige und wirtschaftliche Lösung zu gewährleisten. Das Beispiel aus der Praxis beweist, dass ein wohlüberlegter Umstieg nicht nur möglich ist, sondern auch immense Vorteile bringt, wenn er mit dem nötigen Fokus und Engagement umgesetzt wird.