Langflow AI hat sich als weitverbreitete Open-Source-Plattform etabliert, die Entwicklern und Unternehmen die einfache Erstellung agentischer KI-Workflows ermöglicht. Mit über 50.000 GitHub-Sternen und der Unterstützung bekannter Unternehmen wie DataStax und IBM ist Langflow in der KI-Community anerkannt. Doch gerade aufgrund seiner großen Verbreitung und der zentralen Funktionen erlangte Langflow im April 2025 traurige Bekanntheit durch die Meldung einer gravierenden Sicherheitslücke, die unter der CVE-Nummer 2025-3248 geführt wird. Die Schwachstelle erlaubt es Angreifern, ohne jegliche Authentifizierung vollständige Remote Code Execution (RCE) auf betroffenen Servern durchzuführen, wodurch die Kontrolle über Systeme kompromittiert wird.

Die Sicherheitslücke entstand durch die unsichere Nutzung der Python-Funktion exec innerhalb eines API-Endpunkts, und ihre Applikation zeigt, warum sorgsamer Umgang mit dynamischer Codeausführung in Webapplikationen unverzichtbar ist. Die Problematik Langflow setzt auf die Programmiersprache Python, eine der am weitesten verbreiteten Sprachen für KI und Webentwicklung. Ein Kernproblem war ein API-Endpunkt, der explizit zur Validierung von Python-Code gedacht war. In der Variante mit Version 1.2.

0 und älter wurde dieser Endpunkt genutzt, um vom Nutzer übermittelte Python-Funktionsdefinitionen und Imports zu analysieren und anschließend per exec in den Serverprozess zu laden und zu kompilieren. Hier war der entscheidende Fehler, dass der übermittelte Code nicht ausreichend sicherheitsüberprüft wurde und unautorisierter Code darin ausgeführt werden konnte. Kommunikation mit dem Server erfolgte meist über eine JSON-Schnittstelle, die beliebigen Python-Code annahm, etwa um den Code des visuellen Editors von Langflow zu validieren. Aus Sicherheitsgründen erwartete man, dass nur authentifizierte Nutzer Zugriff auf diesen Endpunkt haben. Allerdings wurde die Zugriffsregelung gar nicht wirksam durchgesetzt und ermöglichte so auch unbekannten Angreifern Zugriff auf die kritische Funktionalität.

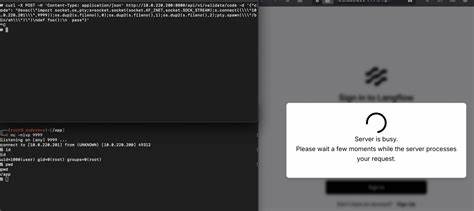

Am gefährlichsten dabei war die Ausnutzung spezieller Python-Features. Zwar überprüfte der Code die Funktionsdefinitionen und Imports, jedoch blieben Expressions innerhalb von Dekoratoren oder Standardfunktionsargumenten ungeprüft. Python-Dekoratoren sind eine mächtige Technik, um Funktionen zu modifizieren oder zu erweitern, deren Ausführung jedoch schon bei der Funktionsdefinition startet. Angreifer platzierten bösartigen Code genau in diese Dekoratoren, wodurch dieser beim Ausführen des exec-Kommandos automatisch auf dem Server ablief ohne, dass die eigentliche Funktion jemals aufgerufen werden musste. So ließen sich beliebige Befehle starten, darunter Reverse Shells, die Angreifern einen interaktiven Zugriff auf die darunterliegende Serverumgebung gewährten.

Das Gleiche gelang auch über Default Argumente von Funktionen, die ebenso als Expressions beim Kompilieren ausgeführt werden. Die Konsequenzen der Schwachstelle sind gravierend. Ein unautorisierter Angreifer konnte ohne Zugangsdaten beliebigen Python-Code ausführen, Systembefehle absetzen und damit Datenklau, Serverübernahme oder gar das Ausrollen von weiterer Malware realisieren. Angriffe konnten über simplen HTTP-POST-Requests mit speziell präpariertem JSON ausgelöst werden, was die Exploitation einfach und automatisierbar machte. Die Entdeckung dieser Lücke erfolgte durch das Sicherheitsteam von Horizon3.

ai im Februar 2025. Nach intensiver Kommunikation mit Langflow-Entwicklern und den Sponsor-Firmen DataStax sowie IBM gelang es, die Verantwortlichen über das Problem zu informieren, woraufhin zeitnah ein Patchprozess eingeleitet wurde. Am 31. März 2025 wurde die Version 1.3.

0 veröffentlicht, die den gefährlichen Endpunkt hinter einer wirksamen Authentifizierung absichert und somit die unautorisierte RCE verhindert. Dennoch bleibt die Warnung aktuell, da bis dahin zahlreiche Versionen weltweit im Einsatz sind, und es Berichte von über 500 via Censys öffentlich exponierten Langflow-Instanzen gibt, die für Angreifer leicht zugänglich sind. Für Anwender bedeutet das im Kern zwei Dinge: Zum einen sollte unverzüglich ein Upgrade auf die Version 1.3.0 oder höher erfolgen, um die gepatchte Version mit geschlossener Sicherheitslücke zu nutzen.

Zum anderen empfiehlt es sich, den Zugriff auf Langflow-Systeme durch Firewall-Regeln, VPNs oder andere Netzwerksicherheitsmechanismen einzuschränken. Auch eine Isolierung in einer abgesicherten Cloud-Umgebung oder hinter Single-Sign-On-Lösungen erhöht die Sicherheit nachhaltig. Die Schwachstelle illustriert, wie riskant dynamische Codeausführung ohne Sandbox und ohne strenge Zugriffsbeschränkungen sein kann. Gerade in der aufstrebenden Szene agentischer KI-Tools, wo Intelligenz und freie Codeausführung oft eng verknüpft sind, müssen Entwickler erhöhte Vorsicht walten lassen. Als Grundsatz gilt, Eingaben strikt zu validieren, die Ausführung fremden Codes nur eingeschränkt zu erlauben und kritische Komponenten sorgfältig abzusichern.

Wer Langflow oder ähnliche Tools einsetzt, sollte diese Gefahr in seine Sicherheitsstrategie integrieren und regelmäßig die aktuellen Patches und Versionen einspielen. Parallel ist die Beobachtung von Netzwerkanomalien und ungewöhnlichem Verhalten hilfreich, um Angriffsversuche frühzeitig zu erkennen und zu verhindern. Die Gemeinschaft reagierte prompt auf die Meldung, indem Sicherheitsanbieter wie Horizon3.ai Exploit-Tests in ihre Pentesting-Produktlinien aufnahmen. Außerdem bieten Frameworks wie Nuclei nun Schwachstellen-Templates an, die automatisiert nach der CVE-2025-3248 suchen können.

![Results summary: 2025 Annual C++ Developer Survey "Lite" [pdf]](/images/AD6BD859-2F0B-4D38-9A34-EC5AC0D9AF1E)