In der schnelllebigen Welt der künstlichen Intelligenz und des maschinellen Lernens gewinnt die Fähigkeit, neuronale Netzwerke effizient zu trainieren und mathematische Ausdrücke verständlich abzubilden, zunehmend an Bedeutung. In diesem Kontext hat sich Micrograd als Minimalbeispiel einer autograd-basierten Engine etabliert, die das Rückpropagationsverfahren auf einfachste Weise abbildet. Noch spannender wird dies durch die Scala-Implementierung von Micrograd, die mit ihrem rein funktionalen Ansatz und fokussierten Design eine neue Perspektive auf die Entwicklung kleiner neuronaler Netzwerke bietet. Scala, eine moderne Programmiersprache, die sowohl objektorientierte als auch funktionale Programmierparadigmen unterstützt, ist prädestiniert für die Umsetzung komplexer mathematischer Algorithmen. Die Implementierung von Micrograd in Scala nutzt diese Vielseitigkeit, um eine effiziente, gleichzeitig aber auch übersichtliche Codebasis zu schaffen.

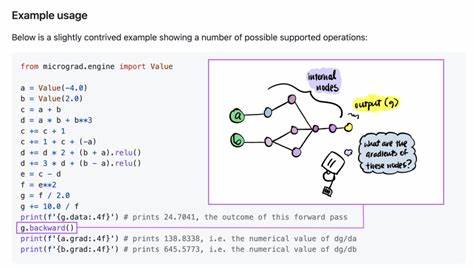

Dieses Projekt wurde inspiriert vom bekannten KI-Experten Andrej Karpathy und seinem YouTube-Tutorial über neuronale Netze, welches komplexe Konzepte anschaulich und nachvollziehbar darstellt. Im Kern bietet die Scala-Variante von Micrograd eine domänenspezifische Sprache (DSL) zur Erstellung mathematischer Ausdrücke, die nicht nur funktional sauber, sondern auch leicht erweiterbar ist. Die Nutzer können damit Variablen wie Gewichte und Bias-Werte definieren und diese zu komplexeren Funktionen zusammensetzen. Diese Flexibilität ermöglicht eine intuitive Modellierung, die besonders für Entwickler und Forscher attraktiv ist, die tiefer in die Mechanismen hinter neuronalen Netzen eintauchen wollen. Das Besondere an Sicrograd, wie das Projekt genannt wird, ist seine pure funktionale Backpropagation-Engine.

Das bedeutet, dass der gesamte Lernprozess, vom Vorwärtsdurchlauf der Netzwerke bis hin zur Gradientenberechnung für die Gewichtsaktualisierung, unter Verwendung unveränderlicher Datenstrukturen und rein funktionaler Konstrukte umgesetzt wurde. Dies führt zu äußerst robustem Code, der leicht testbar und nachvollziehbar bleibt – ein entscheidender Vorteil gegenüber häufig verwendeten imperativen Implementierungen. Für die praktische Anwendung und Demonstration beinhaltet die Scala-Implementierung mehrere Demos. Ein Highlight ist das Training eines Multi-Layer Perceptrons (MLP) zur näherungsweisen Modellierung der Sinusfunktion. Dieses Beispiel zeigt eindrucksvoll, wie das kleine Netzwerk in der Lage ist, eine nichtlineare Funktion innerhalb des Intervalls von 0 bis 2π mit hoher Genauigkeit zu approximieren.

Die Datenpunkte werden dabei zufällig generiert, was den Lernprozess unter realistischeren Bedingungen simuliert. Eine weitere beeindruckende Demo widmet sich der Klassifikation des sogenannten Moon-Datensatzes. Dieser Datensatz ist in der Machine-Learning-Community ein Klassiker für binäre Klassifikationsaufgaben, da seine Struktur die Trennung von zwei Klassen in einer zweidimensionalen Punktwolke mit einem komplizierten Entscheidungsrand erfordert. Das Scala-System trainiert erfolgreich ein MLP, das die Datenpunkte akkurat trennt, und illustriert damit die Leistungsfähigkeit und Flexibilität der Engine. Ein bedeutender Mehrwert des Sicrograd-Projekts ist die Möglichkeit, mathematische Ausdrucksbäume visuell darzustellen.

Dies erfolgt über eine Graphviz-Integration, die die zugrunde liegenden Berechnungsgrafen der Netzwerkoperationen anschaulich macht. Die Visualisierung hilft Anwendern dabei, das Zusammenspiel von Variablen und Operationen zu verstehen und somit besser nachvollziehen zu können, wie das Netzwerk funktioniert und wie der Gradientenfluss gestaltet ist. Darüber hinaus bietet das Projekt eine innovative Demonstration der neuronalen Trainingsdynamik, in der die Veränderung von Gewichten während der Gradientenabstieg-Iteration visualisiert wird. Während die optische Aufbereitung noch weiterentwickelt wird, vermittelt diese Funktion bereits heute einen wertvollen Einblick in den Lernprozess. Das Betrachten der iterativen Gewichtsupdates macht den abstrakten Vorgang greifbar und unterstützt Lernende und Entwickler bei der Analyse von Trainingsphänomenen.

Das Scala-Micrograd-Projekt setzt somit neue Maßstäbe im Bereich der minimalen, aber leistungsfähigen neuronalen Netzwerke. Seine streng funktionale Philosophien sorgen dafür, dass der Code klar strukturiert und zugleich hoch performant bleibt. Die Integration von Visualisierungswerkzeugen schafft Brücken zwischen Theorie und Praxis, die sowohl Neueinsteigern als auch Profis zugutekommen. Von der Installation bis zur Ausführung der Demos gestaltet sich der Einstieg sehr angenehm. Vorausgesetzt wird lediglich die Installation von SBT, dem Scala Build Tool, und Graphviz für die graphische Darstellung.

Danach lassen sich mittels einfacher Befehle vielfältige Anwendungsbeispiele starten, die den kompletten Workflow vom mathematischen Ausdruck bis zum trainierten neuronalen Netz abbilden. Neben seinem pädagogischen Wert ist Sicrograd auch als Grundlage für weiterführende Projekte im Bereich KI-Frameworks interessant. Die modulare Struktur und die klare Trennung der Kernkomponenten ermöglichen es Entwicklern, das Projekt individuell anzupassen, zu erweitern oder in größere Systeme zu integrieren. Insbesondere für Forschungszwecke in funktionaler Programmierung und Deep Learning zeigt die Scala-Implementierung große Potenziale. Insgesamt stellt die Scala-Implementierung von Micrograd ein beeindruckendes Beispiel dafür dar, wie komplexe Machine-Learning-Konzepte in einer kleinen, überschaubaren und dennoch leistungsfähigen Codebasis umgesetzt werden können.

Durch die Kombination von funktionalem Design, umfassender Visualisierung und praktischen Demos werden sowohl die Komplexität neuronaler Netzwerke greifbar als auch die Freude an ihrer Entwicklung erweitert. Anwender und Entwickler erhalten ein schlankes, aber mächtiges Tool, um die Welt des Deep Learning auf neue Weise zu entdecken und zu gestalten.