Künstliche Intelligenz durchdringt inzwischen nahezu alle Lebens- und Arbeitsbereiche. Von der Automatisierung komplexer Prozesse bis hin zur personalisierten Kommunikation – KI-Systeme sind aus dem modernen Alltag nicht mehr wegzudenken. Dabei hängt der Erfolg solcher Systeme maßgeblich davon ab, wie gut sie mit relevanten Daten versorgt werden. Trotz der enormen Fortschritte im maschinellen Lernen und in den Modellen selbst existiert ein grundlegendes Problem: Die fehlende Fähigkeit vieler KI-Modelle, in Echtzeit auf frische und qualitativ hochwertige Daten zuzugreifen. Dieses Defizit hat bislang häufig dazu geführt, dass Entwickler auf Web-Scraping oder kostspielige Drittanbieterschnittstellen angewiesen waren, um ihre KI-Modelle mit aktuellen Informationen zu versorgen.

Mit der Einführung von Retrieval-Augmented Generation (RAG) und dem Model Context Protocol (MCP) steht nun ein grundlegender Wandel bevor, der den Datenzugang für Künstliche Intelligenz effizienter, nachhaltiger und legaler gestaltet. Das Problem der Datenverfügbarkeit für KI-Modelle ist nicht neu. Die meisten großen Sprachmodelle verfügen über einen Wissensstand, der an einem bestimmten Zeitpunkt eingefroren wird – häufig Monate oder sogar Jahre vor der tatsächlichen Nutzung. Dies führt dazu, dass sie auf Fragen, die aktuelle Ereignisse, Börsenkurse, Wetterinformationen oder andere zeitkritische Daten betreffen, keine oder nur unzureichende Antworten liefern können. In der Praxis bedeutet dies, dass Antworten veraltet oder gar falsch sein können, was als sogenannte „Halluzinationen“ bekannt ist, bei denen die KI Fakten erfindet, um Wissenslücken zu füllen.

Für Anwendungsfälle, in denen genaue und aktuelle Daten essenziell sind, wie im Finanzsektor, im Kundenservice oder in der Nachrichtenverarbeitung, ist diese Einschränkung ein erhebliches Hindernis. Web-Scraping, also das automatisierte Auslesen von Webinhalten, war lange Zeit die gängige Methode, um diesen Mangel zu umgehen. Entwickler griffen entweder auf selbstentwickelte Tools oder auf kommerzielle Scraping-Dienste zurück, um Daten in quasi Echtzeit zu sammeln. Doch diese Praxis ist mit erheblichen Herausforderungen verbunden. Zum einen steht das Scraping häufig im rechtlichen Graubereich, weil Webseitenbetreiber selten explizit die Erlaubnis zur automatisierten Datenerfassung erteilen.

Zum anderen ist das Verfahren technisch anfällig und kann durch Änderungen der Quellseiten schnell zum Erliegen kommen. Zudem müssen Entwickler mit ständig steigenden Kosten rechnen, da Scraping skalierend sehr ressourcenintensiv ist. Trotz dieser Probleme bleibt das Scraping weit verbreitet, weil es bislang kaum Alternativen für den Live-Datenzugang an der Schnittstelle der KI-Modelle gab. Hier setzen RAG und MCP an, zwei Technologien, die den Datenzugang an der entscheidenden Stelle – dem Inferenzzeitpunkt – revolutionieren. Retrieval-Augmented Generation kombiniert das vortrainierte Wissen eines großen Sprachmodells mit externen, live abgerufenen Daten.

Dabei sucht das System bei einer Anfrage gezielt nach relevanten Inhalten aus externen Datenquellen, um sie in den Kontext des Modells einzuspeisen, bevor die Antwort generiert wird. Das Ergebnis ist eine deutlich verbessere Genauigkeit und Aktualität, die Halluzinationen reduziert und die Nutzererfahrung optimiert. Im Gegensatz zu herkömmlichen Ansätzen sind die Informationen damit nicht mehr statisch im Modell verankert, sondern flexibel und jederzeit aktualisierbar. Das Model Context Protocol ist ein offener Standard, entwickelt von Anthropic, der diese Datenangriffe vereinfacht und normiert. Er erlaubt es KI-Assistenten, nahtlos und standardisiert mit externen Datenquellen zu kommunizieren.

MCP gilt als universelle Brücke zwischen KI-Modellen und permissionierten Dateninfrastrukturen, die es ermöglicht, unterschiedliche Systeme und Anbieter effizient zu verbinden. Durch die Kombination von RAG und MCP entsteht eine Plattform, die nicht nur die technischen Anforderungen an einen Echtzeitdatenzugang erfüllt, sondern auch ethische und rechtliche Rahmenbedingungen berücksichtigt. Statt Daten einfach zu scrapen, erfolgt der Zugriff per Erlaubnis und klaren Vereinbarungen, was eine nachhaltige Monetarisierung für Datenanbieter ermöglicht. Ein Beispiel für die praktische Umsetzung dieser Technologien liefert das Unternehmen Dappier, das eine Oberfläche für Entwickler und Unternehmen bereitstellt, um Echtzeitdaten mittels RAG und MCP zu integrieren. Dappier stellt seine Real-Time Data Model API kostenfrei zur Verfügung und plant, künftig native Werbeformate zu implementieren, die Publisher, Datenlieferanten und Entwickler fair am Wertschöpfungsprozess beteiligen.

Dadurch entsteht ein nachhaltiges Ökosystem, das den Data Economy Principles entspricht und die bislang marktbeherrschende Rolle des Scrapings infrage stellt. Die Vorteile gegenüber herkömmlichem Scraping sind vielfältig. Zum einen entfällt die technische und rechtliche Unsicherheit, da alle Datenzugriffe mit Zustimmung der Datenanbieter stattfinden. Zum anderen ist die Datenqualität und -aktualität gewährleistet, da die Informationen direkt von den Quellen stammen. Die Kosten lassen sich durch das standardisierte Protokoll und den entfallenden Pflegeaufwand für Scraping-Tools langfristig senken.

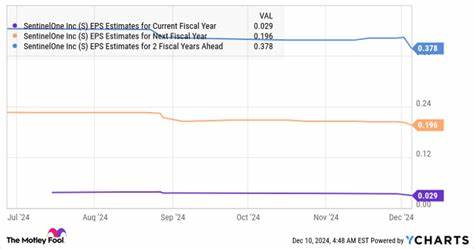

Für Entwickler bedeutet dies zudem einen enormen Produktivitätsgewinn, da sie sich auf die Entwicklung smarter KI-Anwendungen konzentrieren können, ohne sich mit der komplexen Datenbeschaffung auseinandersetzen zu müssen. Die Integration in bestehende und neue KI-Systeme gestaltet sich dank offener APIs und Frameworks wie LangChain, Camel AI oder den GPT-basierten Modellen von OpenAI denkbar einfach. So lassen sich intelligente Assistenten fertigen, die etwa tagesaktuelle Börsendaten abrufen, Echtzeit-Nachrichten einbauen oder Sportergebnisse unmittelbar einbinden. Auch Plattformen wie Zapier ermöglichen durch die Verknüpfung mit diesen Datenmodellen eine Automatisierung auf Basis aktueller Informationen, was völlig neue Use Cases in der Prozessoptimierung und im Data-driven Business eröffnet. Zukunftsorientierte KI-Entwickler sollten daher unbedingt auf RAG und MCP setzen, um ihren Systemen den entscheidenden Wettbewerbsvorteil zu sichern.

Die Kombination aus Echtzeitdaten undmodellbasiertem Wissen schafft Anwendungen, die relevanter, zuverlässiger und benutzerfreundlicher sind als bisherige Lösungen. Gleichzeitig werden mit der Vermeidung von Scraping negative Schlagzeilen vermieden und die rechtliche Sicherheit erhöht. Dies kommt nicht nur Unternehmen zugute, sondern auch den Endnutzern, die auf präzise und vertrauenswürdige Antworten angewiesen sind. Langfristig könnten RAG und MCP sogar die Art und Weise verändern, wie Wissen im Internet verteilt und monetarisiert wird. Ein demokratischer und fairer Zugang zu Daten verspricht eine Diversifizierung der Informationslandschaft und die Entstehung neuer Geschäftsmodelle, die auf Transparenz und Zusammenarbeit basieren.

Gleichzeitig fördern diese Technologien Innovation und Wettbewerb, indem sie auch kleineren Anbietern eine einfache Einbindung ihrer Daten in KI-Ökosysteme ermöglichen. Zusammenfassend lässt sich festhalten, dass die Ära des AI-Scrapings vor dem Ende steht. Die Kombination von Retrieval-Augmented Generation und dem Model Context Protocol ebnet den Weg zu einem neuen Standard im Datenzugang für Künstliche Intelligenz. Sie macht den Datenzugriff näher am Nutzer, dynamischer und rechtlich sauberer. Für Entwickler, Unternehmen und Datenanbieter eröffnen sich dadurch völlig neue Möglichkeiten, KI mit frischen Informationen zu versorgen und so Produkte und Dienstleistungen der nächsten Generation zu schaffen.

Es lohnt sich daher, die Entwicklungen rund um RAG und MCP genau im Blick zu behalten und diese Technologien frühzeitig in eigene Projekte zu integrieren. Wer hier frühzeitig auf die neuen Datenzugangsmethoden setzt, kann sich entscheidende Vorteile sichern und zugleich zur nachhaltigen Transformation der KI-Industrie beitragen. Die Zukunft der KI ist ohne Scraping – dafür mit intelligentem, permissioniertem und nachhaltigem Zugriff auf Echtzeitdaten.