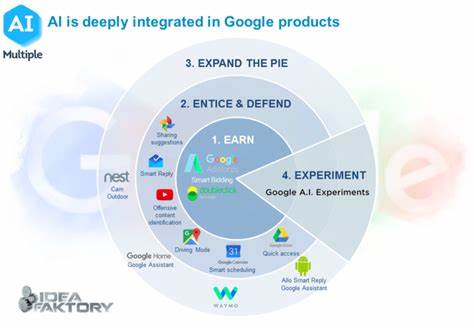

Die rasante Entwicklung von Künstlicher Intelligenz (KI) hat zahlreiche Möglichkeiten für die Automatisierung und Verbesserung verschiedenster Anwendungen geschaffen. Besonders im Bereich komplexer KI-gestützter Werkzeuge stellt sich immer wieder die Frage, ob das sogenannte Prompting – also das gezielte Anweisen von KI-Modellen durch textbasierte Eingaben – ausreicht, um anspruchsvolle Anwendungen zu realisieren. Prompting ist eine Methode, bei der Nutzer oder Entwickler natürliche Sprache verwenden, um der KI bestimmte Aufgaben zuzuweisen oder sie in eine gewünschte Richtung zu lenken. Während es in den letzten Jahren erhebliche Fortschritte bei Sprachmodellen wie GPT, BERT oder anderen großen Modellen gab, die relevante und kontextbezogene Antworten erzeugen können, ist unklar, inwieweit reine Prompting-Techniken komplexe KI-Werkzeuge wie Cursor oder V0 vollständig abdecken können. Moderne KI-Modelle zeichnen sich durch ihre enorme Vielseitigkeit aus.

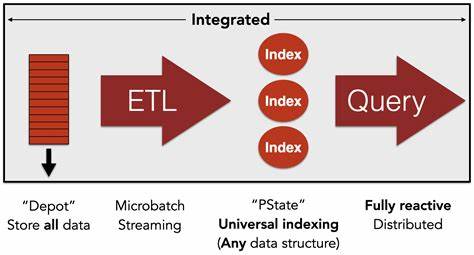

Sie können Texte generieren, programmieren, Daten analysieren oder sogar kreative Aufgaben bewältigen. Doch die Komplexität von Anwendungen, die beispielsweise große Codebasen verwalten oder interaktive Entwicklungsumgebungen unterstützen, geht weit über einfache Nachfrage-Antwort-Strukturen hinaus. Hier steckt der wesentliche Unterschied: Während grundlegendes Prompting gut geeignet ist, um einzelne Anfragen oder kleinere Aufgaben innerhalb eines größeren Rahmens zu bearbeiten, benötigen komplexe Systeme eine umfassendere Architektur. Diese umfasst oft mehrere Komponenten wie Datenmanagement, Sicherheit, Nutzerverwaltung, Leistungsoptimierung und kontinuierliches Lernen. Prompting dient dabei oft als Schnittstelle zwischen Nutzer und KI-Modell, doch die eigentliche Logik und Prozesssteuerung liegen in zusätzlichen Software-Schichten.

Ein zentrales Problem bei der alleinigen Nutzung von Prompting ist die Zuverlässigkeit und Konsistenz der Antworten. KI-Modelle arbeiten probabilistisch, das heißt, ihre Ausgaben beruhen auf Wahrscheinlichkeiten und müssen nicht immer exakt der erwarteten Lösung entsprechen. In einfacheren Anwendungen mag dies tolerierbar sein, doch in kritischen Systemen mit komplexen Anforderungen kann dies zu Fehlern, Missverständnissen oder unerwarteten Ergebnissen führen. Aus diesem Grund verfügen komplexe KI-gestützte Werkzeuge häufig über Feintuning-Mechanismen, Qualitätssicherungsprozesse und spezielle Regelwerke, die über das reine Prompting hinausgehen. Zudem bedingt die Komplexität moderner Anwendungen oft eine enge Integration von KI-Komponenten mit anderen Systemen und Datenquellen.

Beispielsweise benötigen Tools, die Entwicklern beim Programmieren helfen, Zugriff auf umfangreiche Code-Repositories, Versionskontrollsysteme oder Debugging-Informationen, die nicht allein durch ein sprachbasiertes Prompting erschlossen werden können. Die KI fungiert in diesen Fällen eher als intelligenter Assistent innerhalb eines größeren Systems, das nur durch geeignete technische Voraussetzungen optimal arbeiten kann. Ein weiterer Aspekt betrifft die menschliche Interaktion mit der KI. Auch wenn Prompting theoretisch eine sehr intuitive Methode zu sein scheint, stellt sich die Frage, wie gut Nutzer – insbesondere Nicht-Experten – hochwertige Prompts formulieren können, um komplexe Aufgaben genau zu beschreiben. Oft ist eine gewisse Expertise nötig, um die Vorteile von KI-Modellen wirklich auszuschöpfen.

Unternehmen investieren daher in Schulungen, bessere Benutzeroberflächen und automatisierte Prompt-Optimierungen, um die Lücke zwischen menschlicher Intention und maschinellem Verständnis zu schließen. Die Zukunft zeigt jedoch, dass Prompting nicht nur eine statische Methode ist, sondern sich weiterentwickelt. Fortschritte in adaptiven Systemen, die sich selbst anhand von Nutzerfeedback verbessern, und der Kombination von Prompting mit anderen KI-Techniken wie Reinforcement Learning oder symbolischer KI, eröffnen neue Möglichkeiten, komplexere Werkzeuge noch effizienter zu gestalten. Beispielsweise kann eine KI durch fortlaufende Interaktion lernen, welche Arten von Prompts besonders gute Ergebnisse liefern, und entsprechende Vorschläge machen oder automatisch Anpassungen vornehmen. Aus Sicht von Entwicklern und Unternehmen bietet das Prompting eine flexible und schnelle Methode, um KI-Funktionalitäten in Softwareprodukte zu integrieren, ohne aufwändige Modelltrainings oder Infrastruktur zu benötigen.

Dies erleichtert die Prototypenentwicklung und die schnelle Validierung neuer Ideen. Doch wenn es darum geht, robuste, skalierbare und komplexe AI-basierte Werkzeuge in produktiven Umgebungen zu etablieren, reicht das reine Prompting kaum aus. Hier sind umfangreiche technische Architekturen, regelmäßige Datenpflege und Sicherheitseinrichtungen unabdingbar. Abschließend lässt sich sagen, dass Prompting eine wesentliche Rolle bei der Mensch-KI-Interaktion und der schnellen Entwicklung von Anwendungen spielt, aber allein nicht ausreichend ist, um komplexe KI-basierte Werkzeuge vollständig zu realisieren. Die Kombination aus intelligenten Prompting-Techniken, durchdachter Systemintegration und kontinuierlichem Lernprozess bildet den Schlüssel zum Erfolg bei der Entwicklung leistungsfähiger KI-gestützter Tools.

Nur wenn diese Komponenten harmonisch zusammenspielen, können die enormen Potenziale von Künstlicher Intelligenz wirklich ausgeschöpft werden und innovative Lösungen wie Cursor, V0 oder ähnliche Systeme dauerhaft überzeugen.