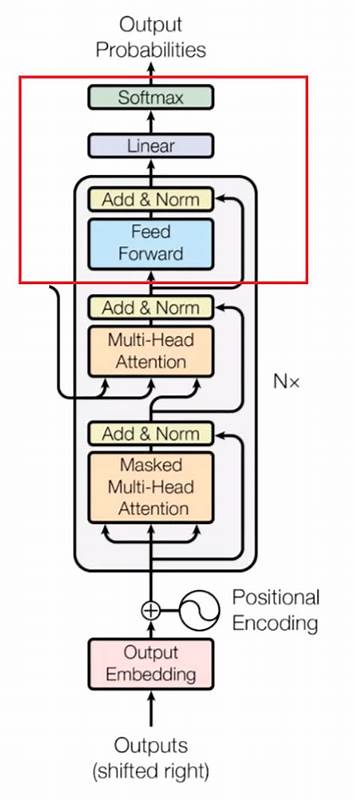

Conways Game of Life ist ein bekanntes zelluläres Automaten-Spiel, das auf einfachen Regeln basiert und dennoch faszinierend komplexe Muster hervorbringt. Die Fähigkeit, solche Systeme mithilfe künstlicher Intelligenz zu simulieren, dominiert zunehmend die Forschungslandschaft. Kürzlich wurde gezeigt, dass ein hochgradig vereinfachtes Transformer-Neuronales Netzwerk, das aus Beispielen trainiert wurde, in der Lage ist, dieses Spiel vollständig zu verstehen und korrekt vorherzusagen. Diese Entdeckung stellt einen bedeutenden Fortschritt dar, da sie beweist, dass neuronale Netzwerke nicht nur statistische Muster lernen, sondern auch regelbasierte Algorithmen eigenständig rekonstruieren können. Der Fokus liegt hierbei auf einem Modell, das als SingleAttentionNet bezeichnet wird und nur aus einem einzelnen Attention-Block mit einer einzigen Kopf-Attention besteht.

Die Methode hebt sich dadurch hervor, dass sie das Spiel als eine Sammlung von Tokens betrachtet, wobei jedes Token einer Zelle des Spielfelds entspricht. Somit kann das Modell mit kontextbezogenen Beziehungen zwischen Zellen interagieren und dadurch wichtige Nachbarschaftsinformationen erfassen. Die zentrale Herausforderung für neuronale Netze bei der Arbeit mit dem Game of Life besteht darin, die nächste Generation des Zellzustands anhand der aktuellen Schritte zu bestimmen. Dabei sind nicht nur die individuellen Zellen von Bedeutung, sondern auch deren unmittelbare 3x3-Nachbarschaft, da die Regeln auf der Anzahl lebender Nachbarn basieren. Typischerweise erfolgt diese Berechnung mit klassischen Methoden wie 3x3 Faltungskernen (Convolutions), die die Nachbarn zählen.

Das Besondere an SingleAttentionNet ist, dass das Modell mithilfe seiner Attention-Mechanismen ebenfalls lernt, diese 3x3-Faltungsvorgänge durchzuführen. Diese Mechanik wird durch das Lernen von gewichteten Verbindungen zwischen Zellen sichtbar, die die Nachbarschaftsinformationen gewichten und so die Grundlage für die Entscheidungsfindung der Lebens- oder Todeszustände bilden. Der Trainingsprozess erfolgt mit zahlreichen zufällig erzeugten Life-Gitterpaaren. Jedes Paar besteht aus dem aktuellen Zustand und dem darauf folgenden, echten nächsten Zustand. Dabei wird das Modell darauf trainiert, die korrekte Vorhersage der nächsten Generation zu erreichen.

Bemerkenswert ist, dass das Training mit einfachen Methoden und vergleichsweise kurzen Zeiträumen auf handelsüblichen Grafikkarten möglich ist – unter bestimmten Hyperparametern und Startbedingungen sogar in wenigen Minuten. Allerdings zeigte sich, dass das Training empfindlich auf bestimmte Einstellungen sowie die Hardwareumgebung reagiert, was ein klassisches Phänomen bei tiefen neuronalen Netzen darstellt. Eine besonders beeindruckende Fähigkeit des Modells ist die perfekte Generalisierung auf bisher unbekannte Ausgangszustände. Nach einem sorgfältigen Training konnte SingleAttentionNet über 10.000 neue zufällig initialisierte Life-Gitter, jeweils 100 Schritte tief, korrekt vorhersagen und damit eine Million einzelne Lebensschritte fehlerfrei simulieren.

Diese Leistung deutet klar darauf hin, dass das Netzwerk nicht nur Muster erkennt, sondern die Regeln des Spiels verinnerlicht hat und prozessorientiert arbeitet. Um dieses Verhalten genauer zu verstehen, wurden die Output-Gewichte des Attention-Blocks analysiert. Dabei wurde festgestellt, dass die modellinternen Attention-Matrizen genau jene 3x3-Gewichte abbilden, die benötigt werden, um die Nachbarschaft der Zellen zu mitteln – allerdings wird die Zelle selbst vom Mittelwert ausgenommen, was exakt den Regeln von Conway entspricht. Ein zusätzlicher linearer Klassifikator verarbeitet anschließend diese konsolidierten Informationen, um aus Nachbarzahlangaben und dem vorherigen Zustand der Zelle ihre zukünftige Lebendigkeit abzuleiten. Weitere Kontrolltests verstärkten die Einsicht, indem die Attention-Schicht durch eine vorgegebene, manuell berechnete Nachbarschafts-Attention-Matrix ersetzt wurde.

Dies ermöglichte das schneller Erlernen und garantierte eine perfekte Umsetzung der Regeln. Offensichtlich entwickelte sich das Modell in der Lage dazu, den Rechenprozess von Conways Game of Life effektiv zu implementieren. Ebenso funktionierte ein Austausch der Attention-Operation durch einen 3x3 Durchschnittspooling-Mechanismus, was den Schluss zulässt, dass das Modell auf Basis grundlegender lokaler Operationen arbeitet. Hinter diesem Erfolg steckt die Fähigkeit von Transformern, komplexe lokale Datenbeziehungen zu erfassen, selbst in simplen Netzwerkkonfigurationen. Dies ist eine wichtige Erkenntnis für die weitere Forschung, da es Signal ist, dass selbst vereinfachte Transformerarchitekturen nicht nur für Sprachmodelle oder Bildverarbeitung geeignet sind, sondern auch klassische algorithmische Regeln adaptiv umsetzen können.

Dadurch eröffnen sich spannende Perspektiven für die Anwendung im Bereich zellulärer Automaten, Simulationssystemen und modellbasierten Vorhersagen, auch über das Game of Life hinaus. Historisch gesehen galt das Game of Life oft als Herausforderung für neuronale Netze: Es ist „hard“ zu lernen, wenn man es rein von der Funktion her betrachtet, da die Regeln zwar eindeutig sind, jedoch komplexe räumliche Beziehungen erzeugen. Frühere Studien zeigten teilweise Schwierigkeiten bei der Konvergenz der Modelle, doch die hier beschriebene Transformer-basierte Herangehensweise stellt eine vereinfachte und robuste Lösung dar. Die Fähigkeit von SingleAttentionNet, sowohl lokal als auch global präzise Vorhersagen zu treffen, belegt, dass neurale Netze mehr können als nur Wahrscheinlichkeiten zu schätzen – sie können algorithmische Abläufe imitiert und damit die zugrundeliegende Logik erlernen. Damit ergänzt diese Arbeit die große Familie von Forschungen rund um transformerbasierte Modelle wie „Attention Is All You Need“, die diese Architektur für unterschiedlichste Aufgaben revolutionär gemacht haben.

Aus technischer Sicht liegt die Stärke im Zusammenspiel von Attention-Mechanismus und einfacher Klassifikation. Während Attention lokale Kontextinformationen angemessen gewichtet, stellt die Klassifikationsschicht sicher, dass die einfachen aber strengen Regeln von Conway korrekt angewandt werden. Die Lebensregel selbst ist erstaunlich einfach formuliert: Eine Zelle lebt oder stirbt basierend auf der Anzahl seiner acht unmittelbaren Nachbarn. Dabei führt genau diese einfache Regel zu einer Vielzahl komplexer Verhaltensmuster, die bei der Nachbildung durch neuronale Netze eine echte Herausforderung darstellen. Die Forschungsarbeit verdeutlicht, dass mit genügend Trainingsdaten und einer geeigneten Netzwerkarchitektur tiefgehendes Verständnis algorithmischer Prozesse erreichbar ist.

Zusätzlich zeigt sie, dass neuronale Netze ihre Struktur auf transparente Weise entwickeln können, die erklärbar und nachvollziehbar ist. Zukunftsperspektivisch könnten solche Modelle helfen, komplexe zelluläre oder physikalische Systeme effizient zu simulieren, was für Anwendungen in Biologie, Physik oder komplexen Netzwerken von großem Nutzen sein könnte. Insgesamt markiert die erfolgreiche Simulation von Conways Game of Life durch das SingleAttentionNet einen bemerkenswerten Fortschritt in der KI-Forschung. Das zeigt, wie auch vergleichsweise einfache Transformer-Netzwerke tiefgreifende algorithmische Fähigkeiten lernen können, was weitreichende Implikationen für die Weiterentwicklung autonomer Systeme und künstlicher Intelligenz spricht. Für Interessierte sind sowohl der Quellcode als auch die vortrainierten Gewichte frei verfügbar, was die Nachvollziehbarkeit und Weiterentwicklung dieses Ansatzes fördert.

Neben den praktischen Erkenntnissen bietet dieses Projekt einen faszinierenden Einblick in das Potential neuronaler Netzwerke, klassische Probleme in der Forschung erfolgreich zu meistern und innovativ zu interpretieren.