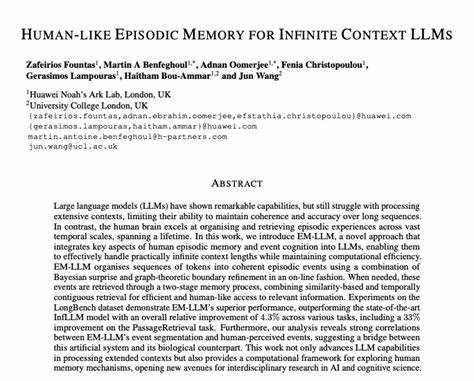

Die rasante Entwicklung im Bereich der Künstlichen Intelligenz hat Large Language Models (LLMs) zu einem wichtigen Werkzeug in unterschiedlichen Anwendungen gemacht. Trotz beeindruckender Fortschritte stoßen diese Modelle jedoch weiterhin an Grenzen, insbesondere wenn es darum geht, große Textkontexte über lange Zeiträume hinweg sinnvoll und kohärent zu verarbeiten. Menschliche Kommunikationsfähigkeit und das episodische Gedächtnis hingegen zeigen, wie komplexe Informationen über eine lange zeitliche Achse organisiert und erinnert werden können. Die Forschung hat daher begonnen, Aspekte des menschlichen episodischen Gedächtnisses in KI-Systeme zu integrieren, um diese Herausforderung zu meistern. Ein herausragendes Beispiel hierfür ist das sogenannte EM-LLM – ein neuartiger Ansatz, der versucht, menschliche Gedächtnisstrukturen in Verarbeitungseinheiten von LLMs zu übertragen und damit praktisch unbegrenzte Kontextlängen handhabbar zu machen.

Anders als herkömmliche Modelle verwendet EM-LLM keine aufwendigen Feinabstimmungen der Modelle, sondern setzt auf eine intelligente Organisation und gezielte Speicherung von Informationseinheiten, den sogenannten episodischen Ereignissen. Die Methode stützt sich dabei auf eine Kombination aus dem Konzept des Bayesian Surprise und graphentheoretischer Analyse, um Ereignisgrenzen online und adaptiv zu erkennen und zu definieren. Bayesian Surprise bezeichnet das Maß an unerwarteter Information in einem Eingabestrom. Indem das System fortlaufend Überraschungsmomente analysiert, gelingt es, den Kontext in sinnvoll abgegrenzte Episoden zu segmentieren. Die graphentheoretische Komponente verfeinert diese Grenzen, indem sie Beziehungen und Verbindungen zwischen verschiedenen Token innerhalb der Ereignisse untersucht.

So entsteht eine strukturierte, kohärente Gliederung des Inputs, welche die spätere Verarbeitung und den Abruf wesentlich erleichtert. Die Speicherstruktur von EM-LLM baut auf einem zweistufigen Abrufmechanismus auf, der das Abrufen von benötigten Informationen ähnlich menschlichen Gedächtnisprozessen gestaltet. Zunächst wird eine Ähnlichkeitssuche durchgeführt, um relevante Erinnerungen zu identifizieren. Im Anschluss sorgt eine zeitlich kontiguierliche Suche dafür, dass zusammenhängende Episoden in korrekter chronologischer Reihenfolge abgerufen werden. Diese Strategie ermöglicht eine schnelle und effiziente Informationsbeschaffung, die auch bei sehr umfangreichen Kontexten stabil bleibt.

Experimentelle Ergebnisse bestätigen die Leistungsfähigkeit von EM-LLM auf mehreren Benchmarks, unter anderem LongBench und InfiniteBench. Gegenüber aktuellen Spitzenmodellen wie InfLLM erreicht EM-LLM sowohl in punkto Genauigkeit als auch Kohärenz signifikante Verbesserungen. Beeindruckend ist zudem, dass die Methode selbst bei der Verarbeitung von bis zu zehn Millionen Tokens funktioniert, eine Größenordnung, die traditionelle vollkontextuelle Modelle schlichtweg nicht bewältigen können. Gegenüber populären Retrieval-Methoden wie RAG weist EM-LLM bei vergleichbarem Ressourcenverbrauch ebenfalls eine bessere Performance auf. Ein weiterer faszinierender Aspekt dieser Forschung liegt in der Erkenntnis, dass die algorithmisch bestimmten Ereignisse von EM-LLM stark mit menschlich wahrgenommenen Ereignissen korrelieren.

Diese Beobachtung legt nahe, dass das Modell nicht nur technische Fortschritte darstellt, sondern auch einen wertvollen Beitrag zum besseren Verständnis biologischer Gedächtnisprozesse leisten kann. Im weiteren Kontext der KI-Entwicklung stellen solche bioinspirierten Ansätze einen vielversprechenden Weg dar, um die Limitierungen herkömmlicher Modelle zu überwinden. Während klassische LLMs auf statischen Kontextfenstern beruhen, bieten episodische Speicherstrukturen das Potenzial, viel dynamischere und nachhaltigere Gedächtnisfunktionen nachzubilden. Die online ablaufende Segmentierung und Speicherung ermöglicht eine kontinuierliche Verarbeitung großer Datenströme, wie sie in natürlicher Kommunikation und komplexen Anwendungsszenarien vorkommen. Das hat nicht nur technische Vorteile, etwa in Chatbots, automatischen Übersetzern oder Dokumentenanalysen, sondern könnte auch in Bereichen wie personalisierten Assistenzsystemen, Langzeitinteraktionen und Wissensmanagement transformative Wirkungen entfalten.

Die Integration von EM-LLM in bestehende Frameworks gestaltet sich zudem ressourcenschonend, da kein umfassendes Re-Training der großen Sprachmodelle erforderlich ist. Diese Eigenschaft erleichtert die Implementierung und Verbreitung in der Praxis. Entscheidend bleibt jedoch, wie die Forschung die Langzeitstabilität, Robustheit gegenüber fehlerhaften Eingaben und Adaptivität an verschiedene Domänen weiter verbessert. Außerdem erlaubt die eventbasierte Modellierung auch neue Einblicke in die Erforschung menschlicher Kognition. Die Lage und Dynamik von Ereignisgrenzen lässt Rückschlüsse zu auf Aufmerksamkeitsprozesse, Gedächtniskonsolidierung und die Entstehung von Bewusstsein.

So erweitert sich der Kreis der Anwendungsmöglichkeiten von EM-LLM weit über die Computerwissenschaft hinaus in die Neurowissenschaften und Psychologie. Abschließend lässt sich sagen, dass der Ansatz, menschliches episodisches Gedächtnis in LLMs aufzugreifen, ein richtungsweisender Schritt auf dem Weg zu wirklich intelligenten Systemen ist. EM-LLM zeigt, wie Prinzipien aus der Biologie und Kognitionswissenschaft erfolgreich in die technische Entwicklung übertragen werden können, um Herausforderungen wie das Grenzenproblem bei der Kontextverarbeitung wirksam zu begegnen. Der Fortschritt dieser Forschung wird zweifelsohne die nächste Generation von Sprachmodellen prägen und den Weg zu einer natürlicheren, menschennäheren Interaktion mit KI ebnen.