Die Grafikprozessoren (GPUs) der heutigen Zeit sind Meister der Parallelverarbeitung. Dank ihres Designs können sie große Mengen an Daten gleichzeitig und effizient verarbeiten. Klassische Grafik-Workloads, wie das Rendern von Geometrien oder Pixeln, werden dabei durch feste und programmierbare Hardwareeinheiten abgewickelt. Allerdings zeigt die Praxis, dass diese einzelnen Einheiten oft sehr ungleich ausgelastet sind, was zu einer suboptimalen Performance führen kann. In solchen Situationen kommt das Konzept der Asynchronous Compute, kurz Async Compute, ins Spiel, das die Effizienz moderner GPUs erheblich steigert, indem es Grafik- und Rechenaufgaben parallel ausführt.

Dieser Artikel beleuchtet, wie Async Compute funktioniert, welche Vorteile es bietet und wie Entwickler es effektiv einsetzen können. Zunächst einmal ist es wichtig, das grundsätzliche Architekturmodell moderner GPUs zu verstehen. GPUs besitzen spezialisierte Pipeline-Stufen, die unterschiedliche Aufgaben übernehmen. Feste Funktionseinheiten wie der Input Assembler oder der Rasterizer verarbeiten gezielt Geometrien, während die programmierbaren Einheiten, die sogenannten Streaming Multiprozessoren (SMs), Shadercode ausführen – sei es für Vertex-, Pixel- oder Compute-Shaders. Diese Struktur ermöglicht es GPUs, eine enorme Menge an parallelen Threads zu verarbeiten, vor allem bei Grafikaufgaben.

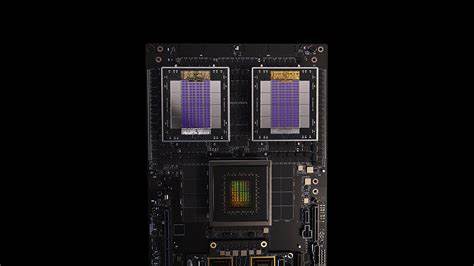

Allerdings entsteht hierbei oft eine ungleiche Lastverteilung: Wenn zum Beispiel eine Aufgabe stark von der Geometrieverarbeitung abhängig ist, wie etwa eine Schattenpass- oder G-Buffer-Erstellung, werden die Geometrieeinheiten stark beansprucht, während die SMs eher unterfordert bleiben. Umgekehrt kann ein rechenintensiver Pixel-Shader die SMs auslasten, während die geometrischen Stufen weniger aktiv sind. Dieses Ungleichgewicht führt dazu, dass Teile der GPU nicht vollständig genutzt werden – eine Verschwendung wertvoller Ressourcen. Die Idee hinter Async Compute ist es, diese Leerlaufzeiten durch paralleles Ausführen verschiedener Aufgaben unterschiedlicher Natur zu minimieren. Hersteller wie AMD (Async Compute) und NVIDIA (Simultaneous Compute and Graphics) haben in ihren GPUs getrennte Hardwarepipelines eingeführt: eine für Grafik und eine für Compute-Aufgaben.

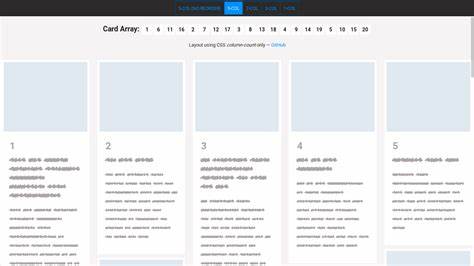

Dies ermöglicht es, Befehle aus Grafik- und Compute-Queues gleichzeitig auf verschiedenen Hardwareeinheiten zu schedulen und somit die Auslastung der GPU insgesamt zu erhöhen. Auf Softwareseite abstrahieren moderne Grafik-APIs wie DirectX 12 diese Hardwarepipelines durch das Konzept der Kommando-Queues. Es existieren mindestens zwei relevante Queues: eine für Grafik- und gemischte Compute-Befehle sowie eine spezifische Compute-Queue für reine Compute-Shader. Entwickler können damit gezielt Befehle an die passende Queue senden und die parallele Ausführung fördern. Allerdings erfordert Async Compute ein sorgfältiges Management von Synchronisationen und Abhängigkeiten zwischen den Queues.

Für eine korrekte Einhaltung der Reihenfolge bestimmter Operationen werden sogenannte Fences genutzt. Diese ermöglichen es, den Abschluss von Aufgaben auf einer Queue zu erkennen und den Start anderer Aufgaben entsprechend zu koordinieren. Durch Signal- und Wartebefehle zwischen den Queues wird sichergestellt, dass etwa ein Berechnungsergebnis vor der weiteren Nutzung fertiggestellt ist, während gleichzeitig maximale Parallelität gewährleistet wird. Das Management der Ressourcenzustände zwischen den Pipelines stellt eine weitere Herausforderung dar. Weil die Compute-Queue nicht auf feste Funktionseinheiten wie Rasterizer oder Render-Targets zugreifen kann, müssen Übergänge von Ressourcen wie Renderzielzuständen zwingend über die Grafik-Queue erfolgen.

Dadurch entsteht ein zusätzliches Synchronisations- und Verwaltungs-Overhead, den Entwickler bei der Implementation berücksichtigen müssen. Trotzdem erlaubt Async Compute in vielen Szenarien eine deutliche Leistungssteigerung. Ein praktisches Beispiel ist die Verwendung von Screen-Space Ambient Occlusion (SSAO) Techniken, wie Ground Truth Ambient Occlusion (GTAO). GTAO ist häufig stark vom Cache und den ALUs (den Recheneinheiten) abhängig, während etwa eine Raytraced Shadows-Pass auf dedizierten Raytracing-Kernen läuft. Da diese Aufgaben unterschiedliche Hardwareeinheiten beanspruchen, bietet sich die parallele Ausführung über Async Compute geradezu an.

Untersuchungen zeigen, dass die gleichzeitige Ausführung von GTAO auf der Compute-Queue und Raytraced Shadows auf der Grafik-Queue die gesamte Framezeit signifikant reduzieren kann. Während die einzelnen Aufgaben durch Ressourcenwettbewerb teilweise langsamer werden, ist der Gesamtdurchsatz höher, was dem schnellen Wechsel der Engpässe im GPU-Processing entgegenkommt. Die Balance zwischen den parallel ausgeführten Aufgaben ist entscheidend für den Erfolg von Async Compute. Werden zum Beispiel zwei stark ALU-bound Aufgaben gleichzeitig ausgeführt, kann es zu einem Performanceverlust durch erhöhte Kontention kommen. Darum empfiehlt es sich, Workloads sorgfältig zu analysieren, deren Engpässe zu erkennen und gezielt solche Aufgaben zu kombinieren, die unterschiedliche Ressourcen auf der GPU auslasten.

Dieses fine-tuning ist oft experimenteller Natur und stark hardwareabhängig. Der Entwickler muss testen, welche Kombinationen von Passes die einzelne GPU-Generation am besten ausnutzt. In der Praxis profitieren vor allem komplexe, moderne Engines von Async Compute. Der typische Frame beginnt oftmals mit Aufgaben, die dominant von Geometrieverarbeitung und Rasterisierung abhängen, wie Schatten- oder G-Buffer-Pässe. Diese Phasen beanspruchen viele feste Pipelinestufen und wenig SMs.

Später im Frame folgen meist Pixelshader- oder Compute-intensive Aufgaben. Async Compute kann diese zeitlich überlappenden Phasen nutzen, um die freien Recheneinheiten während geometrischer Pässe mit zusätzlichen Compute-Shadern oder anderen parallelen Aufgaben auszulasten. Dadurch wird der GPU-Leerlauf reduziert und die Gesamtdurchsatzrate erhöht. Die Implementierung von Async Compute erfordert jedoch eine präzise Abstimmung der Synchronisationsmechanismen. Das Warten mit der Wait()-Funktion auf das Signal einer anderen Queue blockiert zwar nur die GPU-Pipeline und nicht die CPU, kann aber im schlimmsten Fall zu sogenannten „Bubbles“ führen: Zeitfenster, in denen die GPU untätig auf Fertigstellung einer Aufgabe wartet.

Ein bewusstes Scheduling und das Minimieren dieser Wartezeiten sind deshalb essentiell, um die Vorteile von Async Compute voll auszuschöpfen. Auch der Wechsel zwischen Async- und Non-Async-Execution-Pfaden bei bestimmten Aufgaben hilft, mögliche Engpässe zu identifizieren und Optimierungspotenziale zu evaluieren. Neben der Synchronisation spielt auch die Ressourcenumstellung eine Rolle. Ressourcen müssen in die passenden Zustände versetzt werden, sei es als Renderziel, Shader-Ressource oder für Compute-Zugriff. Da die Compute-Queue nicht direkt mit allen GPU-Festfunktionen interagiert, ist es wichtig, dass State-Transitions von Ressourcen, die beispielsweise an der Grafikpipeline beteiligt sind, auf der Grafik-Queue durchgeführt werden.

Dieses Detail verhindert häufige Fehler und Ungenauigkeiten in der Ressourcenverwaltung, die zu Rendering- oder Synchronisationsproblemen führen können. Zusammenfassend ist Async Compute eine moderne Technik, die das enorme Parallelisierungspotenzial heutiger GPUs durch getrennte Hardwarepipelines für Grafik- und Compute-Arbeiten ausnutzt. Die parallele Ausführung unterschiedlicher Aufgabengruppen optimiert die Ressourcenauslastung auf Hardwareebene und erhöht so die Gesamtleistung. Dennoch setzt Async Compute voraus, dass Entwickler ihre Workloads genau analysieren und sorgfältig abstimmen. Die Erkennung der Flaschenhälse, die richtige Paarung von Passen mit komplementären Workloads und die Konstruktion sinnvoller Synchronisationspunkte sind entscheidend für den Erfolg.

Dies erfordert neben technischem Know-how auch häufige Performance-Analysen und Experimentierfreude. Die Zukunft verspricht weitere Fortschritte in der GPU-Architektur, die Async Compute noch effektiver machen werden. Mit wachsender Anzahl an Recheneinheiten, verbesserten Scheduling-Mechanismen und höherer Hardwareflexibilität wird auch die parallele Abarbeitung von Grafik- und Compute-Workloads effizienter und zugänglicher. Entwickler, die sich heute mit der Technik vertraut machen und optimale Nutzungsszenarien finden, sichern sich Wettbewerbsvorteile bei der Gestaltung leistungsstarker und moderner Grafikengines. Weiterführende Quellen und technische Präsentationen von namhaften GPU-Herstellern bieten detaillierte Einblicke für Interessierte und Profis.

Ein tieferes Verständnis der API-Performance, Synchronisationsmethoden und des Scheduling-Verhaltens hilft, Async Compute in eigene Projekte sinnvoll zu integrieren. Dabei sollte stets die Hardware-Kompatibilität beachtet werden, da die Unterstützung und Effizienz von Async Compute zwischen verschiedenen GPU-Generationen und Herstellern variieren kann. Letztlich führt kein Weg am praktischen Ausprobieren und Profilerstellen vorbei. Nur durch gezielte Tests können Entwickler herausfinden, welche Kombinationen von Grafik- und Compute-Aufgaben das Potenzial von Async Compute auf der jeweiligen Zielhardware wirklich entfalten – und so schließlich die bestmögliche Performance herausholen.