Die Digitalisierung und Automatisierung prägen längst alle Lebensbereiche, und die Programmierung als Kern der Softwareentwicklung bleibt davon nicht unberührt. In den letzten Jahren haben große Sprachmodelle (Large Language Models, LLMs) wie GPT-3, Claude oder Sonnet erhebliche Aufmerksamkeit auf sich gezogen. Besonders im Feld der Softwareentwicklung entstehen neue Möglichkeiten, die Effizienz und Kreativität von Entwicklern zu steigern. Doch wie genau verändern LLM-basierte Coding-Assistenten den Alltag erfahrener Programmierer? Und welche Rolle spielen sie bei der Erweiterung des Programmiervokabulars und dem Lernen neuer Sprachen? Die Antworten darauf sind vielschichtig und geben Aufschluss über die Zukunft der Programmierung im Zeitalter der KI-gestützten Hilfsmittel. Ein Erkenntnisgewinn, der weit über philosophische Diskussionen zur Effizienzsteigerung oder zum möglichen Verfall klassischer Programmierfähigkeiten hinausgeht.

Historisch gesehen war die Einführung neuer Werkzeuge und Technologien in der Softwareentwicklung stets mit Skepsis verbunden. Vor allem wenn es um Automatisierung geht, halten viele Programmierer an bewährtem Handwerk fest und fürchten eine Abhängigkeit von Maschinen. Die ersten Erfahrungen mit GPT-3 und ähnlichen Modellen waren daher gemischt. Viele Nutzer empfanden die Ergebnisse als wenig überzeugend oder als „mittelmäßig“, wenn man den Zeitaufwand und den praktischen Nutzen gegeneinander abwog. Doch mit fortschreitender Entwicklung und der Verfügbarkeit spezialisierter Modelle wie Claude in der Version 3.

5 Sonnet verbesserte sich die Benutzererfahrung erheblich. Eine engere Integration in Entwicklungsumgebungen wie dem Editor Zed sorgt dafür, dass der Einsatz solcher Modelle nahtloser, intuitiver und produktiver wird. Eine der größten Stärken von LLM-basierten Coding-Assistenten liegt weniger in der automatischen Codevervollständigung oder in der Generierung komplizierter Algorithmen als vielmehr in ihrer Rolle als dialogbasierte Helfer. Entwickler können gezielt Fragen stellen, etwa "Wie mache ich X in Sprache Y?", und erhalten schnelle und präzise Antworten, die ansonsten mühsam in Handbüchern oder auf Nutzerforen recherchiert werden müssten. Dies senkt die Einstiegshürde beim Erlernen neuer Programmiersprachen signifikant.

Häufig verfügen erfahrene Entwickler über klare Vorstellungen davon, was sie erreichen möchten, kennen jedoch nicht die exakten Syntaxdetails oder speziellen Bibliotheksfunktionen. Hier fungiert der Assistent als eine Art persönlicher Tutor, der Syntax, Semantik und Struktur erklärbar macht und so die Lernkurve abflacht. Dieser Vorteil zeigt sich besonders dann, wenn man innerhalb der gleichen Arbeitsumgebung verbleiben kann, ohne ständig zwischen Editor und externen Quellen wie etwa offiziellen Dokumentationen oder Online-Foren wechseln zu müssen. Die Verringerung solcher Kontextwechsel steigert die Konzentration, vermeidet Ablenkungen und lässt mehr Zeit für den kreativen Aspekt des Programmierens. Deshalb integrieren moderne Coding-Assistenten nicht nur Schnittstellen zu großen Sprachmodellen, sondern verknüpfen diese eng mit der Entwicklungsumgebung.

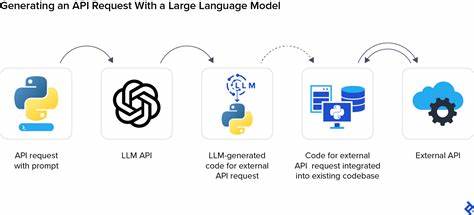

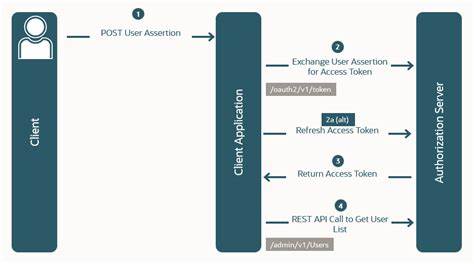

So ist beispielsweise die Kombination aus Zed und Claude 3.5 Sonnet ein hervorragendes Beispiel für eine solche Symbiose. Die Anwendungen, die durch LLM-basierte Assistenten möglich werden, beschränken sich jedoch nicht nur auf einfache Syntaxfragen. Entwickler interessieren sich zunehmend auch für komplexere Tasks, die über reine Codeunterstützung hinausgehen. Ein Forschungsschwerpunkt liegt auf der automatisierten Generierung von Bindings für C-Bibliotheken in anderen Programmiersprachen.

Solche Bindings sind oft manuelle und zeitaufwändige Arbeiten, die der Übergang zwischen verschiedenen Ökosystemen erleichtern. Dass ein Modell hier assistieren kann, ermöglicht neue Möglichkeiten in der Softwareintegration und spart wertvolle Entwicklungszeit. Des Weiteren ist es spannend, ein Protokoll oder eine Spezifikation dem Modell zu übergeben und es iterativ eine Implementierung ausarbeiten zu lassen. Das ist besonders für experimentelle oder akademische Projekte relevant, bei denen neue, oft komplexe Programmierparadigmen erforscht werden. Unterfüttert mit zusätzlichen Kontextdaten wie wissenschaftlichen Artikeln kann das Modell fundierte Lösungsvorschläge liefern und so als eine Art kollaborativer Entwicklerpartner auftreten.

Diese kooperative Entwicklung von Software eröffnet neue Denkweisen im Softwaredesign. Nicht zuletzt betrachten viele Entwickler LLMs als Katalysator, um jüngeren oder weniger ausgereiften Programmiersprachen zentrale Bibliotheken oder Werkzeuge hinzuzufügen. Funktionen wie JSON-RPC-Server, Linter, Formatierer oder Sprachserver sind essenziell, um die Akzeptanz und den Einsatz einer Sprache in der Praxis zu erhöhen. Die automatisierte Generierung solcher Kern-Komponenten durch KI kann der Verbreitung neuer Sprachen maßgeblich Vorschub leisten. Beim Prototyping von Anwendungen sind schnelle und flexible Ergebnisse entscheidend.

Hiermit fallen vor allem Frameworks wie React ins Gewicht, bei denen Entwickler darauf achten, möglichst effizient komponentenbasierte Oberflächen zu bauen. LLM-Assistenten erleichtern das zügige Erstellen von React-Komponenten, indem sie basierend auf Vorgaben sofort passenden Code generieren und so Iterationszyklen deutlich verkürzen. Trotz all dieser Fortschritte bleibt jedoch eine kritische Einordnung notwendig. Das Aufkommen von KI-generiertem Content hat eine Flut von teilweise minderwertigen Inhalten im Internet ausgelöst, die den Blick auf das Wesentliche erschwert. Die Herausforderung für Entwickler ist daher, diese Informationen zu filtern und gezielt die wertvollen und gut ausgearbeiteten Vorschläge herauszufiltern.

Nur dadurch kann sich das Potenzial der Coding-Assistenten voll entfalten. Ein weiterer interessanter Ansatz, den einige Entwickler verfolgen, ist das Fine-Tuning von Modellen auf eigene Bedürfnisse oder der Einsatz von Prompt-Caching. Letzteres sorgt dafür, dass besonders effiziente oder häufig genutzte Abfragen rasch wiederverwendet werden können, was zusätzlich Zeit spart und die Interaktionsqualität verbessert. Gerade in forschungsintensiven Bereichen oder bei sehr spezialisierten Programmiersprachen kann dies ein entscheidender Vorteil sein. Auch die Ergonomie der Syntax und Programmiersprachen-Designs wird dadurch beeinflusst.

Projekte, die auf fortgeschrittenen Konzepten wie abhängigen Typen, Nebenläufigkeit oder Speicherverwaltung basieren, können durch KI-Unterstützung neu bewertet und weiterentwickelt werden. Der interaktive Austausch mit einem LLM bietet Entwicklern neue Werkzeuge, um Fehler zu erkennen, Syntax besser handhabbar zu machen und Konzepte verständlicher zu formulieren. Zusammenfassend lässt sich festhalten, dass LLM-basierte Coding-Assistenten längst kein Zukunftsthema mehr, sondern praktische Hilfsmittel im Alltag vieler Entwickler sind. Sie ergänzen Programmiersprachen und Entwicklungswerkzeuge um einen interaktiven, lernfördernden und produktivitätssteigernden Baustein. Insbesondere erfahrene Programmierer profitieren vom schnellen Zugriff auf Syntaxinformationen und Standardbibliotheken, ohne Bildschirmwechsel oder lange Recherchephasen.

![It's Not Magic: Securing Modern Apps with PKCE [video]](/images/45614606-B3C7-4F8D-A328-7968749903DA)