In den letzten Jahren haben große Sprachmodelle (Large Language Models, LLMs) stetig an Bedeutung gewonnen und sind aus der Forschung sowie vielen Anwendungsfeldern nicht mehr wegzudenken. Die Fähigkeit dieser Modelle, natürliche Sprache zu verstehen und zu generieren, eröffnet völlig neue Möglichkeiten für die Interaktion zwischen Menschen und Künstlicher Intelligenz (KI). Doch während Einzelmodelle bereits erstaunliche Leistungen vollbringen, rückt zunehmend die Frage in den Fokus, was passiert, wenn viele dieser KI-Agenten miteinander in einem Netzwerk kommunizieren und interagieren. Können sich in diesen Populationen soziale Konventionen oder Normen spontan herausbilden? Wie wirken sich individuelle Präferenzen und Verzerrungen auf das kollektive Verhalten aus? Und wie robust sind solche Verhaltensmuster gegenüber gezielten Eingriffen oder Minderheitsmeinungen? Diese Fragen sind entscheidend für das Verständnis von Mehragentensystemen auf Basis von LLMs und deren potenziellem Einfluss auf reale gesellschaftliche und technologische Umgebungen. Die Entstehung sozialer Konventionen ist ein grundlegendes Element menschlichen Zusammenlebens.

In der Soziologie und Spieltheorie werden Konventionen als ungeschriebene Regeln verstanden, die sich im Laufe von Interaktionen in Gruppen etablieren und das Verhalten koordinieren. Darunter fallen alltägliche Dinge wie Begrüßungsformen, Sprachgewohnheiten oder gemeinsame moralische Urteile. Forschungen haben gezeigt, dass solche Konventionen oft ohne zentrale Autorität und nur durch wiederholte lokale Interaktionen entstehen können – ein Phänomen, das auch als spontane Ordnung beschrieben wird. Überträgt man dieses Konzept auf Populationen von LLM-Agenten, gibt es mehrere Schlüsselfragen, die beantwortet werden müssen. Erstens, können LLMs, die in Simulationen als Agenten agieren und in Paarinteraktionen natürliche Sprache verwenden, aus eigenem Antrieb gemeinsame Konventionen entwickeln? Zweitens, wie wirken sich anfängliche individuelle Verzerrungen in der Auswahl von Begriffen oder Namen auf das kollektive Verhalten der Population aus? Drittens, wie widerstandsfähig sind diese gemeinsamen Normen gegenüber einer kleinen Gruppe von „überzeugten“ Agenten, die bewusst eine alternative Konvention forcieren, um die Gesellschaft zu verändern? Experimentelle Studien mit Populationen von LLM-Agenten zeigen, dass soziale Konventionen tatsächlich spontan entstehen.

Dies erfolgt auf Basis eines sogenannten „Naming Games“, bei dem Agenten in zufällig ausgewählten Paaren jeweils einen Namen oder eine Bezeichnung auswählen, um eine erfolgreiche Koordination anzustreben. Ihr Ziel ist es, möglichst oft mit ihrem Gegenüber denselben Begriff zu wählen, wodurch ein kollektiver Nutzen entsteht. Die Agenten verfügen über ein begrenztes Gedächtnis der letzten Interaktionen, basieren ihre Entscheidungen jedoch nur auf ihren lokalen Erfahrungen, ohne zentrale Steuerung oder globales Wissen über die gesamte Population zu besitzen. Die Ergebnisse der Simulationen demonstrieren, dass sich nach mehreren Runden eine gemeinsame Konvention durchsetzt, mit der jeder Agent konsistent interagiert. Dieses Phänomen entspricht einer Symmetriebrechung, da aus einer Vielzahl gleicher Möglichkeiten plötzlich eine dominante Lösung hervorgeht.

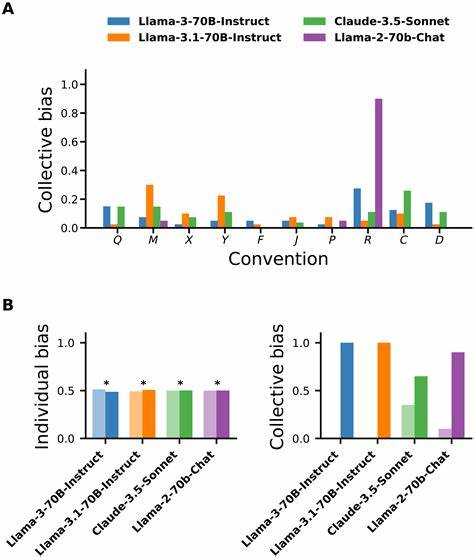

Auffällig ist, dass unterschiedliche LLM-Modelle dabei ähnliche Konvergenzgeschwindigkeiten aufweisen, obwohl ihre individuellen Eigenschaften variieren. Eine Konvention, die am Anfang nur eine zufällige lokale Präferenz war, gewinnt durch Wiederholungen und gegenseitiges Lernen zunehmend an Bedeutung und verdrängt andere Optionen. Doch die Entwicklung von sozialen Normen in diesen KI-Populationen weist auch einige Eigenheiten auf, die sich vom klassischen Verständnis menschlicher sozialen Dynamiken unterscheiden. Zwar wäre theoretisch zu erwarten, dass die Wahrscheinlichkeit, welche Konvention sich durchsetzt, bei gleicher Ausgangslage gleichverteilt ist. Die Experimente zeigen jedoch, dass bestimmte Konventionen bevorzugt werden, was auf kollektive Verzerrungen zurückzuführen ist – selbst wenn die einzelnen Agenten ursprünglich keine individuellen Vorurteile besitzen.

Diese kollektive Bias entsteht durch komplexe Rückkopplungen zwischen den Gedächtnistatistiken der Agenten und deren Entscheidungsprozessen. Analysen tieferer Interaktionsphasen offenbaren, dass erfolgreiche Koordination dazu führt, dass ein Agent in der nächsten Runde mit hoher Wahrscheinlichkeit denselben Begriff verwendet. Im Falle von Fehlkoordination wird dagegen fast immer ein Wechsel der Konvention vollzogen. Die dabei entstehenden unterschiedlichen Häufigkeiten von Erfolg und Misserfolg für einzelne Begriffe verstärken im Laufe der Zeit die Präferenz für eine dominante Konvention. Dieses ausgewogene Zusammenspiel von Lernen, Belohnung und Anpassung schafft eine verstärkende Schleife, die eine kollektive Verzerrung hervorbringt und den konvergenten Sozialvertrag in der KI-Population stabilisiert.

Neben der Entstehung von sozialen Konventionen und kollektiven Bias spielt auch die Untersuchung der Stabilität solcher Normen eine wichtige Rolle. Was passiert, wenn eine kleine, entschlossene Minderheit von KI-Agenten eine alternative soziale Norm konsequent propagiert? Studien legen nahe, dass eine kritische Schwelle der Größe dieser Subgruppe erreicht werden muss, damit sie die bestehenden Konventionen der Mehrheit kippen kann. Dieser sogenannte „Critical Mass“-Effekt ist gut dokumentiert in menschlichen Sozialwissenschaften und lässt sich auch in LLM-Populationen beobachten. Je nach Stärke und Verankerung der dominanten sozialen Norm sowie den Eigenschaften des Sprachmodells variiert diese Schwelle enorm. Manche LLM-Simulationen zeigen, dass bereits kleine Minderheiten von zwei Prozent die Gesellschaftsordnung verändern können, während in anderen Fällen mehr als zwei Drittel nötig sind, um eine Konventionsänderung voranzutreiben.

Dieses Spektrum unterstreicht die vielschichtigen Dynamiken und das Zusammenspiel von individuellen Präferenzen, kollektiver Verstärkung und Resistenz gegenüber Veränderungen. Diese Erkenntnisse haben weitreichende Implikationen für die Zukunft von KI-gestützten Systemen und die Gesellschaft. Zum einen illustriert die autonome Herausbildung von sozialen Konventionen in LLM-Populationen, wie KI-Agenten ohne explizite Programmierung gemeinsame Regeln schaffen können, was die Entwicklung kooperativer und selbstorganisierender KI-Ökosysteme vorantreibt. Zum anderen zeigen sich Risiken durch das Entstehen kollektiver Verzerrungen, die selbst bei individual neutralen Agenten zu systematischen Präferenzen führen und möglicherweise zu unerwünschten Ergebnissen oder Benachteiligungen führen können. Ein weiteres ethisches Spannungsfeld ergibt sich durch die Anfälligkeit bestehender sozialer Normen gegenüber gezielten Einflussnahmen einer kleinen, aber entschiedenen Gruppe von Agenten.

Diese Dynamiken sind analog zu Phänomenen im realen sozialen Raum, etwa der Verbreitung von Desinformation oder der Veränderung gesellschaftlicher Normen durch koordinierte Minderheiten. In KI-Systemen könnten solche Mechanismen genutzt oder missbraucht werden, um normative Vorgaben zu untergraben oder zu bestimmen. Aus technischer Sicht fordert die Forschung ein Umdenken in der Entwicklung von LLMs und Multi-Agenten-Systemen. Die reine Bewertung individueller Bias ist nicht ausreichend, wenn die kollektiven Effekte in Netzwerken von entscheidender Bedeutung sind. Entsprechende Testverfahren und Sicherheitsmechanismen, die das Zusammenspiel vieler KI-Agenten analysieren und kontrollieren, müssen entwickelt werden.

Dazu gehören sowohl die Überwachung emergenter Sozialnormen in diesen Populationen als auch Interventionen gegen potenziell schädliche Tendenzen. Zukunftsorientiert eröffnet die Untersuchung von sozialen Konventionen in LLM-Populationen spannende Möglichkeiten. So können KI-Systeme befähigt werden, gesellschaftlich wünschenswerte Normen und Verhaltensweisen zu fördern, etwa im Kampf gegen kollektive Probleme wie Antibiotikaresistenzen oder den Klimawandel. Gleichzeitig können Modelle für die Simulation sozialer Konventionen als digitale Zwillinge dienen, um menschliche Gesellschaften besser zu verstehen und politische Entscheidungen zu unterstützen. Gleichzeitig bleibt die Herausforderung bestehen, die Unterschiede zwischen KI-generierten Normen und menschlichen sozialen Dynamiken genauer zu analysieren.