In der dynamischen Welt der Datenbanksysteme stehen Unternehmen immer wieder vor der Herausforderung, ihre Infrastruktur an neue Anforderungen anzupassen. Die Wahl der richtigen Datenbanklösung wirkt sich maßgeblich auf Performance, Skalierbarkeit und Betriebskosten aus. Besonders bei der Migration von einer verteilten SQL-Datenbank wie CockroachDB hin zu einem traditionellen, bewährten System wie PostgreSQL zeigen sich spannende technische und operative Aspekte. Im Folgenden wird erläutert, welche Erfahrungen Unternehmen bei einer solchen Migration machen, welche Hürden es zu überwinden gilt und wie sich die Umstellung auf PostgreSQL langfristig auszahlen kann. CockroachDB hat sich seit seiner Markteinführung als verteilte, horizontal skalierende Datenbank etabliert, die besonders bei Multi-Region-Setups und hoher Verfügbarkeit überzeugt.

Die nahtlose SQL-Kompatibilität erleichtert Entwickler den Einstieg und die Arbeit mit dieser Technologie. Dennoch kann die Nutzung einer verteilten Datenbank Nachteile mit sich bringen, vor allem wenn die spezifischen Multi-Region-Anforderungen bislang nicht zwingend sind und das Anwendungsszenario vor allem einfache transaktionale Abfragen in einer einzigen Region umfasst. Solche Situation war auch beim Unternehmen Motion der Fall, das nach etwa zwei Jahren der Nutzung von CockroachDB feststellte, dass die steigenden Betriebskosten und auftretende technische Probleme eine Neubewertung der Datenbankstrategie erforderlich machten. Die Kostenentwicklung zeigte sich dabei besonders markant: Innerhalb von zwei Jahren stiegen die Ausgaben für CockroachDB um das Fünffache und erreichten mittlere sechsstellige Beträge jährlich. Angesichts des Fehlens unmittelbarer technischer Anforderungen, die den Einsatz einer verteilten Datenbank rechtfertigen würden, stellte sich die Frage, ob nicht eine leistungsfähige, zentralisierte Lösung wie PostgreSQL besser geeignet sei.

Zudem traten bei CockroachDB technische Limitierungen zutage, die den Entwicklungsprozess und den laufenden Betrieb erschwerten. Ein zentraler Schmerzpunkt lag in der Durchführung von Datenbank-Migrationen. Mit wachsender Datenbankgröße war es zunehmend schwierig, Änderungen an der Datenstruktur über das eingesetzte ORM, in diesem Fall Prisma, innerhalb akzeptabler Zeiträume einzuspielen. Migrationsversuche führten häufig zu Timeouts, was wiederholtes manuelles Eingreifen und langwierige Eingriffe in die Produktionsumgebung nach sich zog. Solche Einschränkungen blockierten nicht nur Deployments, sondern führten auch zu operativen Kompromissen und einem erhöhten Risiko für Produktionsausfälle.

Auch die Möglichkeit zur Aktualisierung selbst der CockroachDB-Versionen war durch diese Problemen stark eingeschränkt, was den Support und die Sicherheit negativ beeinflusste. Nicht nur Migrationen, auch ETL-Prozesse litten unübersehbar unter den Limitierungen des bisherigen Systems. Fehlende umfassende Tools und stabile Connectoren für CockroachDB erschwerten den Datenexport und die Integration in andere Systeme. Die bisher eingesetzte Lösung, Airbyte, verfügte über einen Connector, der sich noch im Alpha-Stadium befand und durch erhebliche Performance-Probleme, darunter Speicherlecks, auffiel. Diese Faktoren wirkten sich negativ auf Zuverlässigkeit und Wartbarkeit aus.

Im Bereich der Datenabfragen zeigte sich ein gemischtes Bild. Während CockroachDB für bestimmte Abfragen dank eines optimierten Query Planners Vorteile mit sich brachte und in Einzelfällen schnellere Ergebnisse lieferte, offenbarten sich bei den meisten realen Anwendungsfällen erhebliche Performance-Einbußen. Insbesondere die durch Prisma generierten komplexen SQL-Statements führten auf CockroachDB oft zu vollumfänglichen Tabellenscans und langen Antwortzeiten. Im Vergleich dazu zeigte PostgreSQL eine deutlich robustere Performance, steigere die Geschwindigkeit teilweise um das Zwanzigfache bei datenintensiven Analyseabfragen. Neben technischen Herausforderungen führten auch Benutzeroberflächen und Supportprozesse zu Frustration.

Die Übersicht über ungenutzte Indexe entsprach häufig nicht den tatsächlichen Nutzungsmustern, was zu Fehlentscheidungen in der Datenbankoptimierung führte. Das Abbrechen von lange laufenden oder problematischen Abfragen gestaltete sich in der CockroachDB-Umgebung kompliziert und fehleranfällig, was direkte Auswirkungen auf die Stabilität des Systems hatte. Zudem war der Support kanalbedingt wenig reaktionsfreudig und unpraktisch zugänglich, was gerade in kritischen Situationen problematisch war. Netzwerk- und Infrastrukturprobleme rundeten die Herausforderungen ab. Regelmäßige Verbindungsabbrüche durch unklare Ursachen traten wiederholt auf und betrafen sämtliche Umgebungen - von der Entwicklung bis zur Produktion.

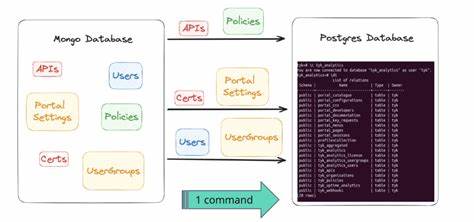

Diese Probleme konnten trotz eingehender Untersuchungen und diversen Gegenmaßnahmen nicht behoben werden. Im Gegensatz dazu verliefen Netzwerkverbindungen zu PostgreSQL-Servern stabiler und weniger störanfällig. Die Entscheidung zur Migration zu PostgreSQL erforderte eine maßgeschneiderte Lösung zur Datenübertragung, denn Standardwerkzeuge oder bestehende ETL-Lösungen waren entweder nicht verfügbar oder nicht zuverlässig einsetzbar. Ein selbst entwickeltes ETL-Script, das moderne Technologien wie Bun nutzt, ermöglichte eine effiziente und kontrollierte Migration. Dabei wurde der gesamte Datenbestand in CSV-Form exportiert, dann durch eine eigens entwickelte Pipeline transformiert, um Unterschiede bei der Byte-Kodierung in JSON- und Array-Feldern auszugleichen sowie die Kompatibilität mit PostgreSQL sicherzustellen.

Der eigentliche Migrationsprozess konnte im produktiven Umfeld in ungefähr 15 Minuten abgeschlossen werden, bei minimaler Ausfallzeit und ohne Datenverlust. Dies ermöglichte ein äußerst schonendes Vorgehen, bei dem nach und nach der Datenverkehr wieder aufgenommen wurde, ohne gleich den Betrieb komplett zu riskieren. Nach dem erfolgreichen Umzug führten Analyse-Tools wie PGAnalyze zu weiterführenden Optimierungen, die sowohl die Abfragegeschwindigkeit steigerten als auch für eine effiziente Ressourcennutzung sorgten. Langfristig brachte der Wechsel zu PostgreSQL bedeutende Vorteile. Neben einer unmittelbaren Steigerung der Systemleistung um ein Drittel sank der operative Kostenaufwand um mehr als 110.

000 US-Dollar pro Jahr. Diese Einsparungen entstehen trotz konservativer Cluster-Überprovisionierung und sind bei weiterem Wachstum des Datenvolumens und des Nutzeraufkommens sogar noch höher zu erwarten. Darüber hinaus verbesserte sich das Entwicklererlebnis durch stabilere Werkzeuge, schnellere Deployment-Prozesse und direkteren Support. Die Migration von CockroachDB zu PostgreSQL wird damit zu einem Musterbeispiel, wie Unternehmen durch zielgerichtete technische Entscheidungen und den Einsatz moderner Tools nicht nur Betriebskosten senken, sondern auch die technische Qualität und Zukunftsfähigkeit ihrer Dateninfrastruktur erhöhen können. Unternehmen, die ähnliche Herausforderungen erleben, profitieren von der dokumentierten Erfahrung und den erprobten Lösungsansätzen, insbesondere wenn sie mit komplexen Datenmodellen und hohem Transaktionsaufkommen arbeiten.

Zukünftige Herausforderungen bleiben auch bei PostgreSQL nicht aus. Die kontinuierliche Optimierung von Abfragen, Datenstrukturen und Systemressourcen erfordert Aufmerksamkeit und gezieltes Monitoring. Doch die umfangreiche Ecosystem-Unterstützung, eine breite Entwickler-Community sowie die Verfügbarkeit von leistungsstarken Analyse- und Optimierungstools machen PostgreSQL zur bevorzugten Wahl für anspruchsvolle Anwendungen mit hohem Wachstumspotential. Für Entwickler und technische Entscheider gilt es, den Lebenszyklus ihrer Datenbanken sorgsam zu planen, um technologische Schulden und Betriebskosten frühzeitig zu minimieren. Der gezielte Einsatz von Migrationen, automatisierten Tests und Monitoring-Software ist dabei unerlässlich.

Die gezeigten Erfahrungen zeigen, dass auch vermeintlich komplexe Migrationen mit einer gut durchdachten Strategie zügig und risikoarm umgesetzt werden können. Abschließend lässt sich festhalten, dass der Umstieg von CockroachDB auf PostgreSQL für Unternehmen eine attraktive Option darstellt, wenn der Anwendungsfall überwiegend in einer einzelnen Region liegt und die Flexibilität einer verteilten Datenbank nicht zwingend erforderlich ist. Die Vorteile in Sachen Performance, Stabilität, Kosten und Entwicklerfreundlichkeit überwiegen in solchen Szenarien deutlich. Im Zuge des Wandels rückt die Bedeutung eines sorgfältigen Datenbankmanagements in den Fokus. Neben technischer Exzellenz zählt auch die Berücksichtigung betriebswirtschaftlicher Aspekte.

Unternehmen sollten sich nicht davor scheuen, alte Systeme zu hinterfragen und neue Wege zu gehen, um so den steigenden Anforderungen an Skalierbarkeit und Effizienz gerecht zu werden. Durch die Verbindung von praxisorientierter Entwicklungsarbeit, innovativen Technologien und strategischem Weitblick schaffen Unternehmen die Voraussetzungen, um im wettbewerbsintensiven Umfeld technisch führend und wirtschaftlich erfolgreich zu sein.

![Aston Martin x Apple CarPlay Ultra – Next generation of automotive connectivity [video]](/images/08377B12-8A6E-4D36-9447-F332810DE362)