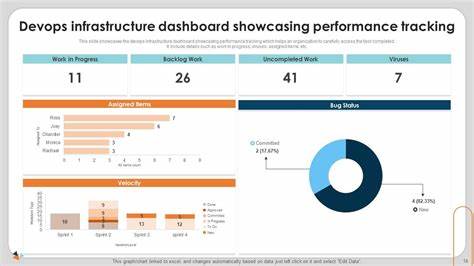

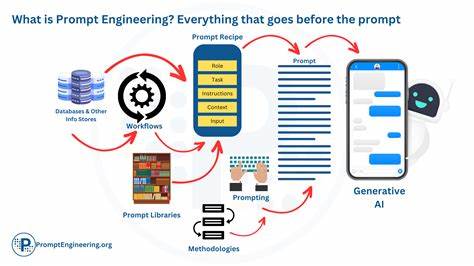

Prompt Engineering ist eine aufstrebende Disziplin im Bereich der künstlichen Intelligenz, die zunehmend an Bedeutung gewinnt. Es beschreibt die Kunst und Wissenschaft, Eingaben – sogenannte Prompts – so zu gestalten, dass KI-Modelle präzise, relevante und nützliche Ausgaben liefern. In Zeiten, in denen große Sprachmodelle wie GPT, Gemini oder andere Transformer-basierte Modelle den Ton angeben, ist es essenziell, diese Modelle nicht nur passiv zu nutzen, sondern aktiv durch strategisches Prompting zu steuern. Der Begriff Prompt Engineering mag zunächst technisch anmuten, doch grundsätzlich kann nahezu jeder eine Eingabeformulierung vornehmen. Die Herausforderung liegt darin, das optimale Zusammenspiel aus Wortwahl, Struktur, Ton und Kontext zu meistern.

So werden unklare oder missverständliche Antworten vermieden und die Leistungsfähigkeit der KI bestmöglich ausgeschöpft. Dies macht das Prompt Engineering zu einem iterativen Prozess, der Geduld, Experimentierfreude und Verständnis für das jeweilige Modell erfordert. Zu Beginn ist es hilfreich, die Funktionsweise von Sprachmodellen zu verstehen. Diese Systeme basieren auf riesigen Textkorpora, aus denen sie Muster erkennen, Sprache verstehen und vorhersagen können, wie ein passender weiterer Text aussieht. Die Eingabe, also der Prompt, dient als Startpunkt für diese Vorhersage und beeinflusst maßgeblich, welche Richtung die Antwort nimmt.

Eine präzise Fragestellung oder klare Anweisungen können das Ergebnis enorm verbessern. Prompt Engineering umfasst verschiedene Techniken. Beispielsweise können gezielte Kontextinformationen in den Prompt eingebettet werden, um die Antwort besser auf die Bedürfnisse des Nutzers auszurichten. Ebenso sind Stil- und Tonvorgaben möglich, die den Charakter der Antwort formen – sei es formell, kreativ oder sachlich. Die Länge und Detailtiefe des Prompts spielt eine Rolle, ebenso wie das gezielte Einfügen von Beispielen zur Verdeutlichung der gewünschten Antwortstruktur.

Neben den sprachlichen Feinheiten sind auch technische Aspekte relevant. Einige Modelle bieten Einstellmöglichkeiten wie die Temperatur, die beeinflusst, wie kreativ oder konservativ die Antworten ausfallen. Durch Anpassung dieser Parameter kann die Ausgabe weiter optimiert werden. Auch die Wahl des Modells selbst ist entscheidend, da unterschiedliche Modelle auf unterschiedlichen Trainingsdaten basieren und somit diverse Stärken besitzen. Eine besondere Bedeutung hat das Prompt Engineering bei Anwendungen, die über reine Textgenerierung hinausgehen.

So spielen multimodale Prompts, die neben Text auch Bilder oder andere Datentypen einsetzen, eine immer wichtigere Rolle. Hier gilt es, die Eingaben so zu gestalten, dass das Modell die verschiedenen Modalitäten korrekt interpretiert und kombiniert. Trotz aller Möglichkeiten gibt es Herausforderungen im Prompt Engineering. Es ist keine exakte Wissenschaft, und auch erfahrene Anwender kommen nicht immer sofort zum gewünschten Ergebnis. Manchmal liefern Modelle unerwartete oder ungenaue Antworten.

Dies liegt auch daran, dass die Trainingsdaten der Modelle begrenzt oder voreingenommen sein können. Zudem ist die Interpretation von Sprache durch KI noch nicht perfekt und kann Kontext oder Nuancen missverstehen. Um diese Hürden zu überwinden, ist eine strukturierte Herangehensweise sinnvoll. Das Experimentieren mit unterschiedlichen Prompts, das Analysieren von Antworten und die kontinuierliche Anpassung schaffen eine Lernkurve, die langfristig zum Erfolg führt. Dabei helfen Best Practices, wie etwa kurze, klare Anweisungen, Vermeidung von Mehrdeutigkeiten und das Einbauen von Kontrollfragen.

Nicht zuletzt eröffnet Prompt Engineering neue Möglichkeiten für Fachleute und Unternehmen. Durch präzises Prompting lässt sich die Arbeit mit KI-Modellen effektiver gestalten, sei es in der Textgenerierung, im Kundenservice, in der Datenanalyse oder Kreativbranche. Wer sich in dieser Disziplin weiterbildet, kann Wettbewerbsvorteile nutzen und innovative Anwendungen entwickeln. Zusammenfassend ist Prompt Engineering der Schlüssel, um die Potenziale moderner KI-Modelle bestmöglich zu nutzen. Es fordert ein Verständnis für die technische Grundlage, sprachliche Feinheiten und den situativen Kontext.

Mit der richtigen Technik und viel Übung lassen sich KIs dazu bringen, hochwertige, relevante und kontextsensitives Antworten zu generieren, die zuvor noch undenkbar schienen. Die Zukunft der Mensch-Maschine-Kommunikation wird maßgeblich durch die Kunst des Prompings mitgestaltet – eine Fähigkeit, die in der digitalen Ära an Bedeutung kaum übertroffen wird.

![Painting with Math – Inigo Quilez [video]](/images/0DEC2526-CFD4-435D-BF80-C34718C38050)