In der Welt der künstlichen Intelligenz und insbesondere im Bereich der Large Language Models (LLMs) spielen Agenten eine immer größere Rolle. Diese Agenten übernehmen komplexe Aufgaben und interagieren mit unterschiedlichsten Systemen, um Nutzern maßgeschneiderte Ergebnisse und Services zu liefern. Doch mit der zunehmenden Verbreitung von LLM-Agenten steigt auch das Risiko von sogenannten Prompt Injection Angriffen, die die Sicherheit und Integrität dieser Systeme massiv gefährden können. Prompt Injection beschreibt eine Angriffstechnik, bei der ein Angreifer die Eingaben eines LLM-Agenten manipuliert, um unerwünschte, manipulative oder gefährliche Anweisungen auszuführen. Vor diesem Hintergrund gewinnen Design Patterns, die speziell zur Absicherung von LLM-Agenten gegen solche Angriffe entwickelt wurden, enorm an Bedeutung.

Sie bieten strukturierte und bewährte Lösungswege, wie man die Verwundbarkeiten von Agenten minimieren und gleichzeitig deren Nutzen erhalten kann. Ein wegweisendes Werk in diesem Bereich wurde 2025 von einem Team führender Forscher unter anderem von IBM, ETH Zürich, Google und Microsoft veröffentlicht. Diese Arbeit definiert umfassend das Problem der Prompt Injection und stellt sechs bewährte Design Patterns vor, die den Schutz von LLM-Agenten entscheidend verbessern können. Das Herzstück dieser Ansätze ist die bewusste Einschränkung der Handlungsmöglichkeiten von Agenten, um zu verhindern, dass schadhafte Eingaben weitreichende oder schädliche Aktionen auslösen können. Dabei wird ein pragmatischer Kompromiss zwischen Funktionalität und Sicherheit eingegangen – eine Entscheidung, die angesichts der aktuellen technischen Möglichkeiten als realistisch und notwendig gilt.

Eines der Schlüsselprinzipien dieser Patterns ist, dass sobald ein LLM-Agent potenziell unzuverlässige oder bösartige Eingaben erhält, dieser Input die Aktionen des Agents nicht unbegrenzt beeinflussen darf. Konkret bedeutet das, dass Agenten keine Möglichkeit haben sollten, ohne Kontrolle sensible Operationen vorzunehmen, etwa solche, die auf vertrauliche Daten zugreifen oder die Systemintegrität kompromittieren könnten. Dadurch wird verhindert, dass Angreifer durch geschicktes Einschleusen ihrer Anweisungen später im Prozess unvorhergesehene und schädliche Aktionen provozieren. Zu den vorgestellten Design Patterns zählt das Action-Selector Pattern, das einen Mechanismus vorsieht, bei dem der Agent zwar Aktionen auslösen kann, jedoch nicht auf die Antworten dieser Aktionen zugreifen darf. Dies eliminiert die Möglichkeit, dass der Agent von manipulierten Rückmeldungen beeinflusst wird.

Beispielsweise kann eine Anwendung so gestaltet werden, dass sie eine E-Mail verschickt oder eine Webseite öffnet, ohne die Antwortdaten zu analysieren oder weiterzuverarbeiten. Eine Erweiterung dieses Prinzips findet sich im Plan-Then-Execute Pattern. Hier wird die Ausführung der Aktionen vorab geplant, bevor der Agent mit potenziell schädlichem Output konfrontiert wird. Dies sorgt dafür, dass spätere Reaktionen des Agents auf die Ergebnisse der zuvor gestarteten Tools keine weiteren, unerwünschten Aktionen mehr anstoßen können. So kann etwa eine Kalenderabfrage gefahrlos durchgeführt werden, bevor eine E-Mail verschickt wird – dabei bleibt die Empfängeradresse fix und unveränderbar.

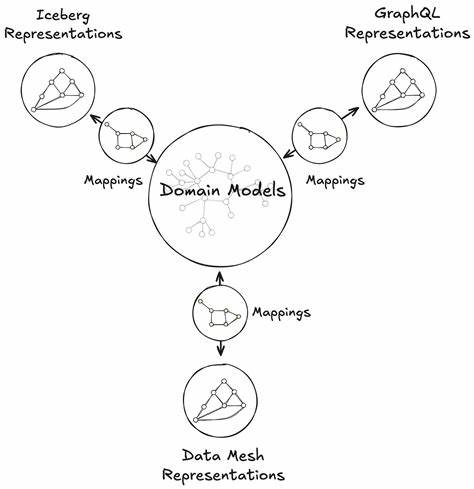

Das LLM Map-Reduce Pattern greift das Map-Reduce-Prinzip aus der Datenverarbeitung auf und setzt es auf Agenten um, die in kleinere Unteragenten aufgeteilt sind. Jeder Unteragent bearbeitet einzelne Teilaufgaben mit potenziell unsicherem Input, dessen Ergebnisse anschließend von einem Koordinator-Agenten aggregiert werden. Dadurch wird die Gefahr gemindert, dass durch eine einzelne kompromittierte Instanz das gesamte System gefährdet wird. Eine besonders interessante Variante ist das Dual LLM Pattern, das einen privilegierten LLM-Agenten und einen isolierten, „quarantänisierten“ LLM-Agenten kombiniert. Der isolierte Agent verarbeitet potenziell gefährlichen Input, ohne direkten Kontakt zum umfassenden System zu haben, und übergibt dem privilegierten Agenten lediglich abstrahierte, symbolische Informationen.

Diese Trennung verhindert, dass unsichere Daten in kritische Systemteile gelangen können. Das Code-Then-Execute Pattern baut darauf auf und nutzt eine spezialisierte domänenspezifische Sprache (DSL), mit der der privilegierte Agent den gesamten Ablauf von Toolaufrufen als Code generiert. Dieser Code wird dann innerhalb einer sicheren Umgebung ausgeführt, wobei jede Verwendung von Daten, die potenziell manipuliert sein könnten, genau getrackt und kontrolliert wird. Somit können auch komplexe Workflows sicher orchestriert werden, ohne unkontrollierte Nebenwirkungen. Außerdem adressiert das Context-Minimization Pattern die Reduzierung manipulativer Potenziale darin, wie Kontexte zwischen Anfragen an den Agenten weitergegeben werden.

Beispielsweise kann ein Kundenservice-Agent durch Umwandlung einer Nutzeranfrage in eine strukturierte Abfrage (etwa eine SQL-Datenbankabfrage) sicherstellen, dass manipulierte Inhalte aus dem ursprünglichen Kontext nicht in den Ausgabeprozess gelangen und somit keine schädlichen Effekte hervorrufen können. Complementär zu diesen Design Patterns untermauert die Arbeit die Bedeutung von klar definierten und realistischen Bedrohungsmodellen, damit die Sicherheit von LLM-Agenten systematisch und nachvollziehbar verbessert werden kann. In mehreren praxisnahen Case Studies werden Anwendungen wie SQL-Analysen, E-Mail- und Kalenderassistenz, Kundenservice-Chatbots oder medizinische Diagnosehilfen analysiert und mit maßgeschneiderten Sicherheitsmaßnahmen versehen. Besonders hervorzuheben ist die Anwendung bei der Verarbeitung unstrukturierter Daten oder externen API-Dokumentationen. Hier ist es ratsam, den Agenten nur über formal streng definierte Interfaces mit externen, potenziell unsicheren Daten interagieren zu lassen, was eine zusätzliche Barriere gegen Prompt Injection Angriffe bildet.

Trotzdem bleibt eine gewisse Unsicherheit. Auch streng limitierte Eingaben, wie beispielsweise methodisch auf 30 Zeichen begrenzte API-Bezeichner, könnten von Angreifern potenziell missbraucht werden, um harmlose Anwendungsbereiche zu unterwandern. Insgesamt lässt sich feststellen, dass Design Patterns für die Sicherheit von LLM-Agenten erhebliche Fortschritte bieten, jedoch keine magische Lösung für alle Probleme darstellen. Die Forschung zeigt sehr klar, dass Sicherheit immer den Preis erforderlicher Einschränkungen und Kompromisse mit sich bringt – sei es in der Funktionalität, im Informationsfluss oder im Umfang der Interaktion eines Agenten mit externen Daten. Dieser pragmatische Ansatz macht die vorgestellten Patterns besonders wertvoll für Entwickler und Betreiber von KI-Systemen, da sie greifbare Strategien an die Hand geben, um den komplexen Angriffen durch Prompt Injection wirksam zu begegnen.

In einer Zeit, in der KI-Agenten immer mehr in kritische Anwendungsfelder vordringen, von Finanzsystemen über medizinische Beratung bis hin zu Softwareentwicklung, ist die Sicherung gegen Prompt Injections von größter Bedeutung für den verantwortungsvollen und sicheren Betrieb. Die Zusammenarbeit zwischen großen Tech-Unternehmen, Forschungseinrichtungen und Open-Source-Communities zeigt zudem, dass das Thema breit diskutiert und in verschiedenen Kontexten geprüft wird. Wer sich als Entwickler oder Entscheidungsträger mit den Herausforderungen moderner KI-Systeme auseinandersetzt, sollte die vorgestellten Design Patterns und die dahinterstehenden Prinzipien unbedingt kennen. Nur so kann man die Balance zwischen Nutzen und Sicherheitsrisiken bei LLM-Agenten angemessen gestalten und zukunftsfähige Systeme planen. Abschließend lässt sich sagen, dass die Design Patterns für die Sicherung von LLM-Agenten gegen Prompt Injection einen Meilenstein in der Weiterentwicklung sicherer KI-Agenten darstellen.

Sie liefern praktische Lösungsansätze und öffnen den Weg für eine breite Implementierung, welche die KI-Entwicklung nicht nur effektiver, sondern auch deutlich sicherer macht. Die zunehmende Aufmerksamkeit und Forschung in diesem Bereich sind ein positives Signal für alle, die sich eine verantwortungsvolle Zukunft mit KI wünschen.